AMD를 선택하면 데이터 센터를 혁신하고 비즈니스를 발전시킬 수 있습니다

AMD EPYC™ 프로세서는 세계 최고의 데이터 센터용 CPU입니다. 기업에서 고객의 요구를 충족하는 데 필요한 데이터 센터 컴퓨팅 성능을 제공하고, 랙 설치 공간을 줄이며, 에너지 효율적인 성능을 제공하고, AI 워크로드를 대규모로 배포할 수 있습니다.

AI 이니셔티브를 준비하는 현대화와 통합

기업은 경쟁력을 유지하기 위해 AI 기술을 구현하고 있지만 이것이 IT 리더에게는 쉽지 않은 상황일 수 있습니다. 기업에 AI 애플리케이션을 추가하면 기존 데이터 센터 인프라의 기능이 저하될 수 있기 때문입니다. 그렇기 때문에 현대화가 핵심인 것입니다. 일례로, 인텔 제온 Gold 6143에서 4세대 AMD EPYC 9334로 업그레이드할 경우 조직은 최대 73% 적은 서버, 70% 적은 랙, 65% 적은 전력을 사용하여 최소 80,000점의 SPECrate® 정수 점수를 달성할 수 있습니다.1

AMD EPYC™을 선택해야 하는 이유

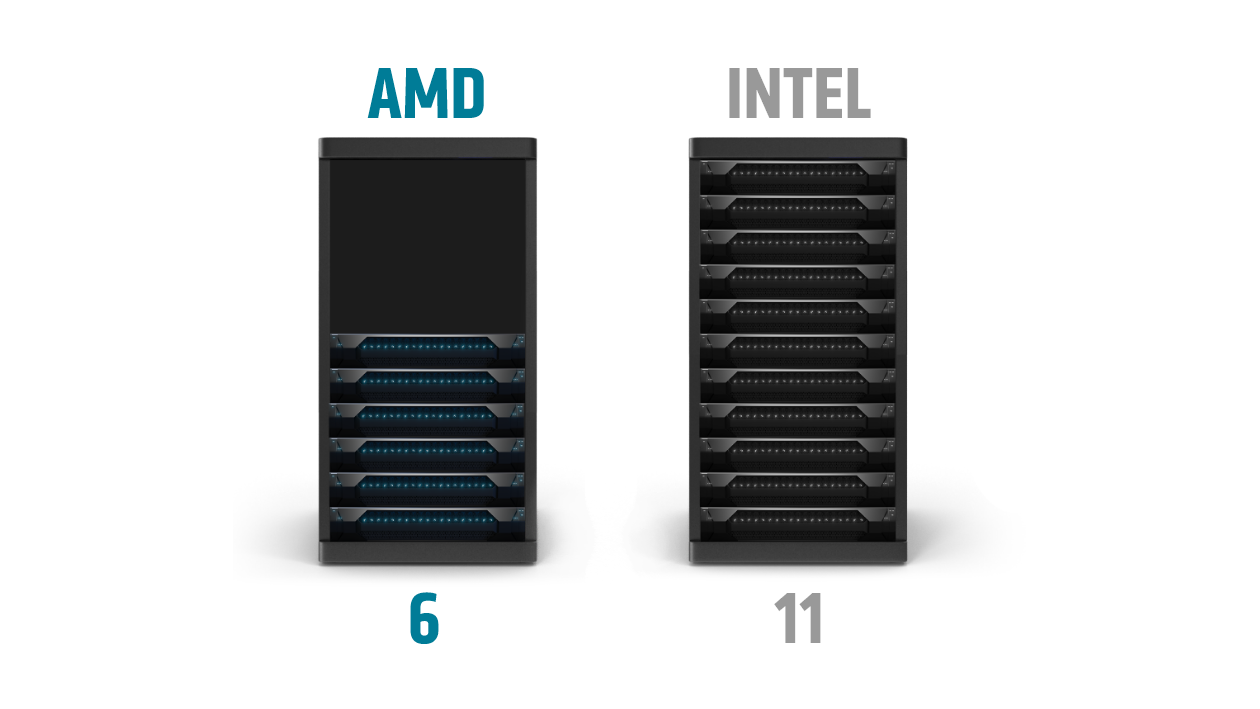

다음 서버 배포를 위해 적절한 데이터 센터 프로세서를 선택하면 IT 조직은 데이터 센터의 설치 공간을 유지하거나 줄이면서도 더 높은 성능과 밀도를 얻을 수 있습니다.

예를 들어 SPECrate®의 정수 점수가 최소 10,000에 도달하려면 11대의 최신 듀얼 소켓 인텔 제온 Platinum 8490H 기반 서버가 필요하지만 듀얼 소켓 AMD EPYC 9654 기반 서버는 6대만 필요합니다.2

4세대 AMD EPYC 프로세서 기반 서버는 다음을 지원할 수 있습니다.

- 더 적은 수의 서버로 동일한 워크로드 수행

- 운영 및 에너지 비용 절감

- 귀중한 데이터 센터 공간과 전력을 확보하고 이 용량을 새로운 워크로드 및 서비스에 할당

데이터 센터 AI 배포를 위한 AMD 선택

AI 워크로드에 관해서는 여러 가지 요구 사항이 있으며, 이러한 요구 사항은 계속 진화하고 있습니다. CPU와 GPU 모두 AI 추론 워크로드를 실행하는 데 탁월하며, 특성과 배포 시나리오가 다양합니다. AMD는 데이터 센터를 배포할 수 있도록 CPU 및 GPU 가속기 모두에 선도적인 AI 성능과 효율성을 제공합니다.

세계 최고의 데이터 센터용 CPU

4세대 AMD EPYC 프로세서는 기업이 비즈니스의 속도를 높이기 위해 통찰력을 더 빠르게 확보할 수 있도록 지원합니다. AI 추론은 모델이 소규모이고, AI가 전체 서버 워크로드 혼합에서 차지하는 비율이 작을 때 EPYC CPU에서 가장 효과적으로 구축됩니다.

AI 컴퓨팅 로드는 기업에 배포될 때 서버의 전반적인 성능에 영향을 미치는 여러 요인 중 하나입니다. 서버의 전반적인 기능을 보다 정확하게 이해하려면 포괄적인 파이프라인을 살펴보는 것이 중요합니다. 최상위 64c 5세대 제온 2개가 탑재된 서버와 비교했을 때, 96c 4세대 EPYC 프로세서 2개가 탑재된 서버는 TPCx-AI SF30 벤치마크 실행 시 서버당 1.65배의 성능을 제공합니다.³

세계 최고 성능의 데이터 센터 GPU 가속기

AMD Instinct™ 가속기는 가장 까다로운 AI 및 HPC 워크로드에 선도적인 성능을 제공하며, MI300X는 NVIDIA H100 SXM(80GB) 가속기와 비교했을 때 AI 정밀도가 최대 1.3배 개선됩니다⁴. AI 모델 학습 외에도 AMD Instinct GPU는 AI가 전체 서버 워크로드 혼합의 상당 부분을 차지하거나 실시간 추론 응답이 애플리케이션에 필수적인 전용 AI 배포의 추론에 적합합니다.

솔루션

AMD는 4세대 AMD EPYC이 탑재된 솔루션을 설계 및 개발하는 다양한 파트너들과 협력하고 있습니다.

AMD EPYC으로 더 많은 것을 실현하세요

4세대 AMD EPYC 프로세서는 인프라를 통합하고 CAPEX 및 OPEX를 줄여 비즈니스 성과를 가속하도록 설계되었습니다.

데이터 센터의 성능과 효율을 높여서 비용, 에너지 소비 및 서버 설치 공간을 줄이는 방법에 대해 알아보세요.

수많은 기업이 신뢰

자체 전산실 또는 클라우드에서 AMD EPYC 프로세서 도입에 성공한 다른 기업의 사례를 알아보세요.

최신 데이터 센터 소식 및 콘텐츠를 받으려면 등록하세요.

각주

- SP5TCO-055: 이 시나리오에는 많은 가정 및 추정이 포함되어 있으며, AMD 내부 연구 및 최대 근사치에 기반하며, 정보 제공 목적의 예시로만 간주하여야 하고 실제 테스트에 대한 의사 결정의 기준으로 사용되어서는 안 됩니다. 베어 메탈 서버 온실가스 배출 TCO(총 소유 비용) 견적 툴 버전 9.37 Pro Refresh는 2023년 6월 1일 현재 이러한 특정 인텔 제온 및 AMD EPYC CPU 기반 서버에 대해 게시된 점수에 기초한 80,000개 유닛의 정수 성능 TOTAL_PERFORMANCE를 제공하는 데 필요한 선별된 AMD EPYC™ 및 인텔® 제온® CPU 기반 서버 솔루션을 비교합니다. 이 추정치는 PUE 1.7, 미국의 전력 비용 0.128달러/kWh, 3년간의 시간 범위를 반영한 것입니다. 이 분석에서는 SPECrate®2017_int_base 점수가 725인 2P AMD 32코어 EPYC 9334 CPU 기반 서버(https://spec.org/cpu2017/results/res2023q1/cpu2017-20230102-33282.pdf)와 SPECrate®2017_int_base 점수가 197인 2P 인텔 제온 16코어 Gold_6143 기반 서버(https://spec.org/cpu2017/results/res2017q4/cpu2017-20171114-00863.pdf)를 비교합니다. 부동산 또는 관리 비용의 범위가 넓기 때문에 이 TCO는 해당 분석에 비용으로 포함되지 않습니다. 새로운 AMD 기반 서버 OpEx는 전력으로만 구성되어 있습니다. 인텔 CPU가 장착된 서버의 기존 설치 기반에 대한 OpEx는 전력에 더해 연장된 보증 비용으로 구성됩니다. 서버 보증 지원 연장 비용은 2023년 비용으로 계산한 최초 구매 가격의 연간 20%로 계산됩니다. 이 비용과 전력 비용을 사용하면 3년간의 TCO에 대한 AMD 솔루션이 250만 달러(62%) 이상 절감되고 연간 OpEx 비용이 120만 달러(93%)나 절감됩니다. 환경 영향 추정치는 '2020 그리드 전력 배출 계수 v1.4 – 2020년 9월' 및 미국 환경보호청 '온실가스 등가 계산기'의 국가/지역별 전기적 계수를 사용한 이 데이터를 활용하여 작성되었습니다. 자세한 사항은 https://www.amd.com/en/claims/epyc4#SP5TCO-055를 참조하세요.

- SP5TCO-032: 이 시나리오에는 많은 가정 및 추정이 포함되어 있으며, AMD 내부 연구 및 최대 근사치에 기반하며, 정보 제공 목적의 예시로만 간주하여야 하고 실제 테스트에 대한 의사 결정의 기준으로 사용되어서는 안 됩니다. 베어 메탈 서버 온실가스 배출 TCO(총 소유 비용) 견적 툴 버전 6.80은 2023년 1월 10일 현재 이러한 특정 인텔 제온 및 AMD EPYC CPU 기반 서버에 대해 게시된 점수에 기초한 10,000개 유닛의 정수 성능 TOTAL_PERFORMANCE를 제공하는 데 필요한 선별된 AMD EPYC™ 및 인텔® 제온® CPU 기반 서버 솔루션을 비교합니다. 이 추정치는 PUE 1.7, 미국의 전력 비용 0.16달러/kWh, 3년간의 시간 범위를 반영한 것입니다. 이 분석에서는 SPECrate2017_int_base 점수가 1790인 2P AMD 96코어 AMD EPYC_9654 기반 서버(https://spec.org/cpu2017/results/res2022q4/cpu2017-20221024-32607.pdf)와 SPECrate2017_int_base 점수가 991인 2P 인텔 제온 60코어 Platinum_8490H 기반 서버(https://spec.org/cpu2017/results/res2023q1/cpu2017-20221206-33039.pdf)를 비교합니다. 환경 영향 추정치는 '2020 그리드 전력 배출 계수 v1.4 – 2020년 9월' 및 미국 환경보호청 '온실가스 등가 계산기'의 국가/지역별 전기적 계수를 사용한 이 데이터를 활용하여 작성되었습니다. 자세한 사항은 https://www.amd.com/en/claims/epyc4#SP5TCO-032를 참조하세요.

- SP5-051A: 2024년 4월 13일 기준 여러 VM 인스턴스를 실행하는 AMD 내부 테스트에 기초하여 TPCx-AI SF30 파생 워크로드를 비교한 수치입니다. 종합적인 엔드 투 엔드 AI 처리율 테스트는 TPCx-AI 벤치마크에서 파생되었으며, 엔드 투 엔드 AI 처리율 테스트 결과가 TPCx-AI 스펙을 준수하지 않기 때문에 게시된 TPCx-AI 결과와 비교할 수 없습니다. AMD 시스템 구성: 프로세서: AMD EPYC 9654 2개, 주파수: 2.4GHz | 3.7GHz, 코어: 소켓당 96개 코어(소켓당 1개의 NUMA 도메인), L3 캐시: 384MB/소켓(총 768MB), 메모리: 1.5TB(24개) 듀얼 랭크 DDR5-5600 64GB DIMM, 1DPC(플랫폼에서 최대 4800MHz 지원), NIC: 100GbE Mellanox CX-5(MT28800) 2개, 스토리지: 3.2TB Samsung MO003200KYDNC U.3 NVMe, BIOS: 1.56, BIOS 설정: SMT=켜짐, 결정성=Power, NPS=1, PPL=400W, 터보 부스트=사용, OS: Ubuntu® 22.04.3 LTS, 테스트 구성: 6개 인스턴스, 64개 vCPU/인스턴스, 종합적인 2663개 AI 사용 사례/분과 다음 인텔 시스템 구성 비교: 프로세서: 인텔® 제온® Platinum 8592+ 2개, 주파수: 1.9GHz | 3.9GHz, 코어: 소켓당 64개 코어(소켓당 1개의 NUMA 도메인), L3 캐시: 320MB/소켓(총 640MB), 메모리: 1TB(16) 듀얼 랭크 DDR5-5600 64GB DIMM, 1DPC, NIC: 1GbE Broadcom NetXtreme BCM5719 기가비트 이더넷 PCIe 4개, 스토리지: 3.84TB KIOXIA KCMYXRUG3T84 NVMe, BIOS: ESE124B-3.11, BIOS 설정: 하이퍼스레딩=활성화, 터보 부스트=활성화, SNC=비활성화, OS: Ubuntu® 22.04.3 LTS, 테스트 구성: 4개 인스턴스, 64개 vCPU/인스턴스, 종합적인 1607개 AI 사용 사례/분 결과는 시스템 구성, 소프트웨어 버전 및 BIOS 설정에 따라 달라질 수 있습니다. TPC, TPC 벤치마크 및 TPC-C는 Transaction Processing Performance Council의 상표입니다.

- MI300-17: 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300X(750W) GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 653.7TFLOPS의 이론상 최대 TensorFloat-32(TF32), 1307.4TFLOPS의 이론상 최대 반정도(FP16), 1307.4TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 2614.9TFLOPS의 이론상 최대 8비트 정도(FP8), 2614.9TOPs의 INT8 부동 소수점 성능을 기록했습니다. MI300X는 정교한 조직 구조 스파시티를 활용해 수학 연산 효율을 약 2배 향상할 것으로 예상되며 1,307.4TFLOPS의 이론상 최대 TensorFloat-32(TF32), 2,614.9TFLOPS의 이론상 최대 반정도(FP16), 2,614.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 5,229.8TFLOPS의 이론상 최대 8비트 정도(FP8), 스파시티 사용 시 5,229.8TOPS의 INT8 부동 소수점 성능을 기록했습니다. Nvidia H100 SXM(80GB) 700W GPU에 대해 게시된 결과는 스파시티 사용 시 989.4TFLOPs의 최대 TensorFloat-32(TF32), 스파시티 사용 시 1,978.9TFLOPS의 이론상 최대 반정도(FP16), 스파시티 사용 시 1,978.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 스파시티 사용 시 3,957.8TFLOPS의 이론상 최대 8비트 정도(FP8), 스파시티 부동 소수점 성능 사용 시 3,957.8TOPs의 이론상 최대 INT8을 기록했습니다. Nvidia H100 출처: https://resources.nvidia.com/en-us-tensor-core. MI300-17

- SP5TCO-055: 이 시나리오에는 많은 가정 및 추정이 포함되어 있으며, AMD 내부 연구 및 최대 근사치에 기반하며, 정보 제공 목적의 예시로만 간주하여야 하고 실제 테스트에 대한 의사 결정의 기준으로 사용되어서는 안 됩니다. 베어 메탈 서버 온실가스 배출 TCO(총 소유 비용) 견적 툴 버전 9.37 Pro Refresh는 2023년 6월 1일 현재 이러한 특정 인텔 제온 및 AMD EPYC CPU 기반 서버에 대해 게시된 점수에 기초한 80,000개 유닛의 정수 성능 TOTAL_PERFORMANCE를 제공하는 데 필요한 선별된 AMD EPYC™ 및 인텔® 제온® CPU 기반 서버 솔루션을 비교합니다. 이 추정치는 PUE 1.7, 미국의 전력 비용 0.128달러/kWh, 3년간의 시간 범위를 반영한 것입니다. 이 분석에서는 SPECrate®2017_int_base 점수가 725인 2P AMD 32코어 EPYC 9334 CPU 기반 서버(https://spec.org/cpu2017/results/res2023q1/cpu2017-20230102-33282.pdf)와 SPECrate®2017_int_base 점수가 197인 2P 인텔 제온 16코어 Gold_6143 기반 서버(https://spec.org/cpu2017/results/res2017q4/cpu2017-20171114-00863.pdf)를 비교합니다. 부동산 또는 관리 비용의 범위가 넓기 때문에 이 TCO는 해당 분석에 비용으로 포함되지 않습니다. 새로운 AMD 기반 서버 OpEx는 전력으로만 구성되어 있습니다. 인텔 CPU가 장착된 서버의 기존 설치 기반에 대한 OpEx는 전력에 더해 연장된 보증 비용으로 구성됩니다. 서버 보증 지원 연장 비용은 2023년 비용으로 계산한 최초 구매 가격의 연간 20%로 계산됩니다. 이 비용과 전력 비용을 사용하면 3년간의 TCO에 대한 AMD 솔루션이 250만 달러(62%) 이상 절감되고 연간 OpEx 비용이 120만 달러(93%)나 절감됩니다. 환경 영향 추정치는 '2020 그리드 전력 배출 계수 v1.4 – 2020년 9월' 및 미국 환경보호청 '온실가스 등가 계산기'의 국가/지역별 전기적 계수를 사용한 이 데이터를 활용하여 작성되었습니다. 자세한 사항은 https://www.amd.com/en/claims/epyc4#SP5TCO-055를 참조하세요.

- SP5TCO-032: 이 시나리오에는 많은 가정 및 추정이 포함되어 있으며, AMD 내부 연구 및 최대 근사치에 기반하며, 정보 제공 목적의 예시로만 간주하여야 하고 실제 테스트에 대한 의사 결정의 기준으로 사용되어서는 안 됩니다. 베어 메탈 서버 온실가스 배출 TCO(총 소유 비용) 견적 툴 버전 6.80은 2023년 1월 10일 현재 이러한 특정 인텔 제온 및 AMD EPYC CPU 기반 서버에 대해 게시된 점수에 기초한 10,000개 유닛의 정수 성능 TOTAL_PERFORMANCE를 제공하는 데 필요한 선별된 AMD EPYC™ 및 인텔® 제온® CPU 기반 서버 솔루션을 비교합니다. 이 추정치는 PUE 1.7, 미국의 전력 비용 0.16달러/kWh, 3년간의 시간 범위를 반영한 것입니다. 이 분석에서는 SPECrate2017_int_base 점수가 1790인 2P AMD 96코어 AMD EPYC_9654 기반 서버(https://spec.org/cpu2017/results/res2022q4/cpu2017-20221024-32607.pdf)와 SPECrate2017_int_base 점수가 991인 2P 인텔 제온 60코어 Platinum_8490H 기반 서버(https://spec.org/cpu2017/results/res2023q1/cpu2017-20221206-33039.pdf)를 비교합니다. 환경 영향 추정치는 '2020 그리드 전력 배출 계수 v1.4 – 2020년 9월' 및 미국 환경보호청 '온실가스 등가 계산기'의 국가/지역별 전기적 계수를 사용한 이 데이터를 활용하여 작성되었습니다. 자세한 사항은 https://www.amd.com/en/claims/epyc4#SP5TCO-032를 참조하세요.

- SP5-051A: 2024년 4월 13일 기준 여러 VM 인스턴스를 실행하는 AMD 내부 테스트에 기초하여 TPCx-AI SF30 파생 워크로드를 비교한 수치입니다. 종합적인 엔드 투 엔드 AI 처리율 테스트는 TPCx-AI 벤치마크에서 파생되었으며, 엔드 투 엔드 AI 처리율 테스트 결과가 TPCx-AI 스펙을 준수하지 않기 때문에 게시된 TPCx-AI 결과와 비교할 수 없습니다. AMD 시스템 구성: 프로세서: AMD EPYC 9654 2개, 주파수: 2.4GHz | 3.7GHz, 코어: 소켓당 96개 코어(소켓당 1개의 NUMA 도메인), L3 캐시: 384MB/소켓(총 768MB), 메모리: 1.5TB(24개) 듀얼 랭크 DDR5-5600 64GB DIMM, 1DPC(플랫폼에서 최대 4800MHz 지원), NIC: 100GbE Mellanox CX-5(MT28800) 2개, 스토리지: 3.2TB Samsung MO003200KYDNC U.3 NVMe, BIOS: 1.56, BIOS 설정: SMT=켜짐, 결정성=Power, NPS=1, PPL=400W, 터보 부스트=사용, OS: Ubuntu® 22.04.3 LTS, 테스트 구성: 6개 인스턴스, 64개 vCPU/인스턴스, 종합적인 2663개 AI 사용 사례/분과 다음 인텔 시스템 구성 비교: 프로세서: 인텔® 제온® Platinum 8592+ 2개, 주파수: 1.9GHz | 3.9GHz, 코어: 소켓당 64개 코어(소켓당 1개의 NUMA 도메인), L3 캐시: 320MB/소켓(총 640MB), 메모리: 1TB(16) 듀얼 랭크 DDR5-5600 64GB DIMM, 1DPC, NIC: 1GbE Broadcom NetXtreme BCM5719 기가비트 이더넷 PCIe 4개, 스토리지: 3.84TB KIOXIA KCMYXRUG3T84 NVMe, BIOS: ESE124B-3.11, BIOS 설정: 하이퍼스레딩=활성화, 터보 부스트=활성화, SNC=비활성화, OS: Ubuntu® 22.04.3 LTS, 테스트 구성: 4개 인스턴스, 64개 vCPU/인스턴스, 종합적인 1607개 AI 사용 사례/분 결과는 시스템 구성, 소프트웨어 버전 및 BIOS 설정에 따라 달라질 수 있습니다. TPC, TPC 벤치마크 및 TPC-C는 Transaction Processing Performance Council의 상표입니다.

- MI300-17: 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300X(750W) GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 653.7TFLOPS의 이론상 최대 TensorFloat-32(TF32), 1307.4TFLOPS의 이론상 최대 반정도(FP16), 1307.4TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 2614.9TFLOPS의 이론상 최대 8비트 정도(FP8), 2614.9TOPs의 INT8 부동 소수점 성능을 기록했습니다. MI300X는 정교한 조직 구조 스파시티를 활용해 수학 연산 효율을 약 2배 향상할 것으로 예상되며 1,307.4TFLOPS의 이론상 최대 TensorFloat-32(TF32), 2,614.9TFLOPS의 이론상 최대 반정도(FP16), 2,614.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 5,229.8TFLOPS의 이론상 최대 8비트 정도(FP8), 스파시티 사용 시 5,229.8TOPS의 INT8 부동 소수점 성능을 기록했습니다. Nvidia H100 SXM(80GB) 700W GPU에 대해 게시된 결과는 스파시티 사용 시 989.4TFLOPs의 최대 TensorFloat-32(TF32), 스파시티 사용 시 1,978.9TFLOPS의 이론상 최대 반정도(FP16), 스파시티 사용 시 1,978.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 스파시티 사용 시 3,957.8TFLOPS의 이론상 최대 8비트 정도(FP8), 스파시티 부동 소수점 성능 사용 시 3,957.8TOPs의 이론상 최대 INT8을 기록했습니다. Nvidia H100 출처: https://resources.nvidia.com/en-us-tensor-core. MI300-17