AMD CDNA 3

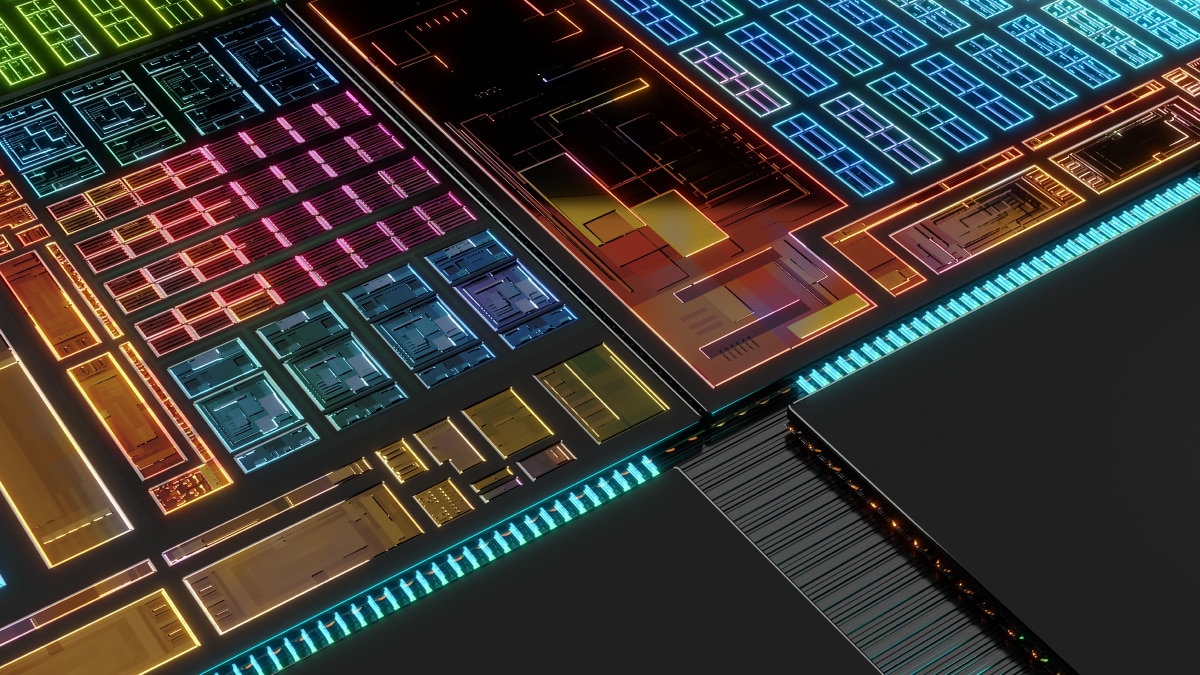

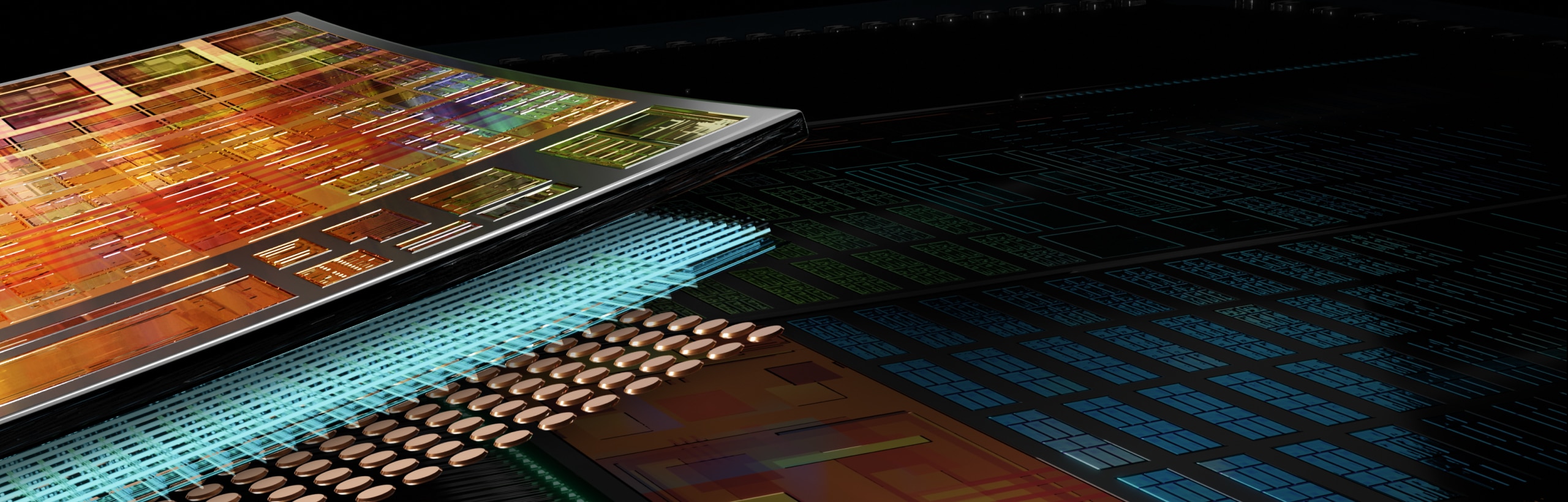

AMD CDNA™ 3 est l'architecture de calcul dédiée sur laquelle sont basés les accélérateurs de la gamme AMD Instinct™ série MI300. Elle offre des technologies de packaging avancées associées à des chiplets et conçues pour réduire les frais de déplacement des données et améliorer l'efficacité énergétique.

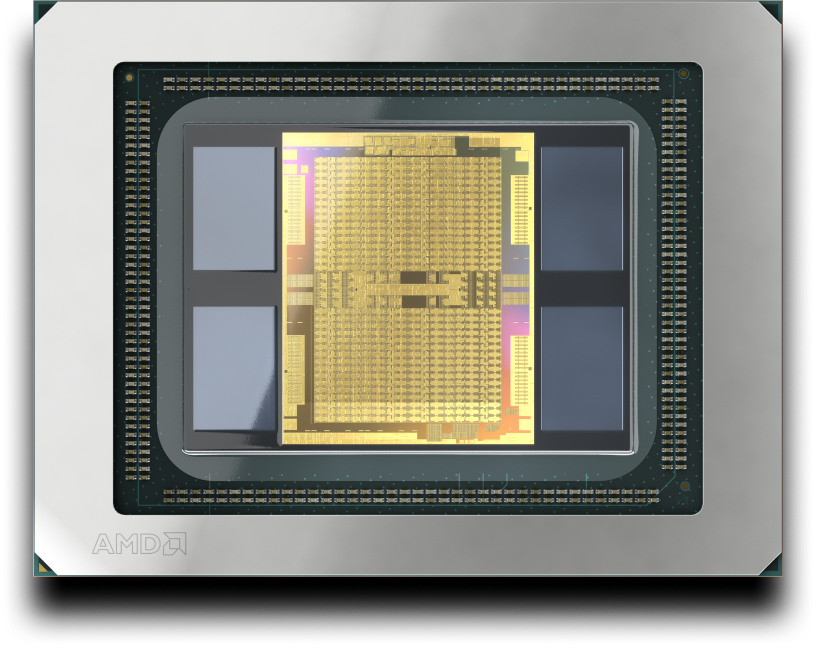

Unité de calcul accéléré AMD Instinct MI300A

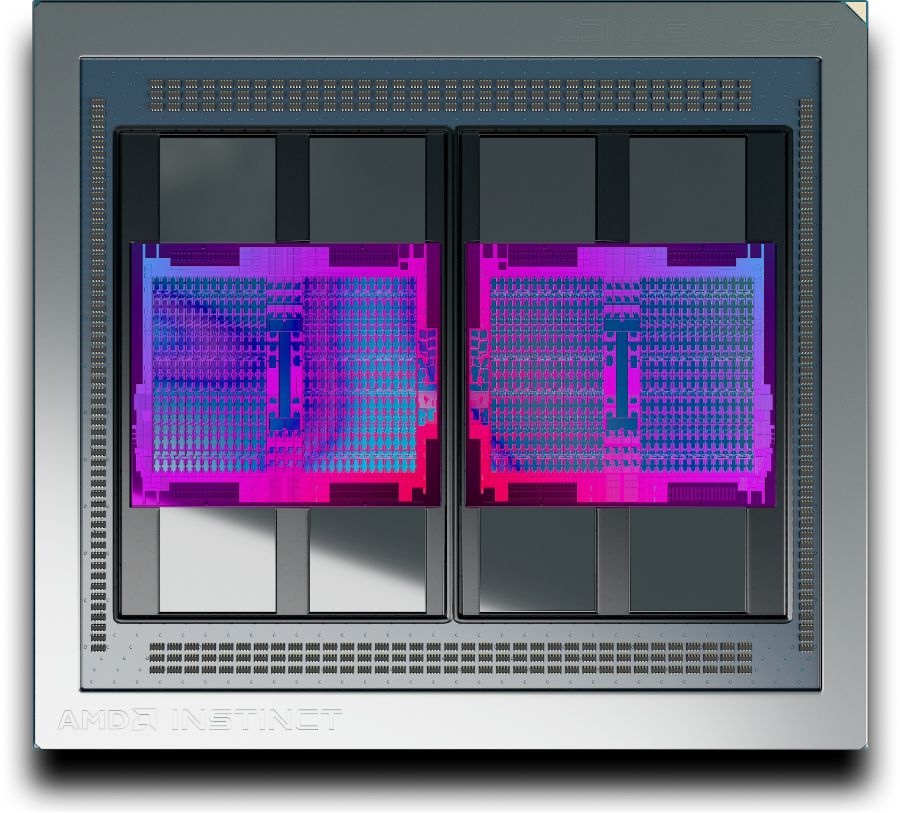

Accélérateur AMD Instinct MI325X

Technologies Matrix Core

AMD CDNA 3 inclut des technologies Matrix Core qui offrent un débit de calcul amélioré avec un parallélisme au niveau des instructions avancé, y compris la prise en charge d'un large éventail de précisions (INT8, FP8, BF16, FP16, TF32, FP32 et FP64), ainsi que des données de matrice éparses (c'est-à-dire avec dispersion).

Mémoire HBM, cache et cohérence

Les accélérateurs de la gamme AMD Instinct série MI300 offrent une capacité de mémoire HBM3e et une bande passante mémoire de pointe1,2, ainsi qu'une mémoire partagée et AMD Infinity Cache™ (cache de dernier niveau partagé). Ils éliminent ainsi la copie des données, tout en réduisant le temps de latence.

Structure unifiée

L'architecture AMD Infinity nouvelle génération, associée à la technologie AMD Infinity Fabric™, permet une unification cohérente et à haut débit des technologies de chiplet GPU et CPU d'AMD avec une mémoire HBM3 empilée sur des appareils uniques, ainsi que sur les plateformes hébergeant plusieurs appareils. Elle offre également des E/S améliorées avec une compatibilité PCIe® 5.

AMD CDNA 2

L'architecture AMD CDNA 2 est conçue pour accélérer les charges de travail de calcul scientifique et les applications d'apprentissage automatique les plus exigeantes. Elle sert de base aux accélérateurs de la gamme AMD Instinct série MI200.

AMD CDNA

AMD CDNA est une architecture dédiée pour le calcul basé sur GPU, conçue pour marquer les débuts du calcul de classe exascale. Elle sert de base aux accélérateurs de la gamme AMD Instinct série MI100.

Accélérateurs AMD Instinct

Découvrez comment les accélérateurs AMD Instinct dynamisent l'IA et le HPC.

Logiciel AMD ROCm™

L'architecture AMD CDNA est prise en charge par AMD ROCm™, une pile logicielle ouverte qui inclut un large éventail de modèles de programmation, d'outils, de compilateurs, de bibliothèques et d'exécutions pour les accélérateurs AMD Instinct dédiés au développement de solutions IA et HPC.

Notes de bas de page

©2023 Advanced Micro Devices, Inc. Tous droits réservés. AMD, le logo AMD avec la flèche, AMD Instinct, AMD CDNA, Infinity Fabric, ROCm et toutes leurs combinaisons sont des marques commerciales d'Advanced Micro Devices, Inc. PCIe est une marque déposée de PCI-SIG Corporation. Les autres noms sont donnés à titre indicatif uniquement et peuvent être des marques commerciales de leurs propriétaires respectifs.

- Les calculs réalisés par AMD Performance Labs au 7 novembre 2023 pour l'accélérateur APU AMD Instinct™ MI300A 760 W (HBM3 de 128 Go) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm ont indiqué une capacité de mémoire HBM3 de 128 Go et des performances de bande passante mémoire de crête théorique de 5,325 TFLOPS. L'interface bus mémoire MI300A est de 8 192 bits (1 024 bits x 8 dies) et la vitesse de données de la mémoire est de 5,2 Gbit/s pour une bande passante mémoire de crête totale de 5,325 To/s (interface de bus mémoire de 8 192 bits * vitesse de données de mémoire de 5,2 Gbit/s/8). Les résultats publiés les plus élevés sur l'accélérateur GPU Nvidia Hopper H200 (141 Go) SXM ont indiqué une capacité de mémoire HBM3e de 141 Go et des performances de bande passante mémoire du GPU de 4,8 To/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Les résultats publiés les plus élevés sur l'accélérateur GPU Nvidia Hopper H100 (80 Go) SXM ont indiqué une capacité de mémoire HBM3 de 80 Go et des performances de bande passante mémoire du GPU de 3,35 To/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet Les fabricants de serveurs peuvent faire évoluer les offres de configuration, ce qui aboutirait à des résultats différents. MI300-12

- MI325-001A - Calculs effectués par AMD Performance Labs le 26 septembre 2024, sur la base des spécifications et/ou estimations actuelles. L'accélérateur OAM AMD Instinct™ MI325X offre une capacité de mémoire de 256 Go HBM3E et des performances de bande passante mémoire théorique de pointe du GPU de 6 To/s. Les résultats réels peuvent varier selon la production de silicium.

Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Hopper H200 (141 Go) SXM ont indiqué une capacité de mémoire HBM3E de 141 Go et des performances de bande passante mémoire du GPU de 4,8 To/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Blackwell HGX B100 (192 Go) 700 W ont indiqué une capacité de mémoire HBM3E de 192 Go et des performances de bande passante mémoire du GPU de 8 To/s.

Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Blackwell HGX B200 (192 Go) ont indiqué une capacité de mémoire HBM3E de 192 Go et des performances de bande passante mémoire du GPU de 8 To/s.

Spécifications de Nvidia Blackwell à l'adresse https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZB

©2023 Advanced Micro Devices, Inc. Tous droits réservés. AMD, le logo AMD avec la flèche, AMD Instinct, AMD CDNA, Infinity Fabric, ROCm et toutes leurs combinaisons sont des marques commerciales d'Advanced Micro Devices, Inc. PCIe est une marque déposée de PCI-SIG Corporation. Les autres noms sont donnés à titre indicatif uniquement et peuvent être des marques commerciales de leurs propriétaires respectifs.

- Les calculs réalisés par AMD Performance Labs au 7 novembre 2023 pour l'accélérateur APU AMD Instinct™ MI300A 760 W (HBM3 de 128 Go) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm ont indiqué une capacité de mémoire HBM3 de 128 Go et des performances de bande passante mémoire de crête théorique de 5,325 TFLOPS. L'interface bus mémoire MI300A est de 8 192 bits (1 024 bits x 8 dies) et la vitesse de données de la mémoire est de 5,2 Gbit/s pour une bande passante mémoire de crête totale de 5,325 To/s (interface de bus mémoire de 8 192 bits * vitesse de données de mémoire de 5,2 Gbit/s/8). Les résultats publiés les plus élevés sur l'accélérateur GPU Nvidia Hopper H200 (141 Go) SXM ont indiqué une capacité de mémoire HBM3e de 141 Go et des performances de bande passante mémoire du GPU de 4,8 To/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Les résultats publiés les plus élevés sur l'accélérateur GPU Nvidia Hopper H100 (80 Go) SXM ont indiqué une capacité de mémoire HBM3 de 80 Go et des performances de bande passante mémoire du GPU de 3,35 To/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet Les fabricants de serveurs peuvent faire évoluer les offres de configuration, ce qui aboutirait à des résultats différents. MI300-12

- MI325-001A - Calculs effectués par AMD Performance Labs le 26 septembre 2024, sur la base des spécifications et/ou estimations actuelles. L'accélérateur OAM AMD Instinct™ MI325X offre une capacité de mémoire de 256 Go HBM3E et des performances de bande passante mémoire théorique de pointe du GPU de 6 To/s. Les résultats réels peuvent varier selon la production de silicium. Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Hopper H200 (141 Go) SXM ont indiqué une capacité de mémoire HBM3E de 141 Go et des performances de bande passante mémoire du GPU de 4,8 To/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Blackwell HGX B100 (192 Go) 700 W ont indiqué une capacité de mémoire HBM3E de 192 Go et des performances de bande passante mémoire du GPU de 8 To/s.

Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Blackwell HGX B200 (192 Go) ont indiqué une capacité de mémoire HBM3E de 192 Go et des performances de bande passante mémoire du GPU de 8 To/s.

Spécifications de Nvidia Blackwell à l'adresse https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZB