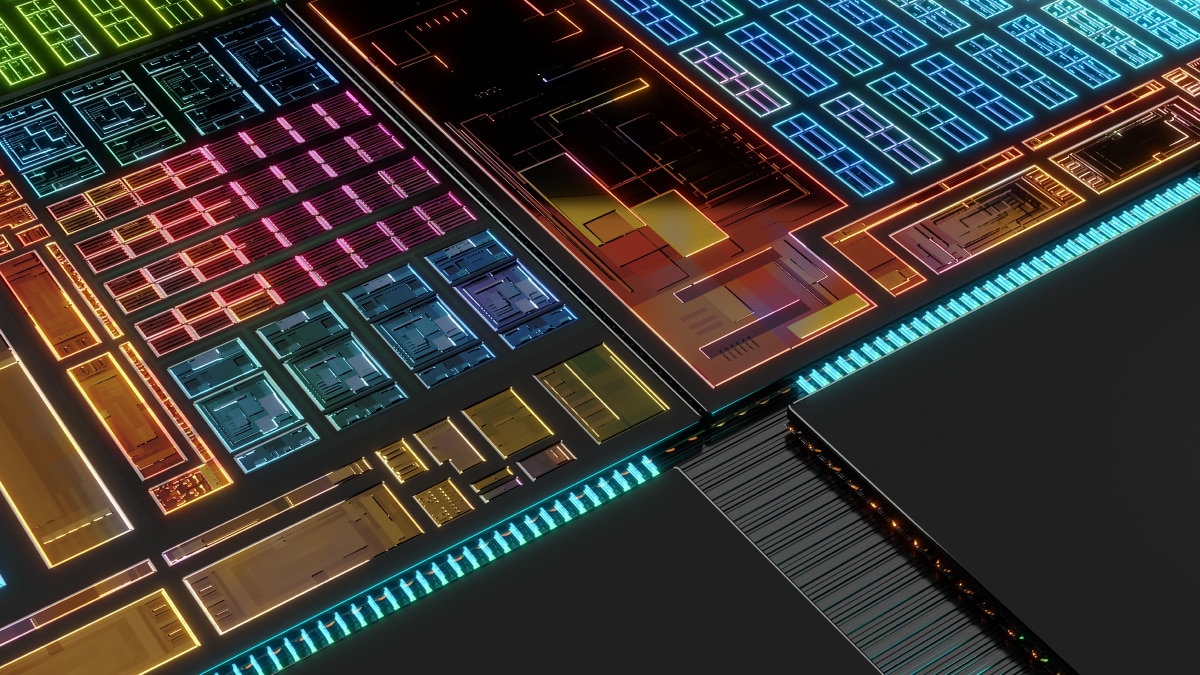

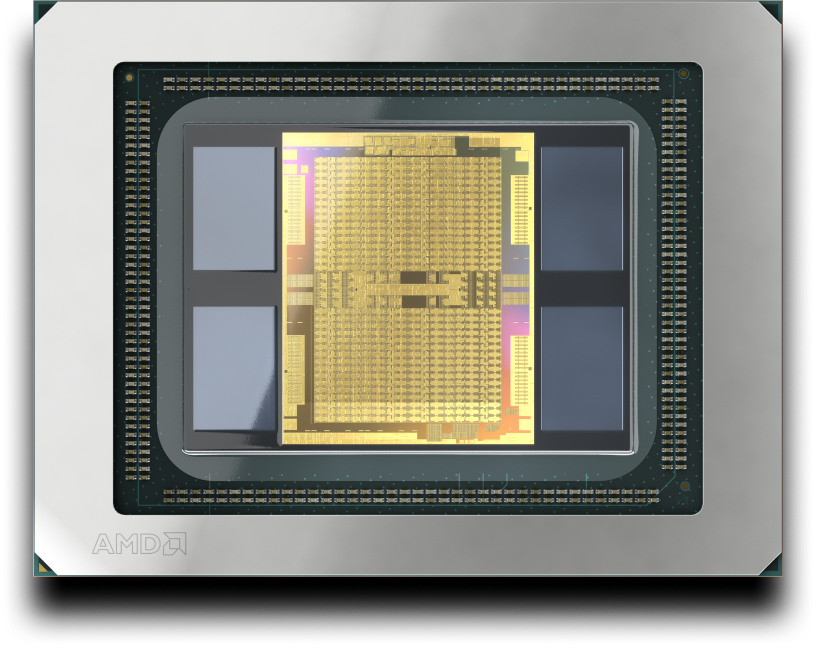

AMD CDNA 3

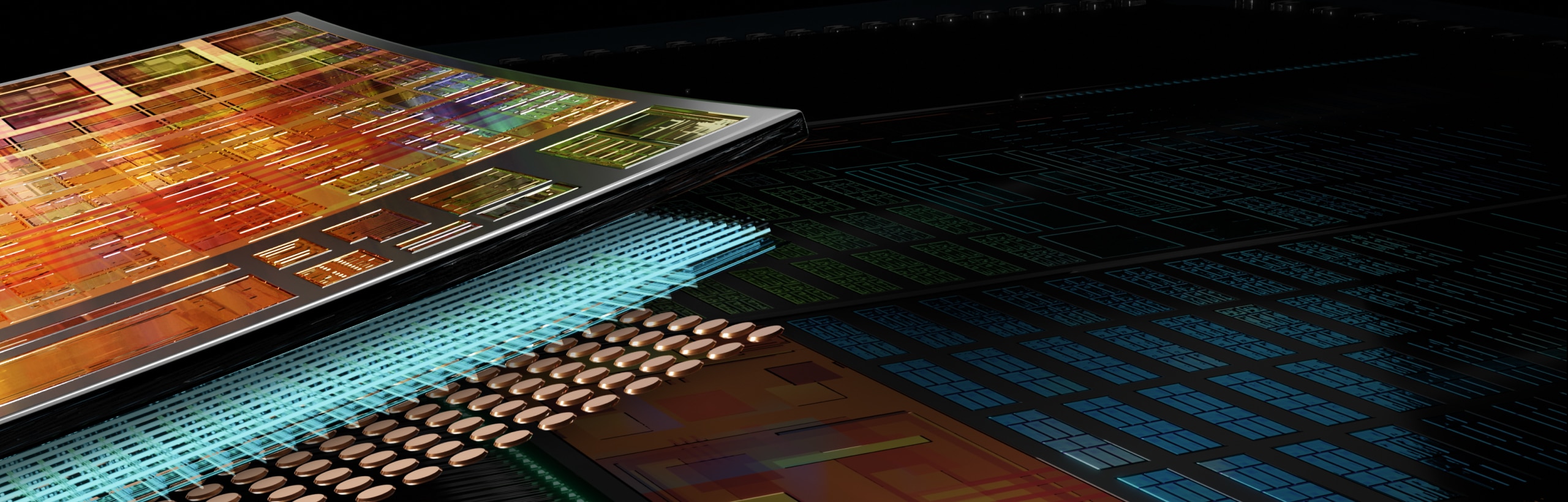

AMD CDNA™ 3 es la arquitectura de procesamiento dedicada que subyace a los aceleradores AMD Instinct™ Serie MI300. Cuenta con un empaque avanzado con tecnologías de chiplet, diseñado para reducir el movimiento excesivo de datos y mejorar el ahorro de energía.

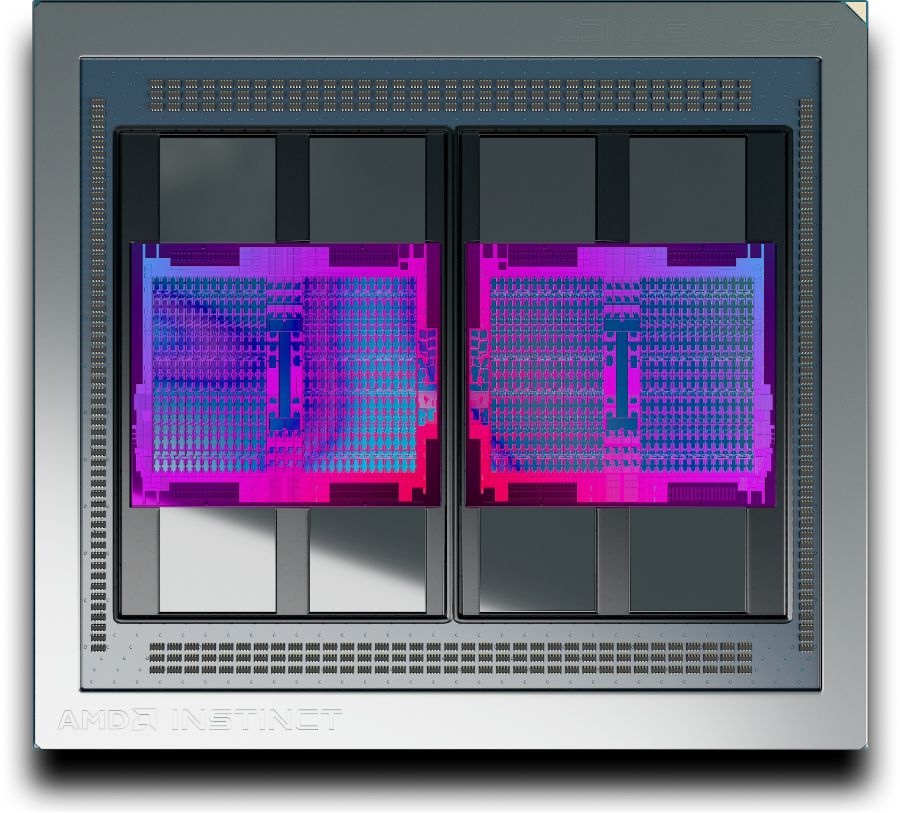

Unidad de procesamiento acelerado AMD Instinct MI300A

Acelerador AMD Instinct MI325X

Tecnologías Matrix Core

AMD CDNA 3 incluye tecnologías Matrix Core que ofrecen un rendimiento computacional mejorado con un paralelismo mejorado en el nivel de instrucción, incluida la compatibilidad para una amplia gama de precisiones (INT8, FP8, BF16, FP16, TF32, FP32 y FP64), así como datos de matriz escasos (es decir, sparsity).

Memoria HBM, caché y coherencia

Los aceleradores AMD Instinct Serie MI300 ofrecen capacidad HBM3e líder en la industria y ancho de banda de memoria1,2, así como memoria compartida y AMD Infinity Cache™ (caché compartida de último nivel), lo que elimina la copia de datos y mejora la latencia.

Fabric unificado

La AMD Infinity Architecture de última generación, junto con la tecnología AMD Infinity Fabric™, permite una unificación coherente y de alto rendimiento de las tecnologías de chiplet de GPU y CPU de AMD con memoria HBM3 apilada en dispositivos únicos y en plataformas de varios dispositivos. También ofrece E/S mejorada con compatibilidad con PCIe® 5.

AMD CDNA 2

La arquitectura AMD CDNA 2 está diseñada para acelerar las cargas de trabajo informáticas científicas y las aplicaciones de aprendizaje automático más exigentes que existen. Sustenta aceleradores AMD Instinct Serie MI200

AMD CDNA

La arquitectura de AMD CDNA es una arquitectura dedicada para el procesamiento basado en GPU que fue diseñada para ser pionera en la informática de clase de exaescala. Sustenta aceleradores AMD Instinct Serie MI100

Aceleradores AMD Instinct

Descubre cómo los aceleradores AMD Instinct potencian la IA y la HPC.

Software AMD ROCm™

La arquitectura de AMD CDNA es compatible con AMD ROCm™, una pila de software abierta que incluye un amplio conjunto de modelos de programación, herramientas, compiladores, bibliotecas y tiempos de ejecución para el desarrollo de soluciones de IA y HPC dirigidas a los aceleradores AMD Instinct.

Notas al pie

© 2023 Advanced Micro Devices, Inc. Todos los derechos reservados. AMD, el logotipo de la flecha de AMD, AMD Instinct, AMD CDNA, Infinity Fabric, ROCm y sus combinaciones son marcas comerciales de Advanced Micro Devices, Inc. PCIe es una marca comercial registrada de PCI-SIG Corporation. Los demás nombres se utilizan solo con fines informativos y pueden ser marcas comerciales de sus respectivos propietarios.

- Las mediciones realizadas en los laboratorios de rendimiento de AMD al 7 de noviembre del 2023 en el acelerador de APU AMD Instinct™ MI300A de 760 W (128 GB de memoria HBM3) diseñado con la tecnología de proceso FinFet de 5 nm de AMD CDNA™ 3 arrojaron como resultado 128 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria máximo teórico de 5,325 TFLOPS. La interfaz de bus de memoria MI300A es de 8,192 (chip de 1024 x 8 bits) y la velocidad de datos de memoria es de 5,2 Gbps para el ancho de banda de memoria máximo total de 5325 TB/s (interfaz de bus de memoria de 8,192 bits * 5,2 Gbps de velocidad de datos de memoria/8). Los resultados más altos publicados acerca del acelerador de GPU NVIDIA Hopper H200 (141 GB) SXM arrojaron como resultado 141 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria de GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Los resultados más altos publicados acerca del acelerador de GPU NVIDIA Hopper H100 (80 GB) SXM arrojaron como resultado 80 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria de GPU de 3,35 TB/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet Los fabricantes de servidores pueden variar las ofertas de configuración, lo que arroja resultados diferentes. MI300-12

- MI325-001A: los cálculos realizados por los laboratorios de rendimiento de AMD al 26 de septiembre del 2024, con base en las especificaciones o estimaciones actuales. El acelerador AMD Instinct™ MI325X OAM tendrá una capacidad de memoria HBM3E de 256 GB y un rendimiento teórico máximo del ancho de banda de memoria de GPU de 6 TB/s. Los resultados reales basados en silicio para producción pueden variar.

Los resultados más altos publicados sobre el acelerador GPU NVidia Hopper H200 (141 GB) SXM arrojaron como resultado 141 GB de capacidad de memoria HBM3E y un rendimiento de ancho de banda de memoria de GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Los resultados más altos publicados sobre el acelerador GPU NVidia Blackwell HGX B100 (192 GB) 700 W arrojaron como resultado 192 GB de capacidad de memoria HBM3E y un rendimiento de ancho de banda de memoria de GPU de 8 TB/s.

Los resultados publicados más altos sobre el acelerador de GPU NVidia Blackwell HGX B200 (192 GB) arrojaron como resultado una capacidad de memoria HBM3E de 192 GB y un rendimiento de ancho de banda de memoria de GPU de 8 TB/s.

Especificaciones de Nvidia Blackwell en https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZB

© 2023 Advanced Micro Devices, Inc. Todos los derechos reservados. AMD, el logotipo de la flecha de AMD, AMD Instinct, AMD CDNA, Infinity Fabric, ROCm y sus combinaciones son marcas comerciales de Advanced Micro Devices, Inc. PCIe es una marca comercial registrada de PCI-SIG Corporation. Los demás nombres se utilizan solo con fines informativos y pueden ser marcas comerciales de sus respectivos propietarios.

- Las mediciones realizadas en los laboratorios de rendimiento de AMD al 7 de noviembre del 2023 en el acelerador de APU AMD Instinct™ MI300A de 760 W (128 GB de memoria HBM3) diseñado con la tecnología de proceso FinFet de 5 nm de AMD CDNA™ 3 arrojaron como resultado 128 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria máximo teórico de 5,325 TFLOPS. La interfaz de bus de memoria MI300A es de 8,192 (chip de 1024 x 8 bits) y la velocidad de datos de memoria es de 5,2 Gbps para el ancho de banda de memoria máximo total de 5325 TB/s (interfaz de bus de memoria de 8,192 bits * 5,2 Gbps de velocidad de datos de memoria/8). Los resultados más altos publicados acerca del acelerador de GPU NVIDIA Hopper H200 (141 GB) SXM arrojaron como resultado 141 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria de GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Los resultados más altos publicados acerca del acelerador de GPU NVIDIA Hopper H100 (80 GB) SXM arrojaron como resultado 80 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria de GPU de 3,35 TB/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet Los fabricantes de servidores pueden variar las ofertas de configuración, lo que arroja resultados diferentes. MI300-12

- MI325-001A: los cálculos realizados por los laboratorios de rendimiento de AMD al 26 de septiembre del 2024, con base en las especificaciones o estimaciones actuales. El acelerador AMD Instinct™ MI325X OAM tendrá una capacidad de memoria HBM3E de 256 GB y un rendimiento teórico máximo del ancho de banda de memoria de GPU de 6 TB/s. Los resultados reales basados en silicio para producción pueden variar. Los resultados más altos publicados sobre el acelerador GPU NVidia Hopper H200 (141 GB) SXM arrojaron como resultado 141 GB de capacidad de memoria HBM3E y un rendimiento de ancho de banda de memoria de GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Los resultados más altos publicados sobre el acelerador GPU NVidia Blackwell HGX B100 (192 GB) 700 W arrojaron como resultado 192 GB de capacidad de memoria HBM3E y un rendimiento de ancho de banda de memoria de GPU de 8 TB/s.

Los resultados publicados más altos sobre el acelerador de GPU NVidia Blackwell HGX B200 (192 GB) arrojaron como resultado una capacidad de memoria HBM3E de 192 GB y un rendimiento de ancho de banda de memoria de GPU de 8 TB/s.

Especificaciones de Nvidia Blackwell en https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZB