Dynamiser l'IA et les HPC

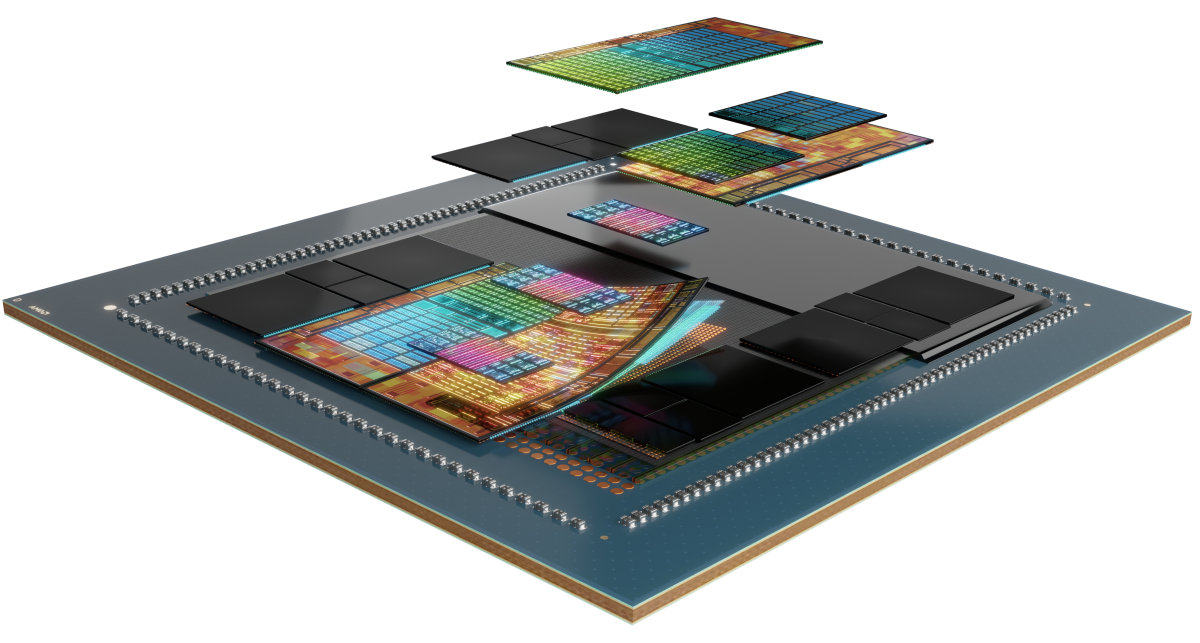

Les accélérateurs AMD Instinct™ Série MI300 sont particulièrement bien adaptés à la gestion des charges de travail d'IA et de HPC les plus exigeantes, offrant des performances de calcul exceptionnelles, une grande densité de mémoire, une bande passante large et la prise en charge de formats de données spécialisés.

Qu'est-ce qui se cache sous le capot ?

Les accélérateurs AMD Instinct série MI300 sont basés sur l'architecture AMD CDNA™ 3, qui offre les technologies Matrix Core et la compatibilité avec une large gamme de capacités de précision, des INT8 et FP8 hautement efficaces (y compris la prise en charge de la dispersion pour l'IA) aux FP64 les plus exigeantes pour les HPC.

Découvrez la série

Découvrez les accélérateurs AMD Instinct Série MI300, les plateformes AMD Instinct Série MI300 et l'APU AMD Instinct MI300A.

Découvrez les accélérateurs AMD Instinct™ MI325X

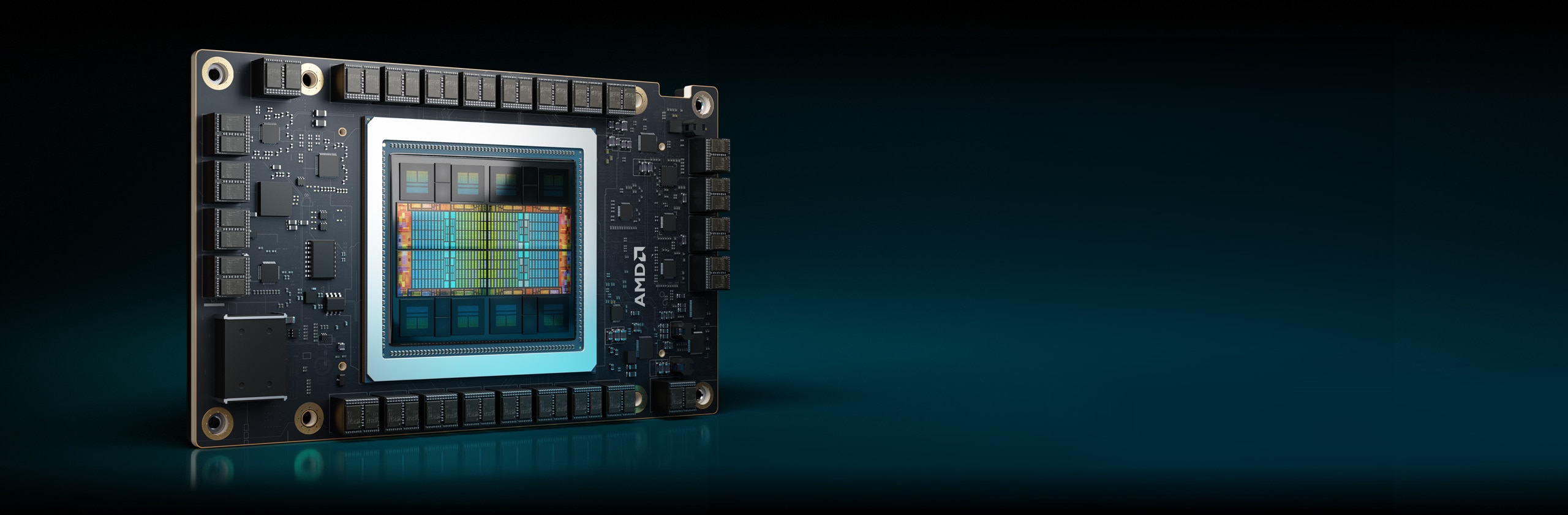

Les accélérateurs GPU AMD Instinct™ MI325X définissent de nouvelles normes en matière de performances d'IA avec l'architecture AMD CDNA™ de 3e génération, offrant des performances et une efficacité incroyables pour l'entraînement et l'inférence. Avec 256 Go de mémoire HBM3E de pointe et une bande passante de 6 To/s, ils optimisent les performances et contribuent à réduire le TCO (coût total de possession).1

304 unités de calcul

304 unités de calcul GPU

256 Go

256 Go de mémoire HBM3E

6 To/s

Bande passante mémoire de crête théorique de 6 To/s

Comparaisons de spécifications

- Performances AI

- Performances HPC

- Mémoire

Performances d'IA (TFLOPS en crête)

Performances d'IA multipliées par 1,3 maximum, par rapport aux accélérateurs concurrents2, 3

SXM H200 141 Go

OAM MI325X 256 Go

Performances HPC (TFLOPS en crête)

Performances HPC multipliées par 2,4 maximum, par rapport aux accélérateurs concurrents3

SXM H200 141 Go

OAM MI325X 256 Go

Capacité de mémoire et bande passante

Capacité de mémoire multipliée par 1,8 et bande passante mémoire multipliée par 1,2, par rapport aux accélérateurs concurrents1

SXM H200 141 Go

OAM MI325X 256 Go

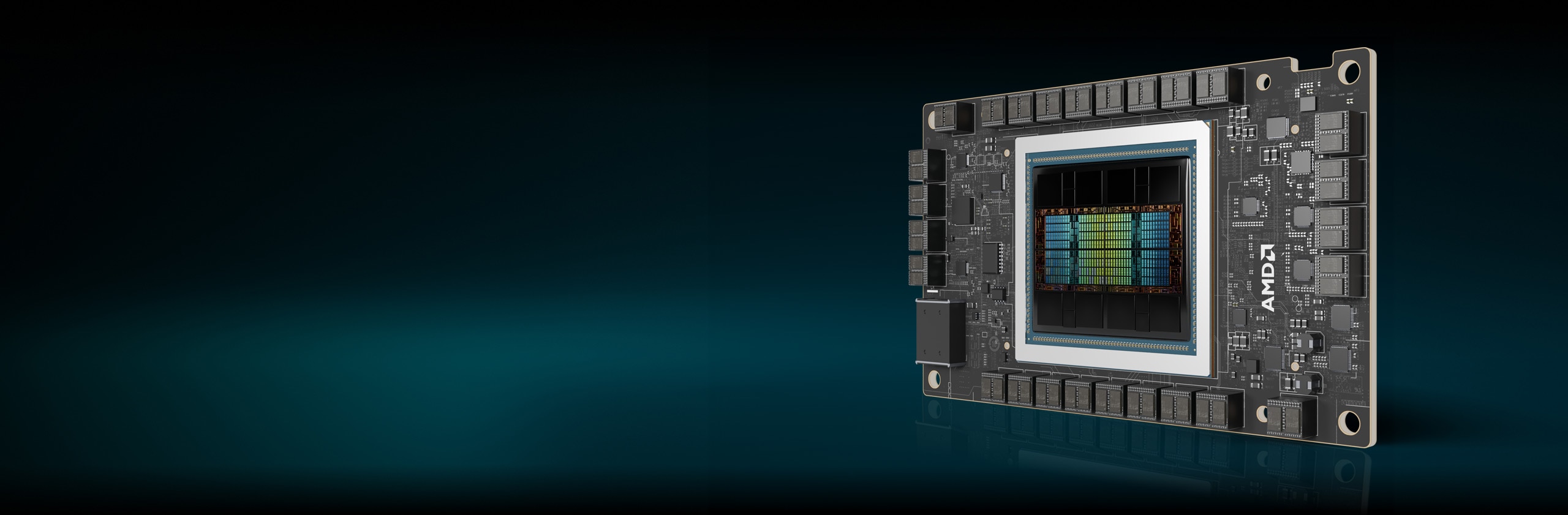

Accélérateurs Instinct MI300X

Les accélérateurs AMD Instinct série MI300X sont conçus pour offrir des performances de pointe pour les charges de travail d'IA générative et les applications HPC.

304 unités de calcul

304 unités de calcul GPU

192 Go

192 Go de mémoire HBM3

5,3 To/s

Bande passante mémoire de crête théorique de 5,3 To/s

Performances AI (TFLOPS en crête)

Performances d'IA multipliées par 1,3 maximum, par rapport aux accélérateurs concurrents6

Performances HPC (TFLOPS en crête)

Performances HPC multipliées par 2,4 maximum, par rapport aux accélérateurs concurrents7

Capacité de mémoire et bande passante

Capacité de mémoire multipliée par 2,4 et bande passante mémoire de crête théorique multipliée par 1,6, par rapport aux accélérateurs concurrents8

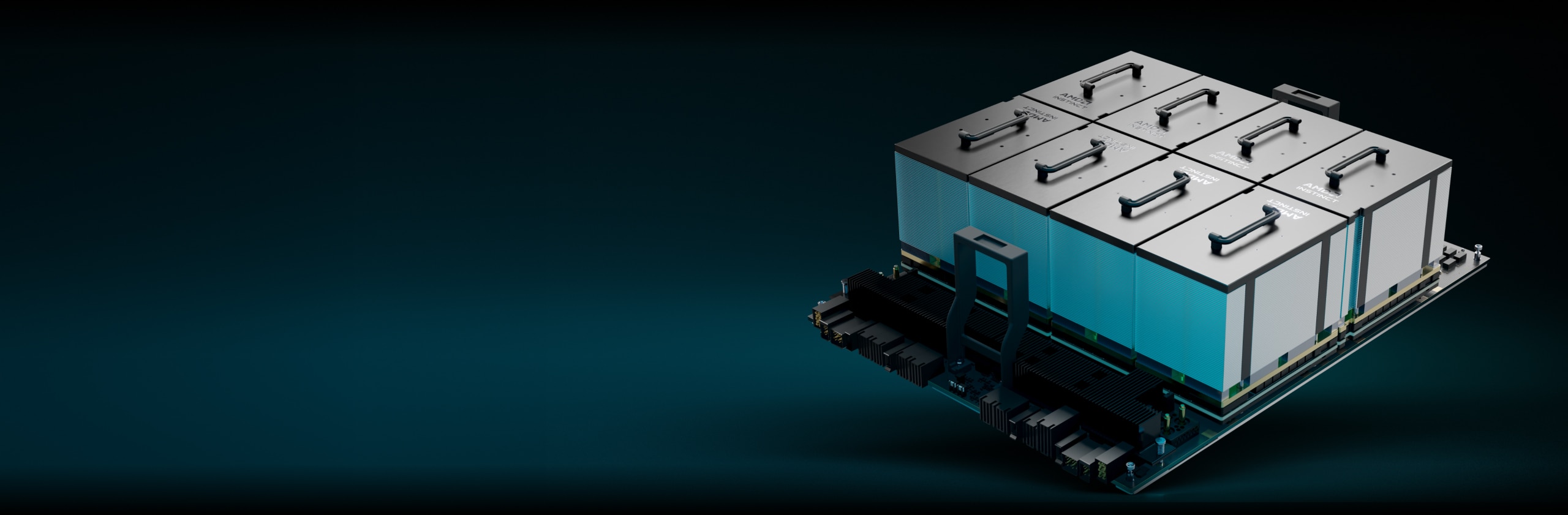

Plateformes AMD Instinct

La plateforme AMD Instinct MI325X intègre 8 modules OAM GPU MI325X entièrement connectés dans une conception OCP standard, via des liaisons AMD Infinity Fabric™ 4e génération, offrant une capacité de mémoire HBM3E maximale de 2 To pour le traitement IA à faible temps de latence. Cette plateforme prête à déployer peut accélérer la mise sur le marché et réduire les coûts de développement grâce à l'ajout des accélérateurs MI325X à l'infrastructure de rack et de serveur d'IA existante.

8 MI325X

8 modules OAM GPU MI325X

2 To

2 To de mémoire HBM3E totale

48 To/s

Bande passante mémoire de crête théorique cumulée de 48 To/s

APU AMD Instinct MI300A

Les unités de calcul accéléré (APU) AMD Instinct MI300A associent la puissance des accélérateurs AMD Instinct et des processeurs AMD EPYC™ avec une mémoire partagée, pour améliorer l'efficacité, la flexibilité et la programmabilité. Elles sont conçues pour accélérer la convergence de l'IA et des HPC, ce qui contribuera à faire progresser la recherche et à stimuler les découvertes.

228 unités de calcul

228 unités de calcul GPU

24

24 cœurs de CPU x86 « Zen 4 »

128 Go

128 Go de mémoire HBM3 unifiée

5,3 To/s

Bande passante mémoire de crête théorique de 5,3 To/s

Performances d'IA (TFLOPS en crête)11

Performances HPC (TFLOPS en crête)

Performances HPC multipliées par 1,8 maximum par rapport aux accélérateurs concurrents12

Capacité de mémoire et bande passante

Capacité de mémoire multipliée par 2,4 et bande passante mémoire de crête théorique multipliée par 1,6, par rapport aux accélérateurs concurrents13

Faire progresser le calcul exascale

Les accélérateurs AMD Instinct propulsent certains des meilleurs supercalculateurs au monde, notamment le système El Capitan du Lawrence Livermore National Laboratory. Découvrez comment ce supercalculateur à deux exascales utilisera l'IA pour exécuter des simulations uniques en leur genre afin de faire progresser la recherche scientifique.

Logiciel AMD ROCm™

Le logiciel AMD ROCm™ inclut un large éventail de modèles de programmation, d'outils, de compilateurs, de bibliothèques et d'exécutions pour les accélérateurs AMD Instinct dédiés aux charges de travail d'IA et de HPC.

Études de cas

Trouver des solutions

Trouvez un partenaire offrant des solutions basées sur les accélérateurs AMD Instinct.

Ressources

Tenez-vous au courant

Abonnez-vous pour recevoir les actualités et contenus les plus récents sur les centres de données et les serveurs.

Notes de bas de page

- MI325-001A - Calculs effectués par AMD Performance Labs le 26 septembre 2024, sur la base des spécifications et/ou estimations actuelles. L'accélérateur OAM AMD Instinct™ MI325X offre une capacité de mémoire de 256 Go HBM3E et des performances de bande passante mémoire théorique de pointe du GPU de 6 To/s. Les résultats réels peuvent varier selon la production de silicium.

Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Hopper H200 (141 Go) SXM ont indiqué une capacité de mémoire HBM3E de 141 Go et des performances de bande passante mémoire du GPU de 4,8 To/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Blackwell HGX B100 (192 Go) 700 W ont indiqué une capacité de mémoire HBM3E de 192 Go et des performances de bande passante mémoire du GPU de 8 To/s.

Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Blackwell HGX B200 (192 Go) ont indiqué une capacité de mémoire HBM3E de 192 Go et des performances de bande passante mémoire du GPU de 8 To/s.

Spécifications de Nvidia Blackwell à l'adresse https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy

- MI325-002 - Les calculs effectués par AMD Performance Labs le 28 mai 2024 pour le GPU AMD Instinct™ MI325X ont indiqué 1 307,4 TFLOPS en crête en demi-précision théorique (FP16), 1 307,4 TFLOPS en crête en précision au format Bfloat16 théorique (BF16), 2 614,9 TFLOPS en crête en précision 8 bits théorique (FP8), 2 614,9 TOPS en performance de calcul en virgule flottante INT8. Les performances réelles varieront en fonction des spécifications finales et de la configuration du système.

Résultats publiés avec le GPU Nvidia H200 SXM (141 Go) : 989,4 TFLOPS en crête de tenseur en demi-précision théorique (Tensor FP16), 989,4 TFLOPS en crête en précision au format de tenseur Bfloat16 théorique (Tensor BF16), 1 978,9 TFLOPS en crête en précision de 8 bits théorique (FP8), 1 978,9 TOPS en crête de performance de calcul en virgule flottante INT8 théorique. Les performances du cœur Tensor BFLOAT16, du cœur Tensor FP16, du cœur Tensor FP8 et du cœur Tensor INT8 ont été communiquées par Nvidia en utilisant la dispersion ; à des fins de comparaison, AMD a converti ces chiffres en chiffres non dispersés/denses en les divisant par 2, et ces chiffres apparaissent ci-dessus

Source Nvidia H200 : https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 et https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Remarque : les GPU Nvidia H200 ont les mêmes performances en FLOPS publiées que les produits H100 https://resources.nvidia.com/en-us-tensor-core/. MI325-02

- MI325-008 - Les calculs réalisés par AMD Performance Labs le 2 octobre 2024 sur le GPU AMD Instinct™ MI325X (1 000 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de calcul en virgule flottante de 163,4 TFLOPS en crête en matrice double précision théorique (matrice FP64), de 81,7 TFLOPS en crête en double précision théorique (FP64), de 163,4 TFLOPS en crête en matrice simple précision théorique (matrice FP32), de 163,4 TFLOPS en crête en simple précision théorique (FP32), de 653,7 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 1 307,4 TFLOPS en crête en demi-précision théorique (FP16). Les performances réelles peuvent varier en fonction des spécifications finales et de la configuration du système.

Résultats publiés avec le GPU Nvidia H200 SXM (141 Go) : 66,9 TFLOPS en crête de tenseur en double précision théorique (Tensor FP64), 33,5 TFLOPS en crête en double précision théorique (FP64), 66,9 TFLOPS en crête en simple précision théorique (FP32), 494,7 TFLOPS en crête de format TensorFloat-32 (TF32), 989,5 TFLOPS en crête de tenseur en demi-précision théorique (Tensor FP16). Les performances du cœur Tensor TF32 ont été communiquées par Nvidia en utilisant la dispersion ; à des fins de comparaison, AMD a converti ces chiffres en chiffres non dispersés/denses en les divisant par 2, et ces chiffres apparaissent ci-dessus.

Source Nvidia H200 : https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 et https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Remarque : les GPU Nvidia H200 ont les mêmes performances en FLOPS publiées que les produits H100 https://resources.nvidia.com/en-us-tensor-core/.

*Les GPU Nvidia H200 ne prennent pas en charge Tensor FP32.

- Les mesures réalisées par AMD Performance Labs au 11 novembre 2023 sur le GPU AMD Instinct™ MI300X (750 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de calcul en virgule flottante de 653,7 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 1 307,4 TFLOPS en crête en demi-précision théorique (FP16), de 1 307,4 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 2 614,9 TFLOPS en crête en précision 8 bits théorique (FP8) et de 2 614,9 TOPS en format INT8. Profitant d'une dispersion structurelle précise, l'efficacité mathématique du MI300X est estimée 2 fois supérieure, donnant ainsi des performances de calcul en virgule flottante avec dispersion de 1 307,4 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 2 614,9 TFLOPS en crête en demi-précision théorique (FP16), de 2 614,9 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 5 229,8 TFLOPS en crête en précision 8 bits théorique (FP8) et de 5 229,8 TOPS en format INT8. Les résultats calculés pour l'accélérateur OAM AMD Instinct™ MI250X (560 W) HBM2e de 128 Go conçu avec la technologie de processus AMD CDNA™ 2 FinFET 5 nm à une fréquence du processeur boostée maximale de 1 700 MHz ont donné des performances de calcul en virgule flottante de 383 TFLOPS en crête en demi-précision théorique (FP16), TF32* (N/A), de 383 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), FP8* (N/A) et de 383 TOPS en format INT8. * Les GPU AMD Instinct Série MI200 ne prennent pas en charge les formats TF32 et FP8, ainsi que la dispersion. MI300-16

- Mesures réalisées par les laboratoires internes AMD Performance Labs au 2 juin 2023 selon les spécifications actuelles et/ou les calculs techniques internes. Le grand modèle de langage (LLM) est exécuté ou calculé avec une précision de FP16 afin de déterminer le nombre minimum de GPU nécessaires pour exécuter les modèles Falcon-7B (7 milliards, 40 milliards de paramètres), LLaMA (13 milliards, 33 milliards de paramètres), OPT (66 milliards de paramètres), GPT-3 (175 milliards de paramètres), BLOOM (176 milliards de paramètres) et PaLM (340 milliards, 540 milliards de paramètres). Estimations calculées en fonction de la taille de la mémoire du GPU uniquement, par rapport à la mémoire requise par le modèle, aux paramètres définis et en ajoutant 10 % supplémentaires. Les calculs reposent sur des tailles de mémoire de modèle publiées et parfois préliminaires. Les résultats GPT-3, BLOOM et PaLM sont estimés sur le MI300X en raison de la disponibilité du système/des pièces. Configurations des résultats des tests : système AMD Lab comprenant 1 CPU EPYC 9654 (96 cœurs) doté d'un accélérateur AMD Instinct™ MI300X 750 W (192 Go de mémoire HBM3, module OAM)

Résultats (précision FP16) :

Modèle

Paramètres

Mémoire totale requise

MI300X requis

Falcon-7B

7 milliards

15,4 Go

1 réel

LLaMA

13 milliards

44 Go

1 réel

LLaMA

33 milliards

72,5 Go

1 réel

Falcon-40B

40 milliards

88 Go

1 réel

OPT

66 milliards

145,2 Go

1 réel

GPT-3

175 milliards

385 Go

3 calculés

Bloom

176 milliards

387,2 Go

3 calculés

PaLM

340 milliards

748 Go

4 calculés

PaLM

540 milliards

1 188 Go

7 calculés

Les estimations calculées peuvent varier en fonction de la taille du modèle final ; les estimations et les valeurs réelles peuvent varier en fonction des quantités supplémentaires requises et de l'utilisation de la mémoire système au-delà du GPU. Les fabricants de serveurs peuvent faire évoluer les offres de configuration, ce qui aboutirait à des résultats différents. MI300-07

- Les mesures réalisées par AMD Performance Labs au 11 novembre 2023 sur le GPU AMD Instinct™ MI300X (750 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de calcul en virgule flottante de 653,7 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 1 307,4 TFLOPS en crête en demi-précision théorique (FP16), de 1 307,4 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 2 614,9 TFLOPS en crête en précision 8 bits théorique (FP8) et de 2 614,9 TOPS en format INT8. Profitant d'une dispersion structurelle précise, l'efficacité mathématique du MI300X est estimée 2 fois supérieure, donnant ainsi des performances de calcul en virgule flottante avec dispersion de 1 307,4 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 2 614,9 TFLOPS en crête en demi-précision théorique (FP16), de 2 614,9 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 5 229,8 TFLOPS en crête en précision 8 bits théorique (FP8) et de 5 229,8 TOPS en format INT8. Les résultats publiés sur le GPU Nvidia H100 SXM (80 Go) 700 W ont donné des performances de calcul en virgule flottante, avec dispersion, de 989,4 TFLOPS en crête en format TensorFloat-32 (TF32), de 1 978,9 TFLOPS en crête en demi-précision théorique (FP16), de 1 978,9 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 3 957,8 TFLOPS en crête en précision 8 bits théorique (FP8) et de 3,957,8 TOPS en crête de format INT8 théorique. Source Nvidia H100 : https://resources.nvidia.com/en-us-tensor-core. MI300-17

- Les mesures réalisées par AMD Performance Labs au 11 novembre 2023 sur le GPU AMD Instinct™ MI300X (750 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de calcul en virgule flottante de 163,4 TFLOPS en crête en matrice double précision théorique (matrice FP64), de 81,7 TFLOPS en crête en double précision théorique (FP64), de 163,4 TFLOPS en crête en matrice simple précision théorique (matrice FP32), de 163,4 TFLOPS en crête en simple précision théorique (FP32), de 653,7 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 1 307,4 TFLOPS en crête en demi-précision théorique (FP16), de 1 307,4 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 2 614,9 TFLOPS en crête en précision 8 bits théorique (FP8) et de 2 614,9 TOPS en format INT8. Les résultats publiés sur le GPU Nvidia H100 SXM (80 Go) ont donné des performances de calcul en virgule flottante de 66,9 TFLOPS en crête en format Tensor en double précision théorique (Tensor FP64), de 33,5 TFLOPS en crête en double précision théorique (FP64), de 66,9 TFLOPS en crête en simple précision théorique (FP32), de 494,7 TFLOPS en crête en format TensorFloat-32 (TF32)*, de 989,4 TFLOPS en crête en format Tensor en demi-précision théorique (Tensor FP16), de 133,8 TFLOPS en crête en demi-précision théorique (FP16), de 989,4 TFLOPS en crête en précision de format Tensor Bfloat16 théorique (Tensor BF16), de 133,8 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 1 978,9 TFLOPS en crête en précision 8 bits théorique (FP8) et de 1 978,9 TOPS en crête de format INT8 théorique. Source Nvidia H100 : https://resources.nvidia.com/en-us-tensor-core/ * Les GPU Nvidia H100 ne prennent pas en charge Tensor FP32. MI300-18

- Les calculs réalisés par AMD Performance Labs au 17 novembre 2023 pour l'accélérateur OAM AMD Instinct™ MI300X 750 W (HBM3 de 192 Go) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm ont indiqué une capacité de mémoire HBM3 de 192 Go et des performances de bande passante mémoire de crête théorique de 5,325 TFLOPS. L'interface bus mémoire MI300X est de 8 192 bits et la vitesse de données de la mémoire est de 5,2 Gbit/s pour une bande passante mémoire de crête totale de 5,325 To/s (interface de bus mémoire de 8 192 bits * vitesse de données de mémoire de 5,2 Gbit/s/8). Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Hopper H200 (141 Go) SXM ont indiqué une capacité de mémoire HBM3e de 141 Go et des performances de bande passante mémoire du GPU de 4,8 To/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Hopper H100 (80 Go) SXM5 ont indiqué une capacité de mémoire HBM3 de 80 Go et des performances de bande passante mémoire du GPU de 3,35 To/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A

- Les mesures réalisées par AMD Performance Labs au 18 novembre 2023 sur le GPU AMD Instinct™ MI300X (HBM3 de 192 Go) 750 W conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de 1 307,4 TFLOPS en crête en demi-précision théorique (FP16) et de 1 307,4 TFLOPS en crête en précision de format Bfloat16 théorique (BF16). Profitant d'une dispersion structurelle précise, l'efficacité mathématique du MI300X est estimée 2 fois supérieure, donnant ainsi des performances de calcul en virgule flottante avec dispersion de 2 614,9 TFLOPS en crête en demi-précision théorique (FP16) et de 2 614,9 TFLOPS en crête en précision de format Bfloat16 théorique (BF16). Les résultats publiés sur le GPU Nvidia H100 SXM (HBM3 de 80 Go) 700 W ont indiqué des performances de calcul en virgule flottante, avec dispersion, de 1 978,9 TFLOPS en crête en demi-précision théorique (FP16) et de 1 978,9 TFLOPS en crête en précision de format Bfloat16 théorique (BF16). Source Nvidia H100 : https://resources.nvidia.com/en-us-tensor-core/ Les accélérateurs AMD Instinct™ MI300X, basés sur la technologie AMD CDNA 3, incluent jusqu'à huit liaisons AMD Infinity Fabric, fournissant jusqu'à 1 024 Go/s de bande passante GPU peer-to-peer (P2P) de données de transport théorique de crête au total par module GPU OAM. MI300-25

- Les mesures réalisées par AMD Performance Labs au 11 novembre 2023 sur l'APU AMD Instinct™ MI300A (760 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz en crête ont donné des performances de calcul en virgule flottante de 122,6 TFLOPS en crête en double précision théorique (matrice FP64), de 61,3 TFLOPS en crête en double précision théorique (FP64), de 122,6 TFLOPS en crête en matrice simple précision théorique (matrice FP32), de 122,6 TFLOPS en crête en simple précision théorique (FP32), de 490,3 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 980,6 TFLOPS en crête en demi-précision théorique (FP16), de 980,6 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 1961,2 TFLOPS en crête en précision 8 bits théorique (FP8) et de 1961,2 TOPS en format INT8. Les résultats calculés pour l'accélérateur OAM AMD Instinct™ MI250X (560 W) HBM2e de 128 Go, conçu avec la technologie de processus AMD CDNA™ 2 FinFET 5 nm, à une fréquence du processeur boostée maximale de 1 700 MHz, ont donné des performances de calcul en virgule flottante de 95,7 TFLOPS en crête en double précision théorique (matrice FP64), de 47,9 TFLOPS en crête en double précision théorique (FP64), de 95,7 TFLOPS en crête en matrice simple précision théorique (matrice FP32), de 47,9 TFLOPS en crête en simple précision théorique (FP32), TF32* (N/A), de 383 TFLOPS en crête en demi-précision théorique (FP16), de 383 TFLOPS en crête en précision de format Bfloat16 (BF16), FP8* (N/A) et de 383 TOPS en format INT8. Les fabricants de serveurs peuvent faire évoluer les offres de configuration, ce qui aboutirait à des résultats différents. * Les GPU Série MI200 ne prennent pas en charge les formats TF32 et FP8, ainsi que la dispersion. MI300-10

- Les mesures réalisées par AMD Performance Labs au 11 novembre 2023 sur le APU AMD Instinct™ MI300A (750 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de calcul en virgule flottante de 490,29 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 980,58 TFLOPS en crête en demi-précision théorique (FP16), de 980,58 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 1 961,16 TFLOPS en crête en précision 8 bits théorique (FP8) et de 1 961,16 TOPS en format INT8. Profitant d'une dispersion structurelle précise, l'efficacité mathématique du MI300A est estimée 2 fois supérieure, donnant ainsi des performances de calcul en virgule flottante avec dispersion de 980,58 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 1 961,16 TFLOPS en crête en demi-précision théorique (FP16), de 1 961,16 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 3 922,33 TFLOPS en crête en précision 8 bits théorique (FP8) et de 3 922,33 TOPS en format INT8. Les résultats publiés sur le GPU Nvidia H100 SXM5 (80 Go) ont donné des performances de calcul en virgule flottante, avec dispersion, de 989,4 TFLOPS en crête en format TensorFloat-32 (TF32, cœur Tensor), de 1 978,9 TFLOPS en crête en demi-précision théorique (FP16, cœur Tensor), de 1 978,9 TFLOPS en crête en précision de format Bfloat16 théorique (BF16, cœur Tensor), de 3 957,8 TFLOPS en crête en précision 8 bits théorique (FP8, cœur Tensor) et de 3 957,8 TOPS en crête de format INT8 théorique (cœur Tensor). Source Nvidia H100 : https://resources.nvidia.com/en-us-tensor-core/ Les fabricants de serveurs peuvent faire évoluer les offres de configuration, ce qui aboutirait à des résultats différents. MI300-21

- Les mesures réalisées par AMD Performance Labs au 11 novembre 2023 sur le GPU AMD Instinct™ MI300A (760 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de calcul en virgule flottante de 122,6 TFLOPS en crête en matrice double précision théorique (matrice FP64), de 61,3 TFLOPS en crête en double précision théorique (FP64), de 122,6 TFLOPS en crête en matrice simple précision théorique (matrice FP32), de 122,6 TFLOPS en crête en simple précision théorique (FP32), de 490,29 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 980,58 TFLOPS en crête en demi-précision théorique (FP16), de 980,58 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 1 961,16 TFLOPS en crête en précision 8 bits théorique (FP8) et de 1 961,16 TOPS en format INT8. Les résultats publiés sur le GPU Nvidia H100 SXM (80 Go) 700 W ont donné des performances de calcul en virgule flottante de 66,9 TFLOPS en crête en format Tensor en double précision théorique (Tensor FP64), de 33,5 TFLOPS en crête en double précision théorique (FP64), de 66,9 TFLOPS en crête en simple précision théorique (FP32), de 494,7 TFLOPS en crête en format TensorFloat-32 (TF32)*, de 989,4 TFLOPS en crête en format Tensor en demi-précision théorique (Tensor FP16), de 133,8 TFLOPS en crête en demi-précision théorique (FP16), de 989,4 TFLOPS en crête en précision de format Tensor Bfloat16 théorique (Tensor BF16), de 133,8 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 1 978,9 TFLOPS en crête en précision 8 bits théorique (FP8) et de 1 978,9 TOPS en crête de format INT8 théorique. Source Nvidia H100 : https://resources.nvidia.com/en-us-tensor-core/ Les fabricants de serveurs peuvent faire évoluer les offres de configuration, ce qui aboutirait à des résultats différents. * Les GPU Nvidia H100 ne prennent pas en charge Tensor FP32. MI300-20

- Les calculs réalisés par AMD Performance Labs au 7 novembre 2023 pour l'accélérateur APU AMD Instinct™ MI300A 760 W (HBM3 de 128 Go) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm ont indiqué une capacité de mémoire HBM3 de 128 Go et des performances de bande passante mémoire de crête théorique de 5,325 TFLOPS. L'interface bus mémoire MI300A est de 8 192 bits (1 024 bits x 8 dies) et la vitesse de données de la mémoire est de 5,2 Gbit/s pour une bande passante mémoire de crête totale de 5,325 To/s (interface de bus mémoire de 8 192 bits * vitesse de données de mémoire de 5,2 Gbit/s/8). Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Hopper H200 (141 Go) SXM ont indiqué une capacité de mémoire HBM3e de 141 Go et des performances de bande passante mémoire du GPU de 4,8 To/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Hopper H100 (80 Go) SXM ont indiqué une capacité de mémoire HBM3 de 80 Go et des performances de bande passante mémoire du GPU de 3,35 To/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet Les fabricants de serveurs peuvent faire évoluer les offres de configuration, ce qui aboutirait à des résultats différents. MI300-12

- MI325-001A - Calculs effectués par AMD Performance Labs le 26 septembre 2024, sur la base des spécifications et/ou estimations actuelles. L'accélérateur OAM AMD Instinct™ MI325X offre une capacité de mémoire de 256 Go HBM3E et des performances de bande passante mémoire théorique de pointe du GPU de 6 To/s. Les résultats réels peuvent varier selon la production de silicium.

Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Hopper H200 (141 Go) SXM ont indiqué une capacité de mémoire HBM3E de 141 Go et des performances de bande passante mémoire du GPU de 4,8 To/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Blackwell HGX B100 (192 Go) 700 W ont indiqué une capacité de mémoire HBM3E de 192 Go et des performances de bande passante mémoire du GPU de 8 To/s.

Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Blackwell HGX B200 (192 Go) ont indiqué une capacité de mémoire HBM3E de 192 Go et des performances de bande passante mémoire du GPU de 8 To/s.

Spécifications de Nvidia Blackwell à l'adresse https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy - MI325-002 - Les calculs effectués par AMD Performance Labs le 28 mai 2024 pour le GPU AMD Instinct™ MI325X ont indiqué 1 307,4 TFLOPS en crête en demi-précision théorique (FP16), 1 307,4 TFLOPS en crête en précision au format Bfloat16 théorique (BF16), 2 614,9 TFLOPS en crête en précision 8 bits théorique (FP8), 2 614,9 TOPS en performance de calcul en virgule flottante INT8. Les performances réelles varieront en fonction des spécifications finales et de la configuration du système.

Résultats publiés avec le GPU Nvidia H200 SXM (141 Go) : 989,4 TFLOPS en crête de tenseur en demi-précision théorique (Tensor FP16), 989,4 TFLOPS en crête en précision au format de tenseur Bfloat16 théorique (Tensor BF16), 1 978,9 TFLOPS en crête en précision de 8 bits théorique (FP8), 1 978,9 TOPS en crête de performance de calcul en virgule flottante INT8 théorique. Les performances du cœur Tensor BFLOAT16, du cœur Tensor FP16, du cœur Tensor FP8 et du cœur Tensor INT8 ont été communiquées par Nvidia en utilisant la dispersion ; à des fins de comparaison, AMD a converti ces chiffres en chiffres non dispersés/denses en les divisant par 2, et ces chiffres apparaissent ci-dessus

Source Nvidia H200 : https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 et https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Remarque : les GPU Nvidia H200 ont les mêmes performances en FLOPS publiées que les produits H100 https://resources.nvidia.com/en-us-tensor-core/. MI325-02 - MI325-008 - Les calculs réalisés par AMD Performance Labs le 2 octobre 2024 sur le GPU AMD Instinct™ MI325X (1 000 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de calcul en virgule flottante de 163,4 TFLOPS en crête en matrice double précision théorique (matrice FP64), de 81,7 TFLOPS en crête en double précision théorique (FP64), de 163,4 TFLOPS en crête en matrice simple précision théorique (matrice FP32), de 163,4 TFLOPS en crête en simple précision théorique (FP32), de 653,7 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 1 307,4 TFLOPS en crête en demi-précision théorique (FP16). Les performances réelles peuvent varier en fonction des spécifications finales et de la configuration du système.

Résultats publiés avec le GPU Nvidia H200 SXM (141 Go) : 66,9 TFLOPS en crête de tenseur en double précision théorique (Tensor FP64), 33,5 TFLOPS en crête en double précision théorique (FP64), 66,9 TFLOPS en crête en simple précision théorique (FP32), 494,7 TFLOPS en crête de format TensorFloat-32 (TF32), 989,5 TFLOPS en crête de tenseur en demi-précision théorique (Tensor FP16). Les performances du cœur Tensor TF32 ont été communiquées par Nvidia en utilisant la dispersion ; à des fins de comparaison, AMD a converti ces chiffres en chiffres non dispersés/denses en les divisant par 2, et ces chiffres apparaissent ci-dessus.

Source Nvidia H200 : https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 et https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Remarque : les GPU Nvidia H200 ont les mêmes performances en FLOPS publiées que les produits H100 https://resources.nvidia.com/en-us-tensor-core/.

*Les GPU Nvidia H200 ne prennent pas en charge Tensor FP32. - Les mesures réalisées par AMD Performance Labs au 11 novembre 2023 sur le GPU AMD Instinct™ MI300X (750 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de calcul en virgule flottante de 653,7 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 1 307,4 TFLOPS en crête en demi-précision théorique (FP16), de 1 307,4 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 2 614,9 TFLOPS en crête en précision 8 bits théorique (FP8) et de 2 614,9 TOPS en format INT8. Profitant d'une dispersion structurelle précise, l'efficacité mathématique du MI300X est estimée 2 fois supérieure, donnant ainsi des performances de calcul en virgule flottante avec dispersion de 1 307,4 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 2 614,9 TFLOPS en crête en demi-précision théorique (FP16), de 2 614,9 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 5 229,8 TFLOPS en crête en précision 8 bits théorique (FP8) et de 5 229,8 TOPS en format INT8. Les résultats calculés pour l'accélérateur OAM AMD Instinct™ MI250X (560 W) HBM2e de 128 Go conçu avec la technologie de processus AMD CDNA™ 2 FinFET 5 nm à une fréquence du processeur boostée maximale de 1 700 MHz ont donné des performances de calcul en virgule flottante de 383 TFLOPS en crête en demi-précision théorique (FP16), TF32* (N/A), de 383 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), FP8* (N/A) et de 383 TOPS en format INT8. * Les GPU AMD Instinct Série MI200 ne prennent pas en charge les formats TF32 et FP8, ainsi que la dispersion. MI300-16

- Mesures réalisées par les laboratoires internes AMD Performance Labs au 2 juin 2023 selon les spécifications actuelles et/ou les calculs techniques internes. Le grand modèle de langage (LLM) est exécuté ou calculé avec une précision de FP16 afin de déterminer le nombre minimum de GPU nécessaires pour exécuter les modèles Falcon-7B (7 milliards, 40 milliards de paramètres), LLaMA (13 milliards, 33 milliards de paramètres), OPT (66 milliards de paramètres), GPT-3 (175 milliards de paramètres), BLOOM (176 milliards de paramètres) et PaLM (340 milliards, 540 milliards de paramètres). Estimations calculées en fonction de la taille de la mémoire du GPU uniquement, par rapport à la mémoire requise par le modèle, aux paramètres définis et en ajoutant 10 % supplémentaires. Les calculs reposent sur des tailles de mémoire de modèle publiées et parfois préliminaires. Les résultats GPT-3, BLOOM et PaLM sont estimés sur le MI300X en raison de la disponibilité du système/des pièces. Configurations des résultats des tests : système AMD Lab comprenant 1 CPU EPYC 9654 (96 cœurs) doté d'un accélérateur AMD Instinct™ MI300X 750 W (192 Go de mémoire HBM3, module OAM)

Résultats (précision FP16) :

Modèle Paramètres Mémoire totale requise MI300X requis Falcon-7B 7 milliards 15,4 Go 1 réel LLaMA 13 milliards 44 Go 1 réel LLaMA 33 milliards 72,5 Go 1 réel Falcon-40B 40 milliards 88 Go 1 réel OPT 66 milliards 145,2 Go 1 réel GPT-3 175 milliards 385 Go 3 calculés Bloom 176 milliards 387,2 Go 3 calculés PaLM 340 milliards 748 Go 4 calculés PaLM 540 milliards 1 188 Go 7 calculés Les estimations calculées peuvent varier en fonction de la taille du modèle final ; les estimations et les valeurs réelles peuvent varier en fonction des quantités supplémentaires requises et de l'utilisation de la mémoire système au-delà du GPU. Les fabricants de serveurs peuvent faire évoluer les offres de configuration, ce qui aboutirait à des résultats différents. MI300-07

- Les mesures réalisées par AMD Performance Labs au 11 novembre 2023 sur le GPU AMD Instinct™ MI300X (750 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de calcul en virgule flottante de 653,7 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 1 307,4 TFLOPS en crête en demi-précision théorique (FP16), de 1 307,4 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 2 614,9 TFLOPS en crête en précision 8 bits théorique (FP8) et de 2 614,9 TOPS en format INT8. Profitant d'une dispersion structurelle précise, l'efficacité mathématique du MI300X est estimée 2 fois supérieure, donnant ainsi des performances de calcul en virgule flottante avec dispersion de 1 307,4 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 2 614,9 TFLOPS en crête en demi-précision théorique (FP16), de 2 614,9 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 5 229,8 TFLOPS en crête en précision 8 bits théorique (FP8) et de 5 229,8 TOPS en format INT8. Les résultats publiés sur le GPU Nvidia H100 SXM (80 Go) 700 W ont donné des performances de calcul en virgule flottante, avec dispersion, de 989,4 TFLOPS en crête en format TensorFloat-32 (TF32), de 1 978,9 TFLOPS en crête en demi-précision théorique (FP16), de 1 978,9 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 3 957,8 TFLOPS en crête en précision 8 bits théorique (FP8) et de 3,957,8 TOPS en crête de format INT8 théorique. Source Nvidia H100 : https://resources.nvidia.com/en-us-tensor-core. MI300-17

- Les mesures réalisées par AMD Performance Labs au 11 novembre 2023 sur le GPU AMD Instinct™ MI300X (750 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de calcul en virgule flottante de 163,4 TFLOPS en crête en matrice double précision théorique (matrice FP64), de 81,7 TFLOPS en crête en double précision théorique (FP64), de 163,4 TFLOPS en crête en matrice simple précision théorique (matrice FP32), de 163,4 TFLOPS en crête en simple précision théorique (FP32), de 653,7 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 1 307,4 TFLOPS en crête en demi-précision théorique (FP16), de 1 307,4 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 2 614,9 TFLOPS en crête en précision 8 bits théorique (FP8) et de 2 614,9 TOPS en format INT8. Les résultats publiés sur le GPU Nvidia H100 SXM (80 Go) ont donné des performances de calcul en virgule flottante de 66,9 TFLOPS en crête en format Tensor en double précision théorique (Tensor FP64), de 33,5 TFLOPS en crête en double précision théorique (FP64), de 66,9 TFLOPS en crête en simple précision théorique (FP32), de 494,7 TFLOPS en crête en format TensorFloat-32 (TF32)*, de 989,4 TFLOPS en crête en format Tensor en demi-précision théorique (Tensor FP16), de 133,8 TFLOPS en crête en demi-précision théorique (FP16), de 989,4 TFLOPS en crête en précision de format Tensor Bfloat16 théorique (Tensor BF16), de 133,8 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 1 978,9 TFLOPS en crête en précision 8 bits théorique (FP8) et de 1 978,9 TOPS en crête de format INT8 théorique. Source Nvidia H100 : https://resources.nvidia.com/en-us-tensor-core/ * Les GPU Nvidia H100 ne prennent pas en charge Tensor FP32. MI300-18

- Les calculs réalisés par AMD Performance Labs au 17 novembre 2023 pour l'accélérateur OAM AMD Instinct™ MI300X 750 W (HBM3 de 192 Go) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm ont indiqué une capacité de mémoire HBM3 de 192 Go et des performances de bande passante mémoire de crête théorique de 5,325 TFLOPS. L'interface bus mémoire MI300X est de 8 192 bits et la vitesse de données de la mémoire est de 5,2 Gbit/s pour une bande passante mémoire de crête totale de 5,325 To/s (interface de bus mémoire de 8 192 bits * vitesse de données de mémoire de 5,2 Gbit/s/8). Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Hopper H200 (141 Go) SXM ont indiqué une capacité de mémoire HBM3e de 141 Go et des performances de bande passante mémoire du GPU de 4,8 To/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Hopper H100 (80 Go) SXM5 ont indiqué une capacité de mémoire HBM3 de 80 Go et des performances de bande passante mémoire du GPU de 3,35 To/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A

- Les mesures réalisées par AMD Performance Labs au 18 novembre 2023 sur le GPU AMD Instinct™ MI300X (HBM3 de 192 Go) 750 W conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de 1 307,4 TFLOPS en crête en demi-précision théorique (FP16) et de 1 307,4 TFLOPS en crête en précision de format Bfloat16 théorique (BF16). Profitant d'une dispersion structurelle précise, l'efficacité mathématique du MI300X est estimée 2 fois supérieure, donnant ainsi des performances de calcul en virgule flottante avec dispersion de 2 614,9 TFLOPS en crête en demi-précision théorique (FP16) et de 2 614,9 TFLOPS en crête en précision de format Bfloat16 théorique (BF16). Les résultats publiés sur le GPU Nvidia H100 SXM (HBM3 de 80 Go) 700 W ont indiqué des performances de calcul en virgule flottante, avec dispersion, de 1 978,9 TFLOPS en crête en demi-précision théorique (FP16) et de 1 978,9 TFLOPS en crête en précision de format Bfloat16 théorique (BF16). Source Nvidia H100 : https://resources.nvidia.com/en-us-tensor-core/ Les accélérateurs AMD Instinct™ MI300X, basés sur la technologie AMD CDNA 3, incluent jusqu'à huit liaisons AMD Infinity Fabric, fournissant jusqu'à 1 024 Go/s de bande passante GPU peer-to-peer (P2P) de données de transport théorique de crête au total par module GPU OAM. MI300-25

- Les mesures réalisées par AMD Performance Labs au 11 novembre 2023 sur l'APU AMD Instinct™ MI300A (760 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz en crête ont donné des performances de calcul en virgule flottante de 122,6 TFLOPS en crête en double précision théorique (matrice FP64), de 61,3 TFLOPS en crête en double précision théorique (FP64), de 122,6 TFLOPS en crête en matrice simple précision théorique (matrice FP32), de 122,6 TFLOPS en crête en simple précision théorique (FP32), de 490,3 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 980,6 TFLOPS en crête en demi-précision théorique (FP16), de 980,6 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 1961,2 TFLOPS en crête en précision 8 bits théorique (FP8) et de 1961,2 TOPS en format INT8. Les résultats calculés pour l'accélérateur OAM AMD Instinct™ MI250X (560 W) HBM2e de 128 Go, conçu avec la technologie de processus AMD CDNA™ 2 FinFET 5 nm, à une fréquence du processeur boostée maximale de 1 700 MHz, ont donné des performances de calcul en virgule flottante de 95,7 TFLOPS en crête en double précision théorique (matrice FP64), de 47,9 TFLOPS en crête en double précision théorique (FP64), de 95,7 TFLOPS en crête en matrice simple précision théorique (matrice FP32), de 47,9 TFLOPS en crête en simple précision théorique (FP32), TF32* (N/A), de 383 TFLOPS en crête en demi-précision théorique (FP16), de 383 TFLOPS en crête en précision de format Bfloat16 (BF16), FP8* (N/A) et de 383 TOPS en format INT8. Les fabricants de serveurs peuvent faire évoluer les offres de configuration, ce qui aboutirait à des résultats différents. * Les GPU Série MI200 ne prennent pas en charge les formats TF32 et FP8, ainsi que la dispersion. MI300-10

- Les mesures réalisées par AMD Performance Labs au 11 novembre 2023 sur le APU AMD Instinct™ MI300A (750 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de calcul en virgule flottante de 490,29 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 980,58 TFLOPS en crête en demi-précision théorique (FP16), de 980,58 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 1 961,16 TFLOPS en crête en précision 8 bits théorique (FP8) et de 1 961,16 TOPS en format INT8. Profitant d'une dispersion structurelle précise, l'efficacité mathématique du MI300A est estimée 2 fois supérieure, donnant ainsi des performances de calcul en virgule flottante avec dispersion de 980,58 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 1 961,16 TFLOPS en crête en demi-précision théorique (FP16), de 1 961,16 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 3 922,33 TFLOPS en crête en précision 8 bits théorique (FP8) et de 3 922,33 TOPS en format INT8. Les résultats publiés sur le GPU Nvidia H100 SXM5 (80 Go) ont donné des performances de calcul en virgule flottante, avec dispersion, de 989,4 TFLOPS en crête en format TensorFloat-32 (TF32, cœur Tensor), de 1 978,9 TFLOPS en crête en demi-précision théorique (FP16, cœur Tensor), de 1 978,9 TFLOPS en crête en précision de format Bfloat16 théorique (BF16, cœur Tensor), de 3 957,8 TFLOPS en crête en précision 8 bits théorique (FP8, cœur Tensor) et de 3 957,8 TOPS en crête de format INT8 théorique (cœur Tensor). Source Nvidia H100 : https://resources.nvidia.com/en-us-tensor-core/ Les fabricants de serveurs peuvent faire évoluer les offres de configuration, ce qui aboutirait à des résultats différents. MI300-21

- Les mesures réalisées par AMD Performance Labs au 11 novembre 2023 sur le GPU AMD Instinct™ MI300A (760 W) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm | 6 nm à une fréquence du processeur boostée maximale de 2 100 MHz ont donné des performances de calcul en virgule flottante de 122,6 TFLOPS en crête en matrice double précision théorique (matrice FP64), de 61,3 TFLOPS en crête en double précision théorique (FP64), de 122,6 TFLOPS en crête en matrice simple précision théorique (matrice FP32), de 122,6 TFLOPS en crête en simple précision théorique (FP32), de 490,29 TFLOPS en crête en format TensorFloat-32 théorique (TF32), de 980,58 TFLOPS en crête en demi-précision théorique (FP16), de 980,58 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 1 961,16 TFLOPS en crête en précision 8 bits théorique (FP8) et de 1 961,16 TOPS en format INT8. Les résultats publiés sur le GPU Nvidia H100 SXM (80 Go) 700 W ont donné des performances de calcul en virgule flottante de 66,9 TFLOPS en crête en format Tensor en double précision théorique (Tensor FP64), de 33,5 TFLOPS en crête en double précision théorique (FP64), de 66,9 TFLOPS en crête en simple précision théorique (FP32), de 494,7 TFLOPS en crête en format TensorFloat-32 (TF32)*, de 989,4 TFLOPS en crête en format Tensor en demi-précision théorique (Tensor FP16), de 133,8 TFLOPS en crête en demi-précision théorique (FP16), de 989,4 TFLOPS en crête en précision de format Tensor Bfloat16 théorique (Tensor BF16), de 133,8 TFLOPS en crête en précision de format Bfloat16 théorique (BF16), de 1 978,9 TFLOPS en crête en précision 8 bits théorique (FP8) et de 1 978,9 TOPS en crête de format INT8 théorique. Source Nvidia H100 : https://resources.nvidia.com/en-us-tensor-core/ Les fabricants de serveurs peuvent faire évoluer les offres de configuration, ce qui aboutirait à des résultats différents. * Les GPU Nvidia H100 ne prennent pas en charge Tensor FP32. MI300-20

- Les calculs réalisés par AMD Performance Labs au 7 novembre 2023 pour l'accélérateur APU AMD Instinct™ MI300A 760 W (HBM3 de 128 Go) conçu avec la technologie de processus AMD CDNA™ 3 FinFET 5 nm ont indiqué une capacité de mémoire HBM3 de 128 Go et des performances de bande passante mémoire de crête théorique de 5,325 TFLOPS. L'interface bus mémoire MI300A est de 8 192 bits (1 024 bits x 8 dies) et la vitesse de données de la mémoire est de 5,2 Gbit/s pour une bande passante mémoire de crête totale de 5,325 To/s (interface de bus mémoire de 8 192 bits * vitesse de données de mémoire de 5,2 Gbit/s/8). Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Hopper H200 (141 Go) SXM ont indiqué une capacité de mémoire HBM3e de 141 Go et des performances de bande passante mémoire du GPU de 4,8 To/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Les résultats publiés les plus élevés sur l'accélérateur de GPU Nvidia Hopper H100 (80 Go) SXM ont indiqué une capacité de mémoire HBM3 de 80 Go et des performances de bande passante mémoire du GPU de 3,35 To/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet Les fabricants de serveurs peuvent faire évoluer les offres de configuration, ce qui aboutirait à des résultats différents. MI300-12