Potenciación de IA y HPC

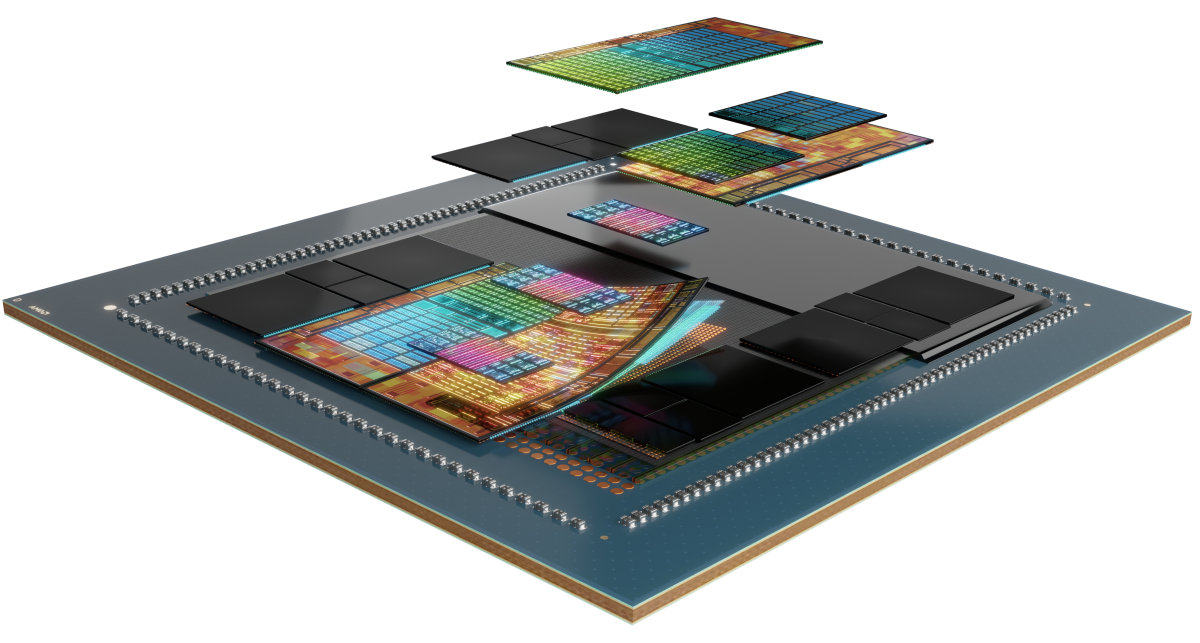

Los aceleradores AMD Instinct™ Serie MI300 se adaptan a la potencia de una manera única, incluso a las cargas de trabajo más exigentes de IA y HPC, a fin de ofrecer un rendimiento de procesamiento excepcional, una gran densidad de memoria con alto ancho de banda y compatibilidad con formatos de datos especializados.

En segundo plano

Los aceleradores AMD Instinct Serie MI300 están desarrollados con la arquitectura AMD CDNA™ 3, que ofrece tecnologías Matrix Core y compatibilidad para una amplia gama de capacidades de precisión, desde INT8 y FP8 (incluida la compatibilidad de sparsity para la IA) con alta eficiencia hasta el FP64 más exigente para HPC.

Conoce la Serie

Descubre los aceleradores AMD Instinct Serie MI300, las plataformas AMD Instinct Serie MI300 y la APU AMD Instinct MI300A.

Conoce los aceleradores AMD Instinct™ MI325X

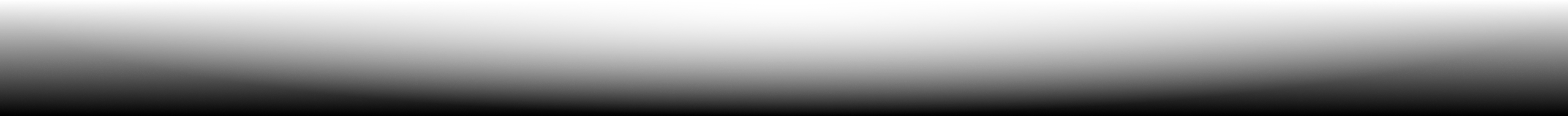

El acelerador de GPU AMD Instinct™ MI325X establece nuevos estándares en el rendimiento de la IA con la arquitectura AMD CDNA™ de 3.ª generación, que ofrece un rendimiento y eficiencia increíbles para el entrenamiento y la inferencia. Con una memoria HBM3E de 256 GB líder en la industria y un ancho de banda de hasta 6 TB/s, optimizan el rendimiento y ayudan a reducir el TCO.1

304 UP

304 unidades de procesamiento de GPU

256 GB

Memoria HBM3E de 256 GB

6 TB/s

Ancho de banda de memoria teórico máximo de 6 TB/s

Comparaciones de especificaciones

- Rendimiento de AI

- Rendimiento HPC

- Memoria

Rendimiento AI (TFLOPS máximos)

Hasta 1,3 veces el rendimiento de la IA frente a los aceleradores de la competencia2, 3

H200 SXM 141 GB

MI325X OAM 256 GB

Rendimiento HPC (TFLOPS máximos)

Hasta 2,4 veces de rendimiento HPC frente a los aceleradores de la competencia3

H200 SXM 141 GB

MI325X OAM 256 GB

Capacidad de memoria y ancho de banda

Capacidad de memoria 1,8 veces superior y ancho de banda de memoria 1,2 veces superior frente a los aceleradores de la competencia1

H200 SXM 141 GB

MI325X OAM 256 GB

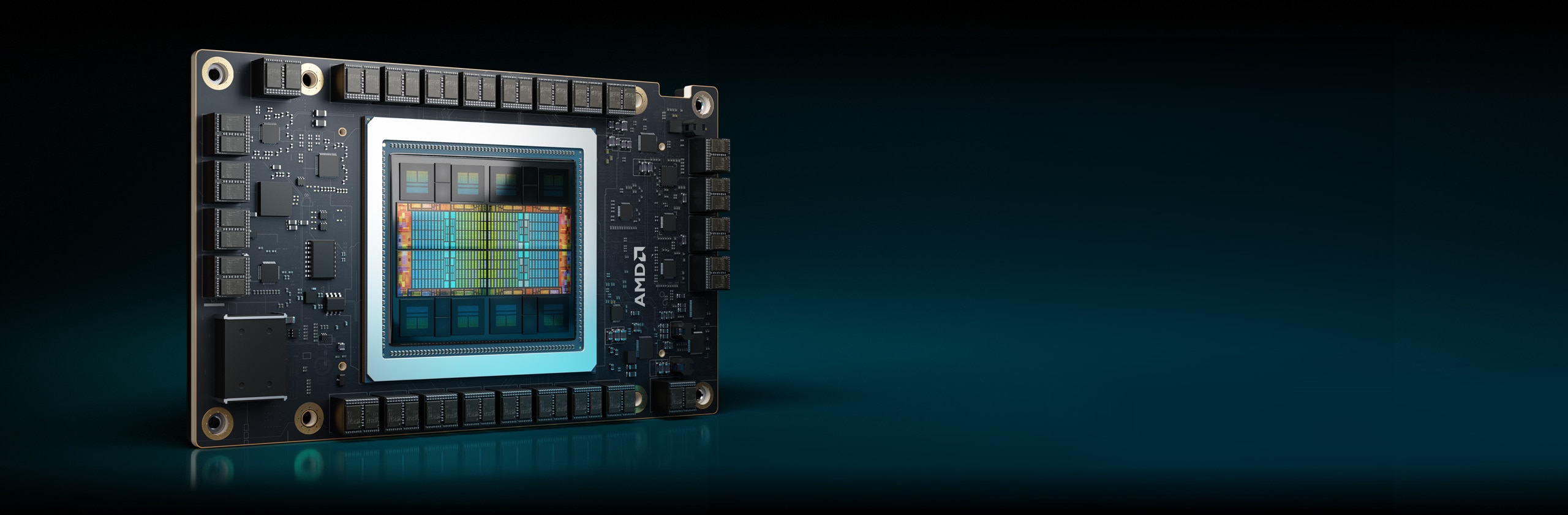

Aceleradores Instinct MI300X

Los aceleradores AMD Instinct Serie MI300X están diseñados a fin de ofrecer un rendimiento líder para las cargas de trabajo generativas de IA y las aplicaciones de HPC.

304 UP

304 unidades de procesamiento de GPU

192 GB

Memoria HBM3 de 192 GB

5,3 TB/s

Ancho de banda de memoria teórico máximo de 5,3 TB/s

Rendimiento de IA (TFLOP máximos)

Hasta 1,3 veces el rendimiento de la IA frente a los aceleradores de la competencia6

Rendimiento de HPC (TFLOP máximos)

Hasta 2,4 veces de rendimiento HPC frente a los aceleradores de la competencia7

Capacidad de memoria y ancho de banda

Capacidad de memoria 2,4 veces superior y ancho de banda de memoria teórico máximo 1,6 veces superior frente a los aceleradores de la competencia8

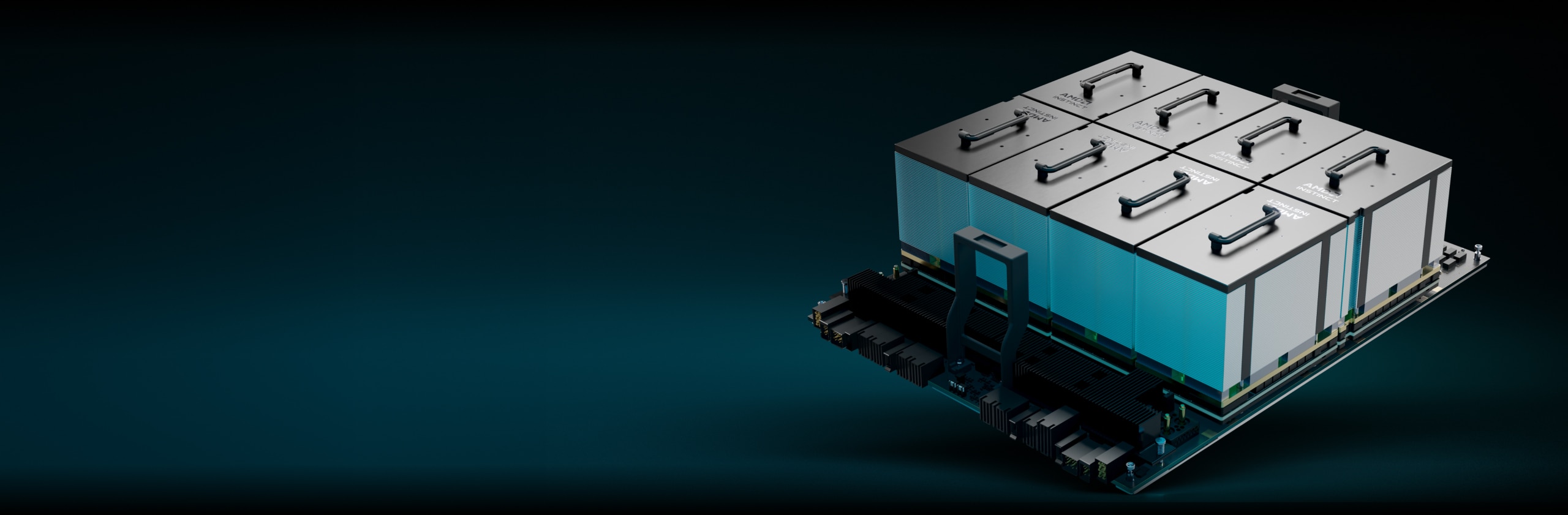

Plataformas AMD Instinct

La plataforma AMD Instinct MI325X integra 8 módulos OAM de GPU MI325X completamente conectados en un diseño OCP estándar de la industria a través de enlaces de 4.ª generación de AMD Infinity Fabric™, lo que proporciona hasta 2 TB de capacidad HBM3E para el procesamiento de IA de baja latencia. Esta plataforma lista para implementar puede acelerar el tiempo de llegada al mercado y reducir los costos de desarrollo cuando se agregan aceleradores MI325X al rack de IA existente y a la infraestructura de servidores.

8 MI325X

8 módulos OAM de GPU MI325X

2 TB

2 TB totales de memoria HBM3E

48 TB/s

Ancho de banda de memoria de agregado teórico máximo de 48 TB/s

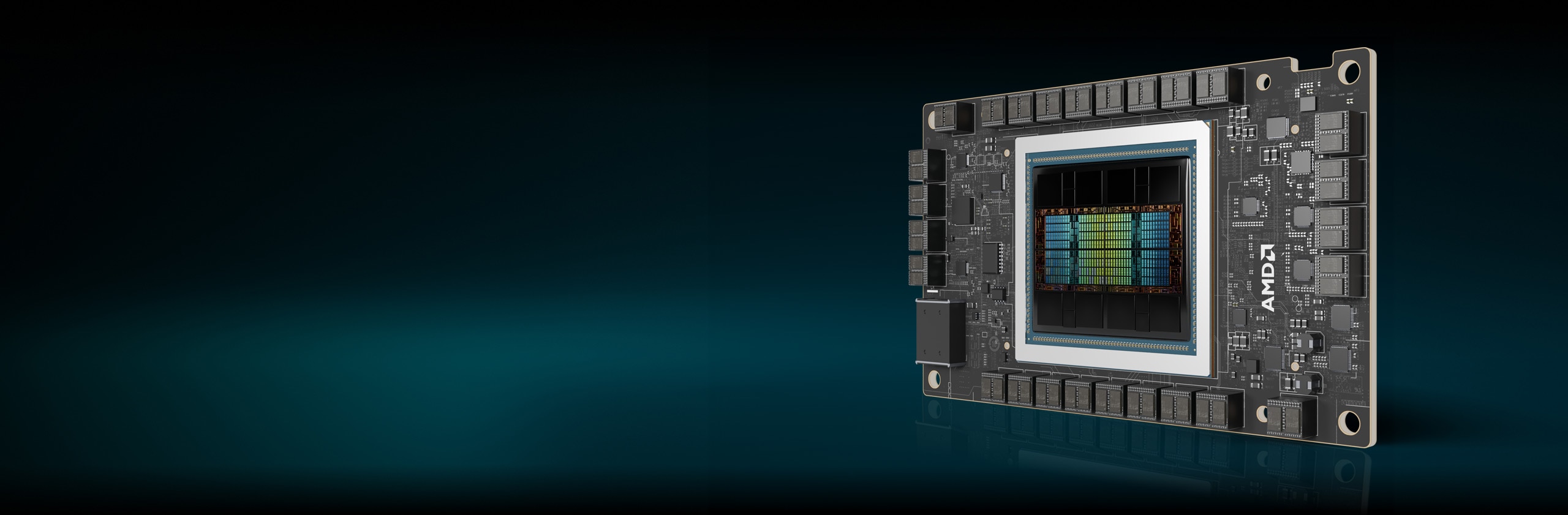

APU AMD Instinct MI300A

Las unidades de procesamiento acelerado (APU) AMD Instinct MI300A combinan la potencia de los aceleradores AMD Instinct y los procesadores AMD EPYC™ con una memoria compartida para permitir una mayor eficiencia, flexibilidad y capacidad de programación. Están diseñadas para acelerar la convergencia de la IA y HPC, lo que ayuda a avanzar en la investigación e impulsar nuevos descubrimientos.

228 UP

228 unidades de procesamiento de GPU

24

24 núcleos de CPU “Zen 4” x 86

128 GB

128 GB de memoria unificada HBM3

5,3 TB/s

Ancho de banda de memoria teórico máximo de 5,3 TB/s

Rendimiento de IA (TFLOPS máximos)11

Rendimiento de HPC (TFLOP máximos)

Hasta 1,8 veces de rendimiento HPC frente a los aceleradores de la competencia12

Capacidad de memoria y ancho de banda

Capacidad de memoria 2,4 veces superior y ancho de banda de memoria teórico máximo 1,6 veces superior frente a los aceleradores de la competencia13

Avanzar en la informática a exaescala

Los aceleradores AMD Instinct potencian algunas de las mejores supercomputadoras del mundo, incluido el sistema El Capitan de Lawrence Livermore National Laboratory. Ve cómo esta supercomputadora de dos exaescalas utilizará la IA para ejecutar simulaciones exclusivas y avanzar en la investigación científica.

Software AMD ROCm™

El software AMD ROCm™ incluye un amplio conjunto de modelos de programación, herramientas, compiladores, bibliotecas y tiempos de ejecución para modelos de IA y cargas de trabajo de HPC dirigidos a aceleradores de AMD Instinct.

Casos de Estudio

Encontrar soluciones

Encuentra un socio que ofrezca soluciones basadas en aceleradores AMD Instinct.

Recursos

Mantente informado

Regístrate para recibir las últimas novedades sobre centros de datos y contenido de servidores

Notas al pie

- MI325-001A: los cálculos realizados por los laboratorios de rendimiento de AMD al 26 de septiembre del 2024, con base en las especificaciones o estimaciones actuales. El acelerador AMD Instinct™ MI325X OAM tendrá una capacidad de memoria HBM3E de 256 GB y un rendimiento teórico máximo del ancho de banda de memoria de GPU de 6 TB/s. Los resultados reales basados en silicio para producción pueden variar.

Los resultados más altos publicados sobre el acelerador GPU NVidia Hopper H200 (141 GB) SXM arrojaron como resultado 141 GB de capacidad de memoria HBM3E y un rendimiento de ancho de banda de memoria de GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Los resultados más altos publicados sobre el acelerador GPU NVidia Blackwell HGX B100 (192 GB) 700 W arrojaron como resultado 192 GB de capacidad de memoria HBM3E y un rendimiento de ancho de banda de memoria de GPU de 8 TB/s.

Los resultados publicados más altos sobre el acelerador de GPU NVidia Blackwell HGX B200 (192 GB) arrojaron como resultado una capacidad de memoria HBM3E de 192 GB y un rendimiento de ancho de banda de memoria de GPU de 8 TB/s.

Especificaciones de NVIDIA Blackwell en https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy

- MI325-002: los cálculos realizados por los laboratorios de rendimiento de AMD al 28 de mayo del 2024 para la GPU AMD Instinct™ MI325X alcanzaron 1307,4 TFLOPS de máximo teórico de precisión media (FP16), 1307,4 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), 2614,9 TFLOPS de máximo teórico de precisión de 8 bits (FP8) y 2614,9 TOPS de rendimiento de punto flotante INT8. El rendimiento real variará según las especificaciones finales y la configuración del sistema.

Resultados publicados sobre la GPU Nvidia H200 SXM (141 GB): 989,4 TFLOPS de máximo teórico de precisión media de tensor (tensor FP16), 989,4 TFLOPS de máximo teórico de precisión de formato de tensor Bfloat16 (tensor BF16), 1978,9 TFLOPS de máximo teórico de precisión de 8 bits (FP8), 1978,9 TOPS de máximo teórico de rendimiento de punto flotante INT8. Nvidia publicó el rendimiento de BFLOAT16 Tensor Core, FP16 Tensor Core, FP8 Tensor Core e INT8 Tensor Core usando escasez; a los efectos de comparación, AMD convirtió estos números a no escasez/densidad dividiéndolos por dos, y estos números aparecen arriba.

Fuente Nvidia H200: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 y https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Nota: Las GPU NVIDIA H200 tienen el mismo rendimiento de FLOPS publicado que los productos H100 https://resources.nvidia.com/en-us-tensor-core/. MI325-02

- MI325-008: los cálculos realizados por los laboratorios de rendimiento de AMD al 2 de octubre del 2024 para la GPU AMD Instinct™ MI325X (1000 W) diseñada con tecnología de proceso FinFET de 5 nm | 6 nm de AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron 163,4 TFLOPS de máximo teórico de precisión doble (matriz FP64), 81,7 TFLOPS de máximo teórico de precisión doble (FP64), 163,4 TFLOPS de máximo teórico de matriz de precisión simple (matriz FP32), 163,4 TFLOPS de máximo teórico de precisión simple (FP32), 653,7 TFLOPS de máximo teórico TensorFloat-32 (TF32), 1307,4 TFLOPS de máximo teórico de media precisión (FP16). El rendimiento real puede variar según las especificaciones finales y la configuración del sistema.

Resultados publicados sobre la GPU Nvidia H200 SXM (141 GB): 66,9 TFLOPS de máximo teórico de precisión doble de tensor (tensor FP64), 33,5 TFLOPS de máximo teórico de precisión doble (FP64), 66,9 TFLOPS de máximo teórico de precisión simple (FP32), 494,7 TFLOPS de máximo teórico de TensorFloat-32 (TF32), 989,5 TFLOPS de máximo teórico de precisión media de tensor (tensor FP16). Nvidia publicó el rendimiento de TF32 Tensor Core usando escasez; a los efectos de comparación, AMD convirtió estos números a no escasez/densidad dividiéndolos por 2, y este número aparece arriba.

Fuente Nvidia H200: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 y https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Nota: Las GPU NVIDIA H200 tienen el mismo rendimiento de FLOPS publicado que los productos H100 https://resources.nvidia.com/en-us-tensor-core/.

* Las GPU Nvidia H200 no admiten Tensor FP32.

- Las mediciones realizadas por los laboratorios de rendimiento de AMD al 11 de noviembre del 2023 en la GPU AMD Instinct™ MI300X (750 W) diseñada con la tecnología de proceso FinFET de 5 nm | 6 nm AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron los 653,7 TFLOPS de precisión máxima teórica de TensorFloat-32 (TF32), 1307,4 TFLOPS de precisión media máxima teórica (FP16), 1307,4 TFLOPS de precisión máxima teórica de formato Bfloat16 (BF16), 2614,9 TFLOPS de precisión máxima teórica de 8 bits (FP8), 2614,9 TOPS INT8 de rendimiento de punto flotante. Se espera que MI300X sea capaz de aprovechar la sparsity de la estructura precisa proporcionando una mejora estimada del doble de la eficiencia matemática, lo que da como resultado 1307,4 TFLOP de precisión máxima teórica TensorFloat-32 (TF32), 2614,9 TFLOP de precisión media máxima teórica (FP16), 2614,9 TFLOP de precisión máxima teórica de formato Bfloat16 (BF16), 5229,8 TFLOP de precisión máxima teórica de 8 bits (FP8), 5229,8 TOP INT8 de rendimiento de punto flotante con sparsity. Los resultados calculados para el acelerador AMD Instinct™ MI250X (560 W) HBM2e OAM de 128 GB diseñado con la tecnología de proceso FinFet de 5 nm de AMD CDNA™ 2 a una frecuencia de reloj de motor con impulso máximo de 1700 MHz dieron como resultado TF32* (N/D), 383,0 TFLOPS de máximo teórico de precisión media (FP16), 383,0 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), FP8* (N/D), 383,0 TOPS de rendimiento de punto flotante INT8. * Las GPU AMD Instinct Serie MI200 no admiten TF32, FP8 ni sparsity. MI300-16

- Mediciones realizadas por los laboratorios de rendimiento internos de AMD el 2 de junio del 2023 sobre las especificaciones actuales o los cálculos de ingeniería interna. Gran modelo de lenguaje (LLM, Large Language Model) ejecutado o calculado con precisión FP16 para determinar la cantidad mínima de GPU necesarias para ejecutar los modelos Falcon-7B (parámetros 7B, 40B), LLaMA (parámetros 13B, 33B), OPT (parámetros 66B), GPT-3 (parámetros 175B), BLOOM (parámetro 176B) y Palm (parámetros 340B, 540B). Estimaciones calculadas con base en el tamaño de la memoria únicamente de GPU en comparación con la memoria requerida por el modelo en parámetros definidos más un 10 % de sobrecarga. Los cálculos dependen de los tamaños de memoria del modelo publicado y, a veces, preliminar. Los resultados de GPT-3, BLOOM y PaML se estimaron en MI300X debido a la disponibilidad del sistema o de las piezas. Configuraciones de resultados probadas: Sistema del laboratorio de AMD que consta de 1 CPU EPYC 9654 (96 núcleos) con 1 acelerador AMD Instinct™ MI300X (192 GB HBM3, módulo OAM) de 750 W

Resultados (precisión de FP16):

Modelo

Parámetros

Memoria total requerida

MI300X requerido

Falcon-7B

7000 millones

15.4 GB

1 real

LLaMA

13 mil millones

44 GB

1 real

LLaMA

33 mil millones

72.5 GB

1 real

Falcon-40B

40 mil millones

88 GB

1 real

OPT

66 mil millones

145.2 GB

1 real

GPT-3

175 mil millones

385 GB

3 calculado

Bloom

176 mil millones

387.2 GB

3 calculado

PaLM

340 mil millones

748 GB

4 calculado

PaLM

540 mil millones

1188 GB

7 calculado

Las estimaciones calculadas pueden variar según el tamaño del modelo final; las estimaciones y los valores reales pueden variar debido a los gastos generales reales requeridos y al uso de la memoria del sistema más allá de la GPU. Los fabricantes de servidores pueden variar las ofertas de configuración, lo que arroja resultados diferentes. MI300-07

- Las mediciones realizadas por los laboratorios de rendimiento de AMD al 11 de noviembre del 2023 en la GPU AMD Instinct™ MI300X (750 W) diseñada con la tecnología de proceso FinFET de 5 nm | 6 nm AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron los 653,7 TFLOPS de precisión máxima teórica de TensorFloat-32 (TF32), 1307,4 TFLOPS de precisión media máxima teórica (FP16), 1307,4 TFLOPS de precisión máxima teórica de formato Bfloat16 (BF16), 2614,9 TFLOPS de precisión máxima teórica de 8 bits (FP8), 2614,9 TOPS INT8 de rendimiento de punto flotante. Se espera que MI300X sea capaz de aprovechar la sparsity de la estructura precisa proporcionando una mejora estimada del doble de la eficiencia matemática, lo que da como resultado 1307,4 TFLOP de precisión máxima teórica TensorFloat-32 (TF32), 2614,9 TFLOP de precisión media máxima teórica (FP16), 2614,9 TFLOP de precisión máxima teórica de formato Bfloat16 (BF16), 5229,8 TFLOP de precisión máxima teórica de 8 bits (FP8), 5229,8 TOP INT8 de rendimiento de punto flotante con sparsity. Los resultados publicados de la GPU Nvidia H100 SXM (80 GB) de 700 W dieron como resultado 989,4 TFLOPS máxima TensorFloat-32 (TF32) con sparsity, 1978,9 TFLOPS de precisión media teórica máxima (FP16) con sparsity, 1978,9 TFLOPS de precisión de formato Bfloat16 máxima teórica (BF16) con sparsity, 3957,8 TFLOPS de precisión de 8 bits máxima teórica (FP8) con sparsity, 3957,8 TOPS de rendimiento de punto flotante INT8 con sparsity máxima teórica. Fuente NVIDIA H100: https://resources.nvidia.com/en-us-tensor-core. MI300-17

- Las mediciones realizadas en los laboratorios de rendimiento de AMD al 11 de noviembre del 2023 en la GPU AMD Instinct™ MI300X (750 W) diseñada con la tecnología de proceso FinFet de 5 nm | 6 nm de AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron los 163,4 TFLOPS de máximo teórico de matriz de precisión doble (Matriz FP64), 81,7 TFLOPS de máximo teórico de precisión doble (FP64), 163,4 TFLOPS de máximo teórico de matriz de precisión simple (Matriz FP32), 163,4 TFLOPS de máximo teórico de precisión simple (FP32), 653,7 TFLOPS de máximo teórico de precisión con TensorFloat-32 (TF32), 1307,4 TFLOPS de máximo teórico de precisión media (FP16), 1307,4 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), 2614,9 TFLOPS de máximo teórico de precisión de 8 bits (FP8), 2614,9 TOPS de rendimiento de punto flotante INT8. Los resultados publicados de la GPU Nvidia H100 SXM (80 GB) dieron como resultado 66,9 TFLOPS de máximo teórico de tensor de precisión doble (Tensor FP64), 33,5 TFLOPS de máximo teórico de precisión doble (FP64), 66,9 TFLOPS de máximo teórico de precisión simple (FP32), 494,7 TFLOPS de precisión máxima con TensorFloat-32 (TF32)*, 989,4 TFLOPS de máximo teórico de tensor de precisión media (Tensor FP16), 133,8 TFLOPS de máximo teórico de precisión media (FP16), 989,4 TFLOPS de máximo teórico de precisión de formato Bfloat16 (Tensor BF16), 133,8 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), 1978,9 TFLOPS de máximo teórico de precisión de 8 bits (FP8), 1978,9 TOPS de máximo teórico de rendimiento de punto flotante INT8. Fuente Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ * Las GPU Nvidia H100 no admiten Tensor FP32. MI300-18

- Las mediciones realizadas en los laboratorios de rendimiento de AMD el 17 de noviembre del 2023 en el acelerador AMD Instinct™ MI300X OAM de 750 W (192 GB de memoria HBM3) diseñado con la tecnología de proceso FinFet de 5 nm de AMD CDNA™ 3 arrojaron como resultado 192 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria máximo teórico de 5,325 TFLOPS. La interfaz de bus de memoria MI300X es de 8192 y la velocidad de datos de memoria es de 5,2 Gbps para el ancho de banda de memoria máximo total de 5,325 TB/s (interfaz de bus de memoria de 8192 bits * 5,2 Gbps de velocidad de datos de memoria/8). Los resultados más altos publicados sobre el acelerador de GPU NVIDIA Hopper H200 (141 GB) SXM arrojaron como resultado 141 GB de capacidad de memoria HBM3e y un rendimiento de ancho de banda de memoria de GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Los resultados más altos publicados sobre el acelerador de GPU NVIDIA Hopper H100 (80 GB) SXM5 arrojaron como resultado 80 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria de GPU de 3,35 TB/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A

- Las mediciones realizadas en los laboratorios de rendimiento de AMD al 18 de noviembre del 2023 en la GPU AMD Instinct™ MI300X (192 GB de memoria HBM3) de 750 W diseñada con la tecnología de proceso FinFet de 5 nm | 6 nm de AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron los 1307,4 TFLOPS de máximo teórico de precisión media (FP16), 1307,4 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16). Se espera que MI300X sea capaz de aprovechar la sparcity de la estructura precisa proporcionando una mejora estimada del doble de la eficiencia matemática, lo que da como resultado 2614,9 TFLOP de precisión media máxima teórica (FP16), 2614,9 TFLOP de precisión máxima teórica de formato Bfloat16 (BF16, rendimiento de punto flotante con sparsity). Los resultados publicados de la GPU Nvidia H100 SXM (80 GB de memoria HBM3) de 700 W arrojaron 1978,9 TFLOPS de máximo teórico de precisión media (FP16) con sparsity, 1978,9 TFLOPS de máximo teórico de rendimiento de punto flotante de precisión de formato Bfloat16 (BF16) con sparsity. Fuente Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ Los aceleradores AMD Instinct™ MI300X, diseñados con la tecnología AMD CDNA 3, incluyen hasta ocho puertos AMD Infinity Fabric, con lo cual el rendimiento máximo teórico de ancho de banda agregado para transferencia de datos entre tarjetas o pares (P2P) alcanza los 1,024 GB/s por GPU OAM. MI300-25

- Las mediciones realizadas en los laboratorios de rendimiento de AMD al 11 de noviembre del 2023 en la APU AMD Instinct™ MI300A (760 W) diseñada con la tecnología de proceso FinFet de 5 nm | 6nm de AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz arrojaron como resultado 122,6 TFLOPS de máximo teórico de precisión doble (Matriz FP64), 61,3 TFLOPS de máximo teórico de precisión doble (FP64), 122,6 TFLOPS de máximo teórico de matriz de precisión simple (Matriz FP32), 122,6 TFLOPS de máximo teórico de precisión simple (FP32), 490,3 TFLOPS de máximo teórico de precisión TensorFloat-32 (TF32), 980,6 TFLOPS de máximo teórico de precisión media (FP16), 980,6 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), 1961,2 TFLOPS de máximo teórico de precisión de 8 bits (FP8), 1961,2 TOPS de rendimiento de punto flotante INT8. Los resultados calculados para el acelerador AMD Instinct™ MI250X (560W) 128 GB HBM2e diseñado con la tecnología de proceso FinFeT de 5 nm AMD CDNA™ 2 a una frecuencia de reloj de motor con impulso máximo de 1700 MHz alcanzaron 95,7 TFLOPS de máximo teórico de precisión doble (matriz FP64); 47,9 TFLOPS de máximo teórico de precisión doble (FP64); 95,7 TFLOPS de máximo teórico de matriz de precisión simple (matriz FP32); 47,9 TFLOPS de máximo teórico de precisión simple (FP32); TF32* (N/A), 383,0 TFLOPS de máximo teórico de precisión media (FP16) y 383,0 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), FP8* (N/D), 383,0 TOPS de rendimiento de punto flotante INT8. Los fabricantes de servidores pueden variar las ofertas de configuración, lo que arroja resultados diferentes. * Las GPU de la Serie MI200 no admiten TF32, FP8 ni sparsity. MI300-10

- Las mediciones realizadas por los laboratorios de rendimiento de AMD el 11 de noviembre del 2023 en la APU AMD Instinct™ MI300A (750 W) diseñada con la tecnología de proceso FinFet de 5 nm | 6 nm AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron los 490,29 TFLOP de precisión máxima teórica de TensorFloat-32 (TF32), 980,58 TFLOP de precisión media máxima teórica (FP16), 980,58 TFLOP de precisión máxima teórica de formato Bfloat16 (BF 16), 1961,16 TFLOP de precisión máxima teórica de 8 bits (FP8), 1961,16 TOP INT8 de rendimiento de punto flotante. Se espera que MI300A sea capaz de aprovechar la sparsity de la estructura precisa proporcionando una mejora estimada del doble de la eficiencia matemática, lo que da como resultado 980,58 TFLOP de precisión máxima teórica TensorFloat-32 (TF32), 1961,16 TFLOP de precisión media máxima teórica (FP16), 1961,16 TFLOP de precisión máxima teórica de formato Bfloat16 (BF16), 3922,33 TFLOP de precisión máxima teórica de 8 bits (FP8), 3922,33 TOP INT8 de rendimiento de punto flotante con sparsity. Los resultados publicados de la GPU Nvidia H100 SXM5 (80 GB) dieron como resultado 989,4 TFLOPS de máximo de TensorFloat-32 (TF32) de núcleo Tensor con sparsity, 1978,9 TFLOPS de máximo teórico de precisión media (FP16) de núcleo Tensor con sparsity, 1978,9 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16) de núcleo Tensor con sparsity, 3957,8 TFLOPS de máximo teórico de precisión de 8 bits (FP8) de núcleo Tensor con sparsity, 3957,8 TOPS de máximo teórico de rendimiento de punto flotante INT8 de núcleo Tensor con sparsity. Fuente de Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ Los fabricantes de servidores pueden variar las ofertas de configuración, lo que arroja resultados diferentes. MI300-21

- Las mediciones realizadas en los laboratorios de rendimiento de AMD al 11 de noviembre del 2023 en la GPU AMD Instinct™ MI300A (760 W) diseñada con la tecnología de proceso FinFet de 5 nm | 6 nm de AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron los 122,6 TFLOPS de máximo teórico de matriz de precisión doble (Matriz FP64), 61,3 TFLOPS de máximo teórico de precisión doble (FP64), 122,6 TFLOPS de máximo teórico de matriz de precisión simple (Matriz FP32), 122,6 TFLOPS de máximo teórico de precisión simple (FP32), 490,29 TFLOPS de máximo teórico de precisión con TensorFloat-32 (TF32), 980,58 TFLOPS de máximo teórico de precisión media (FP16), 980,58 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), 1961,16 TFLOPS de máximo teórico de precisión de 8 bits (FP8), 1961,16 TOPS de rendimiento de punto flotante INT8. Los resultados publicados de la GPU Nvidia H100 SXM (80 GB) de 700 W dieron como resultado 66,9 TFLOPS de máximo teórico de tensor de precisión doble (Tensor FP64), 33,5 TFLOPS de máximo teórico de precisión doble (FP64), 66,9 TFLOPS de máximo teórico de precisión simple (FP32), 494,7 TFLOPS de precisión máxima con TensorFloat-32 (TF32)*, 989,4 TFLOPS de máximo teórico de tensor de precisión media (Tensor FP16), 133,8 TFLOPS de máximo teórico de precisión media (FP16), 989,4 TFLOPS de máximo teórico de precisión de tensor de formato Bfloat16 (Tensor BF16), 133,8 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), 1978,9 TFLOPS de máximo teórico de precisión de 8 bits (FP8), 1978,9 TOPS de máximo teórico de rendimiento de punto flotante INT8. Fuente de Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ Los fabricantes de servidores pueden variar las ofertas de configuración, lo que arroja resultados diferentes. * Las GPU Nvidia H100 no admiten Tensor FP32. MI300-20

- Las mediciones realizadas en los laboratorios de rendimiento de AMD al 7 de noviembre del 2023 en el acelerador de APU AMD Instinct™ MI300A de 760 W (128 GB de memoria HBM3) diseñado con la tecnología de proceso FinFet de 5 nm de AMD CDNA™ 3 arrojaron como resultado 128 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria máximo teórico de 5,325 TFLOPS. La interfaz de bus de memoria MI300A es de 8,192 (chip de 1024 x 8 bits) y la velocidad de datos de memoria es de 5,2 Gbps para el ancho de banda de memoria máximo total de 5325 TB/s (interfaz de bus de memoria de 8,192 bits * 5,2 Gbps de velocidad de datos de memoria/8). Los resultados más altos publicados acerca del acelerador de GPU NVIDIA Hopper H200 (141 GB) SXM arrojaron como resultado 141 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria de GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Los resultados más altos publicados acerca del acelerador de GPU NVIDIA Hopper H100 (80 GB) SXM arrojaron como resultado 80 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria de GPU de 3,35 TB/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet Los fabricantes de servidores pueden variar las ofertas de configuración, lo que arroja resultados diferentes. MI300-12

- MI325-001A: los cálculos realizados por los laboratorios de rendimiento de AMD al 26 de septiembre del 2024, con base en las especificaciones o estimaciones actuales. El acelerador AMD Instinct™ MI325X OAM tendrá una capacidad de memoria HBM3E de 256 GB y un rendimiento teórico máximo del ancho de banda de memoria de GPU de 6 TB/s. Los resultados reales basados en silicio para producción pueden variar.

Los resultados más altos publicados sobre el acelerador GPU NVidia Hopper H200 (141 GB) SXM arrojaron como resultado 141 GB de capacidad de memoria HBM3E y un rendimiento de ancho de banda de memoria de GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Los resultados más altos publicados sobre el acelerador GPU NVidia Blackwell HGX B100 (192 GB) 700 W arrojaron como resultado 192 GB de capacidad de memoria HBM3E y un rendimiento de ancho de banda de memoria de GPU de 8 TB/s.

Los resultados publicados más altos sobre el acelerador de GPU NVidia Blackwell HGX B200 (192 GB) arrojaron como resultado una capacidad de memoria HBM3E de 192 GB y un rendimiento de ancho de banda de memoria de GPU de 8 TB/s.

Especificaciones de NVIDIA Blackwell en https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy - MI325-002: los cálculos realizados por los laboratorios de rendimiento de AMD al 28 de mayo del 2024 para la GPU AMD Instinct™ MI325X alcanzaron 1307,4 TFLOPS de máximo teórico de precisión media (FP16), 1307,4 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), 2614,9 TFLOPS de máximo teórico de precisión de 8 bits (FP8) y 2614,9 TOPS de rendimiento de punto flotante INT8. El rendimiento real variará según las especificaciones finales y la configuración del sistema.

Resultados publicados sobre la GPU Nvidia H200 SXM (141 GB): 989,4 TFLOPS de máximo teórico de precisión media de tensor (tensor FP16), 989,4 TFLOPS de máximo teórico de precisión de formato de tensor Bfloat16 (tensor BF16), 1978,9 TFLOPS de máximo teórico de precisión de 8 bits (FP8), 1978,9 TOPS de máximo teórico de rendimiento de punto flotante INT8. Nvidia publicó el rendimiento de BFLOAT16 Tensor Core, FP16 Tensor Core, FP8 Tensor Core e INT8 Tensor Core usando escasez; a los efectos de comparación, AMD convirtió estos números a no escasez/densidad dividiéndolos por dos, y estos números aparecen arriba.

Fuente Nvidia H200: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 y https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Nota: Las GPU NVIDIA H200 tienen el mismo rendimiento de FLOPS publicado que los productos H100 https://resources.nvidia.com/en-us-tensor-core/. MI325-02 - MI325-008: los cálculos realizados por los laboratorios de rendimiento de AMD al 2 de octubre del 2024 para la GPU AMD Instinct™ MI325X (1000 W) diseñada con tecnología de proceso FinFET de 5 nm | 6 nm de AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron 163,4 TFLOPS de máximo teórico de precisión doble (matriz FP64), 81,7 TFLOPS de máximo teórico de precisión doble (FP64), 163,4 TFLOPS de máximo teórico de matriz de precisión simple (matriz FP32), 163,4 TFLOPS de máximo teórico de precisión simple (FP32), 653,7 TFLOPS de máximo teórico TensorFloat-32 (TF32), 1307,4 TFLOPS de máximo teórico de media precisión (FP16). El rendimiento real puede variar según las especificaciones finales y la configuración del sistema.

Resultados publicados sobre la GPU Nvidia H200 SXM (141 GB): 66,9 TFLOPS de máximo teórico de precisión doble de tensor (tensor FP64), 33,5 TFLOPS de máximo teórico de precisión doble (FP64), 66,9 TFLOPS de máximo teórico de precisión simple (FP32), 494,7 TFLOPS de máximo teórico de TensorFloat-32 (TF32), 989,5 TFLOPS de máximo teórico de precisión media de tensor (tensor FP16). Nvidia publicó el rendimiento de TF32 Tensor Core usando escasez; a los efectos de comparación, AMD convirtió estos números a no escasez/densidad dividiéndolos por 2, y este número aparece arriba.

Fuente Nvidia H200: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 y https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Nota: Las GPU NVIDIA H200 tienen el mismo rendimiento de FLOPS publicado que los productos H100 https://resources.nvidia.com/en-us-tensor-core/.

* Las GPU Nvidia H200 no admiten Tensor FP32. - Las mediciones realizadas por los laboratorios de rendimiento de AMD al 11 de noviembre del 2023 en la GPU AMD Instinct™ MI300X (750 W) diseñada con la tecnología de proceso FinFET de 5 nm | 6 nm AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron los 653,7 TFLOPS de precisión máxima teórica de TensorFloat-32 (TF32), 1307,4 TFLOPS de precisión media máxima teórica (FP16), 1307,4 TFLOPS de precisión máxima teórica de formato Bfloat16 (BF16), 2614,9 TFLOPS de precisión máxima teórica de 8 bits (FP8), 2614,9 TOPS INT8 de rendimiento de punto flotante. Se espera que MI300X sea capaz de aprovechar la sparsity de la estructura precisa proporcionando una mejora estimada del doble de la eficiencia matemática, lo que da como resultado 1307,4 TFLOP de precisión máxima teórica TensorFloat-32 (TF32), 2614,9 TFLOP de precisión media máxima teórica (FP16), 2614,9 TFLOP de precisión máxima teórica de formato Bfloat16 (BF16), 5229,8 TFLOP de precisión máxima teórica de 8 bits (FP8), 5229,8 TOP INT8 de rendimiento de punto flotante con sparsity. Los resultados calculados para el acelerador AMD Instinct™ MI250X (560 W) HBM2e OAM de 128 GB diseñado con la tecnología de proceso FinFet de 5 nm de AMD CDNA™ 2 a una frecuencia de reloj de motor con impulso máximo de 1700 MHz dieron como resultado TF32* (N/D), 383,0 TFLOPS de máximo teórico de precisión media (FP16), 383,0 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), FP8* (N/D), 383,0 TOPS de rendimiento de punto flotante INT8. * Las GPU AMD Instinct Serie MI200 no admiten TF32, FP8 ni sparsity. MI300-16

- Mediciones realizadas por los laboratorios de rendimiento internos de AMD el 2 de junio del 2023 sobre las especificaciones actuales o los cálculos de ingeniería interna. Gran modelo de lenguaje (LLM, Large Language Model) ejecutado o calculado con precisión FP16 para determinar la cantidad mínima de GPU necesarias para ejecutar los modelos Falcon-7B (parámetros 7B, 40B), LLaMA (parámetros 13B, 33B), OPT (parámetros 66B), GPT-3 (parámetros 175B), BLOOM (parámetro 176B) y Palm (parámetros 340B, 540B). Estimaciones calculadas con base en el tamaño de la memoria únicamente de GPU en comparación con la memoria requerida por el modelo en parámetros definidos más un 10 % de sobrecarga. Los cálculos dependen de los tamaños de memoria del modelo publicado y, a veces, preliminar. Los resultados de GPT-3, BLOOM y PaML se estimaron en MI300X debido a la disponibilidad del sistema o de las piezas. Configuraciones de resultados probadas: Sistema del laboratorio de AMD que consta de 1 CPU EPYC 9654 (96 núcleos) con 1 acelerador AMD Instinct™ MI300X (192 GB HBM3, módulo OAM) de 750 W

Resultados (precisión de FP16):

Modelo Parámetros Memoria total requerida MI300X requerido Falcon-7B 7000 millones 15.4 GB 1 real LLaMA 13 mil millones 44 GB 1 real LLaMA 33 mil millones 72.5 GB 1 real Falcon-40B 40 mil millones 88 GB 1 real OPT 66 mil millones 145.2 GB 1 real GPT-3 175 mil millones 385 GB 3 calculado Bloom 176 mil millones 387.2 GB 3 calculado PaLM 340 mil millones 748 GB 4 calculado PaLM 540 mil millones 1188 GB 7 calculado Las estimaciones calculadas pueden variar según el tamaño del modelo final; las estimaciones y los valores reales pueden variar debido a los gastos generales reales requeridos y al uso de la memoria del sistema más allá de la GPU. Los fabricantes de servidores pueden variar las ofertas de configuración, lo que arroja resultados diferentes. MI300-07

- Las mediciones realizadas por los laboratorios de rendimiento de AMD al 11 de noviembre del 2023 en la GPU AMD Instinct™ MI300X (750 W) diseñada con la tecnología de proceso FinFET de 5 nm | 6 nm AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron los 653,7 TFLOPS de precisión máxima teórica de TensorFloat-32 (TF32), 1307,4 TFLOPS de precisión media máxima teórica (FP16), 1307,4 TFLOPS de precisión máxima teórica de formato Bfloat16 (BF16), 2614,9 TFLOPS de precisión máxima teórica de 8 bits (FP8), 2614,9 TOPS INT8 de rendimiento de punto flotante. Se espera que MI300X sea capaz de aprovechar la sparsity de la estructura precisa proporcionando una mejora estimada del doble de la eficiencia matemática, lo que da como resultado 1307,4 TFLOP de precisión máxima teórica TensorFloat-32 (TF32), 2614,9 TFLOP de precisión media máxima teórica (FP16), 2614,9 TFLOP de precisión máxima teórica de formato Bfloat16 (BF16), 5229,8 TFLOP de precisión máxima teórica de 8 bits (FP8), 5229,8 TOP INT8 de rendimiento de punto flotante con sparsity. Los resultados publicados de la GPU Nvidia H100 SXM (80 GB) de 700 W dieron como resultado 989,4 TFLOPS máxima TensorFloat-32 (TF32) con sparsity, 1978,9 TFLOPS de precisión media teórica máxima (FP16) con sparsity, 1978,9 TFLOPS de precisión de formato Bfloat16 máxima teórica (BF16) con sparsity, 3957,8 TFLOPS de precisión de 8 bits máxima teórica (FP8) con sparsity, 3957,8 TOPS de rendimiento de punto flotante INT8 con sparsity máxima teórica. Fuente NVIDIA H100: https://resources.nvidia.com/en-us-tensor-core. MI300-17

- Las mediciones realizadas en los laboratorios de rendimiento de AMD al 11 de noviembre del 2023 en la GPU AMD Instinct™ MI300X (750 W) diseñada con la tecnología de proceso FinFet de 5 nm | 6 nm de AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron los 163,4 TFLOPS de máximo teórico de matriz de precisión doble (Matriz FP64), 81,7 TFLOPS de máximo teórico de precisión doble (FP64), 163,4 TFLOPS de máximo teórico de matriz de precisión simple (Matriz FP32), 163,4 TFLOPS de máximo teórico de precisión simple (FP32), 653,7 TFLOPS de máximo teórico de precisión con TensorFloat-32 (TF32), 1307,4 TFLOPS de máximo teórico de precisión media (FP16), 1307,4 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), 2614,9 TFLOPS de máximo teórico de precisión de 8 bits (FP8), 2614,9 TOPS de rendimiento de punto flotante INT8. Los resultados publicados de la GPU Nvidia H100 SXM (80 GB) dieron como resultado 66,9 TFLOPS de máximo teórico de tensor de precisión doble (Tensor FP64), 33,5 TFLOPS de máximo teórico de precisión doble (FP64), 66,9 TFLOPS de máximo teórico de precisión simple (FP32), 494,7 TFLOPS de precisión máxima con TensorFloat-32 (TF32)*, 989,4 TFLOPS de máximo teórico de tensor de precisión media (Tensor FP16), 133,8 TFLOPS de máximo teórico de precisión media (FP16), 989,4 TFLOPS de máximo teórico de precisión de formato Bfloat16 (Tensor BF16), 133,8 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), 1978,9 TFLOPS de máximo teórico de precisión de 8 bits (FP8), 1978,9 TOPS de máximo teórico de rendimiento de punto flotante INT8. Fuente Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ * Las GPU Nvidia H100 no admiten Tensor FP32. MI300-18

- Las mediciones realizadas en los laboratorios de rendimiento de AMD el 17 de noviembre del 2023 en el acelerador AMD Instinct™ MI300X OAM de 750 W (192 GB de memoria HBM3) diseñado con la tecnología de proceso FinFet de 5 nm de AMD CDNA™ 3 arrojaron como resultado 192 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria máximo teórico de 5,325 TFLOPS. La interfaz de bus de memoria MI300X es de 8192 y la velocidad de datos de memoria es de 5,2 Gbps para el ancho de banda de memoria máximo total de 5,325 TB/s (interfaz de bus de memoria de 8192 bits * 5,2 Gbps de velocidad de datos de memoria/8). Los resultados más altos publicados sobre el acelerador de GPU NVIDIA Hopper H200 (141 GB) SXM arrojaron como resultado 141 GB de capacidad de memoria HBM3e y un rendimiento de ancho de banda de memoria de GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Los resultados más altos publicados sobre el acelerador de GPU NVIDIA Hopper H100 (80 GB) SXM5 arrojaron como resultado 80 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria de GPU de 3,35 TB/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A

- Las mediciones realizadas en los laboratorios de rendimiento de AMD al 18 de noviembre del 2023 en la GPU AMD Instinct™ MI300X (192 GB de memoria HBM3) de 750 W diseñada con la tecnología de proceso FinFet de 5 nm | 6 nm de AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron los 1307,4 TFLOPS de máximo teórico de precisión media (FP16), 1307,4 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16). Se espera que MI300X sea capaz de aprovechar la sparcity de la estructura precisa proporcionando una mejora estimada del doble de la eficiencia matemática, lo que da como resultado 2614,9 TFLOP de precisión media máxima teórica (FP16), 2614,9 TFLOP de precisión máxima teórica de formato Bfloat16 (BF16, rendimiento de punto flotante con sparsity). Los resultados publicados de la GPU Nvidia H100 SXM (80 GB de memoria HBM3) de 700 W arrojaron 1978,9 TFLOPS de máximo teórico de precisión media (FP16) con sparsity, 1978,9 TFLOPS de máximo teórico de rendimiento de punto flotante de precisión de formato Bfloat16 (BF16) con sparsity. Fuente Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ Los aceleradores AMD Instinct™ MI300X, diseñados con la tecnología AMD CDNA 3, incluyen hasta ocho puertos AMD Infinity Fabric, con lo cual el rendimiento máximo teórico de ancho de banda agregado para transferencia de datos entre tarjetas o pares (P2P) alcanza los 1,024 GB/s por GPU OAM. MI300-25

- Las mediciones realizadas en los laboratorios de rendimiento de AMD al 11 de noviembre del 2023 en la APU AMD Instinct™ MI300A (760 W) diseñada con la tecnología de proceso FinFet de 5 nm | 6nm de AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz arrojaron como resultado 122,6 TFLOPS de máximo teórico de precisión doble (Matriz FP64), 61,3 TFLOPS de máximo teórico de precisión doble (FP64), 122,6 TFLOPS de máximo teórico de matriz de precisión simple (Matriz FP32), 122,6 TFLOPS de máximo teórico de precisión simple (FP32), 490,3 TFLOPS de máximo teórico de precisión TensorFloat-32 (TF32), 980,6 TFLOPS de máximo teórico de precisión media (FP16), 980,6 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), 1961,2 TFLOPS de máximo teórico de precisión de 8 bits (FP8), 1961,2 TOPS de rendimiento de punto flotante INT8. Los resultados calculados para el acelerador AMD Instinct™ MI250X (560W) 128 GB HBM2e diseñado con la tecnología de proceso FinFeT de 5 nm AMD CDNA™ 2 a una frecuencia de reloj de motor con impulso máximo de 1700 MHz alcanzaron 95,7 TFLOPS de máximo teórico de precisión doble (matriz FP64); 47,9 TFLOPS de máximo teórico de precisión doble (FP64); 95,7 TFLOPS de máximo teórico de matriz de precisión simple (matriz FP32); 47,9 TFLOPS de máximo teórico de precisión simple (FP32); TF32* (N/A), 383,0 TFLOPS de máximo teórico de precisión media (FP16) y 383,0 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), FP8* (N/D), 383,0 TOPS de rendimiento de punto flotante INT8. Los fabricantes de servidores pueden variar las ofertas de configuración, lo que arroja resultados diferentes. * Las GPU de la Serie MI200 no admiten TF32, FP8 ni sparsity. MI300-10

- Las mediciones realizadas por los laboratorios de rendimiento de AMD el 11 de noviembre del 2023 en la APU AMD Instinct™ MI300A (750 W) diseñada con la tecnología de proceso FinFet de 5 nm | 6 nm AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron los 490,29 TFLOP de precisión máxima teórica de TensorFloat-32 (TF32), 980,58 TFLOP de precisión media máxima teórica (FP16), 980,58 TFLOP de precisión máxima teórica de formato Bfloat16 (BF 16), 1961,16 TFLOP de precisión máxima teórica de 8 bits (FP8), 1961,16 TOP INT8 de rendimiento de punto flotante. Se espera que MI300A sea capaz de aprovechar la sparsity de la estructura precisa proporcionando una mejora estimada del doble de la eficiencia matemática, lo que da como resultado 980,58 TFLOP de precisión máxima teórica TensorFloat-32 (TF32), 1961,16 TFLOP de precisión media máxima teórica (FP16), 1961,16 TFLOP de precisión máxima teórica de formato Bfloat16 (BF16), 3922,33 TFLOP de precisión máxima teórica de 8 bits (FP8), 3922,33 TOP INT8 de rendimiento de punto flotante con sparsity. Los resultados publicados de la GPU Nvidia H100 SXM5 (80 GB) dieron como resultado 989,4 TFLOPS de máximo de TensorFloat-32 (TF32) de núcleo Tensor con sparsity, 1978,9 TFLOPS de máximo teórico de precisión media (FP16) de núcleo Tensor con sparsity, 1978,9 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16) de núcleo Tensor con sparsity, 3957,8 TFLOPS de máximo teórico de precisión de 8 bits (FP8) de núcleo Tensor con sparsity, 3957,8 TOPS de máximo teórico de rendimiento de punto flotante INT8 de núcleo Tensor con sparsity. Fuente de Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ Los fabricantes de servidores pueden variar las ofertas de configuración, lo que arroja resultados diferentes. MI300-21

- Las mediciones realizadas en los laboratorios de rendimiento de AMD al 11 de noviembre del 2023 en la GPU AMD Instinct™ MI300A (760 W) diseñada con la tecnología de proceso FinFet de 5 nm | 6 nm de AMD CDNA™ 3 a una frecuencia de reloj de motor con impulso máximo de 2100 MHz alcanzaron los 122,6 TFLOPS de máximo teórico de matriz de precisión doble (Matriz FP64), 61,3 TFLOPS de máximo teórico de precisión doble (FP64), 122,6 TFLOPS de máximo teórico de matriz de precisión simple (Matriz FP32), 122,6 TFLOPS de máximo teórico de precisión simple (FP32), 490,29 TFLOPS de máximo teórico de precisión con TensorFloat-32 (TF32), 980,58 TFLOPS de máximo teórico de precisión media (FP16), 980,58 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), 1961,16 TFLOPS de máximo teórico de precisión de 8 bits (FP8), 1961,16 TOPS de rendimiento de punto flotante INT8. Los resultados publicados de la GPU Nvidia H100 SXM (80 GB) de 700 W dieron como resultado 66,9 TFLOPS de máximo teórico de tensor de precisión doble (Tensor FP64), 33,5 TFLOPS de máximo teórico de precisión doble (FP64), 66,9 TFLOPS de máximo teórico de precisión simple (FP32), 494,7 TFLOPS de precisión máxima con TensorFloat-32 (TF32)*, 989,4 TFLOPS de máximo teórico de tensor de precisión media (Tensor FP16), 133,8 TFLOPS de máximo teórico de precisión media (FP16), 989,4 TFLOPS de máximo teórico de precisión de tensor de formato Bfloat16 (Tensor BF16), 133,8 TFLOPS de máximo teórico de precisión de formato Bfloat16 (BF16), 1978,9 TFLOPS de máximo teórico de precisión de 8 bits (FP8), 1978,9 TOPS de máximo teórico de rendimiento de punto flotante INT8. Fuente de Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ Los fabricantes de servidores pueden variar las ofertas de configuración, lo que arroja resultados diferentes. * Las GPU Nvidia H100 no admiten Tensor FP32. MI300-20

- Las mediciones realizadas en los laboratorios de rendimiento de AMD al 7 de noviembre del 2023 en el acelerador de APU AMD Instinct™ MI300A de 760 W (128 GB de memoria HBM3) diseñado con la tecnología de proceso FinFet de 5 nm de AMD CDNA™ 3 arrojaron como resultado 128 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria máximo teórico de 5,325 TFLOPS. La interfaz de bus de memoria MI300A es de 8,192 (chip de 1024 x 8 bits) y la velocidad de datos de memoria es de 5,2 Gbps para el ancho de banda de memoria máximo total de 5325 TB/s (interfaz de bus de memoria de 8,192 bits * 5,2 Gbps de velocidad de datos de memoria/8). Los resultados más altos publicados acerca del acelerador de GPU NVIDIA Hopper H200 (141 GB) SXM arrojaron como resultado 141 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria de GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Los resultados más altos publicados acerca del acelerador de GPU NVIDIA Hopper H100 (80 GB) SXM arrojaron como resultado 80 GB de capacidad de memoria HBM3 y un rendimiento de ancho de banda de memoria de GPU de 3,35 TB/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet Los fabricantes de servidores pueden variar las ofertas de configuración, lo que arroja resultados diferentes. MI300-12