Turbinando a IA e a HPC

Os aceleradores AMD Instinct™ Série MI300 são excepcionalmente adequados para alimentar até mesmo as cargas de trabalho de IA e HPC mais exigentes, oferecendo desempenho de computação excepcional, grande densidade de memória com alta largura de banda e suporte para formatos de dados especializados.

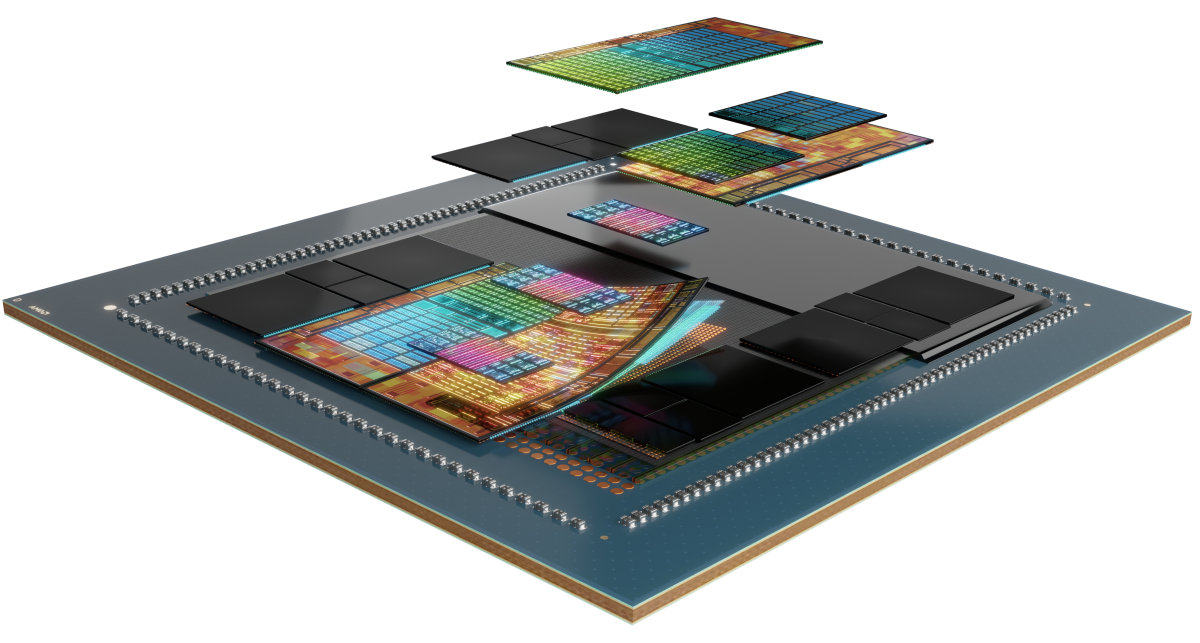

Equipamento interno

Os aceleradores AMD Instinct MI300 Series são construídos com base na arquitetura AMD CDNA™ 3, que oferece Matrix Core Technologies e suporte para uma ampla gama de recursos de precisão — desde os altamente eficientes INT8 e FP8 (incluindo suporte a dispersão para IA) até o mais exigente FP64 para HPC.

Conheça a série

Explore aceleradores AMD Instinct Série MI300, plataformas AMD Instinct Série MI300 e APU AMD Instinct MI300A.

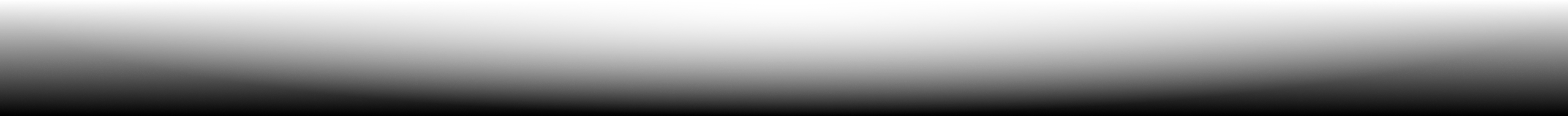

Conheça os aceleradores AMD Instinct™ MI325X

Os aceleradores de GPU AMD Instinct™ MI325X definem novos padrões de desempenho de IA com a arquitetura AMD CDNA™ de 3ª geração, oferecendo desempenho e eficiência incríveis para treinamento e inferência. Com memória líder do setor de 256 GB HBM3E e largura de banda de até 6 TB/s, eles otimizam o desempenho e ajudam a reduzir o custo total de propriedade.1

304 UCs

304 unidades de computação de GPU

256 GB

256 GB de memória HBM3E

6 TB/s

6 TB/s de largura de banda de memória teórica máxima

Comparações de especificações

- Desempenho de IA

- Desempenho de HPC

- Memória

Desempenho de IA (TFLOPs de pico)

Até 1,3 vez o desempenho de IA em comparação com os aceleradores da concorrência2, 3

H200 SXM de 141 GB

OAM MI325X de 256 GB

Desempenho HPC (TFLOPs de pico)

Até 2,4 vezes o desempenho HPC em comparação com os aceleradores da concorrência3

H200 SXM de 141 GB

OAM MI325X de 256 GB

Capacidade de memória e largura de banda

1,8 vez a capacidade de memória e 1,2 vez a largura de banda de memória em comparação com aceleradores da concorrência1

H200 SXM de 141 GB

OAM MI325X de 256 GB

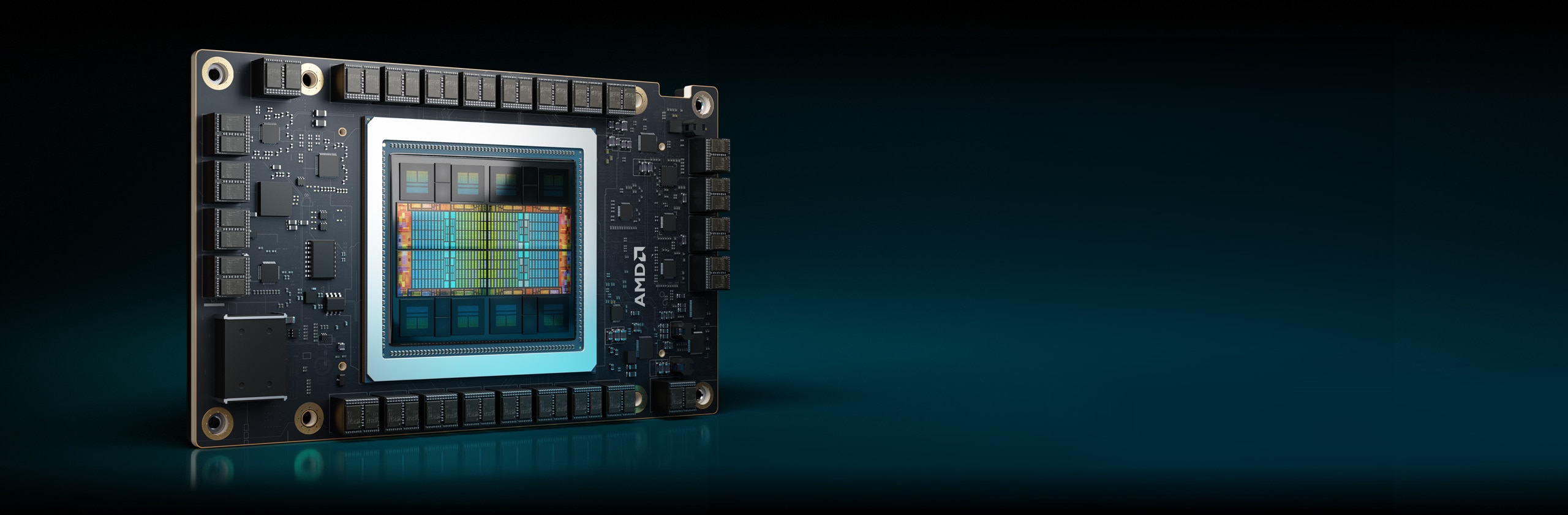

Aceleradores Instinct MI300X

Os aceleradores AMD Instinct Série MI300X foram projetados para oferecer desempenho de liderança para cargas de trabalho de IA generativa e aplicativos HPC.

304 UCs

304 unidades de computação de GPU

192 GB

Memória de 192 GB HBM3

5,3 TB/s

5,3 TB/s de largura de banda teórica máxima de memória

Desempenho de IA (TFLOPs de pico)

Até 1,3 vez o desempenho de IA em comparação com os aceleradores da concorrência6

Desempenho de HPC (TFLOPs de pico)

Até 2,4 vezes o desempenho HPC em comparação com os aceleradores da concorrência7

Capacidade de memória e largura de banda

2,4 vezes a capacidade de memória e 1,6 vez o pico de largura de banda de memória teórica em comparação com aceleradores da concorrência8

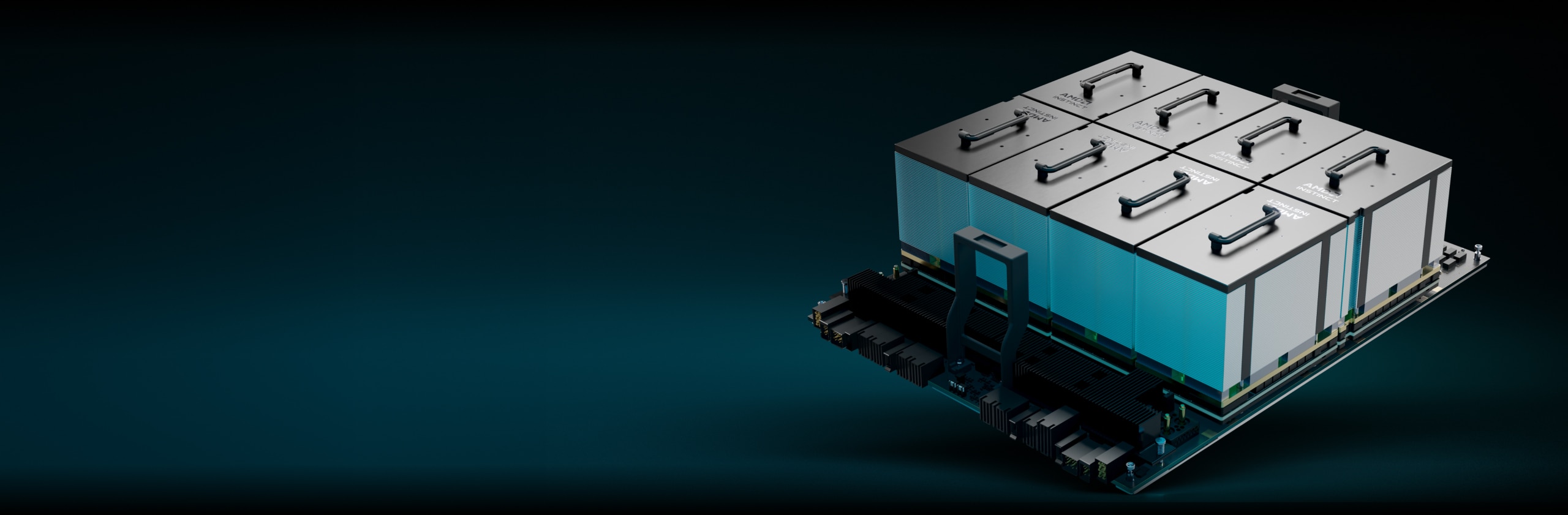

Plataformas AMD Instinct

A plataforma AMD Instinct MI325X integra oito módulos OAM de GPU MI325X totalmente conectados em um design OCP padrão do setor por meio de links AMD Infinity Fabric™ de 4ª geração, fornecendo até 2 TB de capacidade HBM3E para processamento de IA de baixa latência. Essa plataforma pronta para implantação pode acelerar o time-to-market e reduzir os custos de desenvolvimento ao adicionar aceleradores MI325X à infraestrutura de servidor e rack de IA existente.

8 MI325X

8 módulos OAM de GPU MI325X

2 TB

2 TB total de memória HBM3E

48 TB/s

48 TB/s de pico de largura de banda de memória agregada teórica

APUs AMD Instinct MI300A

Unidades de processamento acelerado (APUs) AMD Instinct MI300A combinam a potência dos aceleradores AMD Instinct e dos processadores AMD EPYC™ com memória compartilhada para permitir maior eficiência, flexibilidade e capacidade de programação. Essas unidades foram projetadas para acelerar a convergência de IA e HPC, ajudando a avançar na pesquisa e a impulsionar novas descobertas.

228 UCs

228 unidades de computação de GPU

24

24 núcleos de CPU x86 "Zen 4"

128 GB

Memória HBM3 unificada de 128 GB

5,3 TB/s

5,3 TB/s de largura de banda teórica máxima de memória

Desempenho de IA (TFLOPs de pico)11

Desempenho de HPC (TFLOPs de pico)

Até 1,8 vez o desempenho HPC em comparação com aceleradores da concorrência12

Capacidade de memória e largura de banda

2,4 vezes a capacidade de memória e 1,6 vez o pico de largura de banda de memória teórica em comparação com aceleradores concorrentes13

Avançando na computação Exascale

Os aceleradores AMD Instinct alimentam alguns dos principais supercomputadores do mundo, incluindo o sistema El Capitan do Lawrence Livermore National Laboratory. Veja como esse supercomputador de duas escalas exatas usará a IA para executar simulações inéditas e avançar na pesquisa científica.

Software AMD ROCm™

O software AMD ROCm™ inclui um amplo conjunto de modelos de programação, ferramentas, compiladores, bibliotecas e tempos de execução para modelos de IA e cargas de trabalho de HPC direcionados aos aceleradores AMD Instinct.

Estudos de caso

Encontre soluções

Encontre um parceiro que ofereça soluções baseadas no acelerador AMD Instinct.

Recursos

Mantenha-se informado

Inscreva-se para receber as últimas notícias sobre data centers e conteúdo sobre servidores.

Notas de rodapé

- MI325-001A – Cálculos realizados pelo AMD Performance Labs em 26 de setembro de 2024, com base nas especificações e/ou estimativas atuais. O acelerador AMD Instinct™ MI325X OAM terá capacidade de memória HBM3E de 256 GB e desempenho de largura de banda de memória teórica de pico de GPU de 6 TB/s. Os resultados reais baseados na produção de silício podem variar.

Os resultados publicados mais elevados para o acelerador de GPU NVidia Hopper H200 (141 GB) SXM resultaram em capacidade de memória HBM3E de 141 GB e desempenho de largura de banda de memória de GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Os resultados publicados mais elevados para o acelerador de GPU NVidia Blackwell HGX B100 (192 GB) 700W resultaram em capacidade de memória HBM3E de 192 GB e desempenho de largura de banda de memória de GPU de 8 TB/s.

Os resultados publicados mais elevados para o acelerador de GPU Blackwell HGX B200 (192GB) SXM resultaram em capacidade de memória HBM3E de 192 GB e desempenho de largura de banda de memória de GPU de 8 TB/s.

Especificações NVIDIA Blackwell em https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy

- MI325-002 – Os cálculos realizados pelo AMD Performance Labs em 28 de maio de 2024 para a GPU AMD Instinct™ MI325X resultaram em 1307,4 TFLOPS de pico teórico de meia precisão (FP16), 1307,4 TFLOPS de pico teórico de precisão de formato Bfloat16 (BF16), 2614,9 TFLOPS de pico teórico de precisão de 8 bits (FP8), 2614,9 TOPs de desempenho do ponto de flutuação INT8. O desempenho real varia de acordo com as especificações finais e a configuração do sistema.

Resultados publicados sobre a GPU Nvidia H200 SXM (141 GB): 989,4 TFLOPS de pico teórico do tensor de meia precisão (FP16 Tensor), 989,4 TFLOPS de pico teórico da precisão do formato do tensor Bfloat16 (BF16 Tensor), 1.978,9 TFLOPS de pico teórico da precisão de 8 bits (FP8), 1.978,9 TOPs de pico teórico do desempenho do ponto de flutuação INT8. O desempenho do núcleo do tensor BFLOAT16, do núcleo do tensor FP16, do núcleo do tensor FP8 e do núcleo do tensor INT8 foi publicado pela NVIDIA usando dispersão. Para fins de comparação, a AMD converteu esses números para não dispersão/densa dividindo-os por 2, e esses números aparecem acima

Fonte NVIDIA H200: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 e https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Nota: As GPUs Nvidia H200 têm o mesmo desempenho em FLOPs publicados que os produtos H100 https://resources.nvidia.com/en-us-tensor-core/. MI325-02

- MI325-008 – Os cálculos realizados pelos AMD Performance Labs em 2 de outubro de 2024 na GPU AMD Instinct™ MI325X (1000 W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico de precisão dupla teórica de 163,4 TFLOPS (Matriz FP64), pico de precisão dupla teórica de 81,7 TFLOPS (FP64), matriz de pico de precisão única teórica de 163,4 TFLOPS (Matriz FP32), pico de precisão única teórica de 163,4 TFLOPS (FP32), pico teórico do TensorFloat-32 de 653,7 TFLOPS (TF32), pico de meia precisão teórica de 1307,4 TFLOPS (FP16). O desempenho real pode variar de acordo com as especificações finais e a configuração do sistema.

Resultados publicados sobre a GPU Nvidia H200 SXM (141 GB): 66,9 TFLOPs de pico de precisão dupla teórica (FP64 Tensor), 33,5 TFLOPs de pico de precisão dupla teórica (FP64), 66,9 TFLOPs de pico de precisão simples teórica (FP32), 494,7 TFLOPs de pico de TensorFloat-32 (TF32), 989,5 TFLOPS de pico de tensor de meia precisão teórica (FP16 Tensor). O desempenho do TF32 Tensor Core foi publicado pela Nvidia usando dispersão. Para fins de comparação, a AMD converteu esses números para não dispersão/densa dividindo por 2, e esse número aparece acima.

Fonte NVIDIA H200: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 e https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Nota: As GPUs Nvidia H200 têm o mesmo desempenho em FLOPs publicados que os produtos H100 https://resources.nvidia.com/en-us-tensor-core/.

*As GPUs Nvidia H200 não são compatíveis com Tensor FP32.

- As medições realizadas pela AMD Performance Labs em 11 de novembro de 2023 na GPU AMD Instinct™ MI300X (750W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico teórico do TensorFloat-32 de 653,7 TFLOPS (TF32), pico de meia precisão teórica de 1.307,4 TFLOPS (FP16), pico de precisão do formato Bfloat16 (BF16) de 1.307,4 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 2.614,9 TFLOPS, desempenho do ponto de flutuação INT8 de 2.614,9 TOPs. É esperado que o MI300X seja capaz de aproveitar a dispersão da estrutura de granulação fina proporcionando uma melhoria estimada de 2x na eficiência matemática, resultando em pico teórico do TensorFloat-32 (TF32) de 1.307,4 TFLOPS, pico de meia precisão teórica (FP16) de 2.614,9 TFLOPS, pico de precisão do formato Bfloat16 (BF16) de 2.614,9 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 5.229,8 TFLOPS, desempenho do ponto de flutuação INT8 de 5.229,8 TOPs com dispersão. Os resultados calculados para o acelerador OAM HBM2e AMD Instinct™ MI250X (560W) de 128GB projetado com tecnologia de processo FinFET AMD CDNA™ de 2 5nm com aumento de pico do clock do mecanismo de 1.700 MHz resultaram em TF32* (N/A), pico de meia precisão teórica de 383,0 TFLOPS (FP16), pico de precisão teórica do formato Bfloat16 de 383,0 TFLOPS (BF16), FP8* (N/A), desempenho do ponto de flutuação INT8 de 383,0 TOPs. *As GPUs da série AMD Instinct MI200 não são compatíveis com TF32, FP8 ou dispersão. MI300-16

- Medições feitas pelos laboratórios internos de desempenho da AMD em 2 de junho de 2023 com base nas especificações atuais e/ou cálculos internos de engenharia. Execução do modelo de linguagem grande (LLM) ou calculado com precisão FP16 para determinar o número mínimo de GPUs necessárias para executar os modelos Falcon-7B (7B, 40B parâmetros), LLaMA (13B, 33B parâmetros), OPT (66B parâmetros), GPT-3 (175B parâmetros), BLOOM (176B parâmetros) e PaLM (340B, 540B parâmetros). Estimativas calculadas com base no tamanho da memória somente da GPU versus a memória exigida pelo modelo em parâmetros definidos mais 10% de sobrecarga. Os cálculos se baseiam em tamanhos de memória de modelos publicados e, às vezes, preliminares. Resultados de GPT-3, BLOOM e PaML estimados no MI300X devido à disponibilidade do sistema/peça. Configurações de resultados testados: Sistema de laboratório AMD composto por 1x CPU EPYC 9654 (96 núcleos) com 1x acelerador AMD Instinct™ MI300X (192GB HBM3, Módulo OAM) 750W

Resultados (precisão FP16):

Modelo

Parâmetros

Necessário memória TOT

MI300X obrigatório

Falcon-7B

7 bilhões

15,4 GB

1 real

LLaMA

13 bilhões

44 GB

1 real

LLaMA

33 bilhões

72,5 GB

1 real

Falcon-40B

40 bilhões

88 GB

1 real

OPT

66 bilhões

145,2 GB

1 real

GPT-3

175 bilhões

385 GB

3 calculado

Bloom

176 bilhões

387,2 GB

3 calculado

PaLM

340 bilhões

748 GB

4 calculado

PaLM

540 bilhões

1188 GB

7 calculado

As estimativas calculadas podem variar com base no tamanho final do modelo; as estimativas reais e as estimativas podem variar devido à sobrecarga real necessária e ao uso da memória do sistema além da GPU. Os fabricantes de servidores podem variar as ofertas de configuração, produzindo resultados diferentes. MI300-07

- As medições realizadas pela AMD Performance Labs em 11 de novembro de 2023 na GPU AMD Instinct™ MI300X (750W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico teórico do TensorFloat-32 de 653,7 TFLOPS (TF32), pico de meia precisão teórica de 1.307,4 TFLOPS (FP16), pico de precisão do formato Bfloat16 (BF16) de 1.307,4 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 2.614,9 TFLOPS, desempenho do ponto de flutuação INT8 de 2.614,9 TOPs. É esperado que o MI300X seja capaz de aproveitar a dispersão da estrutura de granulação fina proporcionando uma melhoria estimada de 2x na eficiência matemática, resultando em pico teórico do TensorFloat-32 (TF32) de 1.307,4 TFLOPS, pico de meia precisão teórica (FP16) de 2.614,9 TFLOPS, pico de precisão do formato Bfloat16 (BF16) de 2.614,9 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 5.229,8 TFLOPS, desempenho do ponto de flutuação INT8 de 5.229,8 TOPs com dispersão. Os resultados publicados na GPU Nvidia H100 SXM (80GB) 700W resultaram em 989,4 TFLOPs de pico de TensorFloat-32 (TF32) com dispersão, 1.978,9 TFLOPS de pico de meia precisão teórica (FP16) com dispersão, 1.978,9 TFLOPS de pico teórico de precisão de formato Bfloat16 (BF16) com dispersão, 3.957,8 TFLOPS de pico teórico de precisão de 8 bits (FP8) com dispersão, 3.957,8 TOPs de pico teórico de INT8 com desempenho de ponto flutuante com dispersão. Fonte NVIDIA H100: https://resources.nvidia.com/en-us-tensor-core. MI300-17

- As medições realizadas pela AMD Performance Labs em 11 de novembro de 2023 na GPU AMD Instinct™ MI300X (750W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico de precisão dupla teórica de 163,4 TFLOPS (Matriz FP64), pico de precisão dupla teórica de 81,7 TFLOPS (FP64), matriz de pico de precisão única teórica de 163,4 TFLOPS (Matriz FP32), pico de precisão única teórica de 163,4 TFLOPS (FP32), pico teórico do TensorFloat-32 de 653,7 TFLOPS (TF32), pico de meia precisão teórica de 1307,4 TFLOPS (FP16), pico de precisão do formato Bfloat16 (BF16) de 1307,4 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 2614,9 TFLOPS, desempenho do ponto de flutuação INT8 de 2614,9 TOPs. Resultados publicados sobre a GPU NVIDIA H100 SXM (80 GB) resultaram em pico de precisão dupla teórica do tensor de 66,9 TFLOPS (FP64 Tensor), pico de precisão dupla teórica de 33,5 TFLOPS (FP64), pico de precisão única teórica de 66,9 TFLOPS (FP32), pico do TensorFloat-32 de 494,7 TFLOPS (TF32)*, pico de meia precisão do tensor de 989,4 TFLOPS (Tensor FP16), pico de meia precisão teórica de 133,8 TFLOPS (FP16), pico de precisão teórica do formato do tensor Bfloat16 de 989,4 TFLOPS (Tensor BF16), pico de precisão teórica do formato Bfloat16 de 133,8 TFLOPS (BF16), pico de precisão teórica de 8 bits de 1.978,9 TFLOPS (FP8), pico teórico do desempenho do ponto de flutuação INT8 de 1.978,9 TOPs. Fonte NVIDIA H100: https://resources.nvidia.com/en-us-tensor-core/. * As GPUs NVIDIA H100 não são compatíveis com Tensor FP32. MI300-18

- Cálculos conduzidos pelo AMD Performance Labs em 17 de novembro de 2023 para o acelerador AMD Instinct™ MI300X OAM de 750W (HBM3 de 192 GB), projetado com a tecnologia de processo AMD CDNA™ 3 5 nm FinFet, que resultou em capacidade de memória HBM3 de 192 GB e desempenho de largura de banda de memória de pico teórica de 5,325 TFLOPS. A interface do barramento de memória MI300X é de 8.192 bits, e a taxa de dados de memória é de 5,2 Gbps para largura de banda de memória de pico total de 5,325 TB/s (interface de barramento de memória de 8.192 bits * taxa de dados de memória de 5,2 Gbps/8). Os resultados mais altos publicados sobre o acelerador de GPU SXM NVIDIA Hopper H200 (141 GB) resultaram em capacidade de memória HBM3e de 141 GB e desempenho de largura de banda de memória GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446. Os resultados mais altos publicados sobre o acelerador de GPU SXM5 NVIDIA Hopper H100 (80 GB) resultaram em capacidade de memória HBM3 de 80 GB e desempenho de largura de banda de memória da GPU de 3,35 TB/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A

- As medições realizadas pela AMD Performance Labs em 18 de novembro de 2023 na GPU AMD Instinct™ MI300X (HBM3 de 192 GB) 750W projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHZ resultaram em pico de meia precisão teórica de 1.307,4 TFLOPS (FP16), pico de precisão teórica do formato Bfloat16 de 1.307,4 TFLOPS (BF16). É esperado que o MI300X seja capaz de aproveitar a dispersão da estrutura de granulação fina proporcionando uma melhoria estimada de 2x na eficiência matemática, resultando em pico de meia precisão teórica de 2.614,9 TFLOPS (FP16), pico de precisão teórica do formato Bfloat16 de 2.614,9 TFLOPS (BF16) e desempenho do ponto de flutuação com dispersão). Os resultados publicados sobre a GPU NVIDIA H100 SXM (HBM3 de 80GB) 700W resultaram em pico de meia precisão teórica de 1.978,9 (FP16) com dispersão, pico de precisão teórica do formato Bfloat16 de 1.978,9 TFLOPS (BF16) e desempenho do ponto de flutuação com dispersão. Fonte NVIDIA H100: https://resources.nvidia.com/en-us-tensor-core/. Os aceleradores AMD Instinct™ MI300X baseados na tecnologia AMD CDNA 3 incluem até oito links AMD Infinity Fabric fornecendo desempenho de largura de banda da taxa de transporte peer-to-peer (P2P) com pico teórico agregado de GPU de até 1.024 GB/s por placa de GPU OAM. MI300-25

- As medições realizadas pela AMD Performance Labs em 11 de novembro de 2023 na APU AMD Instinct™ MI300A (760W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5nm | 6nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico de precisão dupla teórica de 122,6 TFLOPS (Matriz FP64), pico de precisão dupla teórica de 61,3 TFLOPS (FP64), matriz de pico de precisão única teórica de 122,6 TFLOPS (Matriz FP32), pico de precisão única teórica de 122,6 TFLOPS (FP32), pico teórico do TensorFloat-32 de 490,3 TFLOPS (TF32), pico de meia precisão teórica de 980,6 TFLOPS (FP16), pico de precisão do formato Bfloat16 (BF16) de 980,6 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 1.961,2 TFLOPS, desempenho do ponto de flutuação INT8 de 1.961,2 TOPs. Os resultados calculados para o acelerador OAM HBM2e AMD Instinct™ MI250X (560W) de 128GB projetado com tecnologia de processo FinFET AMD CDNA™ de 2 5nm com aumento de pico do clock do mecanismo de 1.700 MHz resultaram em um pico de precisão dupla teórica 95,7 TFLOPS (Matriz FP64), pico de precisão dupla teórica de 47,9 TFLOPS (FP64), matriz de pico de precisão única teórica de 95,7 TFLOPS (Matriz FP32), pico de precisão única teórica de 47,9 TFLOPS (FP32), TF32* (N/A), pico de meia precisão teórica de 383,0 TFLOPS (FP16), pico de precisão teórica do formato Bfloat16 de 383,0 TFLOPS (BF16), FP8* (N/A), desempenho do ponto de flutuação INT8 de 383,0 TOPs. Os fabricantes de servidores podem variar as ofertas de configuração, produzindo resultados diferentes. * As GPUs da Série MI200 não suportam TF32, FP8 ou dispersão MI300-10

- As medições realizadas pela AMD Performance Labs em 11 de novembro de 2023 na APU AMD Instinct™ MI300A (750W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico teórico do TensorFloat-32 de 490,29 TFLOPS (TF32), pico de meia precisão teórica de 980,58 TFLOPS (FP16), pico de precisão do formato Bfloat16 (BF16) de 980,58 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 1.961,16 TFLOPS, desempenho do ponto de flutuação INT8 de 1.961,16 TOPs. É esperado que o MI300A seja capaz de aproveitar a dispersão da estrutura de granulação fina proporcionando uma melhoria estimada de 2x na eficiência matemática, resultando em pico teórico do TensorFloat-32 (TF32) de 980,58 TFLOPS, pico de meia precisão teórica (FP16) de 1.961,16 TFLOPS, pico de precisão do formato Bfloat16 (BF16) de 1.961,16 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 3.922,33 TFLOPS, desempenho do ponto de flutuação INT8 de 3.922,33 TOPs com dispersão. Os resultados publicados na GPU Nvidia H100 SXM5 (80 GB) resultaram em 989,4 TFLOPs de pico do núcleo do tensor TensorFloat-32 (TF32) com dispersão, 1.978,9 TFLOPS de pico teórico de meia precisão (FP16) do núcleo do tensor com dispersão, 1.978,9 TFLOPS de pico teórico de precisão de formato Bfloat16 (BF16) Núcleo do Tensor com dispersão, 3.957,8 TFLOPS de pico teórico de precisão de 8 bits (FP8) Núcleo do Tensor com dispersão, 3.957,8 TOPs de pico teórico de desempenho de ponto flutuante do INT8 Núcleo do Tensor com dispersão. Fonte NVIDIA H100: https://resources.nvidia.com/en-us-tensor-core/. Os fabricantes de servidores podem variar as ofertas de configuração, produzindo resultados diferentes. MI300-21

- As medições realizadas pela AMD Performance Labs em 11 de novembro de 2023 na GPU AMD Instinct™ MI300A (760W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico de precisão dupla teórica de 122,6 TFLOPS (Matriz FP64), pico de precisão dupla teórica de 61,3 TFLOPS (FP64), matriz de pico de precisão única teórica de 122,6 TFLOPS (Matriz FP32), pico de precisão única teórica de 122,6 TFLOPS (FP32), pico teórico do TensorFloat-32 de 490,29 TFLOPS (TF32), pico de meia precisão teórica de 980,58 TFLOPS (FP16), pico de precisão do formato Bfloat16 (BF16) de 980,58 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 1961,16 TFLOPS, desempenho do ponto de flutuação INT8 de 1961,16 TOPs. Resultados publicados sobre a GPU NVIDIA H100 SXM de 700W (80 GB) resultaram em pico de precisão dupla teórica do tensor de 66,9 TFLOPS (FP64 Tensor), pico de precisão dupla teórica de 33,5 TFLOPS (FP64), pico de precisão única teórica de 66,9 TFLOPS (FP32), pico do TensorFloat-32 de 494,7 TFLOPS (TF32)*, pico de meia precisão do tensor de 989,4 TFLOPS (Tensor FP16), pico de meia precisão teórica de 133,8 TFLOPS (FP16), pico de precisão teórica do formato do tensor Bfloat16 de 989,4 TFLOPS (Tensor BF16), pico de precisão teórica do formato Bfloat16 de 133,8 TFLOPS (BF16), pico de precisão teórica de 8 bits de 1.978,9 TFLOPS (FP8), pico teórico do desempenho do ponto de flutuação INT8 de 1.978,9 TOPs. Fonte NVIDIA H100: https://resources.nvidia.com/en-us-tensor-core/. Os fabricantes de servidores podem variar as ofertas de configuração, produzindo resultados diferentes. * As GPUs NVIDIA H100 não são compatíveis com Tensor FP32. MI300-20

- Cálculos conduzidos pelo AMD Performance Labs em 7 de novembro de 2023 para o acelerador AMD Instinct™ MI300A APU de 760W (HBM3 de 128 GB), projetado com a tecnologia de processo AMD CDNA™ 3 5 nm FinFet, que resultou em capacidade de memória HBM3 de 128 GB e desempenho de largura de banda de memória de pico teórica de 5,325 TFLOPS. A interface do barramento de memória MI300A é de 8.192 bits (1.024 bits x 8 die) e a taxa de dados de memória é de 5,2 Gbps para largura de banda de memória total máxima de 5,325 TB/s (interface de barramento de memória de 8.192 bits * taxa de dados de memória de 5,2 Gbps/8). Os resultados mais altos publicados sobre o acelerador de GPU SXM NVIDIA Hopper H200 (141 GB) resultaram em capacidade de memória HBM3e de 141 GB e desempenho de largura de banda de memória da GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446. Os resultados mais altos publicados sobre o acelerador de GPU SXM NVIDIA Hopper H100 (80 GB) resultaram em capacidade de memória HBM3 de 80 GB e desempenho de largura de banda de memória da GPU de 3,35 TB/s. Https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet. Os fabricantes de servidores podem variar as ofertas de configuração, produzindo resultados diferentes. MI300-12

- MI325-001A – Cálculos realizados pelo AMD Performance Labs em 26 de setembro de 2024, com base nas especificações e/ou estimativas atuais. O acelerador AMD Instinct™ MI325X OAM terá capacidade de memória HBM3E de 256 GB e desempenho de largura de banda de memória teórica de pico de GPU de 6 TB/s. Os resultados reais baseados na produção de silício podem variar.

Os resultados publicados mais elevados para o acelerador de GPU NVidia Hopper H200 (141 GB) SXM resultaram em capacidade de memória HBM3E de 141 GB e desempenho de largura de banda de memória de GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Os resultados publicados mais elevados para o acelerador de GPU NVidia Blackwell HGX B100 (192 GB) 700W resultaram em capacidade de memória HBM3E de 192 GB e desempenho de largura de banda de memória de GPU de 8 TB/s.

Os resultados publicados mais elevados para o acelerador de GPU Blackwell HGX B200 (192GB) SXM resultaram em capacidade de memória HBM3E de 192 GB e desempenho de largura de banda de memória de GPU de 8 TB/s.

Especificações NVIDIA Blackwell em https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy - MI325-002 – Os cálculos realizados pelo AMD Performance Labs em 28 de maio de 2024 para a GPU AMD Instinct™ MI325X resultaram em 1307,4 TFLOPS de pico teórico de meia precisão (FP16), 1307,4 TFLOPS de pico teórico de precisão de formato Bfloat16 (BF16), 2614,9 TFLOPS de pico teórico de precisão de 8 bits (FP8), 2614,9 TOPs de desempenho do ponto de flutuação INT8. O desempenho real varia de acordo com as especificações finais e a configuração do sistema.

Resultados publicados sobre a GPU Nvidia H200 SXM (141 GB): 989,4 TFLOPS de pico teórico do tensor de meia precisão (FP16 Tensor), 989,4 TFLOPS de pico teórico da precisão do formato do tensor Bfloat16 (BF16 Tensor), 1.978,9 TFLOPS de pico teórico da precisão de 8 bits (FP8), 1.978,9 TOPs de pico teórico do desempenho do ponto de flutuação INT8. O desempenho do núcleo do tensor BFLOAT16, do núcleo do tensor FP16, do núcleo do tensor FP8 e do núcleo do tensor INT8 foi publicado pela NVIDIA usando dispersão. Para fins de comparação, a AMD converteu esses números para não dispersão/densa dividindo-os por 2, e esses números aparecem acima

Fonte NVIDIA H200: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 e https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Nota: As GPUs Nvidia H200 têm o mesmo desempenho em FLOPs publicados que os produtos H100 https://resources.nvidia.com/en-us-tensor-core/. MI325-02 - MI325-008 – Os cálculos realizados pelos AMD Performance Labs em 2 de outubro de 2024 na GPU AMD Instinct™ MI325X (1000 W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico de precisão dupla teórica de 163,4 TFLOPS (Matriz FP64), pico de precisão dupla teórica de 81,7 TFLOPS (FP64), matriz de pico de precisão única teórica de 163,4 TFLOPS (Matriz FP32), pico de precisão única teórica de 163,4 TFLOPS (FP32), pico teórico do TensorFloat-32 de 653,7 TFLOPS (TF32), pico de meia precisão teórica de 1307,4 TFLOPS (FP16). O desempenho real pode variar de acordo com as especificações finais e a configuração do sistema.

Resultados publicados sobre a GPU Nvidia H200 SXM (141 GB): 66,9 TFLOPs de pico de precisão dupla teórica (FP64 Tensor), 33,5 TFLOPs de pico de precisão dupla teórica (FP64), 66,9 TFLOPs de pico de precisão simples teórica (FP32), 494,7 TFLOPs de pico de TensorFloat-32 (TF32), 989,5 TFLOPS de pico de tensor de meia precisão teórica (FP16 Tensor). O desempenho do TF32 Tensor Core foi publicado pela Nvidia usando dispersão. Para fins de comparação, a AMD converteu esses números para não dispersão/densa dividindo por 2, e esse número aparece acima.

Fonte NVIDIA H200: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 e https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Nota: As GPUs Nvidia H200 têm o mesmo desempenho em FLOPs publicados que os produtos H100 https://resources.nvidia.com/en-us-tensor-core/.

*As GPUs Nvidia H200 não são compatíveis com Tensor FP32. - As medições realizadas pela AMD Performance Labs em 11 de novembro de 2023 na GPU AMD Instinct™ MI300X (750W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico teórico do TensorFloat-32 de 653,7 TFLOPS (TF32), pico de meia precisão teórica de 1.307,4 TFLOPS (FP16), pico de precisão do formato Bfloat16 (BF16) de 1.307,4 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 2.614,9 TFLOPS, desempenho do ponto de flutuação INT8 de 2.614,9 TOPs. É esperado que o MI300X seja capaz de aproveitar a dispersão da estrutura de granulação fina proporcionando uma melhoria estimada de 2x na eficiência matemática, resultando em pico teórico do TensorFloat-32 (TF32) de 1.307,4 TFLOPS, pico de meia precisão teórica (FP16) de 2.614,9 TFLOPS, pico de precisão do formato Bfloat16 (BF16) de 2.614,9 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 5.229,8 TFLOPS, desempenho do ponto de flutuação INT8 de 5.229,8 TOPs com dispersão. Os resultados calculados para o acelerador OAM HBM2e AMD Instinct™ MI250X (560W) de 128GB projetado com tecnologia de processo FinFET AMD CDNA™ de 2 5nm com aumento de pico do clock do mecanismo de 1.700 MHz resultaram em TF32* (N/A), pico de meia precisão teórica de 383,0 TFLOPS (FP16), pico de precisão teórica do formato Bfloat16 de 383,0 TFLOPS (BF16), FP8* (N/A), desempenho do ponto de flutuação INT8 de 383,0 TOPs. *As GPUs da série AMD Instinct MI200 não são compatíveis com TF32, FP8 ou dispersão. MI300-16

- Medições feitas pelos laboratórios internos de desempenho da AMD em 2 de junho de 2023 com base nas especificações atuais e/ou cálculos internos de engenharia. Execução do modelo de linguagem grande (LLM) ou calculado com precisão FP16 para determinar o número mínimo de GPUs necessárias para executar os modelos Falcon-7B (7B, 40B parâmetros), LLaMA (13B, 33B parâmetros), OPT (66B parâmetros), GPT-3 (175B parâmetros), BLOOM (176B parâmetros) e PaLM (340B, 540B parâmetros). Estimativas calculadas com base no tamanho da memória somente da GPU versus a memória exigida pelo modelo em parâmetros definidos mais 10% de sobrecarga. Os cálculos se baseiam em tamanhos de memória de modelos publicados e, às vezes, preliminares. Resultados de GPT-3, BLOOM e PaML estimados no MI300X devido à disponibilidade do sistema/peça. Configurações de resultados testados: Sistema de laboratório AMD composto por 1x CPU EPYC 9654 (96 núcleos) com 1x acelerador AMD Instinct™ MI300X (192GB HBM3, Módulo OAM) 750W

Resultados (precisão FP16):

Modelo Parâmetros Necessário memória TOT MI300X obrigatório Falcon-7B 7 bilhões 15,4 GB 1 real LLaMA 13 bilhões 44 GB 1 real LLaMA 33 bilhões 72,5 GB 1 real Falcon-40B 40 bilhões 88 GB 1 real OPT 66 bilhões 145,2 GB 1 real GPT-3 175 bilhões 385 GB 3 calculado Bloom 176 bilhões 387,2 GB 3 calculado PaLM 340 bilhões 748 GB 4 calculado PaLM 540 bilhões 1188 GB 7 calculado As estimativas calculadas podem variar com base no tamanho final do modelo; as estimativas reais e as estimativas podem variar devido à sobrecarga real necessária e ao uso da memória do sistema além da GPU. Os fabricantes de servidores podem variar as ofertas de configuração, produzindo resultados diferentes. MI300-07

- As medições realizadas pela AMD Performance Labs em 11 de novembro de 2023 na GPU AMD Instinct™ MI300X (750W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico teórico do TensorFloat-32 de 653,7 TFLOPS (TF32), pico de meia precisão teórica de 1.307,4 TFLOPS (FP16), pico de precisão do formato Bfloat16 (BF16) de 1.307,4 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 2.614,9 TFLOPS, desempenho do ponto de flutuação INT8 de 2.614,9 TOPs. É esperado que o MI300X seja capaz de aproveitar a dispersão da estrutura de granulação fina proporcionando uma melhoria estimada de 2x na eficiência matemática, resultando em pico teórico do TensorFloat-32 (TF32) de 1.307,4 TFLOPS, pico de meia precisão teórica (FP16) de 2.614,9 TFLOPS, pico de precisão do formato Bfloat16 (BF16) de 2.614,9 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 5.229,8 TFLOPS, desempenho do ponto de flutuação INT8 de 5.229,8 TOPs com dispersão. Os resultados publicados na GPU Nvidia H100 SXM (80GB) 700W resultaram em 989,4 TFLOPs de pico de TensorFloat-32 (TF32) com dispersão, 1.978,9 TFLOPS de pico de meia precisão teórica (FP16) com dispersão, 1.978,9 TFLOPS de pico teórico de precisão de formato Bfloat16 (BF16) com dispersão, 3.957,8 TFLOPS de pico teórico de precisão de 8 bits (FP8) com dispersão, 3.957,8 TOPs de pico teórico de INT8 com desempenho de ponto flutuante com dispersão. Fonte NVIDIA H100: https://resources.nvidia.com/en-us-tensor-core. MI300-17

- As medições realizadas pela AMD Performance Labs em 11 de novembro de 2023 na GPU AMD Instinct™ MI300X (750W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico de precisão dupla teórica de 163,4 TFLOPS (Matriz FP64), pico de precisão dupla teórica de 81,7 TFLOPS (FP64), matriz de pico de precisão única teórica de 163,4 TFLOPS (Matriz FP32), pico de precisão única teórica de 163,4 TFLOPS (FP32), pico teórico do TensorFloat-32 de 653,7 TFLOPS (TF32), pico de meia precisão teórica de 1307,4 TFLOPS (FP16), pico de precisão do formato Bfloat16 (BF16) de 1307,4 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 2614,9 TFLOPS, desempenho do ponto de flutuação INT8 de 2614,9 TOPs. Resultados publicados sobre a GPU NVIDIA H100 SXM (80 GB) resultaram em pico de precisão dupla teórica do tensor de 66,9 TFLOPS (FP64 Tensor), pico de precisão dupla teórica de 33,5 TFLOPS (FP64), pico de precisão única teórica de 66,9 TFLOPS (FP32), pico do TensorFloat-32 de 494,7 TFLOPS (TF32)*, pico de meia precisão do tensor de 989,4 TFLOPS (Tensor FP16), pico de meia precisão teórica de 133,8 TFLOPS (FP16), pico de precisão teórica do formato do tensor Bfloat16 de 989,4 TFLOPS (Tensor BF16), pico de precisão teórica do formato Bfloat16 de 133,8 TFLOPS (BF16), pico de precisão teórica de 8 bits de 1.978,9 TFLOPS (FP8), pico teórico do desempenho do ponto de flutuação INT8 de 1.978,9 TOPs. Fonte NVIDIA H100: https://resources.nvidia.com/en-us-tensor-core/. * As GPUs NVIDIA H100 não são compatíveis com Tensor FP32. MI300-18

- Cálculos conduzidos pelo AMD Performance Labs em 17 de novembro de 2023 para o acelerador AMD Instinct™ MI300X OAM de 750W (HBM3 de 192 GB), projetado com a tecnologia de processo AMD CDNA™ 3 5 nm FinFet, que resultou em capacidade de memória HBM3 de 192 GB e desempenho de largura de banda de memória de pico teórica de 5,325 TFLOPS. A interface do barramento de memória MI300X é de 8.192 bits, e a taxa de dados de memória é de 5,2 Gbps para largura de banda de memória de pico total de 5,325 TB/s (interface de barramento de memória de 8.192 bits * taxa de dados de memória de 5,2 Gbps/8). Os resultados mais altos publicados sobre o acelerador de GPU SXM NVIDIA Hopper H200 (141 GB) resultaram em capacidade de memória HBM3e de 141 GB e desempenho de largura de banda de memória GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446. Os resultados mais altos publicados sobre o acelerador de GPU SXM5 NVIDIA Hopper H100 (80 GB) resultaram em capacidade de memória HBM3 de 80 GB e desempenho de largura de banda de memória da GPU de 3,35 TB/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A

- As medições realizadas pela AMD Performance Labs em 18 de novembro de 2023 na GPU AMD Instinct™ MI300X (HBM3 de 192 GB) 750W projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHZ resultaram em pico de meia precisão teórica de 1.307,4 TFLOPS (FP16), pico de precisão teórica do formato Bfloat16 de 1.307,4 TFLOPS (BF16). É esperado que o MI300X seja capaz de aproveitar a dispersão da estrutura de granulação fina proporcionando uma melhoria estimada de 2x na eficiência matemática, resultando em pico de meia precisão teórica de 2.614,9 TFLOPS (FP16), pico de precisão teórica do formato Bfloat16 de 2.614,9 TFLOPS (BF16) e desempenho do ponto de flutuação com dispersão). Os resultados publicados sobre a GPU NVIDIA H100 SXM (HBM3 de 80GB) 700W resultaram em pico de meia precisão teórica de 1.978,9 (FP16) com dispersão, pico de precisão teórica do formato Bfloat16 de 1.978,9 TFLOPS (BF16) e desempenho do ponto de flutuação com dispersão. Fonte NVIDIA H100: https://resources.nvidia.com/en-us-tensor-core/. Os aceleradores AMD Instinct™ MI300X baseados na tecnologia AMD CDNA 3 incluem até oito links AMD Infinity Fabric fornecendo desempenho de largura de banda da taxa de transporte peer-to-peer (P2P) com pico teórico agregado de GPU de até 1.024 GB/s por placa de GPU OAM. MI300-25

- As medições realizadas pela AMD Performance Labs em 11 de novembro de 2023 na APU AMD Instinct™ MI300A (760W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5nm | 6nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico de precisão dupla teórica de 122,6 TFLOPS (Matriz FP64), pico de precisão dupla teórica de 61,3 TFLOPS (FP64), matriz de pico de precisão única teórica de 122,6 TFLOPS (Matriz FP32), pico de precisão única teórica de 122,6 TFLOPS (FP32), pico teórico do TensorFloat-32 de 490,3 TFLOPS (TF32), pico de meia precisão teórica de 980,6 TFLOPS (FP16), pico de precisão do formato Bfloat16 (BF16) de 980,6 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 1.961,2 TFLOPS, desempenho do ponto de flutuação INT8 de 1.961,2 TOPs. Os resultados calculados para o acelerador OAM HBM2e AMD Instinct™ MI250X (560W) de 128GB projetado com tecnologia de processo FinFET AMD CDNA™ de 2 5nm com aumento de pico do clock do mecanismo de 1.700 MHz resultaram em um pico de precisão dupla teórica 95,7 TFLOPS (Matriz FP64), pico de precisão dupla teórica de 47,9 TFLOPS (FP64), matriz de pico de precisão única teórica de 95,7 TFLOPS (Matriz FP32), pico de precisão única teórica de 47,9 TFLOPS (FP32), TF32* (N/A), pico de meia precisão teórica de 383,0 TFLOPS (FP16), pico de precisão teórica do formato Bfloat16 de 383,0 TFLOPS (BF16), FP8* (N/A), desempenho do ponto de flutuação INT8 de 383,0 TOPs. Os fabricantes de servidores podem variar as ofertas de configuração, produzindo resultados diferentes. * As GPUs da Série MI200 não suportam TF32, FP8 ou dispersão MI300-10

- As medições realizadas pela AMD Performance Labs em 11 de novembro de 2023 na APU AMD Instinct™ MI300A (750W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico teórico do TensorFloat-32 de 490,29 TFLOPS (TF32), pico de meia precisão teórica de 980,58 TFLOPS (FP16), pico de precisão do formato Bfloat16 (BF16) de 980,58 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 1.961,16 TFLOPS, desempenho do ponto de flutuação INT8 de 1.961,16 TOPs. É esperado que o MI300A seja capaz de aproveitar a dispersão da estrutura de granulação fina proporcionando uma melhoria estimada de 2x na eficiência matemática, resultando em pico teórico do TensorFloat-32 (TF32) de 980,58 TFLOPS, pico de meia precisão teórica (FP16) de 1.961,16 TFLOPS, pico de precisão do formato Bfloat16 (BF16) de 1.961,16 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 3.922,33 TFLOPS, desempenho do ponto de flutuação INT8 de 3.922,33 TOPs com dispersão. Os resultados publicados na GPU Nvidia H100 SXM5 (80 GB) resultaram em 989,4 TFLOPs de pico do núcleo do tensor TensorFloat-32 (TF32) com dispersão, 1.978,9 TFLOPS de pico teórico de meia precisão (FP16) do núcleo do tensor com dispersão, 1.978,9 TFLOPS de pico teórico de precisão de formato Bfloat16 (BF16) Núcleo do Tensor com dispersão, 3.957,8 TFLOPS de pico teórico de precisão de 8 bits (FP8) Núcleo do Tensor com dispersão, 3.957,8 TOPs de pico teórico de desempenho de ponto flutuante do INT8 Núcleo do Tensor com dispersão. Fonte NVIDIA H100: https://resources.nvidia.com/en-us-tensor-core/. Os fabricantes de servidores podem variar as ofertas de configuração, produzindo resultados diferentes. MI300-21

- As medições realizadas pela AMD Performance Labs em 11 de novembro de 2023 na GPU AMD Instinct™ MI300A (760W) projetada com tecnologia de processo FinFET do AMD CDNA™ de 3 5 nm | 6 nm com aumento de pico do clock do mecanismo de 2.100 MHz resultaram em pico de precisão dupla teórica de 122,6 TFLOPS (Matriz FP64), pico de precisão dupla teórica de 61,3 TFLOPS (FP64), matriz de pico de precisão única teórica de 122,6 TFLOPS (Matriz FP32), pico de precisão única teórica de 122,6 TFLOPS (FP32), pico teórico do TensorFloat-32 de 490,29 TFLOPS (TF32), pico de meia precisão teórica de 980,58 TFLOPS (FP16), pico de precisão do formato Bfloat16 (BF16) de 980,58 TFLOPS, pico de precisão teórica de 8 bits (FP8) de 1961,16 TFLOPS, desempenho do ponto de flutuação INT8 de 1961,16 TOPs. Resultados publicados sobre a GPU NVIDIA H100 SXM de 700W (80 GB) resultaram em pico de precisão dupla teórica do tensor de 66,9 TFLOPS (FP64 Tensor), pico de precisão dupla teórica de 33,5 TFLOPS (FP64), pico de precisão única teórica de 66,9 TFLOPS (FP32), pico do TensorFloat-32 de 494,7 TFLOPS (TF32)*, pico de meia precisão do tensor de 989,4 TFLOPS (Tensor FP16), pico de meia precisão teórica de 133,8 TFLOPS (FP16), pico de precisão teórica do formato do tensor Bfloat16 de 989,4 TFLOPS (Tensor BF16), pico de precisão teórica do formato Bfloat16 de 133,8 TFLOPS (BF16), pico de precisão teórica de 8 bits de 1.978,9 TFLOPS (FP8), pico teórico do desempenho do ponto de flutuação INT8 de 1.978,9 TOPs. Fonte NVIDIA H100: https://resources.nvidia.com/en-us-tensor-core/. Os fabricantes de servidores podem variar as ofertas de configuração, produzindo resultados diferentes. * As GPUs NVIDIA H100 não são compatíveis com Tensor FP32. MI300-20

- Cálculos conduzidos pelo AMD Performance Labs em 7 de novembro de 2023 para o acelerador AMD Instinct™ MI300A APU de 760W (HBM3 de 128 GB), projetado com a tecnologia de processo AMD CDNA™ 3 5 nm FinFet, que resultou em capacidade de memória HBM3 de 128 GB e desempenho de largura de banda de memória de pico teórica de 5,325 TFLOPS. A interface do barramento de memória MI300A é de 8.192 bits (1.024 bits x 8 die) e a taxa de dados de memória é de 5,2 Gbps para largura de banda de memória total máxima de 5,325 TB/s (interface de barramento de memória de 8.192 bits * taxa de dados de memória de 5,2 Gbps/8). Os resultados mais altos publicados sobre o acelerador de GPU SXM NVIDIA Hopper H200 (141 GB) resultaram em capacidade de memória HBM3e de 141 GB e desempenho de largura de banda de memória da GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446. Os resultados mais altos publicados sobre o acelerador de GPU SXM NVIDIA Hopper H100 (80 GB) resultaram em capacidade de memória HBM3 de 80 GB e desempenho de largura de banda de memória da GPU de 3,35 TB/s. Https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet. Os fabricantes de servidores podem variar as ofertas de configuração, produzindo resultados diferentes. MI300-12