加強 AI 與 HPC

AMD Instinct™ MI300 系列加速器非常適合驅動最嚴苛的 AI 與 HPC 工作負載,提供卓越的運算效能、高頻寬的高記憶體密度,並支援專門的資料格式。

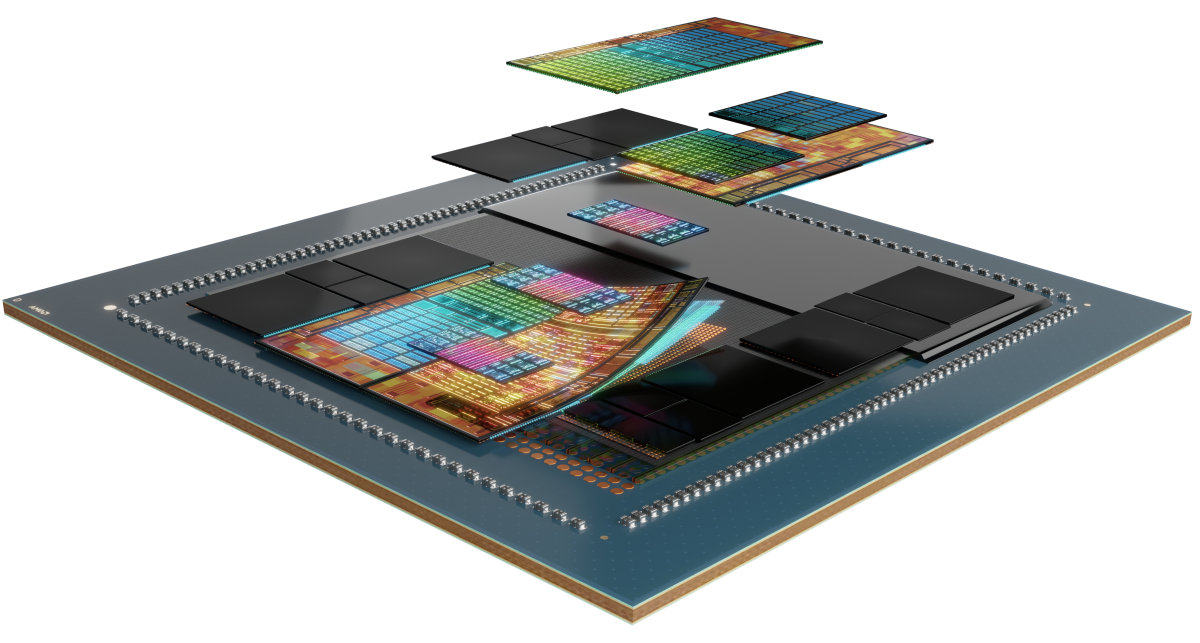

背後的秘密

AMD Instinct MI300 系列加速器是以 AMD CDNA™ 3 架構建置,提供矩陣核心技術並廣泛支援多種精度。從極高效率的 INT8 與 FP8(包括為 AI 提供稀疏性支援),到為 HPC 提供最嚴苛的 FP64,都能支援。

認識此系列

探索 AMD Instinct MI300 系列加速器、AMD Instinct MI300 系列平台,以及 AMD Instinct MI300A APU。

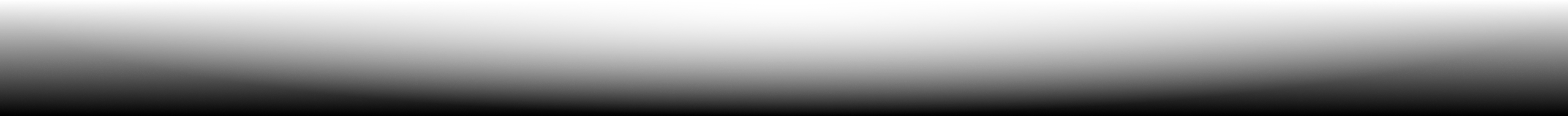

認識 AMD Instinct™ MI325X 加速器

AMD Instinct™ MI325X 顯示卡加速器採用第 3 代 AMD CDNA™ 架構,為訓練與推論提供驚人的效能與效率,樹立 AI 效能的全新標準。具備領先業界的 256 GB HBM3E 記憶體和 6 TB/s 頻寬,讓效能最佳化並有助於降低 TCO。1

304 個 CU

304 個顯示卡運算單元

256 GB

256 GB HBM3E 記憶體

6 TB/s

6 TB/s 峰值理論記憶體頻寬

規格比較

- AI 效能

- HPC 效能

- 記憶體

AI 效能(峰值 TFLOPs)

AI 效能最高達競品加速器的 1.3 倍2, 3

H200 SXM 141 GB

MI325X OAM 256 GB

HPC 效能(峰值 TFLOPs)

HPC 效能最高達競品加速器的 2.4 倍3

H200 SXM 141 GB

MI325X OAM 256 GB

記憶體容量與頻寬

記憶體容量是競品加速器的 1.8 倍,記憶體頻寬則是 1.2 倍1

H200 SXM 141 GB

MI325X OAM 256 GB

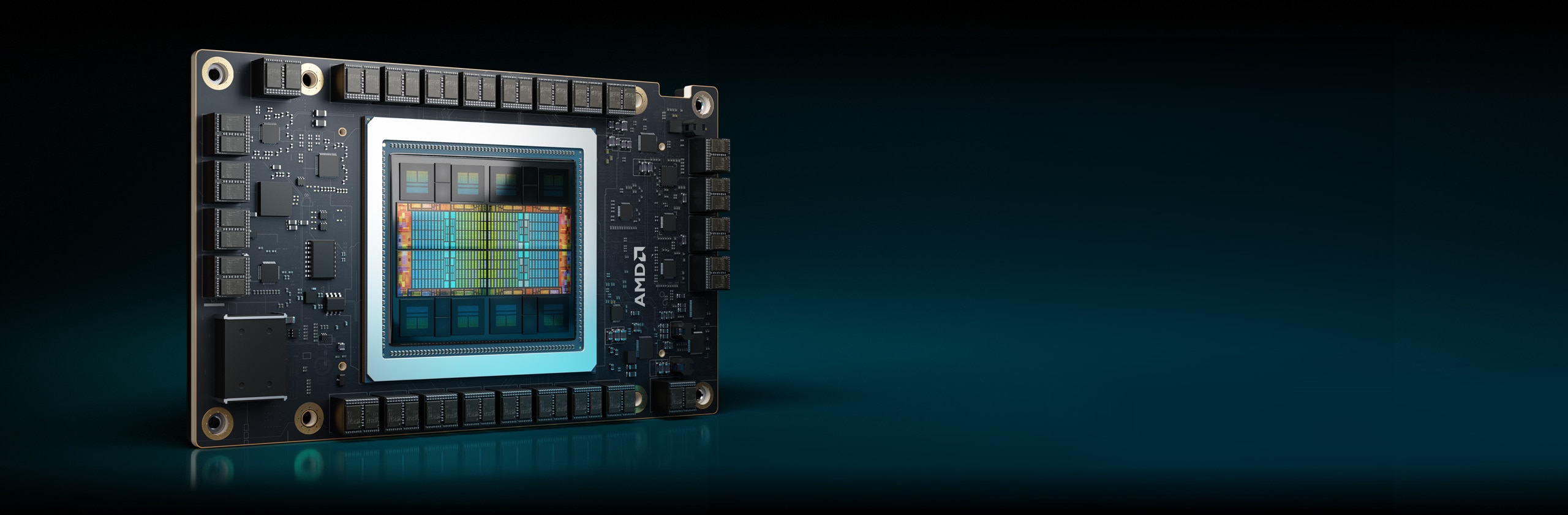

Instinct MI300X 加速器

AMD Instinct MI300X 系列加速器經過專門設計,能為生成式 AI 工作負載和 HPC 應用程式提供領先業界的效能。

304 個 CU

304 個顯示卡運算單元

192 GB

192 GB HBM3 記憶體

5.3 TB/s

5.3 TB/s 峰值理論記憶體頻寬

AI 效能(峰值 TFLOPs)

AI 效能最高達競品加速器的 1.3 倍6

HPC 效能(峰值 TFLOPs)

HPC 效能最高達競品加速器的 2.4 倍7

記憶體容量與頻寬

記憶體容量是競品加速器的 2.4 倍,峰值理論記憶體頻寬則是 1.6 倍8

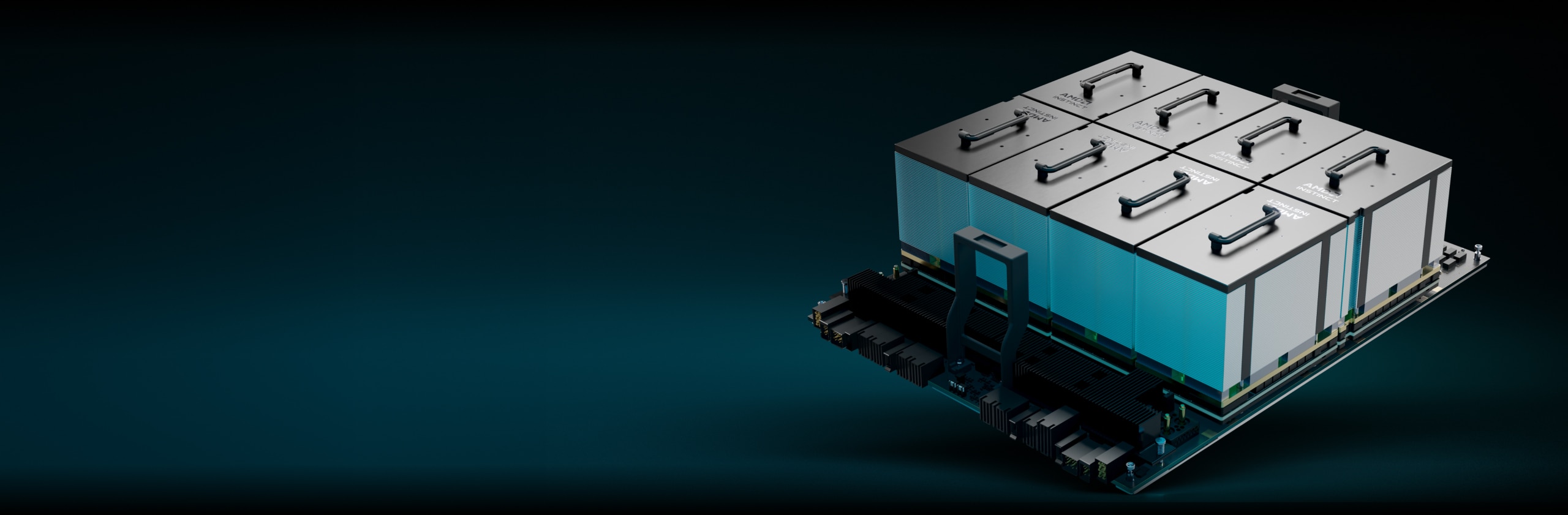

AMD Instinct 平台

AMD Instinct MI325X 平台透過第 4 代 AMD Infinity Fabric™ 連結,將 8 個完全連線的 MI325X 顯示卡 OAM 模組整合到業界標準的 OCP 設計上,提供高達 2TB 的 HBM3E 容量,實現低延遲的 AI 處理。在現有的 AI 機架和伺服器基礎架構中增加 MI325X 加速器時,這個可隨時部署的平台能縮短上市時間,並降低開發成本。

8 個 MI325X

8 個 MI325X 顯示卡 OAM 模組

2 TB

2 TB HBM3E 總記憶體

48 TB/s

48 TB/s 峰值理論總合記憶體頻寬

AMD Instinct MI300A APU

AMD Instinct MI300A 加速處理單元 (APU) 結合 AMD Instinct 加速器的威力與具有共用記憶體的 AMD EPYC™ 處理器,可強化效率、彈性及可程式化功能。其設計目標是加速聚合 AI 與 HPC,協助進行進階研究,並推動新的發現。

228 個 CU

228 個顯示卡運算單元

24

24 個 “Zen 4” x86 處理器核心

128 GB

128 GB 整合式 HBM3 記憶體

5.3 TB/s

5.3 TB/s 峰值理論記憶體頻寬

AI 效能(峰值 TFLOPs)11

HPC 效能(峰值 TFLOPs)

HPC 效能最高達競品加速器的 1.8 倍12

記憶體容量與頻寬

與競爭的加速器相較,記憶體容量提升 2.4 倍,峰值理論記憶體頻寬提升 1.6 倍13

推動百億億次級運算

AMD Instinct 加速器驅動數台全球頂尖的超級電腦,包括勞倫斯利佛摩國家實驗室的 El Capitan 系統。瞭解這部兩百億億次級超級電腦如何使用 AI 來執行首次模擬,並推動科學研究。

AMD ROCm™ 軟體

AMD ROCm™ 軟體包含豐富的程式設計模型、工具、編譯器、程式庫及執行階段,適用於 AMD Instinct 加速器所設計的 AI 模型和 HPC 工作負載。

案例研究

尋找解決方案

尋找提供搭載 AMD Instinct 加速器之解決方案的合作夥伴。

資源

掌握最新動態

註冊以收到最新的資料中心消息和伺服器內容。

尾註

- MI325-001A - AMD 效能實驗室於 2024 年 9 月 26 日根據目前的規格和/或評估進行的計算。AMD Instinct™ MI325X OAM 加速器將擁有 256GB HBM3E 記憶體容量和 6 TB/s 顯示卡峰值理論記憶體頻寬效能。實際結果視生產晶片而異。

NVidia Hopper H200 (141GB) SXM 顯示卡加速器的最高已公佈結果為 141GB HBM3E 記憶體容量和 4.8 TB/s 顯示卡記憶體頻寬效能。 https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

NVidia Blackwell HGX B100 (192GB) 700W 顯示卡加速器的最高已公佈結果為 192GB HBM3E 記憶體容量和 8 TB/s 顯示卡記憶體頻寬效能。

NVidia Blackwell HGX B200 (192GB) 顯示卡加速器的最高已公佈結果為 192GB HBM3E 記憶體容量和 8 TB/s 顯示卡記憶體頻寬效能。

Nvidia Blackwell 規格:https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy

- MI325-002 - AMD 效能實驗室於 2024 年 5 月 28 日對 AMD Instinct™ MI325X 顯示卡進行計算,計算結果為 1307.4 TFLOPS 峰值理論半精度 (FP16)、1307.4 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、2614.9 TFLOPS 峰值理論 8 位元精度 (FP8)、2614.9 TOPs INT8 浮點效能。實際效能會因最終規格和系統配置而不同。

Nvidia H200 SXM (141GB) 顯示卡的已發佈結果:989.4 TFLOPS 峰值理論半精度 Tensor (FP16 Tensor)、989.4 TFLOPS 峰值理論 Bfloat16 Tensor 格式精度 (BF16 Tensor)、1,978.9 TFLOPS 峰值理論 8 位元精度 (FP8)、1,978.9 TOPs 峰值理論 INT8 浮點效能。BFLOAT16 Tensor Core、FP16 Tensor Core、FP8 Tensor Core 和 INT8 Tensor Core 效能是根據 Nvidia 使用稀疏格式發佈的結果;為了進行比較,AMD 將這些數值除以 2 來轉換為非稀疏/密集格式,上方這些數值即為計算結果

Nvidia H200 資料來源: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 和 https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

附註:Nvidia H200 顯示卡的已發佈 FLOPs 效能與 H100 產品相同:https://resources.nvidia.com/en-us-tensor-core/。MI325-02

- MI325-008 - AMD 效能實驗室於 2024 年 10 月 2 日對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI325X (1000W) 顯示卡進行計算,計算結果為 163.4 TFLOPs 峰值理論雙精度矩陣(FP64 矩陣)、81.7 TFLOPs 峰值理論雙精度 (FP64)、163.4 TFLOPs 峰值理論單精度矩陣(FP32 矩陣)、163.4 TFLOPs 峰值理論單精度 (FP32)、653.7 TFLOPS 峰值理論 TensorFloat-32 (TF32)、1307.4 TFLOPS 峰值理論半精度 (FP16),實際效能會因最終規格和系統配置而不同。

Nvidia H200 SXM (141GB) 顯示卡的已發佈結果: 66.9 TFLOPs 峰值理論雙精度 Tensor (FP64 Tensor)、33.5 TFLOPs 峰值理論雙精度 (FP64)、66.9 TFLOPs 峰值理論單精度 (FP32)、494.7 TFLOPs 峰值 TensorFloat-32 (TF32)、989.5 TFLOPS 峰值理論半精度 Tensor (FP16 Tensor)。TF32 Tensor Core 效能是根據 Nvidia 使用稀疏格式發佈的結果;為了進行比較,AMD 將這些數值除以 2 來轉換為非稀疏/密集格式,上方這些數值即為計算結果。

Nvidia H200 資料來源: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 和 https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

附註:Nvidia H200 顯示卡的已發佈 FLOPs 效能與 H100 產品相同:https://resources.nvidia.com/en-us-tensor-core/。

*Nvidia H200 顯示卡不支援 FP32 Tensor。

- AMD 效能實驗室截至 2023 年 11 月 11 日為止對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300X (750W) 顯示卡 進行量測,結果為 653.7 TFLOPS 峰值理論 TensorFloat-32 (TF32)、1307.4 TFLOPS 峰值理論半精度 (FP16)、1307.4 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、2614.9 TFLOPS 峰值理論 8 位元精度 (FP8)、2614.9 TOPs INT8 浮點效能。MI300X 預期能運用精細的結構稀疏性優勢,實現數學效率的估計 2 倍改善,達到 1,307.4 TFLOPS 峰值理論 TensorFloat-32 (TF32)、2,614.9 TFLOPS 峰值理論半精度 (FP16)、2,614.9 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、5,229.8 TFLOPS 峰值理論 8 位元精度 (FP8)、5,229.8 TOPs INT8 稀疏浮點效能。對以 AMD CDNA™ 2 5 奈米 FinFET 製程技術所設計,1,700 MHz 峰值提升引擎時脈的 AMD Instinct™ MI250X (560W) 128GB HBM2e OAM 加速器進行計算,結果為 TF32* (N/A)、383.0 TFLOPS 峰值理論半精度 (FP16)、383.0 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、FP8* (N/A)、383.0 TOPs INT8 浮點效能。*AMD Instinct MI200 系列顯示卡不支援 TF32、FP8 或稀疏性。MI300-16

- AMD 效能實驗室截至 2023 年 6 月 2 日為止對目前規格及/或內部工程計算進行的內部量測。以 FP16 精準度執行或計算以判斷執行 Falcon-7B(70 億個、400 億個參數)、LLaMA(130 億個、330 億個參數)、OPT(660 億個參數)、GPT-3(1,750 億個參數)、BLOOM(1,760 個參數)和 PaLM(3,400 億個、5,400 個參數參數)模型所需之最少顯示卡數量的大型語言模型 (LLM)。採用定義的參數再加上 10% 額外負載,根據顯示卡專用記憶體大小與模型所需之記憶體的比較,所計算出來的估計值。需要有發佈的模型記憶體大小,有時是初步模型記憶體大小,才能進行計算。由於系統/零件可用性的緣故,因此 GPT-3、BLOOM 和 PaML 結果是使用 MI300X 估計。測試結果組態:AMD 實驗室系統,包含 1x EPYC 9654(96 核心)處理器與 1x AMD Instinct™ MI300X(192GB HBM3,OAM 模組)750W 加速器

結果(FP16 精準度):

型號

參數

所需總記憶體

須使用 MI300X

Falcon-7B

70 億個

15.4 GB

1 個實際值

LLaMA

130 億個

44 GB

1 個實際值

LLaMA

330 億個

72.5 GB

1 個實際值

Falcon-40B

400 億個

88 GB

1 個實際值

OPT

660 億個

145.2 GB

1 個實際值

GPT-3

1,750 億個

385 GB

3 個計算值

Bloom

1,760 億個

387.2 GB

3 個計算值

PaLM

3,400 億個

748 GB

4 個計算值

PaLM

5,400 億個

1188 GB

7 個計算值

計算的估計值可能會因最終模型大小而有不同;實際值與估計值可能會因所需的實際額外負荷及使用超過顯示卡記憶體之系統記憶體而有不同。伺服器製造商可能會改變配置,進而產生不同的結果。MI300-07

- AMD 效能實驗室截至 2023 年 11 月 11 日為止對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300X (750W) 顯示卡 進行量測,結果為 653.7 TFLOPS 峰值理論 TensorFloat-32 (TF32)、1307.4 TFLOPS 峰值理論半精度 (FP16)、1307.4 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、2614.9 TFLOPS 峰值理論 8 位元精度 (FP8)、2614.9 TOPs INT8 浮點效能。MI300X 預期能運用精細的結構稀疏性優勢,實現數學效率的估計 2 倍改善,達到 1,307.4 TFLOPS 峰值理論 TensorFloat-32 (TF32)、2,614.9 TFLOPS 峰值理論半精度 (FP16)、2,614.9 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、5,229.8 TFLOPS 峰值理論 8 位元精度 (FP8)、5,229.8 TOPs INT8 稀疏浮點效能。Nvidia H100 SXM (80GB) 700W 顯示卡的已發佈結果為 989.4 TFLOPs 峰值稀疏 TensorFloat-32 (TF32)、1,978.9 TFLOPS 稀疏峰值理論半精度 (FP16)、1,978.9 TFLOPS 稀疏峰值理論 Bfloat16 格式精度 (BF16)、3,957.8 TFLOPS 稀疏峰值理論 8 位元精度 (FP8)、3,957.8 TOPs 峰值理論 INT8 稀疏浮點效能。Nvidia H100 資料來源:https://resources.nvidia.com/en-us-tensor-core。MI300-17

- AMD 效能實驗室截至 2023 年 11 月 11 日為止對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300X (750W) 顯示卡進行量測,結果為 163.4 TFLOPs 峰值理論雙精度 (FP64 Matrix)、81.7 TFLOPs 峰值理論雙精度 (FP64)、163.4 TFLOPs 峰值理論單精度 (FP32 Matrix)、163.4 TFLOPs 峰值理論單精度 (FP32)、653.7 TFLOPS 峰值理論 TensorFloat-32 (TF32)、1307.4 TFLOPS 峰值理論半精度 (FP16)、1307.4 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、2614.9 TFLOPS 峰值理論 8 位元精度 (FP8)、2614.9 TOPs INT8 浮點效能。Nvidia H100 SXM (80GB) 顯示卡的已發布結果為 66.9 TFLOPs 峰值理論雙精度 tensor (FP64 Tensor)、33.5 TFLOPs 峰值理論雙精度 (FP64)、66.9 TFLOPs 峰值理論單精度 (FP32)、494.7 TFLOPs 峰值理論 TensorFloat-32 (TF32)*、989.4 TFLOPS 峰值理論半精度 tensor (FP16 Tensor)、133.8 TFLOPS 峰值理論半精度 (FP16)、989.4 TFLOPS 峰值理論 Bfloat16 tensor 格式精度 (BF16 Tensor)、133.8 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、1,978.9 TFLOPS 峰值理論 8 位元精度 (FP8)、1,978.9 TOPs 峰值理論 INT8 浮點效能。Nvidia H100 資料來源:https://resources.nvidia.com/en-us-tensor-core/ * Nvidia H100 顯示卡不支援 FP32 Tensor。MI300-18

- AMD 效能實驗室截至 2023 年 11 月 17 日為止對採用 AMD CDNA™ 3 5nm FinFet 製程技術的 AMD Instinct™ MI300X OAM 加速器 750W (192 GB HBM3) 進行的計算,計算結果為 192 GB HBM3 記憶體容量和 5.325 TFLOPS 峰值理論記憶體頻寬效能。MI300X 記憶體匯流排介面為 8,192,記憶體資料速率為 5.2 Gbps,總峰值記憶體頻寬為 5.325 TB/s(8,192 位元記憶體匯流排介面 * 5.2 Gbps 記憶體資料速率/8)。NVidia Hopper H200 (141GB) SXM 顯示卡加速器的最高已公佈結果為 141GB HBM3e 記憶體容量和 4.8 TB/s 顯示卡記憶體頻寬效能。https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 NVidia Hopper H100 (80GB) SXM 顯示卡加速器的最高已公佈結果為 80GB HBM3 記憶體容量和 3.35 TB/s 顯示卡記憶體頻寬效能。https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A

- AMD 效能實驗室截至 2023 年 11 月 18 日為止對使用 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300X (192 GB HBM3) 750W 顯示卡進行量測,結果為 1307.4 TFLOPS 峰值理論半精度 (FP16)、1307.4 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)。MI300X 預期能運用精細的結構稀疏性優勢,實現數學效率的估計 2 倍改善,達到 2,614.9 TFLOPS 峰值理論半精度 (FP16)、2,614.9 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16) 稀疏浮點效能。Nvidia H100 SXM (80GB HBM3) 700W 顯示卡的已發佈結果為 1,978.9 TFLOPS 稀疏峰值理論半精度 (FP16)、1,978.9 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16) 稀疏浮點效能。Nvidia H100 資料來源:https://resources.nvidia.com/en-us-tensor-core/ 採用 AMD Instinct™ MI300X AMD CDNA 3 技術的加速器包含最多八個 AMD Infinity Fabric 連結,提供每顯示卡 OAM 模組高達 1,024 GB/s 的峰值總計理論顯示卡對等 (P2P) 傳輸速率頻寬效能。MI300-25

- AMD 效能實驗室截至 2023 年 11 月 11 日為止對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300A (760W) APU 進行量測,結果為 122.6 TFLOPS 峰值理論雙精度 (FP64 Matrix)、61.3 TFLOPS 峰值理論雙精度 (FP64)、122.6 TFLOPS 峰值理論單精度 (FP32 Matrix)、122.6 TFLOPS 峰值理論單精度 (FP32)、490.3 TFLOPS 峰值理論 TensorFloat-32 (TF32)、980.6 TFLOPS 峰值理論半精度 (FP16)、980.6 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、1961.2 TFLOPS 峰值理論 8 位元精度 (FP8)、1961.2 TOPs INT8 浮點效能。對以 AMD CDNA™ 2 5 奈米 FinFET 製程技術所設計,1,700 MHz 峰值提升引擎時脈的 AMD Instinct™ MI250X (560W) 128GB HBM2e OAM 加速器計算,結果為 95.7 TFLOPS 峰值理論雙精度 (FP64 Matrix)、47.9 TFLOPS 峰值理論雙精度 (FP64)、95.7 TFLOPS 峰值理論單精度 (FP32 Matrix)、47.9 TFLOPS 峰值理論單精度 (FP32)、TF32* (N/A)、383.0 TFLOPS 峰值理論半精度 (FP16)、383.0 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、FP8* (N/A)、383.0 TOPs INT8 浮點效能。伺服器製造商可能會改變配置,進而產生不同的結果。* MI200 系列顯示卡不支援 TF32、FP8 或稀疏性。MI300-10

- AMD 效能實驗室截至 2023 年 11 月 11 日為止對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300A (750W) APU 進行量測,結果為 490.29 TFLOPS 峰值理論 TensorFloat-32 (TF32)、980.58 TFLOPS 峰值理論半精度 (FP16)、980.58 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、1961.16 TFLOPS 峰值理論 8 位元精度 (FP8)、1961.16 TOPs INT8 浮點效能。MI300A 預期能運用精細的結構稀疏性優勢,實現數學效率的估計 2 倍改善,達到 980.58 TFLOPS 峰值理論 TensorFloat-32 (TF32)、1,961.16 TFLOPS 峰值理論半精度 (FP16)、1,961.16 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、3,922.33 TFLOPS 峰值理論 8 位元精度 (FP8)、3,922.33 TOPs INT8 稀疏浮點效能。Nvidia H100 SXM5 (80GB) 顯示卡的已發佈結果為 989.4 TFLOPs 峰值稀疏 TensorFloat-32 (TF32) Tensor 核心、1,978.9 TFLOPS 稀疏峰值理論半精度 (FP16) Tensor 核心、1,978.9 TFLOPS 稀疏峰值理論 Bfloat16 格式精度 (BF16) Tensor 核心、3,957.8 TFLOPS 稀疏峰值理論 8 位元精度 (FP8) Tensor 核心、3,957.8 TOPs 峰值理論 INT8 Tensor 核心稀疏浮點效能。Nvidia H100 資料來源:https://resources.nvidia.com/en-us-tensor-core/ 伺服器製造商可能會改變配置,進而產生不同的結果。MI300-21

- AMD 效能實驗室截至 2023 年 11 月 11 日為止對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300A (760W) 顯示卡進行量測,結果為 122.6 TFLOPs 峰值理論雙精度 (FP64 Matrix)、61.3 TFLOPs 峰值理論雙精度 (FP64)、122.6 TFLOPs 峰值理論單精度 (FP32 Matrix)、122.6 TFLOPs 峰值理論單精度 (FP32)、490.29 TFLOPS 峰值理論 TensorFloat-32 (TF32)、980.58 TFLOPS 峰值理論半精度 (FP16)、980.58 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、1961.16 TFLOPS 峰值理論 8 位元精度 (FP8)、1961.16 TOPs INT8 浮點效能。Nvidia H100 SXM (80GB) 700W 顯示卡的已發布結果為 66.9 TFLOPs 峰值理論雙精度 tensor (FP64 Tensor)、33.5 TFLOPs 峰值理論雙精度 (FP64)、66.9 TFLOPs 峰值理論單精度 (FP32)、494.7 TFLOPs 峰值理論 TensorFloat-32 (TF32)*、989.4 TFLOPS 峰值理論半精度 tensor (FP16 Tensor)、133.8 TFLOPS 峰值理論半精度 (FP16)、989.4 TFLOPS 峰值理論 Bfloat16 tensor 格式精度 (BF16 Tensor)、133.8 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、1,978.9 TFLOPS 峰值理論 8 位元精度 (FP8)、1,978.9 TOPs 峰值理論 INT8 浮點效能。Nvidia H100 資料來源:https://resources.nvidia.com/en-us-tensor-core/ 伺服器製造商可能會改變配置,進而產生不同的結果。* Nvidia H100 顯示卡不支援 FP32 Tensor。MI300-20

- AMD 效能實驗室截至 2023 年 11 月 7 日為止對採用 AMD CDNA™ 3 5nm FinFet 製程技術的 AMD Instinct™ MI300A APU 加速器 760W (128 GB HBM3) 進行的計算,計算結果為 128 GB HBM3 記憶體容量和 5.325 TFLOPS 峰值理論記憶體頻寬效能。MI300A 記憶體匯流排介面為 8,192(1,024 位元 x 8 個裸晶),記憶體資料速率為 5.2 Gbps,峰值記憶體頻寬為 5.325 TB/s(8,192 位元記憶體匯流排介面 * 5.2 Gbps 記憶體資料速率/8)。NVidia Hopper H200 (141GB) SXM 顯示卡加速器的最高已公佈結果為 141GB HBM3e 記憶體容量和 4.8 TB/s 顯示卡記憶體頻寬效能。https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 NVidia Hopper H100 (80GB) SXM 顯示卡加速器的最高已公佈結果為 80GB HBM3 記憶體容量和 3.35 TB/s 顯示卡記憶體頻寬效能。https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet 伺服器製造商可能會改變配置,進而產生不同的結果。MI300-12

- MI325-001A - AMD 效能實驗室於 2024 年 9 月 26 日根據目前的規格和/或評估進行的計算。AMD Instinct™ MI325X OAM 加速器將擁有 256GB HBM3E 記憶體容量和 6 TB/s 顯示卡峰值理論記憶體頻寬效能。實際結果視生產晶片而異。

NVidia Hopper H200 (141GB) SXM 顯示卡加速器的最高已公佈結果為 141GB HBM3E 記憶體容量和 4.8 TB/s 顯示卡記憶體頻寬效能。 https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

NVidia Blackwell HGX B100 (192GB) 700W 顯示卡加速器的最高已公佈結果為 192GB HBM3E 記憶體容量和 8 TB/s 顯示卡記憶體頻寬效能。

NVidia Blackwell HGX B200 (192GB) 顯示卡加速器的最高已公佈結果為 192GB HBM3E 記憶體容量和 8 TB/s 顯示卡記憶體頻寬效能。

Nvidia Blackwell 規格:https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy - MI325-002 - AMD 效能實驗室於 2024 年 5 月 28 日對 AMD Instinct™ MI325X 顯示卡進行計算,計算結果為 1307.4 TFLOPS 峰值理論半精度 (FP16)、1307.4 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、2614.9 TFLOPS 峰值理論 8 位元精度 (FP8)、2614.9 TOPs INT8 浮點效能。實際效能會因最終規格和系統配置而不同。

Nvidia H200 SXM (141GB) 顯示卡的已發佈結果:989.4 TFLOPS 峰值理論半精度 Tensor (FP16 Tensor)、989.4 TFLOPS 峰值理論 Bfloat16 Tensor 格式精度 (BF16 Tensor)、1,978.9 TFLOPS 峰值理論 8 位元精度 (FP8)、1,978.9 TOPs 峰值理論 INT8 浮點效能。BFLOAT16 Tensor Core、FP16 Tensor Core、FP8 Tensor Core 和 INT8 Tensor Core 效能是根據 Nvidia 使用稀疏格式發佈的結果;為了進行比較,AMD 將這些數值除以 2 來轉換為非稀疏/密集格式,上方這些數值即為計算結果

Nvidia H200 資料來源: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 和 https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

附註:Nvidia H200 顯示卡的已發佈 FLOPs 效能與 H100 產品相同:https://resources.nvidia.com/en-us-tensor-core/。MI325-02 - MI325-008 - AMD 效能實驗室於 2024 年 10 月 2 日對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI325X (1000W) 顯示卡進行計算,計算結果為 163.4 TFLOPs 峰值理論雙精度矩陣(FP64 矩陣)、81.7 TFLOPs 峰值理論雙精度 (FP64)、163.4 TFLOPs 峰值理論單精度矩陣(FP32 矩陣)、163.4 TFLOPs 峰值理論單精度 (FP32)、653.7 TFLOPS 峰值理論 TensorFloat-32 (TF32)、1307.4 TFLOPS 峰值理論半精度 (FP16),實際效能會因最終規格和系統配置而不同。

Nvidia H200 SXM (141GB) 顯示卡的已發佈結果: 66.9 TFLOPs 峰值理論雙精度 Tensor (FP64 Tensor)、33.5 TFLOPs 峰值理論雙精度 (FP64)、66.9 TFLOPs 峰值理論單精度 (FP32)、494.7 TFLOPs 峰值 TensorFloat-32 (TF32)、989.5 TFLOPS 峰值理論半精度 Tensor (FP16 Tensor)。TF32 Tensor Core 效能是根據 Nvidia 使用稀疏格式發佈的結果;為了進行比較,AMD 將這些數值除以 2 來轉換為非稀疏/密集格式,上方這些數值即為計算結果。

Nvidia H200 資料來源: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 和 https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

附註:Nvidia H200 顯示卡的已發佈 FLOPs 效能與 H100 產品相同:https://resources.nvidia.com/en-us-tensor-core/。

*Nvidia H200 顯示卡不支援 FP32 Tensor。 - AMD 效能實驗室截至 2023 年 11 月 11 日為止對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300X (750W) 顯示卡 進行量測,結果為 653.7 TFLOPS 峰值理論 TensorFloat-32 (TF32)、1307.4 TFLOPS 峰值理論半精度 (FP16)、1307.4 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、2614.9 TFLOPS 峰值理論 8 位元精度 (FP8)、2614.9 TOPs INT8 浮點效能。MI300X 預期能運用精細的結構稀疏性優勢,實現數學效率的估計 2 倍改善,達到 1,307.4 TFLOPS 峰值理論 TensorFloat-32 (TF32)、2,614.9 TFLOPS 峰值理論半精度 (FP16)、2,614.9 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、5,229.8 TFLOPS 峰值理論 8 位元精度 (FP8)、5,229.8 TOPs INT8 稀疏浮點效能。對以 AMD CDNA™ 2 5 奈米 FinFET 製程技術所設計,1,700 MHz 峰值提升引擎時脈的 AMD Instinct™ MI250X (560W) 128GB HBM2e OAM 加速器進行計算,結果為 TF32* (N/A)、383.0 TFLOPS 峰值理論半精度 (FP16)、383.0 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、FP8* (N/A)、383.0 TOPs INT8 浮點效能。*AMD Instinct MI200 系列顯示卡不支援 TF32、FP8 或稀疏性。MI300-16

- AMD 效能實驗室截至 2023 年 6 月 2 日為止對目前規格及/或內部工程計算進行的內部量測。以 FP16 精準度執行或計算以判斷執行 Falcon-7B(70 億個、400 億個參數)、LLaMA(130 億個、330 億個參數)、OPT(660 億個參數)、GPT-3(1,750 億個參數)、BLOOM(1,760 個參數)和 PaLM(3,400 億個、5,400 個參數參數)模型所需之最少顯示卡數量的大型語言模型 (LLM)。採用定義的參數再加上 10% 額外負載,根據顯示卡專用記憶體大小與模型所需之記憶體的比較,所計算出來的估計值。需要有發佈的模型記憶體大小,有時是初步模型記憶體大小,才能進行計算。由於系統/零件可用性的緣故,因此 GPT-3、BLOOM 和 PaML 結果是使用 MI300X 估計。測試結果組態:AMD 實驗室系統,包含 1x EPYC 9654(96 核心)處理器與 1x AMD Instinct™ MI300X(192GB HBM3,OAM 模組)750W 加速器

結果(FP16 精準度):

型號 參數 所需總記憶體 須使用 MI300X Falcon-7B 70 億個 15.4 GB 1 個實際值 LLaMA 130 億個 44 GB 1 個實際值 LLaMA 330 億個 72.5 GB 1 個實際值 Falcon-40B 400 億個 88 GB 1 個實際值 OPT 660 億個 145.2 GB 1 個實際值 GPT-3 1,750 億個 385 GB 3 個計算值 Bloom 1,760 億個 387.2 GB 3 個計算值 PaLM 3,400 億個 748 GB 4 個計算值 PaLM 5,400 億個 1188 GB 7 個計算值 計算的估計值可能會因最終模型大小而有不同;實際值與估計值可能會因所需的實際額外負荷及使用超過顯示卡記憶體之系統記憶體而有不同。伺服器製造商可能會改變配置,進而產生不同的結果。MI300-07

- AMD 效能實驗室截至 2023 年 11 月 11 日為止對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300X (750W) 顯示卡 進行量測,結果為 653.7 TFLOPS 峰值理論 TensorFloat-32 (TF32)、1307.4 TFLOPS 峰值理論半精度 (FP16)、1307.4 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、2614.9 TFLOPS 峰值理論 8 位元精度 (FP8)、2614.9 TOPs INT8 浮點效能。MI300X 預期能運用精細的結構稀疏性優勢,實現數學效率的估計 2 倍改善,達到 1,307.4 TFLOPS 峰值理論 TensorFloat-32 (TF32)、2,614.9 TFLOPS 峰值理論半精度 (FP16)、2,614.9 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、5,229.8 TFLOPS 峰值理論 8 位元精度 (FP8)、5,229.8 TOPs INT8 稀疏浮點效能。Nvidia H100 SXM (80GB) 700W 顯示卡的已發佈結果為 989.4 TFLOPs 峰值稀疏 TensorFloat-32 (TF32)、1,978.9 TFLOPS 稀疏峰值理論半精度 (FP16)、1,978.9 TFLOPS 稀疏峰值理論 Bfloat16 格式精度 (BF16)、3,957.8 TFLOPS 稀疏峰值理論 8 位元精度 (FP8)、3,957.8 TOPs 峰值理論 INT8 稀疏浮點效能。Nvidia H100 資料來源:https://resources.nvidia.com/en-us-tensor-core。MI300-17

- AMD 效能實驗室截至 2023 年 11 月 11 日為止對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300X (750W) 顯示卡進行量測,結果為 163.4 TFLOPs 峰值理論雙精度 (FP64 Matrix)、81.7 TFLOPs 峰值理論雙精度 (FP64)、163.4 TFLOPs 峰值理論單精度 (FP32 Matrix)、163.4 TFLOPs 峰值理論單精度 (FP32)、653.7 TFLOPS 峰值理論 TensorFloat-32 (TF32)、1307.4 TFLOPS 峰值理論半精度 (FP16)、1307.4 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、2614.9 TFLOPS 峰值理論 8 位元精度 (FP8)、2614.9 TOPs INT8 浮點效能。Nvidia H100 SXM (80GB) 顯示卡的已發布結果為 66.9 TFLOPs 峰值理論雙精度 tensor (FP64 Tensor)、33.5 TFLOPs 峰值理論雙精度 (FP64)、66.9 TFLOPs 峰值理論單精度 (FP32)、494.7 TFLOPs 峰值理論 TensorFloat-32 (TF32)*、989.4 TFLOPS 峰值理論半精度 tensor (FP16 Tensor)、133.8 TFLOPS 峰值理論半精度 (FP16)、989.4 TFLOPS 峰值理論 Bfloat16 tensor 格式精度 (BF16 Tensor)、133.8 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、1,978.9 TFLOPS 峰值理論 8 位元精度 (FP8)、1,978.9 TOPs 峰值理論 INT8 浮點效能。Nvidia H100 資料來源:https://resources.nvidia.com/en-us-tensor-core/ * Nvidia H100 顯示卡不支援 FP32 Tensor。MI300-18

- AMD 效能實驗室截至 2023 年 11 月 17 日為止對採用 AMD CDNA™ 3 5nm FinFet 製程技術的 AMD Instinct™ MI300X OAM 加速器 750W (192 GB HBM3) 進行的計算,計算結果為 192 GB HBM3 記憶體容量和 5.325 TFLOPS 峰值理論記憶體頻寬效能。MI300X 記憶體匯流排介面為 8,192,記憶體資料速率為 5.2 Gbps,總峰值記憶體頻寬為 5.325 TB/s(8,192 位元記憶體匯流排介面 * 5.2 Gbps 記憶體資料速率/8)。NVidia Hopper H200 (141GB) SXM 顯示卡加速器的最高已公佈結果為 141GB HBM3e 記憶體容量和 4.8 TB/s 顯示卡記憶體頻寬效能。https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 NVidia Hopper H100 (80GB) SXM 顯示卡加速器的最高已公佈結果為 80GB HBM3 記憶體容量和 3.35 TB/s 顯示卡記憶體頻寬效能。https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A

- AMD 效能實驗室截至 2023 年 11 月 18 日為止對使用 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300X (192 GB HBM3) 750W 顯示卡進行量測,結果為 1307.4 TFLOPS 峰值理論半精度 (FP16)、1307.4 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)。MI300X 預期能運用精細的結構稀疏性優勢,實現數學效率的估計 2 倍改善,達到 2,614.9 TFLOPS 峰值理論半精度 (FP16)、2,614.9 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16) 稀疏浮點效能。Nvidia H100 SXM (80GB HBM3) 700W 顯示卡的已發佈結果為 1,978.9 TFLOPS 稀疏峰值理論半精度 (FP16)、1,978.9 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16) 稀疏浮點效能。Nvidia H100 資料來源:https://resources.nvidia.com/en-us-tensor-core/ 採用 AMD Instinct™ MI300X AMD CDNA 3 技術的加速器包含最多八個 AMD Infinity Fabric 連結,提供每顯示卡 OAM 模組高達 1,024 GB/s 的峰值總計理論顯示卡對等 (P2P) 傳輸速率頻寬效能。MI300-25

- AMD 效能實驗室截至 2023 年 11 月 11 日為止對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300A (760W) APU 進行量測,結果為 122.6 TFLOPS 峰值理論雙精度 (FP64 Matrix)、61.3 TFLOPS 峰值理論雙精度 (FP64)、122.6 TFLOPS 峰值理論單精度 (FP32 Matrix)、122.6 TFLOPS 峰值理論單精度 (FP32)、490.3 TFLOPS 峰值理論 TensorFloat-32 (TF32)、980.6 TFLOPS 峰值理論半精度 (FP16)、980.6 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、1961.2 TFLOPS 峰值理論 8 位元精度 (FP8)、1961.2 TOPs INT8 浮點效能。對以 AMD CDNA™ 2 5 奈米 FinFET 製程技術所設計,1,700 MHz 峰值提升引擎時脈的 AMD Instinct™ MI250X (560W) 128GB HBM2e OAM 加速器計算,結果為 95.7 TFLOPS 峰值理論雙精度 (FP64 Matrix)、47.9 TFLOPS 峰值理論雙精度 (FP64)、95.7 TFLOPS 峰值理論單精度 (FP32 Matrix)、47.9 TFLOPS 峰值理論單精度 (FP32)、TF32* (N/A)、383.0 TFLOPS 峰值理論半精度 (FP16)、383.0 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、FP8* (N/A)、383.0 TOPs INT8 浮點效能。伺服器製造商可能會改變配置,進而產生不同的結果。* MI200 系列顯示卡不支援 TF32、FP8 或稀疏性。MI300-10

- AMD 效能實驗室截至 2023 年 11 月 11 日為止對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300A (750W) APU 進行量測,結果為 490.29 TFLOPS 峰值理論 TensorFloat-32 (TF32)、980.58 TFLOPS 峰值理論半精度 (FP16)、980.58 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、1961.16 TFLOPS 峰值理論 8 位元精度 (FP8)、1961.16 TOPs INT8 浮點效能。MI300A 預期能運用精細的結構稀疏性優勢,實現數學效率的估計 2 倍改善,達到 980.58 TFLOPS 峰值理論 TensorFloat-32 (TF32)、1,961.16 TFLOPS 峰值理論半精度 (FP16)、1,961.16 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、3,922.33 TFLOPS 峰值理論 8 位元精度 (FP8)、3,922.33 TOPs INT8 稀疏浮點效能。Nvidia H100 SXM5 (80GB) 顯示卡的已發佈結果為 989.4 TFLOPs 峰值稀疏 TensorFloat-32 (TF32) Tensor 核心、1,978.9 TFLOPS 稀疏峰值理論半精度 (FP16) Tensor 核心、1,978.9 TFLOPS 稀疏峰值理論 Bfloat16 格式精度 (BF16) Tensor 核心、3,957.8 TFLOPS 稀疏峰值理論 8 位元精度 (FP8) Tensor 核心、3,957.8 TOPs 峰值理論 INT8 Tensor 核心稀疏浮點效能。Nvidia H100 資料來源:https://resources.nvidia.com/en-us-tensor-core/ 伺服器製造商可能會改變配置,進而產生不同的結果。MI300-21

- AMD 效能實驗室截至 2023 年 11 月 11 日為止對以 AMD CDNA™ 3 5 奈米 | 6 奈米 FinFET 製程技術所設計、2,100 MHz 峰值提升引擎時脈的 AMD Instinct™ MI300A (760W) 顯示卡進行量測,結果為 122.6 TFLOPs 峰值理論雙精度 (FP64 Matrix)、61.3 TFLOPs 峰值理論雙精度 (FP64)、122.6 TFLOPs 峰值理論單精度 (FP32 Matrix)、122.6 TFLOPs 峰值理論單精度 (FP32)、490.29 TFLOPS 峰值理論 TensorFloat-32 (TF32)、980.58 TFLOPS 峰值理論半精度 (FP16)、980.58 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、1961.16 TFLOPS 峰值理論 8 位元精度 (FP8)、1961.16 TOPs INT8 浮點效能。Nvidia H100 SXM (80GB) 700W 顯示卡的已發布結果為 66.9 TFLOPs 峰值理論雙精度 tensor (FP64 Tensor)、33.5 TFLOPs 峰值理論雙精度 (FP64)、66.9 TFLOPs 峰值理論單精度 (FP32)、494.7 TFLOPs 峰值理論 TensorFloat-32 (TF32)*、989.4 TFLOPS 峰值理論半精度 tensor (FP16 Tensor)、133.8 TFLOPS 峰值理論半精度 (FP16)、989.4 TFLOPS 峰值理論 Bfloat16 tensor 格式精度 (BF16 Tensor)、133.8 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16)、1,978.9 TFLOPS 峰值理論 8 位元精度 (FP8)、1,978.9 TOPs 峰值理論 INT8 浮點效能。Nvidia H100 資料來源:https://resources.nvidia.com/en-us-tensor-core/ 伺服器製造商可能會改變配置,進而產生不同的結果。* Nvidia H100 顯示卡不支援 FP32 Tensor。MI300-20

- AMD 效能實驗室截至 2023 年 11 月 7 日為止對採用 AMD CDNA™ 3 5nm FinFet 製程技術的 AMD Instinct™ MI300A APU 加速器 760W (128 GB HBM3) 進行的計算,計算結果為 128 GB HBM3 記憶體容量和 5.325 TFLOPS 峰值理論記憶體頻寬效能。MI300A 記憶體匯流排介面為 8,192(1,024 位元 x 8 個裸晶),記憶體資料速率為 5.2 Gbps,峰值記憶體頻寬為 5.325 TB/s(8,192 位元記憶體匯流排介面 * 5.2 Gbps 記憶體資料速率/8)。NVidia Hopper H200 (141GB) SXM 顯示卡加速器的最高已公佈結果為 141GB HBM3e 記憶體容量和 4.8 TB/s 顯示卡記憶體頻寬效能。https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 NVidia Hopper H100 (80GB) SXM 顯示卡加速器的最高已公佈結果為 80GB HBM3 記憶體容量和 3.35 TB/s 顯示卡記憶體頻寬效能。https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet 伺服器製造商可能會改變配置,進而產生不同的結果。MI300-12