KI und HPC auf ein neues Level bringen

AMD Instinct™ MI300-Serie Beschleuniger sind hervorragend geeignet, um selbst die anspruchsvollsten KI- und HPC-Auslastungen zu bewältigen, und bieten eine außergewöhnliche Rechenleistung, große Speicherdichte mit hoher Bandbreite und Unterstützung für spezielle Datenformate.

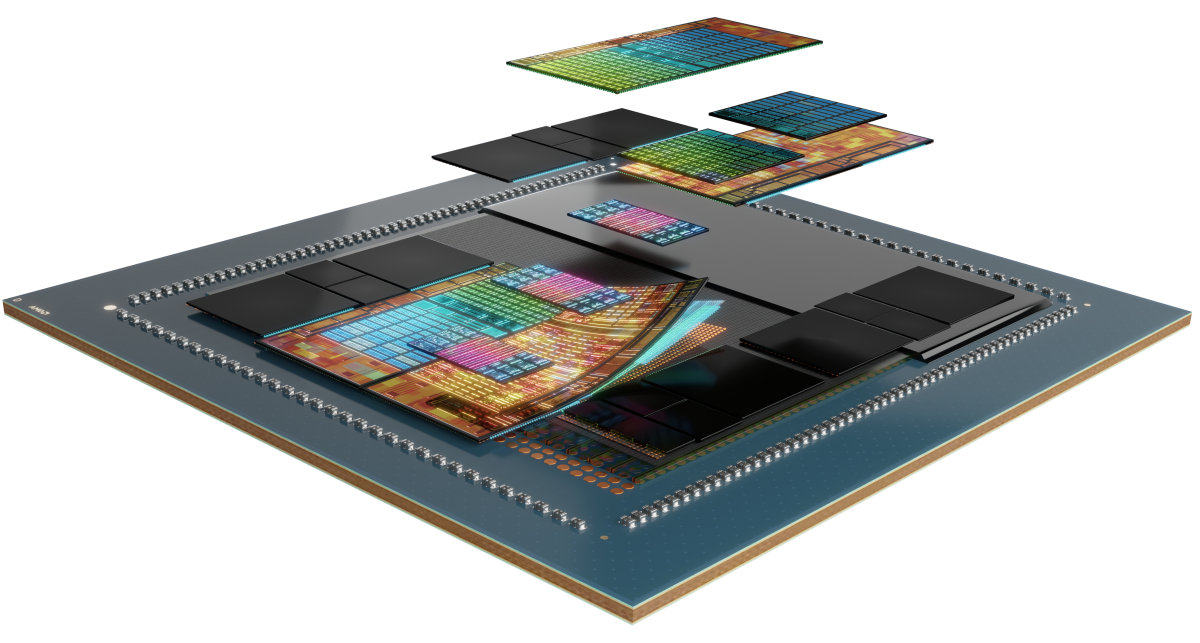

Unter der Haube

AMD Instinct MI300-Serie Beschleuniger basieren auf der AMD CDNA™ 3 Architektur mit Matrix-Core-Technologien und Unterstützung für eine Vielzahl von Genauigkeiten – von hocheffizienten INT8 und FP8 (mit Sparsity-Unterstützung für KI) bis zu anspruchsvollsten FP64 für HPC.

Serie kennenlernen

Entdecken Sie die AMD Instinct MI300-Serie Beschleuniger, AMD Instinct MI300-Serie Plattformen und AMD Instinct MI300A APU.

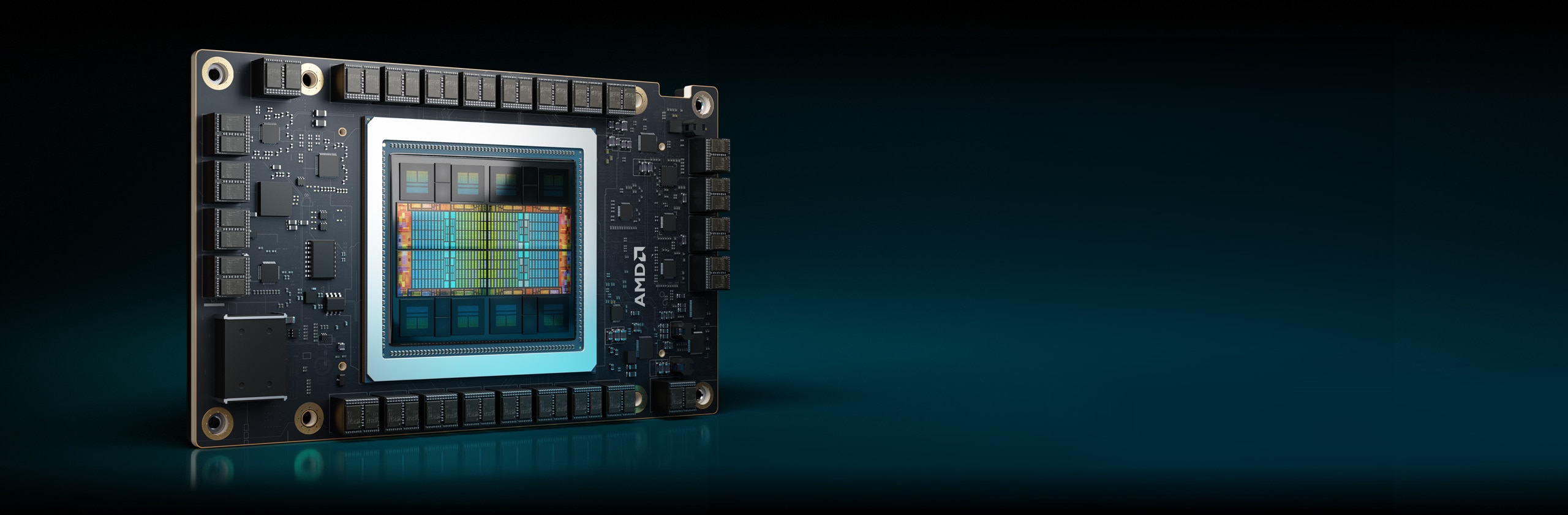

Wir stellen vor: Die AMD Instinct™ MI325X Beschleuniger

Der AMD Instinct™ MI325X GPU-Beschleuniger setzt mit der AMD CDNA™ Architektur der 3. Generation neue Maßstäbe in der KI-Leistung und bietet unglaubliche Performance und Effizienz für Training und Inferenz. Mit einem branchenführenden HBM3E-Speicher mit 256 GB und einer Bandbreite von bis zu 6 TB/s optimieren sie die Performance und tragen zur Senkung der Gesamtbetriebskosten bei.1

304 CUs

304 GPU Recheneinheiten

256 GB

256 GB HBM3E-Speicher

6 TB/s

6 TB/s theoretische maximale Speicherbandbreite

Vergleiche der Spezifikationen

- KI-Performance

- HPC-Performance

- Speicher

KI-Performance (max. TFLOPs)

Bis zu 1,3-fache KI-Performance im Vergleich zu Beschleunigern der Konkurrenz2, 3

H200 SXM 141 GB

MI325X OAM 256 GB

HPC-Performance (max. TFLOPs)

Bis zu 2,4-fache HPC-Performance im Vergleich zu Beschleunigern der Konkurrenz3

H200 SXM 141 GB

MI325X OAM 256 GB

Speicherkapazität und -bandbreite

1,8-fache Speicherkapazität und 1,2-fache Speicherbandbreite im Vergleich zu Beschleunigern der Konkurrenz1

H200 SXM 141 GB

MI325X OAM 256 GB

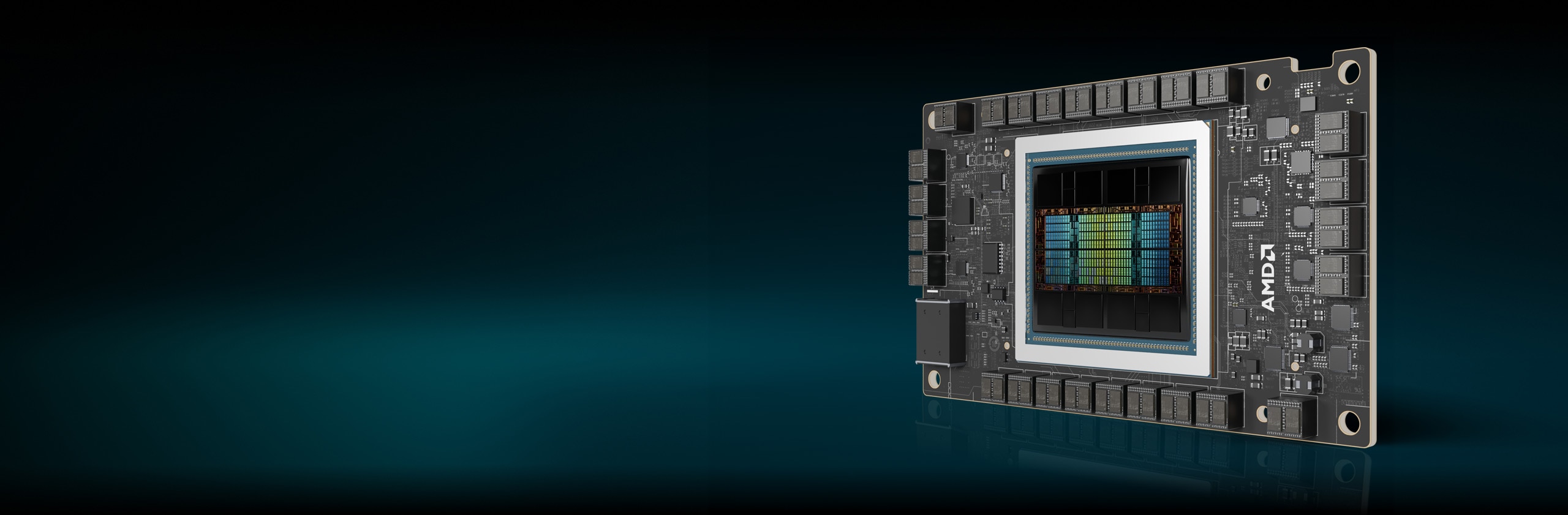

Instinct MI300X Beschleuniger

AMD Instinct MI300X-Serie Beschleuniger sind so konzipiert, dass sie führende Performance für generative KI-Auslastungen und HPC-Anwendungen bereitstellen.

304 CUs

304 GPU Recheneinheiten

192 GB

192 GB HBM3-Speicher

5,3 TB/s

5,3 TB/s theoretische maximale Speicherbandbreite

KI-Performance (max. TFLOPs)

Bis zu 1,3-fache KI-Performance im Vergleich zu Beschleunigern der Konkurrenz6

HPC-Performance (max. TFLOPs)

Bis zu 2,4-fache HPC-Performance im Vergleich zu Beschleunigern der Konkurrenz7

Speicherkapazität und -bandbreite

2,4-fache Speicherkapazität und 1,6-fache theoretische max. Speicherbandbreite im Vergleich zu Beschleunigern der Konkurrenz8

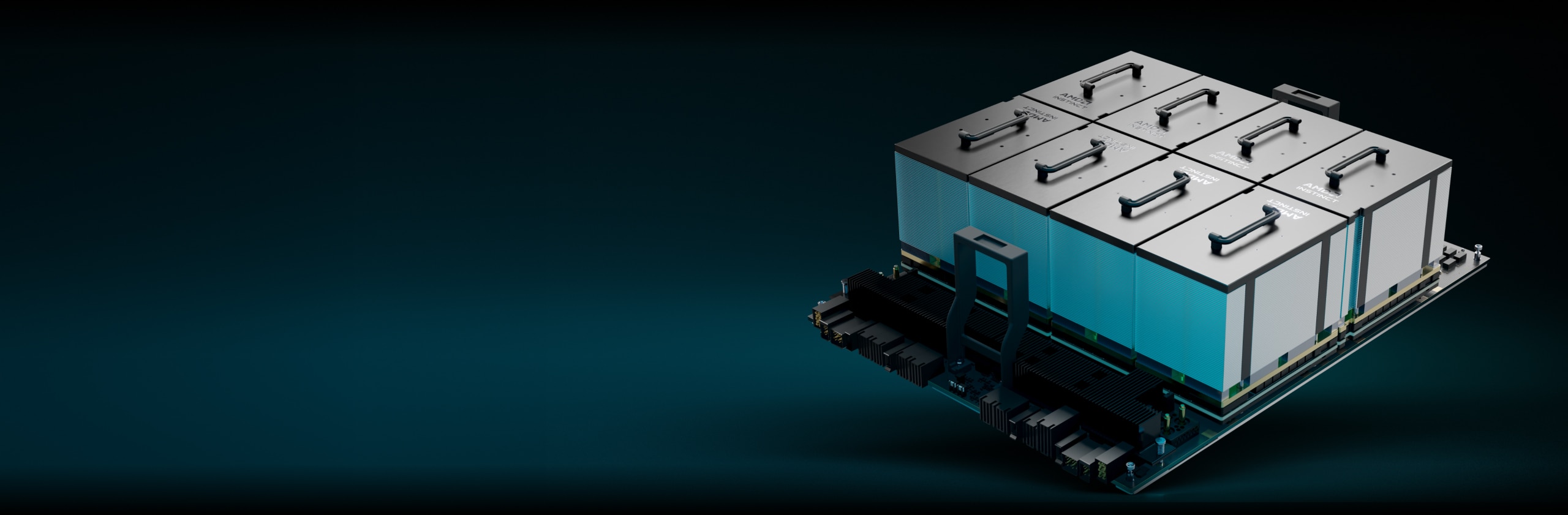

AMD Instinct Plattformen

Die AMD Instinct MI325X Plattform integriert 8 vollständig verbundene MI325X GPU OAM-Module in ein OCP-Design nach Branchenstandard über AMD Infinity Fabric™ Verknüpfungen der 4. Generation und liefert so bis zu 2 TB HBM3E-Kapazität für KI-Verarbeitung mit niedriger Latenz. Diese sofort einsatzbereite Plattform kann die Markteinführungszeit beschleunigen und die Entwicklungskosten reduzieren, wenn MI325X Beschleuniger einer bestehenden KI-Rack- und Serverinfrastruktur hinzugefügt werden.

8 MI325X

8 MI325X GPU OAM-Module

2 TB

2 TB HBM3E-Speicher gesamt

48 TB/s

48 TB/s theoretische maximale Speicherbandbreite (aggregiert)

AMD Instinct MI300A APUs

AMD Instinct MI300A beschleunigte Prozessoreinheiten (APUs) kombinieren die Leistung von AMD Instinct Beschleunigern und AMD EPYC™ Prozessoren mit gemeinsam genutztem Speicher, um erweiterte Effizienz, Flexibilität und Programmierbarkeit zu ermöglichen. Sie sollen die Konvergenz von KI und HPC beschleunigen und so die Forschung und neue Entdeckungen voranbringen.

228 CUs

228 GPU Recheneinheiten

24

24 „Zen 4“ x86-CPU-Kerne

128 GB

128 GB HBM3 Speicher vereinheitlicht

5,3 TB/s

5,3 TB/s theoretische maximale Speicherbandbreite

KI-Performance (max. TFLOPs)11

HPC-Performance (max. TFLOPs)

Bis zu 1,8-fache HPC-Performance im Vergleich zu Beschleunigern der Konkurrenz12

Speicherkapazität und -bandbreite

2,4-fache Speicherkapazität und 1,6-fache theoretische max. Speicherbandbreite im Vergleich zu Beschleunigern der Konkurrenz13

Exascale-Computing voranbringen

AMD Instinct Beschleuniger werden in einigen der weltweit besten Supercomputer eingesetzt, u. a. dem System El Capitan von Lawrence Livermore National Laboratory. Erfahren Sie, wie dieser Zwei-Exascale-Supercomputer KI nutzt, um neuartige Simulationen durchzuführen und die wissenschaftliche Forschung voranzutreiben.

AMD ROCm™ Software

AMD ROCm™ Software beinhaltet ein breites Spektrum an Programmierungsmodellen, Tools, Compilern, Bibliotheken und Laufzeiten für KI-Modelle und HPC-Auslastungen, die auf AMD Instinct Beschleuniger ausgerichtet sind.

Fallstudien

Lösungen finden

Partner finden, die Lösungen mit AMD Instinct Beschleunigern anbieten.

Ressourcen

Immer informiert bleiben

Melden Sie sich an und erhalten Sie alle Neuigkeiten über Rechenzentren und Server.

Fußnoten

- MI325-001A – Berechnungen durchgeführt vom AMD Leistungslabor am 26. September 2024 basierend auf aktuellen Spezifikationen und/oder Schätzungen. Der AMD Instinct™ MI325X OAM Beschleuniger wird über eine HBM3E-Speicherkapazität von 256 GB und eine theoretische GPU-Speicherbandbreite von 6 TB/s verfügen. Die tatsächlichen Ergebnisse auf Basis von Chips aus der Produktion können abweichen.

Die höchsten veröffentlichten Ergebnisse für den Nvidia Hopper H200 (141 GB) SXM-GPU-Beschleuniger ergaben eine Speicherkapazität von 141 GB HBM3E und eine GPU-Speicherbandbreite von 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Die höchsten veröffentlichten Ergebnisse für den Nvidia Blackwell HGX B100 (192 GB) 700-W-GPU-Beschleuniger ergaben eine HBM3E-Speicherkapazität von 192 GB und eine GPU-Speicherbandbreiten-Performance von 8 TB/s.

Die höchsten veröffentlichten Ergebnisse für den Nvidia Blackwell HGX B200 (192 GB) GPU-Beschleuniger ergaben eine HBM3E-Speicherkapazität von 192 GB und eine GPU-Speicherbandbreiten-Performance von 8 TB/s.

Nvidia Blackwell-Spezifikationen unter https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy

- MI325-002 – Die vom AMD Leistungslabor am 28. Mai 2024 durchgeführten Berechnungen für die AMD Instinct™ MI325X GPU ergaben 1.307,4 TFLOPS theoretische Halbpräzision (FP16), 1.307,4 TFLOPS theoretische Spitzenpräzision im Bfloat16-Format (BF16), 2.614,9 TFLOPS theoretische Spitzenpräzision mit 8 Bit (FP8), 2.614,9 TOPs INT8-Gleitkommaleistung. Die tatsächliche Performance hängt von den endgültigen Spezifikationen und der Systemkonfiguration ab.

Veröffentlichte Ergebnisse für Nvidia H200 SXM (141 GB) GPU: 989,4 TFLOPS theoretische Spitzenleistung bei halber Genauigkeit des Tensors (FP16-Tensor), 989,4 TFLOPS theoretische Spitzenleistung bei Bfloat16-Tensorformat-Genauigkeit (BF16-Tensor), 1.978,9 TFLOPS theoretische Spitzenleistung bei 8-Bit-Genauigkeit (FP8), 1.978,9 TOPs theoretische Spitzenleistung bei INT8-Gleitkommaleistung. Die Performance von BFLOAT16 Tensor Core, FP16 Tensor Core, FP8 Tensor Core und INT8 Tensor Core wurde von Nvidia unter Verwendung von Sparsity veröffentlicht. Zum Vergleich hat AMD diese Zahlen durch Division durch 2 in Nicht-Sparsity/Dense umgewandelt. Diese Zahlen sind oben aufgeführt.

Quelle Nvidia H200: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 und https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Hinweis: Nvidia H200 GPUs haben die gleiche veröffentlichte FLOPs-Performance wie H100-Produkte https://resources.nvidia.com/en-us-tensor-core/. MI325-02

- MI325-008 – Die vom AMD Leistungslabor am 2. Oktober 2024 durchgeführten Berechnungen für die AMD Instinct™ MI325X (1000 W) GPU, die mit der AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei 2.100 MHz Spitzen-Boost-Speichertakt entwickelt wurde, ergaben 163,4 TFLOPs theoretische Spitzen-Matrix mit doppelter Genauigkeit (FP64-Matrix), 81,7 TFLOPs theoretischer Spitzenwert mit doppelter Genauigkeit (FP64), 163,4 TFLOPs theoretische Spitzen-Matrix mit einfacher Genauigkeit (FP32-Matrix), 163,4 TFLOPs theoretischer Spitzenwert bei einfacher Genauigkeit (FP32), 653,7 TFLOPS theoretischer Spitzenwert bei TensorFloat-32 (TF32), 1.307,4 TFLOPS theoretischer Spitzenwert bei halber Genauigkeit (FP16). Die tatsächliche Performance kann je nach endgültigen Spezifikationen und Systemkonfiguration variieren.

Veröffentlichte Ergebnisse für Nvidia H200 SXM (141 GB) GPU: 66,9 TFLOPs theoretische Spitzenleistung bei doppelter Genauigkeit Tensor (FP64-Tensor), 33,5 TFLOPs theoretische Spitzenleistung bei doppelter Genauigkeit (FP64), 66,9 TFLOPs theoretische Spitzenleistung bei einfacher Genauigkeit (FP32), 494,7 TFLOPs Spitzenleistung TensorFloat-32 (TF32), 989,5 TFLOPS theoretische Spitzenleistung bei halber Genauigkeit Tensor (FP16-Tensor). Die Performance des TF32-Tensor-Core wurde von Nvidia unter Verwendung von Sparsity veröffentlicht. Zum Vergleich hat AMD diese Zahlen durch Division durch 2 in Nicht-Sparsity/Dense umgewandelt. Diese Zahl ist oben aufgeführt.

Quelle Nvidia H200: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 und https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Hinweis: Nvidia H200 GPUs haben die gleiche veröffentlichte FLOPs-Performance wie H100-Produkte https://resources.nvidia.com/en-us-tensor-core/.

* Nvidia H200 GPUs unterstützen nicht FP32 Tensor.

- Messungen durchgeführt vom AMD Leistungslabor am 11. November 2023, für die AMD Instinct™ MI300X (750 W) GPU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 653,7 TFLOPS TensorFloat-32 (TF32), max. 1.307,4 TFLOPS mit halber Genauigkeit (FP16), max. 1.307,4 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 2.614,9 TFLOPS mit 8-Bit-Genauigkeit (FP8), 2.614,9 TOPs INT8. Es wird erwartet, dass der MI300X in der Lage ist, die Vorteile der genauen Structure Sparsity zu nutzen, was eine geschätzte 2-fache Verbesserung der mathematischen Effizienz ermöglicht, die folgende theoretische Gleitkommaleistung mit Sparsity ergibt: max. 1.307,4 TFLOPS TensorFloat-32 (TF32), max. 2.614,9 TFLOPS mit halber Genauigkeit (FP16), max. 2.614,9 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 5.229,8 TFLOPS mit 8-Bit-Genauigkeit (FP8), 5.229,8 TOPs INT8. Die Ergebnisse für den AMD Instinct™ MI250X (560 W) 128 GB HBM2e OAM-Beschleuniger mit AMD CDNA™ 2 5-nm-FinFET-Prozesstechnologie bei max. 1.700 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: TF32* (N/A), max. 383,0 TFLOPS mit halber Genauigkeit (FP16), max. 383,0 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), FP8* (N/A), 383,0 TOPs INT8. * AMD Instinct MI200-Serie GPUs unterstützen nicht TF32, FP8 oder Sparsity. MI300-16

- Messungen durchgeführt vom internen AMD Leistungslabor am 2. Juni 2023 anhand aktueller Spezifikationen und/oder interner technischer Berechnungen. Large Language Model (LLM) ausgeführt oder berechnet mit FP16 Genauigkeit, um die Mindestanzahl von GPUs zu ermitteln, die zur Ausführung der Modelle Falcon-7B (7B, 40B Parameter), LLaMA (13B, 33B Parameter), OPT (66B Parameter), GPT-3 (175B Parameter), BLOOM (176B Parameter) und PaLM (340B, 540B Parameter) erforderlich sind. Berechnete Schätzungen basieren auf der Größe des reinen GPU-Speichers im Vergleich zum Speicherbedarf des Modells bei definierten Parametern plus 10 % Overhead. Die Berechnungen beruhen auf veröffentlichten und mitunter vorläufigen Modellspeichergrößen. GPT-3, BLOOM und PaLM Ergebnisse geschätzt auf MI300X aufgrund der System-/Teileverfügbarkeit. Getestete Ergebniskonfigurationen: AMD Lab System bestehend aus 1 x EPYC 9654 (96 Kerne) CPU mit 1 x AMD Instinct™ MI300X (192 GB HBM3, OAM-Modul) 750 W Beschleuniger

Ergebnisse (FP16 Genauigkeit):

Modell

Parameter

Gesamtspeicher erforderlich

MI300X erforderlich

Falcon-7B

7 Milliarden

15,4 GB

1 Tatsächlich

LLaMA

13 Milliarden

44 GB

1 Tatsächlich

LLaMA

33 Milliarden

72,5 GB

1 Tatsächlich

Falcon-40B

40 Milliarden

88 GB

1 Tatsächlich

OPT

66 Milliarden

145,2 GB

1 Tatsächlich

GPT-3

175 Milliarden

385 GB

3 Berechnet

Bloom

176 Milliarden

387,2 GB

3 Berechnet

PaLM

340 Milliarden

748 GB

4 Berechnet

PaLM

540 Milliarden

1188 GB

7 Berechnet

Die berechneten Schätzungen können je nach endgültiger Modellgröße variieren; die tatsächlichen und die geschätzten Werte können aufgrund des tatsächlich erforderlichen Overheads und der Verwendung von Systemspeicher über den der GPU hinaus variieren. Serverhersteller können abweichende Konfigurationen anbieten, was zu anderen Ergebnissen führen kann. MI300-07

- Messungen durchgeführt vom AMD Leistungslabor am 11. November 2023, für die AMD Instinct™ MI300X (750 W) GPU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 653,7 TFLOPS TensorFloat-32 (TF32), max. 1.307,4 TFLOPS mit halber Genauigkeit (FP16), max. 1.307,4 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 2.614,9 TFLOPS mit 8-Bit-Genauigkeit (FP8), 2.614,9 TOPs INT8. Es wird erwartet, dass der MI300X in der Lage ist, die Vorteile der genauen Structure Sparsity zu nutzen, was eine geschätzte 2-fache Verbesserung der mathematischen Effizienz ermöglicht, die folgende theoretische Gleitkommaleistung mit Sparsity ergibt: max. 1.307,4 TFLOPS TensorFloat-32 (TF32), max. 2.614,9 TFLOPS mit halber Genauigkeit (FP16), max. 2.614,9 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 5.229,8 TFLOPS mit 8-Bit-Genauigkeit (FP8), 5.229,8 TOPs INT8. Veröffentlichte Ergebnisse auf Nvidia H100 SXM (80 GB) 700 W GPU ergaben eine theoretische Gleitkommaleistung von max. 989,4 TFLOPs TensorFloat-32 (TF32) mit Sparsity, max. 1.978,9 TFLOPS mit halber Genauigkeit (FP16) mit Sparsity, max. 1.978,9 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16) mit Sparsity, max. 3.957,8 TFLOPS 8-Bit-Genauigkeit (FP8) mit Sparsity, max. 3.957,8 TOPs INT8 mit Sparsity. Quelle Nvidia H100: https://resources.nvidia.com/en-us-tensor-core. MI300-17

- Messungen durchgeführt vom AMD Leistungslabor am 11. November 2023, für die AMD Instinct™ MI300X (750 W) GPU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 163,4 TFLOPS mit doppelter Genauigkeit Matrix (FP64 Matrix), max. 81,7 TFLOPS mit doppelter Genauigkeit (FP64), max. 163,4 TFLOPS mit einfacher Genauigkeit Matrix (FP32 Matrix), max. 163,4 TFLOPS mit einfacher Genauigkeit (FP32), max. 653,7 TFLOPS TensorFloat-32 (TF32), max. 1.307,4 TFLOPS mit halber Genauigkeit (FP16), max. 1.307,4 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 2.614,9 TFLOPS mit 8-Bit-Genauigkeit (FP8), 2.614,9 TOPs INT8. Veröffentlichte Ergebnisse auf der Nvidia H100 SXM (80 GB) GPU ergaben folgende theoretische Gleitkommaleistung: max. 66,9 TFLOPs mit doppelter Genauigkeit (FP64 Tensor), max. 33,5 TFLOPs mit doppelter Genauigkeit (FP64), max. 66,9 TFLOPs mit einfacher Genauigkeit (FP32), max. 494,7 TFLOPs TensorFloat-32 (TF32)*, max. 989,4 TFLOPS mit halber Genauigkeit (FP16 Tensor), max. 133,8 TFLOPS mit halber Genauigkeit (FP16), max. 989,4 TFLOPS mit Bfloat16-Tensor-Format-Genauigkeit (BF16 Tensor), max. 133,8 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 1.978,9 TFLOPS mit 8-Bit-Genauigkeit (FP8), max. 1.978,9 TOPs INT8. Nvidia H100 Quelle: https://resources.nvidia.com/en-us-tensor-core/ * Nvidia H100 GPUs unterstützen nicht FP32 Tensor. MI300-18

- Berechnungen durchgeführt vom AMD Leistungslabor am 17. November 2023 für den AMD Instinct™ MI300X OAM-Beschleuniger 750 W (192 GB HBM3), entwickelt mit AMD CDNA™ 3 5-nm-FinFet-Prozesstechnologie, ergaben 192 GB HBM3-Speicherkapazität und eine Performance von 5,325 TFLOPS theoretischer Speicherbandbreite. Die Speicherbus-Schnittstelle von MI300X ist 8.192 und die Speicherdatenrate beträgt 5,2 GB/s für eine Spitzenspeicherbandbreite von insgesamt 5,325 TB/s (8.192 Bit Speicherbus-Schnittstelle * 5,2 GB/s Speicherdatenrate / 8). Die höchsten veröffentlichten Ergebnisse für den Nvidia Hopper H200 (141 GB) SXM-GPU-Beschleuniger ergaben eine Speicherkapazität von 141 GB HBM3e und eine GPU-Speicherbandbreite von 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Die höchsten veröffentlichten Ergebnisse für den Nvidia Hopper H100 (80 GB) SXM5-GPU-Beschleuniger ergaben eine Speicherkapazität von 80 GB HBM3 und eine GPU-Speicherbandbreite von 3,35 TB/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A

- Messungen durchgeführt vom AMD Leistungslabor am 18. November 2023, für die AMD Instinct™ MI300X (192 GB HBM3) 750 W GPU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben theoretische max. 1.307,4 TFLOPS mit halber Genauigkeit (FP16), max. 1.307,4 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16). Es wird erwartet, dass der MI300X in der Lage ist, die Vorteile der genauen Structure Sparsity zu nutzen, was eine geschätzte 2-fache Verbesserung der mathematischen Effizienz ermöglicht, die folgende theoretische Gleitkommaleistung mit Sparsity ergibt: max. 2.614,9 TFLOPS mit halber Genauigkeit (FP16), max. 2.614,9 TFLOPS Bfloat16-Format-Genauigkeit (BF16). Veröffentlichte Ergebnisse auf der Nvidia H100 SXM (80 GB HBM3) 700 W GPU ergaben eine theoretische Gleitkommaleistung von max. 1.978,9 TFLOPS mit halber Genauigkeit (FP16) mit Sparsity, max. 1.978,9 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16) mit Sparsity. Quelle Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ AMD Instinct™ MI300X Beschleuniger mit AMD CDNA 3 Technologie umfassen bis zu acht AMD Infinity Fabric Links und bieten eine theoretische aggregierte Datenbandbreite von bis zu 1.024 GB/s GPU Peer-to-Peer (P2P) pro GPU OAM-Modul. MI300-25

- Messungen durchgeführt vom AMD Leistungslabor am 11. November 2023, für die AMD Instinct™ MI300A (760 W) APU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 122,6 TFLOPS mit doppelter Genauigkeit (FP64 Matrix), max. 61,3 TFLOPS mit doppelter Genauigkeit (FP64), max. 122,6 TFLOPS mit einfacher Genauigkeit Matrix (FP32 Matrix), max. 122,6 TFLOPS mit einfacher Genauigkeit (FP32), max. 490,3 TFLOPS TensorFloat-32 (TF32), max. 980,6 TFLOPS mit halber Genauigkeit (FP16), max. 980,6 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 1.961,2 TFLOPS mit 8-Bit-Genauigkeit (FP8), 1.961,2 TOPs INT8. Die Ergebnisse für den AMD Instinct™ MI250X (560 W) 128 GB HBM2e OAM-Beschleuniger mit AMD CDNA™ 2 5-nm-FinFET-Prozesstechnologie bei max. 1.700 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 95,7 TFLOPS mit doppelter Genauigkeit (FP64 Matrix), max. 47,9 TFLOPS mit doppelter Genauigkeit (FP64), max. 95,7 TFLOPS mit einfacher Genauigkeit (FP32 Matrix), max. 47,9 TFLOPS mit einfacher Genauigkeit (FP32), TF32* (N/A), max. 383,0 TFLOPS mit halber Genauigkeit (FP16), max. 383,0 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), FP8* (N/A), 383,0 TOPs INT8. Serverhersteller können abweichende Konfigurationen anbieten, was zu anderen Ergebnissen führen kann. * MI200-Serie GPUs unterstützen nicht TF32, FP8 oder Sparsity. MI300-10

- Messungen durchgeführt vom AMD Leistungslabor am 11. November 2023, für die AMD Instinct™ MI300A (750 W) APU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 490,29 TFLOPS TensorFloat-32 (TF32), max. 980,58 TFLOPS mit halber Genauigkeit (FP16), max. 980,58 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 1.961,16 TFLOPS mit 8-Bit-Genauigkeit (FP8), 1.961,16 TOPs INT8. Es wird erwartet, dass der MI300A in der Lage ist, die Vorteile der genauen Structure Sparsity zu nutzen, was eine geschätzte 2-fache Verbesserung der mathematischen Effizienz ermöglicht, die folgende theoretische Gleitkommaleistung mit Sparsity ergibt: max. 980,58 TFLOPS TensorFloat-32 (TF32), max. 1.961,16 TFLOPS mit halber Genauigkeit (FP16), max. 1.961,16 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 3.922,33 TFLOPS mit 8-Bit-Genauigkeit (FP8), 3.922,33 TOPs INT8. Veröffentlichte Ergebnisse auf Nvidia H100 SXM5 (80 GB) GPU ergaben eine theoretische Gleitkommaleistung von max. 989,4 TFLOPs TensorFloat-32 (TF32) Tensor Core mit Sparsity, max. 1.978,9 TFLOPS mit halber Genauigkeit (FP16) Tensor Core mit Sparsity, max. 1.978,9 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16) Tensor Core mit Sparsity, max. 3.957,8 TFLOPS mit 8-Bit-Genauigkeit (FP8) Tensor Core mit Sparsity, max. 3.957,8 TOPs INT8 Tensor Core mit Sparsity. Quelle Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ Serverhersteller können abweichende Konfigurationen anbieten, was zu anderen Ergebnissen führen kann. MI300-21

- Messungen durchgeführt vom AMD Leistungslabor am 11. November 2023, für die AMD Instinct™ MI300A (760 W) GPU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 122,6 TFLOPS mit doppelter Genauigkeit Matrix (FP64 Matrix), max. 61,3 TFLOPS mit doppelter Genauigkeit (FP64), max. 122,6 TFLOPS mit einfacher Genauigkeit Matrix (FP32 Matrix), max. 122,6 TFLOPS mit einfacher Genauigkeit (FP32), max. 490,29 TFLOPS TensorFloat-32 (TF32), max. 980,58 TFLOPS mit halber Genauigkeit (FP16), max. 980,58 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 1.961,16 TFLOPS mit 8-Bit-Genauigkeit (FP8), 1.961,16 TOPs INT8. Veröffentlichte Ergebnisse auf der Nvidia H100 SXM (80 GB) 700 W GPU ergaben folgende theoretische Gleitkommaleistung: max. 66,9 TFLOPs mit doppelter Genauigkeit (FP64 Tensor), max. 33,5 TFLOPs mit doppelter Genauigkeit (FP64), max. 66,9 TFLOPs mit einfacher Genauigkeit (FP32), max. 494,7 TFLOPs TensorFloat-32 (TF32)*, max. 989,4 TFLOPS mit halber Genauigkeit (FP16 Tensor), max. 133,8 TFLOPS mit halber Genauigkeit (FP16), max. 989,4 TFLOPS mit Bfloat16-Tensor-Format-Genauigkeit (BF16 Tensor), max. 133,8 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 1.978,9 TFLOPS mit 8-Bit-Genauigkeit (FP8), max. 1.978,9 TOPs INT8. Quelle Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ Serverhersteller können abweichende Konfigurationen anbieten, was zu anderen Ergebnissen führen kann. * Nvidia H100 GPUs unterstützen nicht FP32 Tensor. MI300-20

- Berechnungen durchgeführt vom AMD Leistungslabor vom 7. November 2023 für den AMD Instinct™ MI300A APU-Beschleuniger 760 W (128 GB HBM3), entwickelt mit AMD CDNA™ 3 5-nm-FinFet-Prozesstechnologie, ergaben 128 GB HBM3-Speicherkapazität und eine Performance von 5,325 TFLOPS theoretischer Speicherbandbreite. Die Speicherbus-Schnittstelle von MI300A ist 8.192 (1.024 Bit x 8 Die) und die Speicherdatenrate beträgt 5,2 GB/s für eine Spitzenspeicherbandbreite von insgesamt 5,325 TB/s (8.192 Bit Speicherbus-Schnittstelle * 5,2 GB/s Speicherdatenrate / 8). Die höchsten veröffentlichten Ergebnisse für den Nvidia Hopper H200 (141 GB) SXM-GPU-Beschleuniger ergaben eine Speicherkapazität von 141 GB HBM3e und eine GPU-Speicherbandbreite von 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Die höchsten veröffentlichten Ergebnisse für den Nvidia Hopper H100 (80 GB) SXM-GPU-Beschleuniger ergaben eine Speicherkapazität von 80 GB HBM3 und eine GPU-Speicherbandbreite von 3,35 TB/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet Serverhersteller können abweichende Konfigurationen anbieten, was zu anderen Ergebnissen führen kann. MI300-12

- MI325-001A – Berechnungen durchgeführt vom AMD Leistungslabor am 26. September 2024 basierend auf aktuellen Spezifikationen und/oder Schätzungen. Der AMD Instinct™ MI325X OAM Beschleuniger wird über eine HBM3E-Speicherkapazität von 256 GB und eine theoretische GPU-Speicherbandbreite von 6 TB/s verfügen. Die tatsächlichen Ergebnisse auf Basis von Chips aus der Produktion können abweichen.

Die höchsten veröffentlichten Ergebnisse für den Nvidia Hopper H200 (141 GB) SXM-GPU-Beschleuniger ergaben eine Speicherkapazität von 141 GB HBM3E und eine GPU-Speicherbandbreite von 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Die höchsten veröffentlichten Ergebnisse für den Nvidia Blackwell HGX B100 (192 GB) 700-W-GPU-Beschleuniger ergaben eine HBM3E-Speicherkapazität von 192 GB und eine GPU-Speicherbandbreiten-Performance von 8 TB/s.

Die höchsten veröffentlichten Ergebnisse für den Nvidia Blackwell HGX B200 (192 GB) GPU-Beschleuniger ergaben eine HBM3E-Speicherkapazität von 192 GB und eine GPU-Speicherbandbreiten-Performance von 8 TB/s.

Nvidia Blackwell-Spezifikationen unter https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy - MI325-002 – Die vom AMD Leistungslabor am 28. Mai 2024 durchgeführten Berechnungen für die AMD Instinct™ MI325X GPU ergaben 1.307,4 TFLOPS theoretische Halbpräzision (FP16), 1.307,4 TFLOPS theoretische Spitzenpräzision im Bfloat16-Format (BF16), 2.614,9 TFLOPS theoretische Spitzenpräzision mit 8 Bit (FP8), 2.614,9 TOPs INT8-Gleitkommaleistung. Die tatsächliche Performance hängt von den endgültigen Spezifikationen und der Systemkonfiguration ab.

Veröffentlichte Ergebnisse für Nvidia H200 SXM (141 GB) GPU: 989,4 TFLOPS theoretische Spitzenleistung bei halber Genauigkeit des Tensors (FP16-Tensor), 989,4 TFLOPS theoretische Spitzenleistung bei Bfloat16-Tensorformat-Genauigkeit (BF16-Tensor), 1.978,9 TFLOPS theoretische Spitzenleistung bei 8-Bit-Genauigkeit (FP8), 1.978,9 TOPs theoretische Spitzenleistung bei INT8-Gleitkommaleistung. Die Performance von BFLOAT16 Tensor Core, FP16 Tensor Core, FP8 Tensor Core und INT8 Tensor Core wurde von Nvidia unter Verwendung von Sparsity veröffentlicht. Zum Vergleich hat AMD diese Zahlen durch Division durch 2 in Nicht-Sparsity/Dense umgewandelt. Diese Zahlen sind oben aufgeführt.

Quelle Nvidia H200: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 und https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Hinweis: Nvidia H200 GPUs haben die gleiche veröffentlichte FLOPs-Performance wie H100-Produkte https://resources.nvidia.com/en-us-tensor-core/. MI325-02 - MI325-008 – Die vom AMD Leistungslabor am 2. Oktober 2024 durchgeführten Berechnungen für die AMD Instinct™ MI325X (1000 W) GPU, die mit der AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei 2.100 MHz Spitzen-Boost-Speichertakt entwickelt wurde, ergaben 163,4 TFLOPs theoretische Spitzen-Matrix mit doppelter Genauigkeit (FP64-Matrix), 81,7 TFLOPs theoretischer Spitzenwert mit doppelter Genauigkeit (FP64), 163,4 TFLOPs theoretische Spitzen-Matrix mit einfacher Genauigkeit (FP32-Matrix), 163,4 TFLOPs theoretischer Spitzenwert bei einfacher Genauigkeit (FP32), 653,7 TFLOPS theoretischer Spitzenwert bei TensorFloat-32 (TF32), 1.307,4 TFLOPS theoretischer Spitzenwert bei halber Genauigkeit (FP16). Die tatsächliche Performance kann je nach endgültigen Spezifikationen und Systemkonfiguration variieren.

Veröffentlichte Ergebnisse für Nvidia H200 SXM (141 GB) GPU: 66,9 TFLOPs theoretische Spitzenleistung bei doppelter Genauigkeit Tensor (FP64-Tensor), 33,5 TFLOPs theoretische Spitzenleistung bei doppelter Genauigkeit (FP64), 66,9 TFLOPs theoretische Spitzenleistung bei einfacher Genauigkeit (FP32), 494,7 TFLOPs Spitzenleistung TensorFloat-32 (TF32), 989,5 TFLOPS theoretische Spitzenleistung bei halber Genauigkeit Tensor (FP16-Tensor). Die Performance des TF32-Tensor-Core wurde von Nvidia unter Verwendung von Sparsity veröffentlicht. Zum Vergleich hat AMD diese Zahlen durch Division durch 2 in Nicht-Sparsity/Dense umgewandelt. Diese Zahl ist oben aufgeführt.

Quelle Nvidia H200: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 und https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

Hinweis: Nvidia H200 GPUs haben die gleiche veröffentlichte FLOPs-Performance wie H100-Produkte https://resources.nvidia.com/en-us-tensor-core/.

* Nvidia H200 GPUs unterstützen nicht FP32 Tensor. - Messungen durchgeführt vom AMD Leistungslabor am 11. November 2023, für die AMD Instinct™ MI300X (750 W) GPU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 653,7 TFLOPS TensorFloat-32 (TF32), max. 1.307,4 TFLOPS mit halber Genauigkeit (FP16), max. 1.307,4 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 2.614,9 TFLOPS mit 8-Bit-Genauigkeit (FP8), 2.614,9 TOPs INT8. Es wird erwartet, dass der MI300X in der Lage ist, die Vorteile der genauen Structure Sparsity zu nutzen, was eine geschätzte 2-fache Verbesserung der mathematischen Effizienz ermöglicht, die folgende theoretische Gleitkommaleistung mit Sparsity ergibt: max. 1.307,4 TFLOPS TensorFloat-32 (TF32), max. 2.614,9 TFLOPS mit halber Genauigkeit (FP16), max. 2.614,9 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 5.229,8 TFLOPS mit 8-Bit-Genauigkeit (FP8), 5.229,8 TOPs INT8. Die Ergebnisse für den AMD Instinct™ MI250X (560 W) 128 GB HBM2e OAM-Beschleuniger mit AMD CDNA™ 2 5-nm-FinFET-Prozesstechnologie bei max. 1.700 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: TF32* (N/A), max. 383,0 TFLOPS mit halber Genauigkeit (FP16), max. 383,0 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), FP8* (N/A), 383,0 TOPs INT8. * AMD Instinct MI200-Serie GPUs unterstützen nicht TF32, FP8 oder Sparsity. MI300-16

- Messungen durchgeführt vom internen AMD Leistungslabor am 2. Juni 2023 anhand aktueller Spezifikationen und/oder interner technischer Berechnungen. Large Language Model (LLM) ausgeführt oder berechnet mit FP16 Genauigkeit, um die Mindestanzahl von GPUs zu ermitteln, die zur Ausführung der Modelle Falcon-7B (7B, 40B Parameter), LLaMA (13B, 33B Parameter), OPT (66B Parameter), GPT-3 (175B Parameter), BLOOM (176B Parameter) und PaLM (340B, 540B Parameter) erforderlich sind. Berechnete Schätzungen basieren auf der Größe des reinen GPU-Speichers im Vergleich zum Speicherbedarf des Modells bei definierten Parametern plus 10 % Overhead. Die Berechnungen beruhen auf veröffentlichten und mitunter vorläufigen Modellspeichergrößen. GPT-3, BLOOM und PaLM Ergebnisse geschätzt auf MI300X aufgrund der System-/Teileverfügbarkeit. Getestete Ergebniskonfigurationen: AMD Lab System bestehend aus 1 x EPYC 9654 (96 Kerne) CPU mit 1 x AMD Instinct™ MI300X (192 GB HBM3, OAM-Modul) 750 W Beschleuniger

Ergebnisse (FP16 Genauigkeit):

Modell Parameter Gesamtspeicher erforderlich MI300X erforderlich Falcon-7B 7 Milliarden 15,4 GB 1 Tatsächlich LLaMA 13 Milliarden 44 GB 1 Tatsächlich LLaMA 33 Milliarden 72,5 GB 1 Tatsächlich Falcon-40B 40 Milliarden 88 GB 1 Tatsächlich OPT 66 Milliarden 145,2 GB 1 Tatsächlich GPT-3 175 Milliarden 385 GB 3 Berechnet Bloom 176 Milliarden 387,2 GB 3 Berechnet PaLM 340 Milliarden 748 GB 4 Berechnet PaLM 540 Milliarden 1188 GB 7 Berechnet Die berechneten Schätzungen können je nach endgültiger Modellgröße variieren; die tatsächlichen und die geschätzten Werte können aufgrund des tatsächlich erforderlichen Overheads und der Verwendung von Systemspeicher über den der GPU hinaus variieren. Serverhersteller können abweichende Konfigurationen anbieten, was zu anderen Ergebnissen führen kann. MI300-07

- Messungen durchgeführt vom AMD Leistungslabor am 11. November 2023, für die AMD Instinct™ MI300X (750 W) GPU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 653,7 TFLOPS TensorFloat-32 (TF32), max. 1.307,4 TFLOPS mit halber Genauigkeit (FP16), max. 1.307,4 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 2.614,9 TFLOPS mit 8-Bit-Genauigkeit (FP8), 2.614,9 TOPs INT8. Es wird erwartet, dass der MI300X in der Lage ist, die Vorteile der genauen Structure Sparsity zu nutzen, was eine geschätzte 2-fache Verbesserung der mathematischen Effizienz ermöglicht, die folgende theoretische Gleitkommaleistung mit Sparsity ergibt: max. 1.307,4 TFLOPS TensorFloat-32 (TF32), max. 2.614,9 TFLOPS mit halber Genauigkeit (FP16), max. 2.614,9 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 5.229,8 TFLOPS mit 8-Bit-Genauigkeit (FP8), 5.229,8 TOPs INT8. Veröffentlichte Ergebnisse auf Nvidia H100 SXM (80 GB) 700 W GPU ergaben eine theoretische Gleitkommaleistung von max. 989,4 TFLOPs TensorFloat-32 (TF32) mit Sparsity, max. 1.978,9 TFLOPS mit halber Genauigkeit (FP16) mit Sparsity, max. 1.978,9 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16) mit Sparsity, max. 3.957,8 TFLOPS 8-Bit-Genauigkeit (FP8) mit Sparsity, max. 3.957,8 TOPs INT8 mit Sparsity. Quelle Nvidia H100: https://resources.nvidia.com/en-us-tensor-core. MI300-17

- Messungen durchgeführt vom AMD Leistungslabor am 11. November 2023, für die AMD Instinct™ MI300X (750 W) GPU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 163,4 TFLOPS mit doppelter Genauigkeit Matrix (FP64 Matrix), max. 81,7 TFLOPS mit doppelter Genauigkeit (FP64), max. 163,4 TFLOPS mit einfacher Genauigkeit Matrix (FP32 Matrix), max. 163,4 TFLOPS mit einfacher Genauigkeit (FP32), max. 653,7 TFLOPS TensorFloat-32 (TF32), max. 1.307,4 TFLOPS mit halber Genauigkeit (FP16), max. 1.307,4 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 2.614,9 TFLOPS mit 8-Bit-Genauigkeit (FP8), 2.614,9 TOPs INT8. Veröffentlichte Ergebnisse auf der Nvidia H100 SXM (80 GB) GPU ergaben folgende theoretische Gleitkommaleistung: max. 66,9 TFLOPs mit doppelter Genauigkeit (FP64 Tensor), max. 33,5 TFLOPs mit doppelter Genauigkeit (FP64), max. 66,9 TFLOPs mit einfacher Genauigkeit (FP32), max. 494,7 TFLOPs TensorFloat-32 (TF32)*, max. 989,4 TFLOPS mit halber Genauigkeit (FP16 Tensor), max. 133,8 TFLOPS mit halber Genauigkeit (FP16), max. 989,4 TFLOPS mit Bfloat16-Tensor-Format-Genauigkeit (BF16 Tensor), max. 133,8 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 1.978,9 TFLOPS mit 8-Bit-Genauigkeit (FP8), max. 1.978,9 TOPs INT8. Nvidia H100 Quelle: https://resources.nvidia.com/en-us-tensor-core/ * Nvidia H100 GPUs unterstützen nicht FP32 Tensor. MI300-18

- Berechnungen durchgeführt vom AMD Leistungslabor am 17. November 2023 für den AMD Instinct™ MI300X OAM-Beschleuniger 750 W (192 GB HBM3), entwickelt mit AMD CDNA™ 3 5-nm-FinFet-Prozesstechnologie, ergaben 192 GB HBM3-Speicherkapazität und eine Performance von 5,325 TFLOPS theoretischer Speicherbandbreite. Die Speicherbus-Schnittstelle von MI300X ist 8.192 und die Speicherdatenrate beträgt 5,2 GB/s für eine Spitzenspeicherbandbreite von insgesamt 5,325 TB/s (8.192 Bit Speicherbus-Schnittstelle * 5,2 GB/s Speicherdatenrate / 8). Die höchsten veröffentlichten Ergebnisse für den Nvidia Hopper H200 (141 GB) SXM-GPU-Beschleuniger ergaben eine Speicherkapazität von 141 GB HBM3e und eine GPU-Speicherbandbreite von 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Die höchsten veröffentlichten Ergebnisse für den Nvidia Hopper H100 (80 GB) SXM5-GPU-Beschleuniger ergaben eine Speicherkapazität von 80 GB HBM3 und eine GPU-Speicherbandbreite von 3,35 TB/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A

- Messungen durchgeführt vom AMD Leistungslabor am 18. November 2023, für die AMD Instinct™ MI300X (192 GB HBM3) 750 W GPU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben theoretische max. 1.307,4 TFLOPS mit halber Genauigkeit (FP16), max. 1.307,4 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16). Es wird erwartet, dass der MI300X in der Lage ist, die Vorteile der genauen Structure Sparsity zu nutzen, was eine geschätzte 2-fache Verbesserung der mathematischen Effizienz ermöglicht, die folgende theoretische Gleitkommaleistung mit Sparsity ergibt: max. 2.614,9 TFLOPS mit halber Genauigkeit (FP16), max. 2.614,9 TFLOPS Bfloat16-Format-Genauigkeit (BF16). Veröffentlichte Ergebnisse auf der Nvidia H100 SXM (80 GB HBM3) 700 W GPU ergaben eine theoretische Gleitkommaleistung von max. 1.978,9 TFLOPS mit halber Genauigkeit (FP16) mit Sparsity, max. 1.978,9 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16) mit Sparsity. Quelle Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ AMD Instinct™ MI300X Beschleuniger mit AMD CDNA 3 Technologie umfassen bis zu acht AMD Infinity Fabric Links und bieten eine theoretische aggregierte Datenbandbreite von bis zu 1.024 GB/s GPU Peer-to-Peer (P2P) pro GPU OAM-Modul. MI300-25

- Messungen durchgeführt vom AMD Leistungslabor am 11. November 2023, für die AMD Instinct™ MI300A (760 W) APU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 122,6 TFLOPS mit doppelter Genauigkeit (FP64 Matrix), max. 61,3 TFLOPS mit doppelter Genauigkeit (FP64), max. 122,6 TFLOPS mit einfacher Genauigkeit Matrix (FP32 Matrix), max. 122,6 TFLOPS mit einfacher Genauigkeit (FP32), max. 490,3 TFLOPS TensorFloat-32 (TF32), max. 980,6 TFLOPS mit halber Genauigkeit (FP16), max. 980,6 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 1.961,2 TFLOPS mit 8-Bit-Genauigkeit (FP8), 1.961,2 TOPs INT8. Die Ergebnisse für den AMD Instinct™ MI250X (560 W) 128 GB HBM2e OAM-Beschleuniger mit AMD CDNA™ 2 5-nm-FinFET-Prozesstechnologie bei max. 1.700 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 95,7 TFLOPS mit doppelter Genauigkeit (FP64 Matrix), max. 47,9 TFLOPS mit doppelter Genauigkeit (FP64), max. 95,7 TFLOPS mit einfacher Genauigkeit (FP32 Matrix), max. 47,9 TFLOPS mit einfacher Genauigkeit (FP32), TF32* (N/A), max. 383,0 TFLOPS mit halber Genauigkeit (FP16), max. 383,0 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), FP8* (N/A), 383,0 TOPs INT8. Serverhersteller können abweichende Konfigurationen anbieten, was zu anderen Ergebnissen führen kann. * MI200-Serie GPUs unterstützen nicht TF32, FP8 oder Sparsity. MI300-10

- Messungen durchgeführt vom AMD Leistungslabor am 11. November 2023, für die AMD Instinct™ MI300A (750 W) APU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 490,29 TFLOPS TensorFloat-32 (TF32), max. 980,58 TFLOPS mit halber Genauigkeit (FP16), max. 980,58 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 1.961,16 TFLOPS mit 8-Bit-Genauigkeit (FP8), 1.961,16 TOPs INT8. Es wird erwartet, dass der MI300A in der Lage ist, die Vorteile der genauen Structure Sparsity zu nutzen, was eine geschätzte 2-fache Verbesserung der mathematischen Effizienz ermöglicht, die folgende theoretische Gleitkommaleistung mit Sparsity ergibt: max. 980,58 TFLOPS TensorFloat-32 (TF32), max. 1.961,16 TFLOPS mit halber Genauigkeit (FP16), max. 1.961,16 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 3.922,33 TFLOPS mit 8-Bit-Genauigkeit (FP8), 3.922,33 TOPs INT8. Veröffentlichte Ergebnisse auf Nvidia H100 SXM5 (80 GB) GPU ergaben eine theoretische Gleitkommaleistung von max. 989,4 TFLOPs TensorFloat-32 (TF32) Tensor Core mit Sparsity, max. 1.978,9 TFLOPS mit halber Genauigkeit (FP16) Tensor Core mit Sparsity, max. 1.978,9 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16) Tensor Core mit Sparsity, max. 3.957,8 TFLOPS mit 8-Bit-Genauigkeit (FP8) Tensor Core mit Sparsity, max. 3.957,8 TOPs INT8 Tensor Core mit Sparsity. Quelle Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ Serverhersteller können abweichende Konfigurationen anbieten, was zu anderen Ergebnissen führen kann. MI300-21

- Messungen durchgeführt vom AMD Leistungslabor am 11. November 2023, für die AMD Instinct™ MI300A (760 W) GPU mit AMD CDNA™ 3 5-nm-/6-nm-FinFET-Prozesstechnologie bei max. 2.100 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 122,6 TFLOPS mit doppelter Genauigkeit Matrix (FP64 Matrix), max. 61,3 TFLOPS mit doppelter Genauigkeit (FP64), max. 122,6 TFLOPS mit einfacher Genauigkeit Matrix (FP32 Matrix), max. 122,6 TFLOPS mit einfacher Genauigkeit (FP32), max. 490,29 TFLOPS TensorFloat-32 (TF32), max. 980,58 TFLOPS mit halber Genauigkeit (FP16), max. 980,58 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 1.961,16 TFLOPS mit 8-Bit-Genauigkeit (FP8), 1.961,16 TOPs INT8. Veröffentlichte Ergebnisse auf der Nvidia H100 SXM (80 GB) 700 W GPU ergaben folgende theoretische Gleitkommaleistung: max. 66,9 TFLOPs mit doppelter Genauigkeit (FP64 Tensor), max. 33,5 TFLOPs mit doppelter Genauigkeit (FP64), max. 66,9 TFLOPs mit einfacher Genauigkeit (FP32), max. 494,7 TFLOPs TensorFloat-32 (TF32)*, max. 989,4 TFLOPS mit halber Genauigkeit (FP16 Tensor), max. 133,8 TFLOPS mit halber Genauigkeit (FP16), max. 989,4 TFLOPS mit Bfloat16-Tensor-Format-Genauigkeit (BF16 Tensor), max. 133,8 TFLOPS mit Bfloat16-Format-Genauigkeit (BF16), max. 1.978,9 TFLOPS mit 8-Bit-Genauigkeit (FP8), max. 1.978,9 TOPs INT8. Quelle Nvidia H100: https://resources.nvidia.com/en-us-tensor-core/ Serverhersteller können abweichende Konfigurationen anbieten, was zu anderen Ergebnissen führen kann. * Nvidia H100 GPUs unterstützen nicht FP32 Tensor. MI300-20

- Berechnungen durchgeführt vom AMD Leistungslabor vom 7. November 2023 für den AMD Instinct™ MI300A APU-Beschleuniger 760 W (128 GB HBM3), entwickelt mit AMD CDNA™ 3 5-nm-FinFet-Prozesstechnologie, ergaben 128 GB HBM3-Speicherkapazität und eine Performance von 5,325 TFLOPS theoretischer Speicherbandbreite. Die Speicherbus-Schnittstelle von MI300A ist 8.192 (1.024 Bit x 8 Die) und die Speicherdatenrate beträgt 5,2 GB/s für eine Spitzenspeicherbandbreite von insgesamt 5,325 TB/s (8.192 Bit Speicherbus-Schnittstelle * 5,2 GB/s Speicherdatenrate / 8). Die höchsten veröffentlichten Ergebnisse für den Nvidia Hopper H200 (141 GB) SXM-GPU-Beschleuniger ergaben eine Speicherkapazität von 141 GB HBM3e und eine GPU-Speicherbandbreite von 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Die höchsten veröffentlichten Ergebnisse für den Nvidia Hopper H100 (80 GB) SXM-GPU-Beschleuniger ergaben eine Speicherkapazität von 80 GB HBM3 und eine GPU-Speicherbandbreite von 3,35 TB/s. https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet Serverhersteller können abweichende Konfigurationen anbieten, was zu anderen Ergebnissen führen kann. MI300-12