En segundo plano

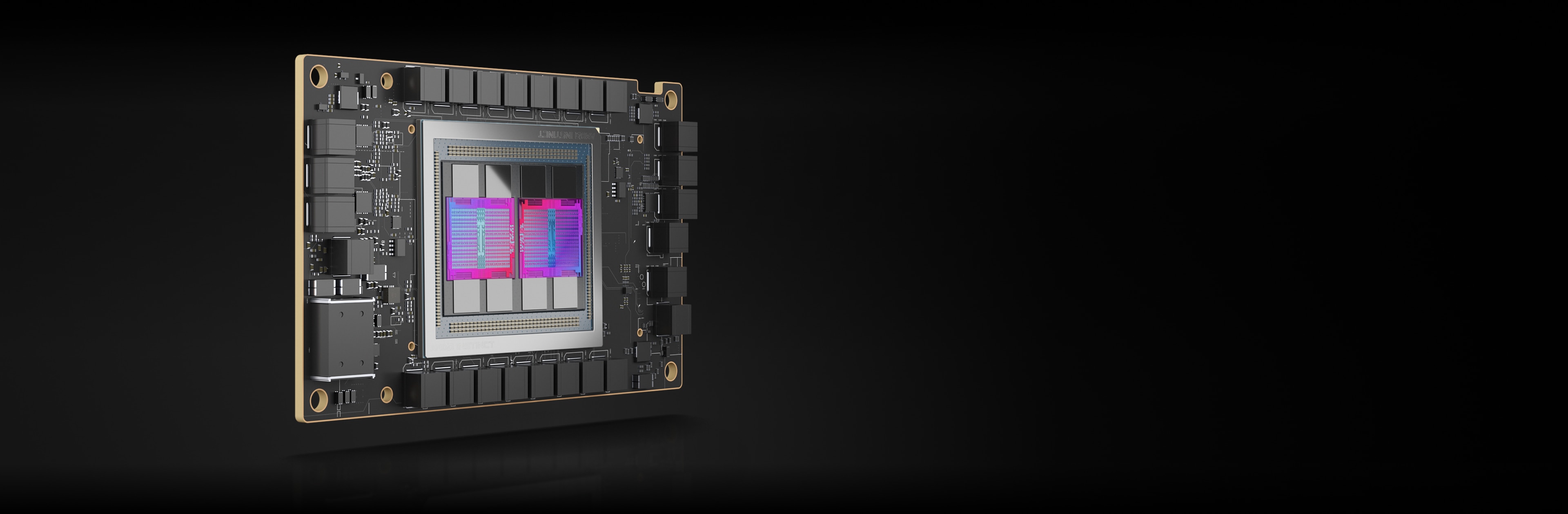

Los aceleradores AMD Instinct están desarrollados con la arquitectura AMD CDNA™, que ofrece tecnologías Matrix Core y compatibilidad para una amplia gama de capacidades de precisión, desde INT8 y FP8 con alta eficiencia hasta la FP64 más exigente para HPC.

Aceleradores AMD Instinct MI250X

Los aceleradores AMD Instinct MI250X potencian algunas de las supercomputadoras más importantes del mundo.

220 UP

220 unidades de procesamiento de GPU

128 GB

128 GB de memoria HBM2e

3,2 TB/s

Ancho de banda de memoria máximo de 3,2 TB/s.

400 GB/s

Máximo agregado de 400 GB/s de Infinity Fabric

Comparaciones de especificaciones

Rendimiento de precisión media teórica máxima (FP16) de hasta 383 TFLOP con hasta 1,6 veces más capacidad de memoria y ancho de banda que las GPU competitivas para las cargas de trabajo de IA más exigentes2,3,4

MI250X

A100

Ofrece hasta 4 veces más ventajas que las GPU de la competencia, lo que proporciona un rendimiento teórico máximo de la matriz de hasta 47,9 TFLOP FP64 y hasta 95,7 TFLOP FP64.2

MI250X

A100

* El formato de datos TF32 no cumple con la norma IEEE y no se incluye en esta comparación.

Aceleradores AMD Instinct MI250

Los aceleradores AMD Instinct MI250 impulsan un desempeño excepcional de HPC e IA para casos de uso empresariales, de investigación y relacionados con la academia.

208 UP

208 unidades de procesamiento de GPU

128 GB

128 GB de memoria HBM2e

3,2 TB/s

Ancho de banda de memoria máximo de 3,2 TB/s.

100 GB/s

Ancho de banda máximo de 100 GB/s de Infinity Fabric™ Link

Evaluaciones comparativas de rendimiento

HPCG 3.0: La evaluación comparativa de los gradientes conjugados de alto rendimiento (HPCG) es la métrica de clasificación de los sistemas HPC. El HPCG está diseñado como un complemento de la evaluación comparativa LINPACK (HPL) de alto rendimiento, que se utiliza actualmente para clasificar los sistemas informáticos TOP500.5

Medición |

1xMI250 |

2xMI250 |

4xMI250 |

GFLOPS |

488,8 |

972,6 |

1927.7 |

HPL: HPL es una implementación de evaluación comparativa LINPACK de alto rendimiento. El código resuelve un sistema aleatorio uniforme de ecuaciones lineales e informa el tiempo y la velocidad de ejecución del punto flotante mediante una fórmula estándar para el recuento de operación.6

Medición |

1xMI250 |

2xMI250 |

4xMI250 |

TFLOPS |

40,45 |

80,666 |

161,97 |

HPL_AI, o LINPACK de alto rendimiento para introspección de aceleradores, es una evaluación comparativa que destaca la convergencia de las cargas de trabajo de HPC e IA mediante la resolución de un sistema de ecuaciones lineales con algoritmos de precisión mixta novedosos.7

Medición |

Módulo de prueba |

4xMI250 |

TFLOPS |

FP16/32/64 mixto |

930,44 |

PyFR es un marco basado en Python de código abierto que permite resolver problemas de tipo advección-difusión sobre arquitecturas de streaming mediante el enfoque de reconstrucción Flux de Huynh. El marco está diseñado para resolver una amplia gama de sistemas reguladores en cuadrículas mixtas no estructuradas que contienen varios tipos de elementos.8

Medición |

Módulo de prueba |

1xMI250 |

Simulaciones/día |

TGV |

41,73 |

OpenFOAM (es decir, “operación y manipulación en terreno de código abierto”) es una caja de herramientas C++ para el desarrollo de soluciones numéricas personalizadas y utilidades previas o posteriores al procesamiento de la solución de problemas mecánicos continuos, que incluyen de forma más destacada la dinámica de fluidos computacional (CFD).9

Medición |

Módulo de prueba |

1xMI250 |

2xMI250 |

4xMI250 |

Tiempo (s) |

HPC Motorbike (más grande no significa mejor) |

662,3 |

364,26 |

209,84 |

Amber es un conjunto de programas de simulación biomolecular; el término “Amber” se refiere a dos cosas. En primer lugar, se trata de un conjunto de campos de fuerza mecánica molecular para la simulación de biomoléculas. En segundo lugar, es un paquete de programas de simulación molecular que incluye código fuente y demostraciones.10

Aplicación |

Medición |

Módulo de prueba |

Más grande es mejor |

1xMI250 |

AMBER |

NS/día |

Producción de celulosa NPT 4fs |

Sí |

227,2 |

AMBER |

NS/día |

Producción de celulosa NVE 4fs |

Sí |

242,4 |

AMBER |

NS/día |

Producción de FactorIX NPT 4fs |

Sí |

803,1 |

AMBER |

NS/día |

Producción de FactorIX NVE 4fs |

Sí |

855,2 |

AMBER |

NS/día |

Producción de JAC NPT 4fs |

Sí |

1794 |

AMBER |

NS/día |

Producción de JAC NVE 4fs |

Sí |

1871 |

AMBER |

NS/día |

Producción de STMV NPT 4fs |

Sí |

80,65 |

AMBER |

NS/día |

Producción de STMV NVE 4fs |

Sí |

86,7 |

GROMACS es un paquete de dinámica molecular diseñado principalmente para simulaciones de proteínas, lípidos y ácidos nucleicos. Fue desarrollado originalmente en el Departamento de Química Biofísica de la Universidad de Groninga y, en la actualidad, lo mantienen colaboradores en universidades y centros de investigación de todo el mundo.11

Aplicación |

Medición |

Módulo de prueba |

Más grande es mejor |

1xMI250 |

2xMI250 |

4xMI250 |

GROMACS |

NS/día |

STMV |

Sí |

34,2 |

61,812 |

89,26 |

LAMMPS es un código de dinámica molecular clásico que se centra en el modelado de materiales. Es un acrónimo de “simulador paralelo atómico/molecular masivo a gran escala”. El LAMMPS tiene potenciales para materiales de estado sólido (metales, semiconductores) y materia blanda (biomoléculas, polímeros) y sistemas granulados o mesoscópicos gruesos.12

Aplicación |

Medición |

Módulo de prueba |

Más grande es mejor |

1xMI250 |

2xMI250 |

4xMI250 |

LAMMPS |

Pasos del tiempo atómico/s |

LJ |

Sí |

6E+08 |

1E+09 |

2E+09 |

LAMMPS |

Pasos del tiempo atómico/s |

ReaxFF |

Sí |

7E+06 |

1E+07 |

3E+07 |

LAMMPS |

Pasos del tiempo atómico/s |

Tersoff |

Sí |

5E+08 |

1E+09 |

2E+09 |

NAMD es un paquete de dinámica molecular diseñado para simular el movimiento de biomoléculas a lo largo del tiempo. Es adecuado para sistemas biomoleculares grandes y se ha utilizado para simular sistemas con más de mil millones de átomos, lo que presenta una escalabilidad estelar en miles de núcleos de CPU y GPU.13

Aplicación |

Medición |

Módulo de prueba |

Más grande es mejor |

1xMI250 |

2xMI250 |

4xMI250 |

NAMD 3.0 |

NS/día |

APOA1_NVE |

Sí |

221,4 |

443,61 |

879,43 |

NAMD 3.0 |

NS/día |

STMV_NVE |

Sí |

19,87 |

39,545 |

77,132 |

Aceleradores AMD Instinct MI210

Los aceleradores AMD Instinct MI210 potencian las cargas de trabajo de HPC e IA empresariales, de investigación y académicas para soluciones de servidor único y mucho más.

104 UP

104 unidades de procesamiento de GPU

64 GB

64 GB de memoria HBM2e

1,6 TB/s

Ancho de banda de memoria máximo de 1,6 TB/s.

100 GB/s

Ancho de banda máximo de 100 GB/s de Infinity Fabric™ Link

Evaluaciones comparativas de rendimiento

HPL: HPL es una implementación de evaluación comparativa LINPACK de alto rendimiento. El código resuelve un sistema aleatorio uniforme de ecuaciones lineales e informa el tiempo y la velocidad de ejecución del punto flotante mediante una fórmula estándar para el recuento de operación.14

Medición |

Más grande es mejor |

1xMI210 |

2xMI210 |

4xMI210 | 8xMI210 |

TFLOPS |

Sí |

21,07 |

40,878 |

81,097 | 159,73 |

HPL-AI: HPL_AI, o LINPACK de alto rendimiento para introspección de aceleradores, es una evaluación comparativa que destaca la convergencia de las cargas de trabajo de HPC e IA mediante la resolución de un sistema de ecuaciones lineales con algoritmos de precisión mixta novedosos.15

Medición |

Módulo de prueba |

Más grande es mejor |

4xMI210 |

8xMI210 |

TFLOPS |

FP16/32/64 mixto |

Sí |

444,77 |

976,18 |

LAMMPS: LAMMPS es un código de dinámica molecular clásico que se centra en el modelado de materiales. Es un acrónimo de “simulador paralelo atómico/molecular masivo a gran escala”. El LAMMPS tiene potenciales para materiales de estado sólido (metales, semiconductores) y materia blanda (biomoléculas, polímeros) y sistemas granulados o mesoscópicos gruesos.16

Medición |

Módulo de prueba |

Más grande es mejor |

4xMI210 | 8xMI210 |

Pasos del tiempo atómico/s |

ReaxFF |

Sí |

1E+07 | 3E+07 |

Mantente informado

Regístrate para recibir las últimas novedades sobre centros de datos y contenido de servidores

Notas al pie

- Lista de las 500 mejores, junio del 2023

- La GPU del centro de datos más rápido del mundo es el AMD Instinct™ MI250X. Los cálculos llevados a cabo en los laboratorios de rendimiento de AMD el 15 de septiembre de 2021, con el acelerador AMD Instinct™ MI250X (módulo OAM HBM2e de 128 GB) a una frecuencia de reloj de motor con impulso máximo de 1700 MHz alcanzó 95,7 TFLOPS de precisión doble máxima teórica (matriz FP64); 47,9 TFLOPS de precisión doble máxima teórica (FP64); 95,7 TFLOPS de matriz de precisión simple máxima teórica (matriz FP32); 47,9 TFLOPS de precisión simple máxima teórica (FP32); 383,0 TFLOPS de mitad de precisión máxima teórica (FP16) y 383,0 TFLOPS de rendimiento de punto flotante de precisión de formato Bfloat16 máxima teórica (BF16). Las pruebas que se llevaron a cabo en los laboratorios de rendimiento de AMD el 18 de septiembre de 2020, en el acelerador AMD Instinct™ MI100 (tarjeta PCIe® con HBM2 de 32 GB) a una frecuencia de reloj de motor con impulso máximo de 1502 MHz, arrojaron como resultado un rendimiento de punto flotante máximo teórico de 11,54 TFLOPS de precisión doble máxima teórica (FP64); 46,1 TFLOPS de matriz de precisión simple máxima teórica (FP32); 23,1 TFLOPS de precisión simple máxima teórica (FP32); 184,6 TFLOPS de rendimiento de punto flotante de precisión media máxima teórica (FP16). Los resultados publicados del acelerador de GPU NVIDIA Ampere A100 (80 GB), con una frecuencia de reloj de motor con impulso máximo de 1410 MHz, arrojaron como resultado 19,5 TFLOPS de precisión doble máxima (núcleo Tensor FP64) y 9,7 TFLOPS de precisión doble máxima (FP64). 19,5 TFLOPS de precisión simple máxima (FP32), 78 TFLOPS de precisión media máxima (FP16), 312 TFLOPS de precisión media máxima (flujo Tensor FP16), 39 TFLOPS de Bfloat16 máxima (BF16), 312 TFLOPS de rendimiento de punto flotante de precisión de formato Bfloat16 máxima teórica (flujo Tensor BF16). El formato de datos TF32 no cumple con la norma IEEE y no se incluye en esta comparación. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-ampere-architecture-whitepaper.pdf, página 15, tabla 1. MI200-01

- Las mediciones realizadas por los laboratorios de rendimiento de AMD el 21 de septiembre del 2021 en los aceleradores AMD Instinct™ MI250X y MI250 (HBM2e de 128 GB) OAM, diseñados con la tecnología de procesos FinFET de 6 nm de AMD CDNA™ 2, a una frecuencia de reloj de memoria máxima de 1600 MHz, arrojaron como resultado un rendimiento de ancho de banda de memoria máximo teórico de 3,2768 TFLOP. La interfaz del bus de memoria de MI250/MI250X es 4096 bits por dos chips y la frecuencia de datos de memoria es 3,20 GB/s para un ancho de banda de memoria total de 3,2768 TB/s ([3,20 GB/s*[4096 bits*2]/8). Los resultados más altos publicados acerca del acelerador NVIDIA Ampere A100 (80 GB) SXM dieron como resultado un rendimiento de ancho de banda de memoria de GPU de 2039 TB/s. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-07

- Las mediciones que los laboratorios de rendimiento de AMD realizaron el 21 de septiembre del 2021 en los aceleradores AMD Instinct™ MI250X y MI250 (OAM), diseñados con la tecnología de procesos FinFET de 6 nm de AMD CDNA™ 2, a una velocidad de reloj de memoria máxima de 1600 MHz, dieron como resultado una capacidad de memoria de 128 GB HBMe. Las especificaciones publicadas acerca de los aceleradores NVIDIA Ampere A100 (80 GB) SXM y A100 (PCIe®) revelaron una capacidad de memoria de 80 GB. Resultados publicados en: https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-18

- Pruebas realizadas por los laboratorios de rendimiento de AMD el 11 de febrero del 2022 usando HPCG 3.0 para comparar dos sistemas: Servidor 2P con tecnología EPYC™ 7763, SMT deshabilitado, con una, dos y cuatro GPU AMD Instinct™ MI250 (HBM2e de 128 GB) de 560 W, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 en comparación con un servidor 2P con AMD EPYC™ 7742, con una, dos y cuatro GPU NVIDIA Ampere A100 de 80 GB SXM de 400 W, SBIOS 0.34, Ubuntu 20.04.4 y CUDA 11.6. Contenedor HPCG 3.0: nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg en https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-70A.

- Pruebas llevadas a cabo por laboratorios de rendimiento de AMD el 14/11/2022 con HPL para comparar dos sistemas. Servidor 2P con tecnología EPYC™ 7763, SMT desactivado, con una, dos y cuatro GPU AMD Instinct™ MI250 (HBM2e de 128 GB) de 560 W, host ROCm 5.2.0 rocHPL6.0.0. El contenedor HPL de AMD aún no está disponible en Infinity Hub en comparación con el servidor 2P AMD EPYC™ 7742, SMT habilitado, con una, dos y cuatro GPU NVIDIA Ampere A100 de 80 GB SXM de 400 W, CUDA 11.6 y versión del controlador 510.47.03. El contenedor HPL (nvcr.io/nvidia/hpc-benchmarks:21.4-hpl) se obtuvo en https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-69A.

- La comparación HPL-AI se basa en pruebas internas de AMD llevadas a cabo el 2/11/2022 en las que se midió el rendimiento de la evaluación comparativa HPL-AI (TFLOP) con un servidor con dos EPYC 7763 con cuatro MI250 (HBM2e de 128 MB) con tecnología en la que se ejecutó el host ROCm 5.2.0, HPL-AI-AMD v1.0.0 en comparación con un servidor con dos EPYC 7742 con cuatro A100 SXM (HBM2e de 80 GB) en los que se ejecuta CUDA 11.6, HPL-AI-NVIDIA v2.0.0, contenedor nvcr.io/nvidia/hpc-benchmarks:21.4-hpl. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-81.

- Pruebas llevadas a cabo en los laboratorios de rendimiento de AMD el 25/11/2022 con PyFR TGV y NACA 0021 para comparar los dos sistemas: Servidor 2P con tecnología EPYC™ 7763, SMT deshabilitado, con una GPU AMD Instinct™ MI250 (HBM2e de 128 GB) de 560 W, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 en comparación con un servidor 2P con AMD EPYC™ 7742, SMT habilitado, con una GPU NVIDIA Ampere A100 de 80 GB SXM de 400 W, SBIOS 0.34, Ubuntu 20.04.4 y CUDA 11.6. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-82.

- Pruebas realizadas por el laboratorio de rendimiento de AMD el 14/4/2023 con OpenFOAM v2206 en un servidor de producción de CPU 2P EPYC 7763 con 1, 2 y 4 GPU AMD Instinct™ MI250 (128 GB, 560 W) con tecnología AMD Infinity Fabric habilitada, ROCm™ 5.3.3, Ubuntu® 20.04.4 frente a un servidor de producción de CPU 2P EPYC 7742 con 1, 2 y 4 GPU NVIDIA A100 de 80 GB SXM (400 W) con tecnología NVLink habilitada, CUDA® 11.8, Ubuntu 20.04.4. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones.

- Pruebas llevadas a cabo en los laboratorios de rendimiento de AMD el 26/8/22 con AMBER: Cellulose_production_NPT_4fs, Cellulose_production_NVE_4fs, FactorIX_production_NPT_4fs, FactorIX_production_NVE_4fs, STMV_production_NPT_4fs, STMV_production_NVE_4fs, JAC_production_NPT_4fs y JAC production_NVE_4fs. Comparación de dos sistemas: Servidor 2P con tecnología EPYC™ 7763 con una GPU AMD Instinct™ MI250 (HBM2e de 128 GB) de 560 W, ROCm 5.2.0 y un contenedor Amber 22.amd_100 en comparación con un servidor 2P con tecnología EPYC™ 7742 con una GPU NVIDIA A100 SXM (HBM2e de 80 GB) de 400 W, con MPS habilitado (dos instancias) y CUDA 11.6. MI200-73.

- Pruebas realizadas por los laboratorios de rendimiento de AMD el 18 de octubre del 2022 usando Gromacs STMV0 para comparar dos sistemas: Servidor 2P con tecnología EPYC™ 7763 con cuatro GPU AMD Instinct™ MI250 (HBM2e de 128 GB) de 560 W con tecnología Infinity Fabric™, ROCm™ 5.2.0 y un contenedor Gromacs 2022.3.amd1_174, en comparación con las declaraciones públicas de NVIDIA disponibles en https://developer.nvidia.com/hpc-application-performance. (Gromacs 2022.2). EPYC 7742 doble con cuatro GPU NVIDIA Ampere A100 SXM de 80 GB. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según determinados factores, incluido el uso de los controladores más recientes y las optimizaciones. MI200-74.

- Pruebas llevadas a cabo en los laboratorios de rendimiento de AMD 109.0322.22 con LAMMPS: EAM, LJ, ReaxFF y Tersoff que comparan dos sistemas: Servidor 2P con tecnología EPYC™ 7763 con cuatro GPU AMD Instinct™ MI250 (HBM2e de 128 GB) de 560 W, ROCm 5.2.0 y contenedor LAMMPS 2021.5.14_121amdih/lammps:2022.5.04_130 en comparación con las declaraciones públicas de NVIDIA, disponibles en http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. (Estable, 23 de junio del 2022, actualización 1). Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-77.

- Pruebas llevadas a cabo en los laboratorios de rendimiento de AMD el 13/9/22 con NAMD: STMV_NNV, APOA1_NVE que compara dos sistemas: Servidor 2P con tecnología EPYC™ 7763 con una, dos y cuatro GPU AMD Instinct™ MI250 (HMB2e de 128 GB) de 560 W con tecnología AMD Infinity Fabric™, ROCm 5.2.0 y contenedor NAMD namd3:3.0a9 en comparación con las declaraciones públicas de NVIDIA sobre el rendimiento de un servidor 2P con EPYC 7742 con una, dos y cuatro GPU NVIDIA Ampere A100 de 80 GB SXM, disponibles en https://developer.nvidia.com/hpc-application-performance. (v2.15a AVX-512). Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-76.

- Pruebas llevadas a cabo en los laboratorios de rendimiento de AMD, realizadas el 14/11/2022 en un socket 2P con CPU AMD EPYC™ 7763 Supermicro 4124 con ocho GPU AMD Instinct™ MI210 (PCIe® de 64 GB y 300 W), con la tecnología AMD Infinity Fabric™ habilitada. Ubuntu 18.04.6 LTS, Host ROCm 5.2.0, rocHPL 6.0.0. Los resultados se calcularon a partir de los promedios de cinco ejecuciones en comparación con las pruebas llevadas a cabo en los laboratorios de rendimiento de AMD en un socket 2P AMD EPYC™ 7763 Supermicro 4124 con ocho GPU NVIDIA A100 (PCIe de 80 GB y 300 W), Ubuntu 18.04.6 LTS, CUDA 11.6, imagen del contenedor HPL de NVIDIA 21.4-HPL. Todos los resultados se midieron en sistemas configurados con 8 GPU; 2 pares de 4 GPU MI210 conectadas mediante un puente de 4 vías Infinity Fabric™; 4 pares de 2 GPU PCIe 2xA100 de 80 GB conectados mediante puentes NVLink de 2 vías. Información sobre HPL: https://www.netlib.org/benchmark/hpl/. Detalles del contenedor HPL de AMD: El contenedor HPL aún no está disponible en Infinity Hub. Detalle del contenedor HPL de NVIDIA: https://ngc.nvidia.com/catalog/containers/nvidia:hpc-benchmarks. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-49A.

- La comparación HPL-AI se basa en pruebas internas de AMD llevadas a cabo el 2/11/2022 en las que se midió el rendimiento de la evaluación comparativa HPL-AI (TFLOP) con un servidor con dos EPYC 7763 con ocho MI210 HBM2e de 64 MB con tecnología Infinity Fabric en la que se ejecutó el host ROCm 5.2.0 HPL-AI-AMD v1.0.0; el contenedor AMD HPL-AI aún no está disponible en Infinity Hub, en comparación con un servidor con dos EPYC 7763 con ocho A100 PCIe HBM2e de 80 GB en los que se ejecuta CUDA 11.6, HPL-AI-NVIDIA v2.0.0, contenedor nvcr.io/nvidia/hpc-benchmarks:21.4-hpl. Los fabricantes de servidores pueden variar las configuraciones, lo que da lugar a resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-83.

- Pruebas llevadas a cabo en los laboratorios de rendimiento de AMD en un socket 2P con CPU AMD EPYC™ 7763 Supermicro 4124 con cuatro y ocho GPU AMD Instinct™ MI210 (PCIe® de 64 GB y 300 W), con la tecnología AMD Infinity Fabric™ habilitada. SBIOS2.2, Ubuntu® 18.04.6 LTS, host ROCm™ 5.2.0. Contenedor AMMPS amdih-2022.5.04_130 (ROCm 5.1) en comparación con las declaraciones públicas de NVIDIA para cuatro y ocho GPU PCIe A100 de 80 GB http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-47A.

- Lista de las 500 mejores, junio del 2023

- La GPU del centro de datos más rápido del mundo es el AMD Instinct™ MI250X. Los cálculos llevados a cabo en los laboratorios de rendimiento de AMD el 15 de septiembre de 2021, con el acelerador AMD Instinct™ MI250X (módulo OAM HBM2e de 128 GB) a una frecuencia de reloj de motor con impulso máximo de 1700 MHz alcanzó 95,7 TFLOPS de precisión doble máxima teórica (matriz FP64); 47,9 TFLOPS de precisión doble máxima teórica (FP64); 95,7 TFLOPS de matriz de precisión simple máxima teórica (matriz FP32); 47,9 TFLOPS de precisión simple máxima teórica (FP32); 383,0 TFLOPS de mitad de precisión máxima teórica (FP16) y 383,0 TFLOPS de rendimiento de punto flotante de precisión de formato Bfloat16 máxima teórica (BF16). Las pruebas que se llevaron a cabo en los laboratorios de rendimiento de AMD el 18 de septiembre de 2020, en el acelerador AMD Instinct™ MI100 (tarjeta PCIe® con HBM2 de 32 GB) a una frecuencia de reloj de motor con impulso máximo de 1502 MHz, arrojaron como resultado un rendimiento de punto flotante máximo teórico de 11,54 TFLOPS de precisión doble máxima teórica (FP64); 46,1 TFLOPS de matriz de precisión simple máxima teórica (FP32); 23,1 TFLOPS de precisión simple máxima teórica (FP32); 184,6 TFLOPS de rendimiento de punto flotante de precisión media máxima teórica (FP16). Los resultados publicados del acelerador de GPU NVIDIA Ampere A100 (80 GB), con una frecuencia de reloj de motor con impulso máximo de 1410 MHz, arrojaron como resultado 19,5 TFLOPS de precisión doble máxima (núcleo Tensor FP64) y 9,7 TFLOPS de precisión doble máxima (FP64). 19,5 TFLOPS de precisión simple máxima (FP32), 78 TFLOPS de precisión media máxima (FP16), 312 TFLOPS de precisión media máxima (flujo Tensor FP16), 39 TFLOPS de Bfloat16 máxima (BF16), 312 TFLOPS de rendimiento de punto flotante de precisión de formato Bfloat16 máxima teórica (flujo Tensor BF16). El formato de datos TF32 no cumple con la norma IEEE y no se incluye en esta comparación. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-ampere-architecture-whitepaper.pdf, página 15, tabla 1. MI200-01

- Las mediciones realizadas por los laboratorios de rendimiento de AMD el 21 de septiembre del 2021 en los aceleradores AMD Instinct™ MI250X y MI250 (HBM2e de 128 GB) OAM, diseñados con la tecnología de procesos FinFET de 6 nm de AMD CDNA™ 2, a una frecuencia de reloj de memoria máxima de 1600 MHz, arrojaron como resultado un rendimiento de ancho de banda de memoria máximo teórico de 3,2768 TFLOP. La interfaz del bus de memoria de MI250/MI250X es 4096 bits por dos chips y la frecuencia de datos de memoria es 3,20 GB/s para un ancho de banda de memoria total de 3,2768 TB/s ([3,20 GB/s*[4096 bits*2]/8). Los resultados más altos publicados acerca del acelerador NVIDIA Ampere A100 (80 GB) SXM dieron como resultado un rendimiento de ancho de banda de memoria de GPU de 2039 TB/s. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-07

- Las mediciones que los laboratorios de rendimiento de AMD realizaron el 21 de septiembre del 2021 en los aceleradores AMD Instinct™ MI250X y MI250 (OAM), diseñados con la tecnología de procesos FinFET de 6 nm de AMD CDNA™ 2, a una velocidad de reloj de memoria máxima de 1600 MHz, dieron como resultado una capacidad de memoria de 128 GB HBMe. Las especificaciones publicadas acerca de los aceleradores NVIDIA Ampere A100 (80 GB) SXM y A100 (PCIe®) revelaron una capacidad de memoria de 80 GB. Resultados publicados en: https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-18

- Pruebas realizadas por los laboratorios de rendimiento de AMD el 11 de febrero del 2022 usando HPCG 3.0 para comparar dos sistemas: Servidor 2P con tecnología EPYC™ 7763, SMT deshabilitado, con una, dos y cuatro GPU AMD Instinct™ MI250 (HBM2e de 128 GB) de 560 W, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 en comparación con un servidor 2P con AMD EPYC™ 7742, con una, dos y cuatro GPU NVIDIA Ampere A100 de 80 GB SXM de 400 W, SBIOS 0.34, Ubuntu 20.04.4 y CUDA 11.6. Contenedor HPCG 3.0: nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg en https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-70A.

- Pruebas llevadas a cabo por laboratorios de rendimiento de AMD el 14/11/2022 con HPL para comparar dos sistemas. Servidor 2P con tecnología EPYC™ 7763, SMT desactivado, con una, dos y cuatro GPU AMD Instinct™ MI250 (HBM2e de 128 GB) de 560 W, host ROCm 5.2.0 rocHPL6.0.0. El contenedor HPL de AMD aún no está disponible en Infinity Hub en comparación con el servidor 2P AMD EPYC™ 7742, SMT habilitado, con una, dos y cuatro GPU NVIDIA Ampere A100 de 80 GB SXM de 400 W, CUDA 11.6 y versión del controlador 510.47.03. El contenedor HPL (nvcr.io/nvidia/hpc-benchmarks:21.4-hpl) se obtuvo en https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-69A.

- La comparación HPL-AI se basa en pruebas internas de AMD llevadas a cabo el 2/11/2022 en las que se midió el rendimiento de la evaluación comparativa HPL-AI (TFLOP) con un servidor con dos EPYC 7763 con cuatro MI250 (HBM2e de 128 MB) con tecnología en la que se ejecutó el host ROCm 5.2.0, HPL-AI-AMD v1.0.0 en comparación con un servidor con dos EPYC 7742 con cuatro A100 SXM (HBM2e de 80 GB) en los que se ejecuta CUDA 11.6, HPL-AI-NVIDIA v2.0.0, contenedor nvcr.io/nvidia/hpc-benchmarks:21.4-hpl. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-81.

- Pruebas llevadas a cabo en los laboratorios de rendimiento de AMD el 25/11/2022 con PyFR TGV y NACA 0021 para comparar los dos sistemas: Servidor 2P con tecnología EPYC™ 7763, SMT deshabilitado, con una GPU AMD Instinct™ MI250 (HBM2e de 128 GB) de 560 W, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 en comparación con un servidor 2P con AMD EPYC™ 7742, SMT habilitado, con una GPU NVIDIA Ampere A100 de 80 GB SXM de 400 W, SBIOS 0.34, Ubuntu 20.04.4 y CUDA 11.6. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-82.

- Pruebas realizadas por el laboratorio de rendimiento de AMD el 14/4/2023 con OpenFOAM v2206 en un servidor de producción de CPU 2P EPYC 7763 con 1, 2 y 4 GPU AMD Instinct™ MI250 (128 GB, 560 W) con tecnología AMD Infinity Fabric habilitada, ROCm™ 5.3.3, Ubuntu® 20.04.4 frente a un servidor de producción de CPU 2P EPYC 7742 con 1, 2 y 4 GPU NVIDIA A100 de 80 GB SXM (400 W) con tecnología NVLink habilitada, CUDA® 11.8, Ubuntu 20.04.4. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones.

- Pruebas llevadas a cabo en los laboratorios de rendimiento de AMD el 26/8/22 con AMBER: Cellulose_production_NPT_4fs, Cellulose_production_NVE_4fs, FactorIX_production_NPT_4fs, FactorIX_production_NVE_4fs, STMV_production_NPT_4fs, STMV_production_NVE_4fs, JAC_production_NPT_4fs y JAC production_NVE_4fs. Comparación de dos sistemas: Servidor 2P con tecnología EPYC™ 7763 con una GPU AMD Instinct™ MI250 (HBM2e de 128 GB) de 560 W, ROCm 5.2.0 y un contenedor Amber 22.amd_100 en comparación con un servidor 2P con tecnología EPYC™ 7742 con una GPU NVIDIA A100 SXM (HBM2e de 80 GB) de 400 W, con MPS habilitado (dos instancias) y CUDA 11.6. MI200-73.

- Pruebas realizadas por los laboratorios de rendimiento de AMD el 18 de octubre del 2022 usando Gromacs STMV0 para comparar dos sistemas: Servidor 2P con tecnología EPYC™ 7763 con cuatro GPU AMD Instinct™ MI250 (HBM2e de 128 GB) de 560 W con tecnología Infinity Fabric™, ROCm™ 5.2.0 y un contenedor Gromacs 2022.3.amd1_174, en comparación con las declaraciones públicas de NVIDIA disponibles en https://developer.nvidia.com/hpc-application-performance. (Gromacs 2022.2). EPYC 7742 doble con cuatro GPU NVIDIA Ampere A100 SXM de 80 GB. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según determinados factores, incluido el uso de los controladores más recientes y las optimizaciones. MI200-74.

- Pruebas llevadas a cabo en los laboratorios de rendimiento de AMD 109.0322.22 con LAMMPS: EAM, LJ, ReaxFF y Tersoff que comparan dos sistemas: Servidor 2P con tecnología EPYC™ 7763 con cuatro GPU AMD Instinct™ MI250 (HBM2e de 128 GB) de 560 W, ROCm 5.2.0 y contenedor LAMMPS 2021.5.14_121amdih/lammps:2022.5.04_130 en comparación con las declaraciones públicas de NVIDIA, disponibles en http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. (Estable, 23 de junio del 2022, actualización 1). Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-77.

- Pruebas llevadas a cabo en los laboratorios de rendimiento de AMD el 13/9/22 con NAMD: STMV_NNV, APOA1_NVE que compara dos sistemas: Servidor 2P con tecnología EPYC™ 7763 con una, dos y cuatro GPU AMD Instinct™ MI250 (HMB2e de 128 GB) de 560 W con tecnología AMD Infinity Fabric™, ROCm 5.2.0 y contenedor NAMD namd3:3.0a9 en comparación con las declaraciones públicas de NVIDIA sobre el rendimiento de un servidor 2P con EPYC 7742 con una, dos y cuatro GPU NVIDIA Ampere A100 de 80 GB SXM, disponibles en https://developer.nvidia.com/hpc-application-performance. (v2.15a AVX-512). Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-76.

- Pruebas llevadas a cabo en los laboratorios de rendimiento de AMD, realizadas el 14/11/2022 en un socket 2P con CPU AMD EPYC™ 7763 Supermicro 4124 con ocho GPU AMD Instinct™ MI210 (PCIe® de 64 GB y 300 W), con la tecnología AMD Infinity Fabric™ habilitada. Ubuntu 18.04.6 LTS, Host ROCm 5.2.0, rocHPL 6.0.0. Los resultados se calcularon a partir de los promedios de cinco ejecuciones en comparación con las pruebas llevadas a cabo en los laboratorios de rendimiento de AMD en un socket 2P AMD EPYC™ 7763 Supermicro 4124 con ocho GPU NVIDIA A100 (PCIe de 80 GB y 300 W), Ubuntu 18.04.6 LTS, CUDA 11.6, imagen del contenedor HPL de NVIDIA 21.4-HPL. Todos los resultados se midieron en sistemas configurados con 8 GPU; 2 pares de 4 GPU MI210 conectadas mediante un puente de 4 vías Infinity Fabric™; 4 pares de 2 GPU PCIe 2xA100 de 80 GB conectados mediante puentes NVLink de 2 vías. Información sobre HPL: https://www.netlib.org/benchmark/hpl/. Detalles del contenedor HPL de AMD: El contenedor HPL aún no está disponible en Infinity Hub. Detalle del contenedor HPL de NVIDIA: https://ngc.nvidia.com/catalog/containers/nvidia:hpc-benchmarks. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-49A.

- La comparación HPL-AI se basa en pruebas internas de AMD llevadas a cabo el 2/11/2022 en las que se midió el rendimiento de la evaluación comparativa HPL-AI (TFLOP) con un servidor con dos EPYC 7763 con ocho MI210 HBM2e de 64 MB con tecnología Infinity Fabric en la que se ejecutó el host ROCm 5.2.0 HPL-AI-AMD v1.0.0; el contenedor AMD HPL-AI aún no está disponible en Infinity Hub, en comparación con un servidor con dos EPYC 7763 con ocho A100 PCIe HBM2e de 80 GB en los que se ejecuta CUDA 11.6, HPL-AI-NVIDIA v2.0.0, contenedor nvcr.io/nvidia/hpc-benchmarks:21.4-hpl. Los fabricantes de servidores pueden variar las configuraciones, lo que da lugar a resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-83.

- Pruebas llevadas a cabo en los laboratorios de rendimiento de AMD en un socket 2P con CPU AMD EPYC™ 7763 Supermicro 4124 con cuatro y ocho GPU AMD Instinct™ MI210 (PCIe® de 64 GB y 300 W), con la tecnología AMD Infinity Fabric™ habilitada. SBIOS2.2, Ubuntu® 18.04.6 LTS, host ROCm™ 5.2.0. Contenedor AMMPS amdih-2022.5.04_130 (ROCm 5.1) en comparación con las declaraciones públicas de NVIDIA para cuatro y ocho GPU PCIe A100 de 80 GB http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI200-47A.