内部のテクノロジ

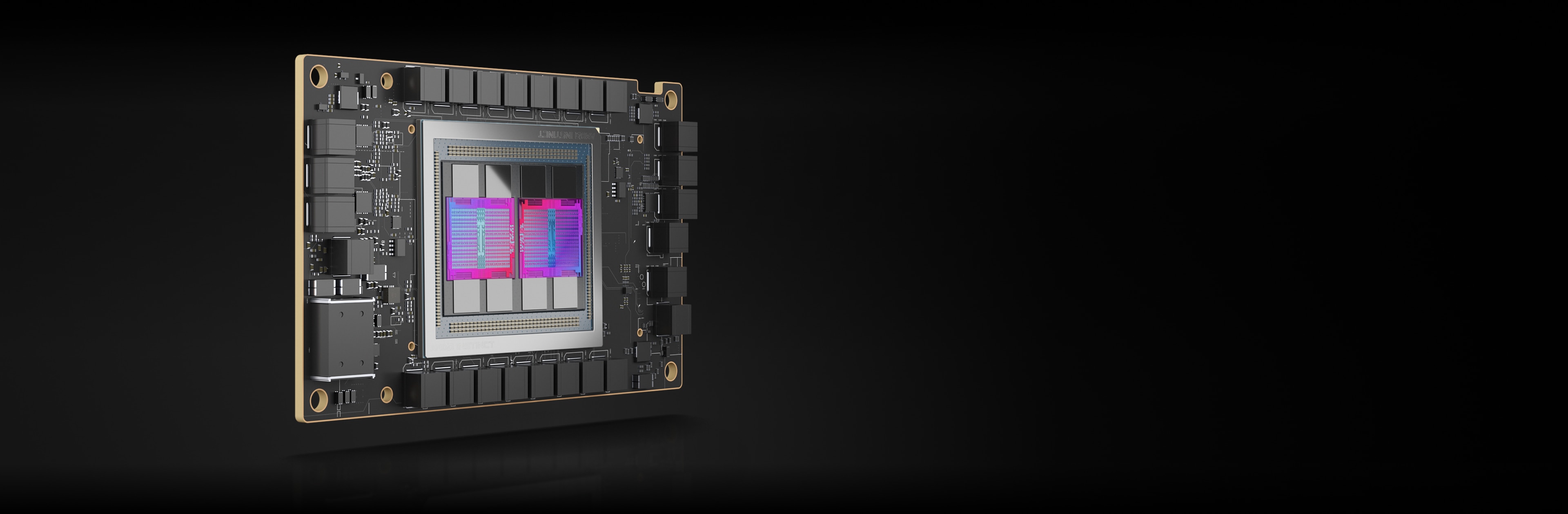

AMD Instinct アクセラレータは、マトリックス コア テクノロジを提供し、高効率の INT8 および FP8 から HPC 向けの最も要求の厳しい FP64 まで、幅広い精度の機能をサポートする AMD CDNA™ アーキテクチャを基盤としています。

AMD Instinct MI250X アクセラレータ

AMD Instinct MI250X アクセラレータは、世界トップクラスのスーパーコンピューターで威力を発揮しています。

220 CU

220 個の GPU 演算ユニット

128GB

128GB HBM2e メモリ

3.2TB/s

3.2TB/s のピーク メモリ帯域幅

400 GB/s

400 GB/s のピーク Infinity Fabric 総帯域幅

仕様比較

最大 383 TFLOPS のピーク理論半精度 (FP16) 性能と、競合 GPU と比較して最大 1.6 倍多いメモリ容量と帯域幅により、最も要求の厳しい AI ワークロードに対応2、3、4

MI250X

A100

最大 47.9 TFLOPs FP64、最大 95.7 TFLOPs FP64 マトリックスのピーク理論性能を提供し、競合 GPU と比較して最大 4 倍のアドバンテージを実現します。2

MI250X

A100

*TF32 データ形式は IEEE に準拠しておらず、この比較には含まれていません。

AMD Instinct MI250 アクセラレータ

AMD Instinct MI250 アクセラレータは、企業、研究、および研究関連のユース ケースにおいて、卓越した HPC および AI パフォーマンスを発揮します。

208 CU

208 個の GPU 演算ユニット

128GB

128GB HBM2e メモリ

3.2TB/s

3.2TB/s のピーク メモリ帯域幅

100GB/s

100GB/s のピーク Infinity Fabric™ リンク帯域幅

パフォーマンス ベンチマーク

HPCG 3.0: HPCG (High Performance Conjugate Gradients) ベンチマークは、HPC システムをランキングするための指標です。HPCG は、現在 TOP500 コンピューティング システムのランク付けに使用されている HPL (High Performance LINPACK) ベンチマークを補完することを目的としています。5

メトリクス |

1 x MI250 |

2 x MI250 |

4 x MI250 |

GFLOPS |

488.8 |

972.6 |

1927.7 |

HPL: HPL とは、高性能 Linpack ベンチマークの実装のことです。このコードは、一様でランダムな連立一次方程式を解き、演算回数に関する標準的な式を使用して、時間と浮動小数点の演算実行レートを報告します。6

メトリクス |

1 x MI250 |

2 x MI250 |

4 x MI250 |

TFLOPS |

40.45 |

80.666 |

161.97 |

HPL_AI (High Performance LINPACK for Accelerator Introspection) は、新しい混合精度アルゴリズムを使用して連立一次方程式を解くことにより、HPC と AI のワークロードの集約を強調するベンチマークです。7

メトリクス |

テスト モジュール |

4 x MI250 |

TFLOPS |

FP16/32/64 の混合 |

930.44 |

PyFR とは、Huynh のフラックス再構成アプローチを使ってストリーミング アーキテクチャ上で移流拡散タイプの問題を解くための、オープンソースの Python ベース フレームワークです。このフレームワークは、さまざまなタイプの要素を含む混合非構造グリッド上で一連の支配方程式を解くことができるように設計されています。8

メトリクス |

テスト モジュール |

1 x MI250 |

シミュレーション/日 |

TGV |

41.73 |

OpenFOAM (「Open-source Field Operation And Manipulation」の略) は、カスタマイズされた数値ソルバー、および連続体力学問題 (特に数値流体力学 (CFD) を含む) 解決に要する前処理/後処理ユーティリティを開発するための、C++ ツールボックスです。9

メトリクス |

テスト モジュール |

1 x MI250 |

2 x MI250 |

4 x MI250 |

時間 (秒) |

HPC Motorbike (大きければ良いというものではない) |

662.3 |

364.26 |

209.84 |

Amber とは、生体分子シミュレーション プログラム群のことで、"Amber" という言葉には 2 つの意味があります。最初の意味は、生体分子のシミュレーションのための分子力学的力場のセットであるということです。もう一つの意味は、ソース コードとデモを含む分子シミュレーション プログラムのパッケージであるということです。10

アプリケーション |

メトリクス |

テスト モジュール |

値が大きいほど良好 |

1 x MI250 |

AMBER |

ns/日 |

セルロース生産 NPT 4fs |

〇 |

227.2 |

AMBER |

ns/日 |

セルロース生産 NVE 4fs |

〇 |

242.4 |

AMBER |

ns/日 |

IX 因子生産 NPT 4fs |

〇 |

803.1 |

AMBER |

ns/日 |

IX 因子生産 NVE 4fs |

〇 |

855.2 |

AMBER |

ns/日 |

JAC 生産 NPT 4fs |

〇 |

1794 |

AMBER |

ns/日 |

JAC 生産 NVE 4fs |

〇 |

1871 |

AMBER |

ns/日 |

STMV 生産 NPT 4fs |

〇 |

80.65 |

AMBER |

ns/日 |

STMV 生産 NVE 4fs |

〇 |

86.7 |

GROMACS は、主にタンパク質、脂質、核酸のシミュレーション用に設計された分子動力学パッケージです。もともとはフローニンゲン大学の生物物理化学部門で開発され、現在は世界中の大学や研究センターの貢献者によって維持されています。11

アプリケーション |

メトリクス |

テスト モジュール |

値が大きいほど良好 |

1 x MI250 |

2 x MI250 |

4 x MI250 |

GROMACS |

ns/日 |

STMV |

〇 |

34.2 |

61.812 |

89.26 |

LAMMPS は、材料モデリングに焦点を当てた古典的な分子動力学コードです。LAMMPS は Large-scale Atomic/Molecular Massively Parallel Simulator の頭文字をとったものです。固体材料 (金属、半導体)、軟質材料 (生体分子、高分子)、粗視化またはメゾスコピック系に対して、LAMMPS は可能性を秘めています。12

アプリケーション |

メトリクス |

テスト モジュール |

値が大きいほど良好 |

1 x MI250 |

2 x MI250 |

4 x MI250 |

LAMMPS |

原子時間ステップ/秒 |

LJ |

〇 |

6E+08 |

1E+09 |

2E+09 |

LAMMPS |

原子時間ステップ/秒 |

ReaxFF |

〇 |

7E+06 |

1E+07 |

3E+07 |

LAMMPS |

原子時間ステップ/秒 |

Tersoff |

〇 |

5E+08 |

1E+09 |

2E+09 |

NAMD は、生体分子の時間的な動きをシミュレーションするように設計された分子動力学パッケージです。大規模な生体分子系に適しており、10 億個以上の原子を持つ系のシミュレーションに使用され、数千の CPU コアや GPU 上で驚異的なスケーラビリティを発揮しています。13

アプリケーション |

メトリクス |

テスト モジュール |

値が大きいほど良好 |

1 x MI250 |

2 x MI250 |

4 x MI250 |

NAMD 3.0 |

ns/日 |

APOA1_NVE |

〇 |

221.4 |

443.61 |

879.43 |

NAMD 3.0 |

ns/日 |

STMV_NVE |

〇 |

19.87 |

39.545 |

77.132 |

AMD Instinct MI210 アクセラレータ

AMD Instinct MI210 アクセラレータは、シングルサーバー ソリューションなどで、企業、研究機関、学術機関の HPC および AI ワークロードを強力にサポートします。

104 CU

104 個の GPU 演算ユニット

64GB

64GB HBM2e メモリ

1.6TB/s

1.6TB/s のピーク メモリ帯域幅

100GB/s

100GB/s のピーク Infinity Fabric™ リンク帯域幅

パフォーマンス ベンチマーク

HPL: HPL とは、高性能 Linpack ベンチマークの実装のことです。このコードは、一様でランダムな連立一次方程式を解き、演算回数に関する標準的な式を使用して、時間と浮動小数点の演算実行レートを報告します。14

メトリクス |

値が大きいほど良好 |

1 x MI210 |

2 x MI210 |

4 x MI210 | 8 x MI210 |

TFLOPS |

〇 |

21.07 |

40.878 |

81.097 | 159.73 |

HPL-AI: HPL_AI (High Performance LINPACK for Accelerator Introspection) は、新しい混合精度アルゴリズムを使用して連立一次方程式を解くことにより、HPC と AI のワークロードの集約を強調するベンチマークです。15

メトリクス |

テスト モジュール |

値が大きいほど良好 |

4 x MI210 |

8 x MI210 |

TFLOPS |

FP16/32/64 の混合 |

〇 |

444.77 |

976.18 |

LAMMPS: LAMMPS は、材料モデリングに焦点を当てた古典的な分子動力学コードです。LAMMPS は Large-scale Atomic/Molecular Massively Parallel Simulator の頭文字をとったものです。固体材料 (金属、半導体)、軟質材料 (生体分子、高分子)、粗視化またはメゾスコピック系に対して、LAMMPS は可能性を秘めています。16

メトリクス |

テスト モジュール |

値が大きいほど良好 |

4 x MI210 | 8 x MI210 |

原子時間ステップ/秒 |

ReaxFF |

〇 |

1E+07 | 3E+07 |

最新情報を入手する

サインアップして、最新のデータセンター ニュースとサーバー コンテンツを受信します。

脚注

- Top 500 リスト、2023 年 6 月

- AMD Instinct™ MI250X は、世界最速のデータセンター向け GPU です。2021 年 9 月 15 日に AMD パフォーマンス ラボで次のシステムを使用してテストを実施しました。AMD Instinct™ MI250X (128 GB HBM2e OAM モジュール) アクセラレータを 1,700 MHz のピーク ブースト エンジン クロックで計測したところ、結果は次のようになりました。95.7 TFLOPS のピーク理論倍精度 (FP64 マトリックス)、47.9 TFLOPS のピーク理論倍精度 (FP64)、95.7 TFLOPS のピーク理論単精度マトリックス (FP32 マトリックス)、47.9 TFLOPS のピーク理論単精度 (FP32)、383.0 TFLOPS のピーク理論半精度 (FP16)、383.0 TFLOPS のピーク理論 Bfloat16 形式精度 (BF16) 浮動小数点演算パフォーマンス。2020 年 9 月 18 日に AMD パフォーマンス ラボで次のシステムを使用して計算を実施しました。AMD Instinct™ MI100 (32 GB HBM2 PCIe® カード) アクセラレータを 1,502 MHz のピーク ブースト エンジン クロックで実行した結果、11.54 TFLOPS のピーク理論倍精度 (FP64)、46.1 TFLOPS のピーク理論単精度マトリックス (FP32)、23.1 TFLOPS のピーク理論単精度 (FP32)、184.6 TFLOPS のピーク理論半精度 (FP16) 浮動小数点演算パフォーマンスが得られました。NVidia Ampere A100 (80 GB) GPU アクセラレータを 1,410 MHz のブースト エンジン クロックで実施したテストの公開結果は次のようになっています。19.5 TFLOPS のピーク時倍精度 (FP64 Tensor Core)、9.7 TFLOPS のピーク時倍精度 (FP64)。19.5 TFLOPS のピーク単精度 (FP32)、78 TFLOPS のピーク半精度 (FP16)、312 TFLOPS のピーク半精度 (FP16 Tensor Flow)、39 TFLOPS のピーク Bfloat16 (BF16)、312 TFLOPS のピーク Bfloat16 形式精度 (BF16 Tensor Flow)、理論浮動小数点演算パフォーマンス。TF32 データ形式は IEEE に準拠しておらず、この比較には含まれていません。https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-ampere-architecture-whitepaper.pdf、15 ページ、表 1。MI200-01

- 2021 年 9 月 21 日に AMD パフォーマンス ラボで計算を実施しました。AMD CDNA™ 2 6 nm FinFET プロセス テクノロジで設計された AMD Instinct™ MI250X と MI250 (128 GB HBM2e) OAM アクセラレータを 1,600 MHz のピーク メモリ クロックで実行した結果、3.2768 TFLOPS のピーク メモリの理論帯域幅パフォーマンスが得られました。MI250/MI250X メモリ バス インターフェイスは 4,096 ビット x 2 ダイで、メモリ データ レートは 3.2768 TB/s ((3.20 Gbps* (4,096 ビット * 2))/8) のトータル メモリ帯域幅に対して 3.20 Gbps です。NVIDIA Ampere A100 (80 GB) SXM GPU アクセラレータで公表されている最高の結果は 2.039 TB/s の GPU メモリ帯域幅パフォーマンスとなっています。https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-07

- 2021 年 9 月 21 日、AMD パフォーマンス ラボが次のシステムを使用して実施しました。1,600 MHz ピーク メモリ クロックの AMD CDNA™ 2 6 nm FinFET プロセス テクノロジで設計された AMD Instinct™ MI250X および MI250 (OAM) アクセラレータ。計算結果は、128 GB HBMe メモリ容量となっています。NVIDIA Ampere A100 (80 GB) SXM および A100 アクセラレータ (PCIe®) の公開仕様では 80 GB メモリ容量が記載されています。結果は次でご覧いただけます。https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-18

- テストでは、2022 年 11 月 2 日に AMD パフォーマンス ラボが HPCG 3.0 を使用して 2 つのシステムを比較しました。2P EPYC™ 7763 搭載サーバー (SMT 無効) + 1x、2x、および 4x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU、SBIOS M12、Ubuntu 20.04.4、Host ROCm 5.2.0。これに対する比較テストのシステム構成が、2P AMD EPYC™ 7742 サーバー + 1x、2x、および 4x NVIDIA Ampere A100 80 GB SXM 400 W GPU、SBIOS 0.34、Ubuntu 20.04.4、CUDA 11.6。HPCG 3.0 コンテナー: nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg は https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks から入手できます。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-70A。

- テストでは、2022 年 11 月 14 日に AMD パフォーマンス ラボが HPL を使用して次の 2 つのシステムを比較しました。2P EPYC™ 7763 搭載サーバー (SMT 無効) + 1x、2x および 4x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU、ホスト ROCm 5.2.0 rocHPL6.0.0。AMD HPL コンテナーは Infinity Hub でまだ利用できません。これに対する比較テストのシステム構成は、2P AMD EPYC™ 7742 サーバー (SMT 無効) + 1x、2x および 4x NVIDIA Ampere A100 80 GB SXM 400 W GPU、CUDA 11.6、ドライバー バージョン 510.47.03。HPL コンテナー (nvcr.io/nvidia/hpc-benchmarks:21.4-hpl) は https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks から入手できます。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-69A。

- HPL-AI の比較テストは、2022 年 11 月 2 日に AMD 社内で実施され、HPL-AI ベンチマーク パフォーマンス (TFLOPS) が測定されました。テストに使用したサーバーのシステム構成は次のとおりです。2x EPYC 7763 + 4x MI250 128 MB HBM2e、ホスト ROCm 5.2.0、HPL-AI-AMD v1.0.0。これに対する比較テストのシステム構成が 2x EPYC 7742 + 4x A100 SXM 80 GB HBM2e、CUDA 11.6、HPL-AI-NVIDIA v2.0.0、コンテナー nvcr.io/nvidia/hpc-benchmarks:21.4-hpl。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-81。

- テストでは、2022 年 11 月 25 日に AMD パフォーマンス ラボが PyFR TGV と NACA 0021 を使用して次の 2 つのシステムを比較しました。2P EPYC™ 7763 搭載サーバー (SMT 無効) + 1x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU、SBIOS M12、Ubuntu 20.04.4、ホスト ROCm 5.2.0。これに対する比較テストのシステム構成が、2P AMD EPYC™ 7742 サーバー (SMT 有効) + 1x NVIDIA Ampere A100 80 GB SXM 400 W GPU、SBIOS 0.34、Ubuntu 20.04.4、CUDA 11.6。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-82。

- テストでは、2023 年 4 月 14 日に AMD パフォーマンス ラボが OpenFOAM v2206 を使用して次の 2 つのシステムを比較しました。AMD Infinity Fabric™ テクノロジが有効な 1x、2x、4x の AMD Instinct™ MI250 GPU (128 GB、560 W) を搭載した 2P EPYC 7763 CPU のプロダクション サーバー、ROCm™ 5.3.3、Ubuntu® 20.04.4。比較対象が、NVLink テクノロジが有効な 1x、2x、4x の NVIDIA A100 80 GB SXM GPUs (400 W) を搭載した 2P EPYC 7742 CPU のプロダクション サーバー、CUDA® 11.8、Ubuntu 20.04.4。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。

- テストは、2022 年 8 月 26 日に AMD パフォーマンス ラボが AMBER を使用して実施しました。Cellulose_production_NPT_4fs、Cellulose_production_NVE_4fs、FactorIX_production_NPT_4fs、FactorIX_production_NVE_4fs、STMV_production_NPT_4fs、STMV_production_NVE_4fs、JAC_production_NPT_4fs および JAC production_NVE_4fs。比較した 2 種類のシステム構成: 2P EPYC™ 7763 搭載サーバー + 1x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU、ROCm 5.2.0、Amber コンテナー 22.amd_100。これに対する比較テストのシステム構成が、2P EPYC™ 7742 搭載サーバー + 1x NVIDIA A100 SXM (80 GB HBM2e) 400 W GPU (MPS 有効化、2 インスタンス)、CUDA 11.6。MI200-73。

- テストは、2022 年 10 月 18 日時点の AMD パフォーマンス ラボが Gromacs STMV を使用して 2 つのシステムを比較しました。2P EPYC™ 7763 搭載サーバー + 4x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU + Infinity Fabric™ テクノロジ、ROCm™ 5.2.0、Gromacs コンテナー 2022.3.amd1_174。これに対する比較テストのシステム構成が、NVIDIA 公称値 (https://developer.nvidia.com/hpc-application-performance)。(Gromacs 2022.2)。デュアル EPYC 7742 + 4x NVIDIA Ampere A100 SXM 80 GB GPU。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無などの要素によって、パフォーマンスが異なる可能性があります。MI200-74。

- テストは、109.0322.22 に AMD パフォーマンス ラボが LAMMPS: EAM、LJ、ReaxFF、Tersoff の 2 つのシステムを比較: 2P EPYC™ 7763 搭載サーバー + 4x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU + ROCm 5.2.0、LAMMPS コンテナー 2021.5.14_121amdih/lammps:2022.5.04_130。これに対する比較テストのシステム構成が、NVIDIA 公称値 (http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance)。(stable 23Jun2022 update 1)。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-77。

- テストは、2022 年 9 月 13 日に AMD パフォーマンス ラボが NAMD: STMV_NVE、APOA1_NVE の 2 つのシステムを比較: 2P EPYC™ 7763 搭載サーバー + 1x、2x および 4x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU + AMD Infinity Fabric™ テクノロジ、ROCm 5.2.0、NAMD コンテナー namd3:3.0a9。これに対する比較テストのシステム構成が、NVIDIA パフォーマンス公称値: 2P EPYC 7742 サーバー + 1x、2x、および 4x NVIDIA Ampere A100 80 GB SXM GPU (https://developer.nvidia.com/hpc-application-performance)。(v2.15a AVX-512)。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-76。

- テストは、2022 年 11 月 14 日に AMD パフォーマンス ラボが次のシステム構成で実施しました。2P ソケット AMD EPYC™ 7763 CPU Supermicro 4124 + 8x AMD Instinct™ MI210 GPU (PCIe® 64 GB、300 W) + AMD Infinity Fabric™ テクノロジ。Ubuntu 18.04.6 LTS、ホスト ROCm 5.2.0、rocHPL 6.0.0。5 回の実行の中央値から結果を算出。比較テストは、AMD パフォーマンス ラボが次のシステム構成で実施しました。2P ソケット AMD EPYC™ 7763 Supermicro 4124 + 8x NVIDIA A100 GPU (PCIe 80 GB 300 W)、Ubuntu 18.04.6 LTS、CUDA 11.6、HPL NVIDIA コンテナー イメージ 21.4-HPL。すべての結果は、4 ウェイ Infinity Fabric™ リンク ブリッジで接続された 2 組の 4xMI210 GPU、2 ウェイ NVLink ブリッジで接続された 4 組の 2xA100 80 GB PCIe GPU、合計 8 GPU で構成されたシステムで測定されています。HPL に関する情報: https://www.netlib.org/benchmark/hpl/。AMD HPL コンテナーの詳細: HPL コンテナーは Infinity Hub でまだ利用できません。NVIDIA HPL コンテナーの詳細: https://ngc.nvidia.com/catalog/containers/nvidia:hpc-benchmarks。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-49A。

- HPL-AI の比較テストは、2022 年 11 月 2 日に AMD 社内で実施され、HPL-AI ベンチマーク パフォーマンス (TFLOPS) が測定されました。テストに使用したサーバーのシステム構成は次のとおりです。2x EPYC 7763 + 8x MI210 64 MB HBM2e + Infinity Fabric テクノロジ、ホスト ROCm 5.2.0、HPL-AI-AMD v1.0.0、AMD HPL-AI コンテナー (Infinity Hub ではまだ利用できません)。これに対する比較テストのシステム構成が 2x EPYC 7763 + 8x A100 PCIe 80 GB HBM2e、CUDA 11.6、HPL-AI-NVIDIA v2.0.0、コンテナー nvcr.io/nvidia/hpc-benchmarks:21.4-hpl。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-83。

- テストは AMD パフォーマンス ラボが 2022 年 10 月 3 日に次のシステム構成で実施しました。2P ソケット AMD EPYC™ 7763 CPU Supermicro 4124 + 4x および 8x AMD Instinct™ MI210 GPU (PCIe® 64 GB、300 W) + AMD Infinity Fabric™ テクノロジ。SBIOS2.2、Ubuntu® 18.04.6 LTS、ホスト ROCm™ 5.2.0。LAMMPS コンテナー amdih-2022.5.04_130 (ROCm 5.1)。これに対する比較テストのシステム構成が、NVIDIA 公称値: 4x および 8x A100 PCIe 80 GB GPU (http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance)。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-47A。

- Top 500 リスト、2023 年 6 月

- AMD Instinct™ MI250X は、世界最速のデータセンター向け GPU です。2021 年 9 月 15 日に AMD パフォーマンス ラボで次のシステムを使用してテストを実施しました。AMD Instinct™ MI250X (128 GB HBM2e OAM モジュール) アクセラレータを 1,700 MHz のピーク ブースト エンジン クロックで計測したところ、結果は次のようになりました。95.7 TFLOPS のピーク理論倍精度 (FP64 マトリックス)、47.9 TFLOPS のピーク理論倍精度 (FP64)、95.7 TFLOPS のピーク理論単精度マトリックス (FP32 マトリックス)、47.9 TFLOPS のピーク理論単精度 (FP32)、383.0 TFLOPS のピーク理論半精度 (FP16)、383.0 TFLOPS のピーク理論 Bfloat16 形式精度 (BF16) 浮動小数点演算パフォーマンス。2020 年 9 月 18 日に AMD パフォーマンス ラボで次のシステムを使用して計算を実施しました。AMD Instinct™ MI100 (32 GB HBM2 PCIe® カード) アクセラレータを 1,502 MHz のピーク ブースト エンジン クロックで実行した結果、11.54 TFLOPS のピーク理論倍精度 (FP64)、46.1 TFLOPS のピーク理論単精度マトリックス (FP32)、23.1 TFLOPS のピーク理論単精度 (FP32)、184.6 TFLOPS のピーク理論半精度 (FP16) 浮動小数点演算パフォーマンスが得られました。NVidia Ampere A100 (80 GB) GPU アクセラレータを 1,410 MHz のブースト エンジン クロックで実施したテストの公開結果は次のようになっています。19.5 TFLOPS のピーク時倍精度 (FP64 Tensor Core)、9.7 TFLOPS のピーク時倍精度 (FP64)。19.5 TFLOPS のピーク単精度 (FP32)、78 TFLOPS のピーク半精度 (FP16)、312 TFLOPS のピーク半精度 (FP16 Tensor Flow)、39 TFLOPS のピーク Bfloat16 (BF16)、312 TFLOPS のピーク Bfloat16 形式精度 (BF16 Tensor Flow)、理論浮動小数点演算パフォーマンス。TF32 データ形式は IEEE に準拠しておらず、この比較には含まれていません。https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-ampere-architecture-whitepaper.pdf、15 ページ、表 1。MI200-01

- 2021 年 9 月 21 日に AMD パフォーマンス ラボで計算を実施しました。AMD CDNA™ 2 6 nm FinFET プロセス テクノロジで設計された AMD Instinct™ MI250X と MI250 (128 GB HBM2e) OAM アクセラレータを 1,600 MHz のピーク メモリ クロックで実行した結果、3.2768 TFLOPS のピーク メモリの理論帯域幅パフォーマンスが得られました。MI250/MI250X メモリ バス インターフェイスは 4,096 ビット x 2 ダイで、メモリ データ レートは 3.2768 TB/s ((3.20 Gbps* (4,096 ビット * 2))/8) のトータル メモリ帯域幅に対して 3.20 Gbps です。NVIDIA Ampere A100 (80 GB) SXM GPU アクセラレータで公表されている最高の結果は 2.039 TB/s の GPU メモリ帯域幅パフォーマンスとなっています。https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-07

- 2021 年 9 月 21 日、AMD パフォーマンス ラボが次のシステムを使用して実施しました。1,600 MHz ピーク メモリ クロックの AMD CDNA™ 2 6 nm FinFET プロセス テクノロジで設計された AMD Instinct™ MI250X および MI250 (OAM) アクセラレータ。計算結果は、128 GB HBMe メモリ容量となっています。NVIDIA Ampere A100 (80 GB) SXM および A100 アクセラレータ (PCIe®) の公開仕様では 80 GB メモリ容量が記載されています。結果は次でご覧いただけます。https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-18

- テストでは、2022 年 11 月 2 日に AMD パフォーマンス ラボが HPCG 3.0 を使用して 2 つのシステムを比較しました。2P EPYC™ 7763 搭載サーバー (SMT 無効) + 1x、2x、および 4x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU、SBIOS M12、Ubuntu 20.04.4、Host ROCm 5.2.0。これに対する比較テストのシステム構成が、2P AMD EPYC™ 7742 サーバー + 1x、2x、および 4x NVIDIA Ampere A100 80 GB SXM 400 W GPU、SBIOS 0.34、Ubuntu 20.04.4、CUDA 11.6。HPCG 3.0 コンテナー: nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg は https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks から入手できます。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-70A。

- テストでは、2022 年 11 月 14 日に AMD パフォーマンス ラボが HPL を使用して次の 2 つのシステムを比較しました。2P EPYC™ 7763 搭載サーバー (SMT 無効) + 1x、2x および 4x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU、ホスト ROCm 5.2.0 rocHPL6.0.0。AMD HPL コンテナーは Infinity Hub でまだ利用できません。これに対する比較テストのシステム構成は、2P AMD EPYC™ 7742 サーバー (SMT 無効) + 1x、2x および 4x NVIDIA Ampere A100 80 GB SXM 400 W GPU、CUDA 11.6、ドライバー バージョン 510.47.03。HPL コンテナー (nvcr.io/nvidia/hpc-benchmarks:21.4-hpl) は https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks から入手できます。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-69A。

- HPL-AI の比較テストは、2022 年 11 月 2 日に AMD 社内で実施され、HPL-AI ベンチマーク パフォーマンス (TFLOPS) が測定されました。テストに使用したサーバーのシステム構成は次のとおりです。2x EPYC 7763 + 4x MI250 128 MB HBM2e、ホスト ROCm 5.2.0、HPL-AI-AMD v1.0.0。これに対する比較テストのシステム構成が 2x EPYC 7742 + 4x A100 SXM 80 GB HBM2e、CUDA 11.6、HPL-AI-NVIDIA v2.0.0、コンテナー nvcr.io/nvidia/hpc-benchmarks:21.4-hpl。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-81。

- テストでは、2022 年 11 月 25 日に AMD パフォーマンス ラボが PyFR TGV と NACA 0021 を使用して次の 2 つのシステムを比較しました。2P EPYC™ 7763 搭載サーバー (SMT 無効) + 1x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU、SBIOS M12、Ubuntu 20.04.4、ホスト ROCm 5.2.0。これに対する比較テストのシステム構成が、2P AMD EPYC™ 7742 サーバー (SMT 有効) + 1x NVIDIA Ampere A100 80 GB SXM 400 W GPU、SBIOS 0.34、Ubuntu 20.04.4、CUDA 11.6。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-82。

- テストでは、2023 年 4 月 14 日に AMD パフォーマンス ラボが OpenFOAM v2206 を使用して次の 2 つのシステムを比較しました。AMD Infinity Fabric™ テクノロジが有効な 1x、2x、4x の AMD Instinct™ MI250 GPU (128 GB、560 W) を搭載した 2P EPYC 7763 CPU のプロダクション サーバー、ROCm™ 5.3.3、Ubuntu® 20.04.4。比較対象が、NVLink テクノロジが有効な 1x、2x、4x の NVIDIA A100 80 GB SXM GPUs (400 W) を搭載した 2P EPYC 7742 CPU のプロダクション サーバー、CUDA® 11.8、Ubuntu 20.04.4。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。

- テストは、2022 年 8 月 26 日に AMD パフォーマンス ラボが AMBER を使用して実施しました。Cellulose_production_NPT_4fs、Cellulose_production_NVE_4fs、FactorIX_production_NPT_4fs、FactorIX_production_NVE_4fs、STMV_production_NPT_4fs、STMV_production_NVE_4fs、JAC_production_NPT_4fs および JAC production_NVE_4fs。比較した 2 種類のシステム構成: 2P EPYC™ 7763 搭載サーバー + 1x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU、ROCm 5.2.0、Amber コンテナー 22.amd_100。これに対する比較テストのシステム構成が、2P EPYC™ 7742 搭載サーバー + 1x NVIDIA A100 SXM (80 GB HBM2e) 400 W GPU (MPS 有効化、2 インスタンス)、CUDA 11.6。MI200-73。

- テストは、2022 年 10 月 18 日時点の AMD パフォーマンス ラボが Gromacs STMV を使用して 2 つのシステムを比較しました。2P EPYC™ 7763 搭載サーバー + 4x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU + Infinity Fabric™ テクノロジ、ROCm™ 5.2.0、Gromacs コンテナー 2022.3.amd1_174。これに対する比較テストのシステム構成が、NVIDIA 公称値 (https://developer.nvidia.com/hpc-application-performance)。(Gromacs 2022.2)。デュアル EPYC 7742 + 4x NVIDIA Ampere A100 SXM 80 GB GPU。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無などの要素によって、パフォーマンスが異なる可能性があります。MI200-74。

- テストは、109.0322.22 に AMD パフォーマンス ラボが LAMMPS: EAM、LJ、ReaxFF、Tersoff の 2 つのシステムを比較: 2P EPYC™ 7763 搭載サーバー + 4x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU + ROCm 5.2.0、LAMMPS コンテナー 2021.5.14_121amdih/lammps:2022.5.04_130。これに対する比較テストのシステム構成が、NVIDIA 公称値 (http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance)。(stable 23Jun2022 update 1)。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-77。

- テストは、2022 年 9 月 13 日に AMD パフォーマンス ラボが NAMD: STMV_NVE、APOA1_NVE の 2 つのシステムを比較: 2P EPYC™ 7763 搭載サーバー + 1x、2x および 4x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU + AMD Infinity Fabric™ テクノロジ、ROCm 5.2.0、NAMD コンテナー namd3:3.0a9。これに対する比較テストのシステム構成が、NVIDIA パフォーマンス公称値: 2P EPYC 7742 サーバー + 1x、2x、および 4x NVIDIA Ampere A100 80 GB SXM GPU (https://developer.nvidia.com/hpc-application-performance)。(v2.15a AVX-512)。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-76。

- テストは、2022 年 11 月 14 日に AMD パフォーマンス ラボが次のシステム構成で実施しました。2P ソケット AMD EPYC™ 7763 CPU Supermicro 4124 + 8x AMD Instinct™ MI210 GPU (PCIe® 64 GB、300 W) + AMD Infinity Fabric™ テクノロジ。Ubuntu 18.04.6 LTS、ホスト ROCm 5.2.0、rocHPL 6.0.0。5 回の実行の中央値から結果を算出。比較テストは、AMD パフォーマンス ラボが次のシステム構成で実施しました。2P ソケット AMD EPYC™ 7763 Supermicro 4124 + 8x NVIDIA A100 GPU (PCIe 80 GB 300 W)、Ubuntu 18.04.6 LTS、CUDA 11.6、HPL NVIDIA コンテナー イメージ 21.4-HPL。すべての結果は、4 ウェイ Infinity Fabric™ リンク ブリッジで接続された 2 組の 4xMI210 GPU、2 ウェイ NVLink ブリッジで接続された 4 組の 2xA100 80 GB PCIe GPU、合計 8 GPU で構成されたシステムで測定されています。HPL に関する情報: https://www.netlib.org/benchmark/hpl/。AMD HPL コンテナーの詳細: HPL コンテナーは Infinity Hub でまだ利用できません。NVIDIA HPL コンテナーの詳細: https://ngc.nvidia.com/catalog/containers/nvidia:hpc-benchmarks。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-49A。

- HPL-AI の比較テストは、2022 年 11 月 2 日に AMD 社内で実施され、HPL-AI ベンチマーク パフォーマンス (TFLOPS) が測定されました。テストに使用したサーバーのシステム構成は次のとおりです。2x EPYC 7763 + 8x MI210 64 MB HBM2e + Infinity Fabric テクノロジ、ホスト ROCm 5.2.0、HPL-AI-AMD v1.0.0、AMD HPL-AI コンテナー (Infinity Hub ではまだ利用できません)。これに対する比較テストのシステム構成が 2x EPYC 7763 + 8x A100 PCIe 80 GB HBM2e、CUDA 11.6、HPL-AI-NVIDIA v2.0.0、コンテナー nvcr.io/nvidia/hpc-benchmarks:21.4-hpl。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-83。

- テストは AMD パフォーマンス ラボが 2022 年 10 月 3 日に次のシステム構成で実施しました。2P ソケット AMD EPYC™ 7763 CPU Supermicro 4124 + 4x および 8x AMD Instinct™ MI210 GPU (PCIe® 64 GB、300 W) + AMD Infinity Fabric™ テクノロジ。SBIOS2.2、Ubuntu® 18.04.6 LTS、ホスト ROCm™ 5.2.0。LAMMPS コンテナー amdih-2022.5.04_130 (ROCm 5.1)。これに対する比較テストのシステム構成が、NVIDIA 公称値: 4x および 8x A100 PCIe 80 GB GPU (http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance)。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI200-47A。