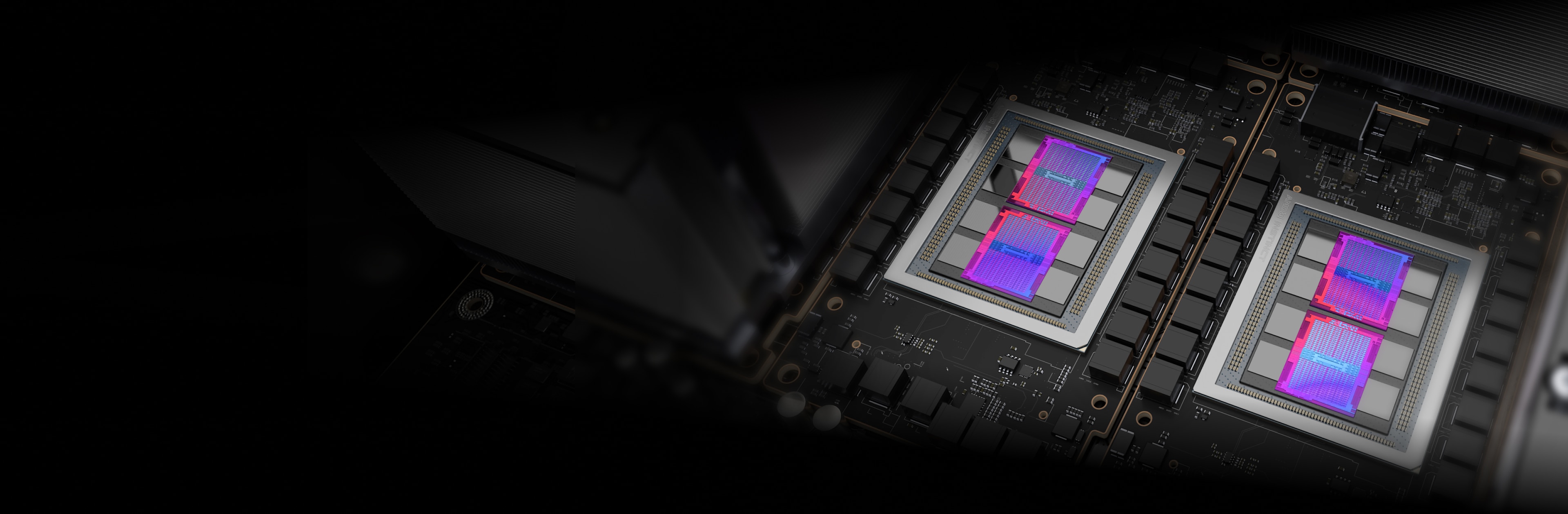

Unter der Haube

AMD Instinct Beschleuniger basieren auf der AMD CDNA™ Architektur, die Matrix-Core-Technologien und Unterstützung für eine Vielzahl von Genauigkeiten bietet – von hocheffizienten INT8 und FP8 bis hin zu anspruchsvollsten FP64 für HPC.

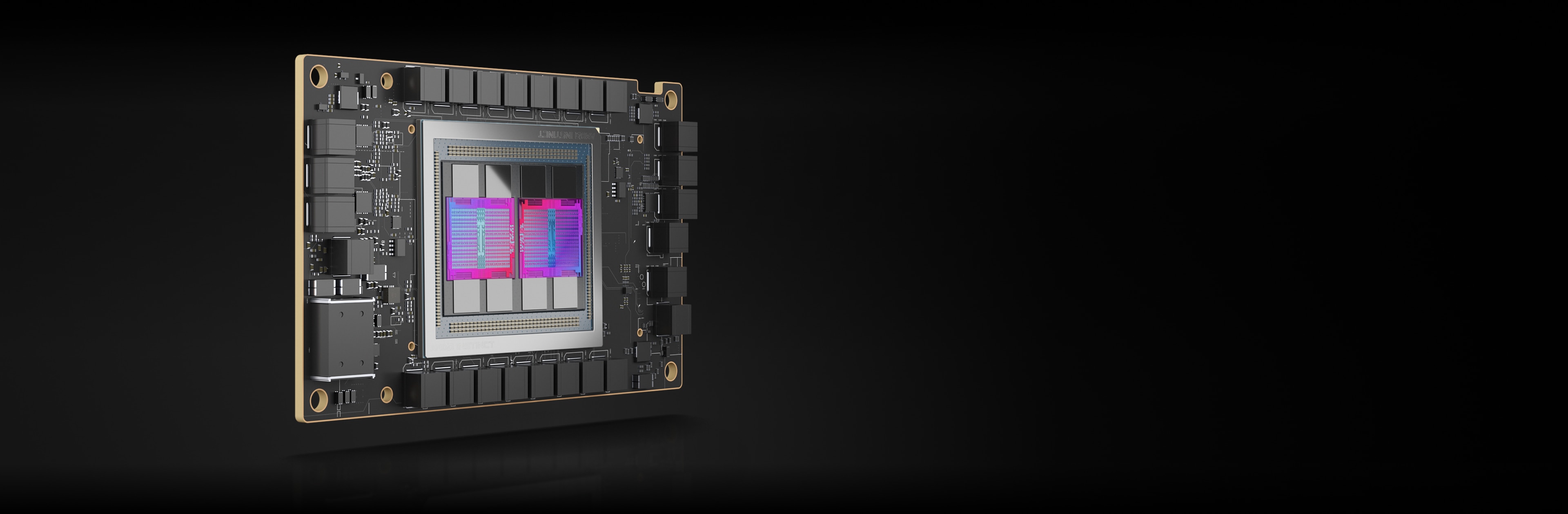

AMD Instinct MI250X Beschleuniger

AMD Instinct MI250X Beschleuniger treiben einige der weltweit wichtigsten Supercomputer an.

220 CUs

220 GPU Recheneinheiten

128 GB

128 GB HBM2e Speicher

3,2 TB/s

3,2 TB/s max. Speicherbandbreite

400 GB/s

400 GB/s max. aggregierte Infinity Fabric Bandbreite

Vergleiche der Spezifikationen

Theoretische Leistung von bis zu max. 383 TFLOPS mit halber Genauigkeit (FP16) und bis zu 1,6-mal mehr Speicherkapazität und Bandbreite als GPUs der Konkurrenz für die anspruchsvollsten KI-Auslastungen2,3,4

MI250X

A100

Bietet einen bis zu 4-fachen Vorteil im Vergleich zu anderen GPUs, mit einer theoretischen Leistung von max. 47,9 TFLOPs FP64 und max. 95,7 TFLOPs FP64 Matrix.2

MI250X

A100

* Das TF32-Datenformat ist nicht IEEE-konform, darum nicht in diesem Vergleich enthalten.

AMD Instinct MI250 Beschleuniger

AMD Instinct MI250 Beschleuniger ermöglichen eine herausragende HPC- und KI-Performance für Anwendungsfälle aus den Bereichen Enterprise, Forschung und Hochschule.

208 CUs

208 GPU Recheneinheiten

128 GB

128 GB HBM2e Speicher

3,2 TB/s

3,2 TB/s max. Speicherbandbreite

100 GB/s

100 GB/s max. Infinity Fabric™ Link Bandbreite

Performance-Benchmarks

HPCG 3.0: Die Benchmark High Performance Conjugate Gradients (HPCG) ist eine Metrik zur Einstufung von HPC-Systemen. HPCG ist als Ergänzung zur Benchmark High Performance LINPACK (HPL) gedacht, die derzeit zur Einstufung der TOP500-Computing-Systeme verwendet wird.5

Metrik |

1 x MI250 |

2 x MI250 |

4 x MI250 |

GFLOPS |

488,8 |

972,6 |

1.927,7 |

HPL: HPL ist eine Implementierung der Benchmark High-Performance Linpack. Der Code löst ein gleichmäßig zufälliges System linearer Gleichungen und meldet die Zeit und die Gleitkomma-Ausführungsrate anhand einer Standardformel für die Anzahl der Operationen.6

Metrik |

1 x MI250 |

2 x MI250 |

4 x MI250 |

TFLOPS |

40,45 |

80,666 |

161,97 |

HPL_AI bzw. High Performance LINPACK for Accelerator Introspection ist eine Benchmark, die die Konvergenz von HPC- und KI-Auslastungen hervorhebt, indem ein System linearer Gleichungen anhand neuartiger Algorithmen mit unterschiedlicher Genauigkeit gelöst wird.7

Metrik |

Testmodul |

4 x MI250 |

TFLOPS |

FP16/32/64 gemischt |

930,44 |

PyFR ist ein Open-Source-Framework auf Basis von Python zur Lösung von Advektions-Diffusions-Problemen auf Streaming-Architekturen unter Verwendung des Flussrekonstruktionsansatzes von Huynh. Das Framework soll eine Reihe von Regelsystemen auf gemischten unstrukturierten Rastern mit verschiedenen Elementtypen lösen.8

Metrik |

Testmodul |

1 x MI250 |

Simulationen/Tag |

TGV |

41,73 |

OpenFOAM (Open-source Field Operation And Manipulation) ist eine C++-Toolbox für die Entwicklung kundenspezifischer numerischer Solver und Pre-/Post-Processing-Anwendungen für die Lösung von Problemen der Kontinuumsmechanik. Hierzu gehört vor allem die numerische Strömungsmechanik.9

Metrik |

Testmodul |

1 x MI250 |

2 x MI250 |

4 x MI250 |

Zeit (Sek.) |

HPC Motorbike (größer ist nicht besser) |

662,3 |

364,26 |

209,84 |

Amber ist eine Reihe von biomolekularen Simulationsprogrammen, wobei sich der Begriff „Amber“ auf zwei Dinge bezieht. Zum einen handelt es sich um eine Reihe von molekularmechanischen Kraftfeldern für die Simulation von Biomolekülen, zum anderen um ein Paket von Molekularsimulationsprogrammen, das Quelltext und Demos enthält.10

Anwendung |

Metrik |

Testmodul |

Größer ist besser |

1 x MI250 |

AMBER |

ns/Tag |

Cellulose Production NPT 4fs |

Ja |

227,2 |

AMBER |

ns/Tag |

Cellulose Production NVE 4fs |

Ja |

242,4 |

AMBER |

ns/Tag |

FactorIX Production NPT 4fs |

Ja |

803,1 |

AMBER |

ns/Tag |

FactorIX Production NVE 4fs |

Ja |

855,2 |

AMBER |

ns/Tag |

JAC Production NPT 4fs |

Ja |

1794 |

AMBER |

ns/Tag |

JAC Production NVE 4fs |

Ja |

1871 |

AMBER |

ns/Tag |

STMV Production NPT 4fs |

Ja |

80,65 |

AMBER |

ns/Tag |

STMV Production NVE 4fs |

Ja |

86,7 |

GROMACS ist ein Molekulardynamik-Paket, das hauptsächlich für Simulationen von Proteinen, Lipiden und Nukleinsäuren konzipiert ist. Es wurde ursprünglich von der Abteilung Biophysikalische Chemie der Universität Groningen entwickelt und wird nun von Mitarbeitern in Universitäten und Forschungszentren weltweit gepflegt.11

Anwendung |

Metrik |

Testmodul |

Größer ist besser |

1 x MI250 |

2 x MI250 |

4 x MI250 |

GROMACS |

ns/Tag |

STMV |

Ja |

34,2 |

61,812 |

89,26 |

LAMMPS ist ein klassischer Molekulardynamik-Code mit Schwerpunkt auf Materialmodellierung. Hierbei handelt es sich um eine Abkürzung für Large-scale Atomic/Molecular Massively Parallel Simulator. LAMMPS hat Potenzial für Festkörperwerkstoffe (Metalle, Halbleiter) und weiche Materie (Biomoleküle, Polymere) sowie grobkörnige oder mesoskopische Systeme.12

Anwendung |

Metrik |

Testmodul |

Größer ist besser |

1 x MI250 |

2 x MI250 |

4 x MI250 |

LAMMPS |

Atomzeitschritte/s |

LJ |

Ja |

6E+08 |

1E+09 |

2E+09 |

LAMMPS |

Atomzeitschritte/s |

ReaxFF |

Ja |

7E+06 |

1E+07 |

3E+07 |

LAMMPS |

Atomzeitschritte/s |

Tersoff |

Ja |

5E+08 |

1E+09 |

2E+09 |

NAMD ist ein Molekulardynamik-Paket zur Simulation der Bewegung von Biomolekülen im Laufe der Zeit. Es eignet sich für große Biomolekularsysteme. Es wird für die Simulation von Systemen mit über 1 Milliarde Atomen verwendet und bietet eine hervorragende Skalierbarkeit auf Tausenden von CPU-Kernen und GPUs.13

Anwendung |

Metrik |

Testmodul |

Größer ist besser |

1 x MI250 |

2 x MI250 |

4 x MI250 |

NAMD 3.0 |

ns/Tag |

APOA1_NVE |

Ja |

221,4 |

443,61 |

879,43 |

NAMD 3.0 |

ns/Tag |

STMV_NVE |

Ja |

19,87 |

39,545 |

77,132 |

AMD Instinct MI210 Beschleuniger

AMD Instinct MI210 Beschleuniger treiben HPC- und KI-Auslastungen im Bereich Enterprise, Forschung und Hochschule für Einzelserverlösungen und mehr an.

104 CUs

104 GPU Recheneinheiten

64 GB

64 GB HBM2e Speicher

1,6 TB/s

1,6 TB/s max. Speicherbandbreite

100 GB/s

100 GB/s max. Infinity Fabric™ Link Bandbreite

Performance-Benchmarks

HPL: HPL ist eine Implementierung der Benchmark High-Performance Linpack. Der Code löst ein gleichmäßig zufälliges System linearer Gleichungen und meldet die Zeit und die Gleitkomma-Ausführungsrate anhand einer Standardformel für die Anzahl der Operationen.14

Metrik |

Größer ist besser |

1 x MI210 |

2 x MI210 |

4 x MI210 | 8 x MI210 |

TFLOPS |

Ja |

21,07 |

40,878 |

81,097 | 159,73 |

HPL-AI: HPL_AI bzw. High Performance LINPACK for Accelerator Introspection ist eine Benchmark, die die Konvergenz von HPC- und KI-Auslastungen hervorhebt, indem ein System linearer Gleichungen anhand neuartiger Algorithmen mit unterschiedlicher Genauigkeit gelöst wird.15

Metrik |

Testmodul |

Größer ist besser |

4 x MI210 |

8 x MI210 |

TFLOPS |

FP16/32/64 gemischt |

Ja |

444,77 |

976,18 |

LAMMPS: LAMMPS ist ein klassischer Molekulardynamik-Code mit Schwerpunkt auf Materialmodellierung. Hierbei handelt es sich um eine Abkürzung für Large-scale Atomic/Molecular Massively Parallel Simulator. LAMMPS hat Potenzial für Festkörperwerkstoffe (Metalle, Halbleiter) und weiche Materie (Biomoleküle, Polymere) sowie grobkörnige oder mesoskopische Systeme.16

Metrik |

Testmodul |

Größer ist besser |

4 x MI210 | 8 x MI210 |

Atomzeitschritte/s |

ReaxFF |

Ja |

1E+07 | 3E+07 |

Immer informiert bleiben

Melden Sie sich an und erhalten Sie alle Neuigkeiten über Rechenzentren und Server.

Fußnoten

- Top-500-Liste, Juni 2023

- Die weltweit schnellste GPU für Rechenzentren ist der AMD Instinct™ MI250X. Berechnungen durchgeführt vom AMD Leistungslabor, Stand: 15.09.2021, für den AMD Instinct™ MI250X Beschleuniger (128 GB HBM2e OAM-Modul) bei max. 1.700 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 95,7 TFLOPS mit doppelter Genauigkeit (FP64-Matrix), max. 47,9 TFLOPS mit doppelter Genauigkeit (FP64), max. 95,7 TFLOPS mit einfacher Genauigkeit (FP32-Matrix), max. 47,9 TFLOPS mit einfacher Genauigkeit (FP32), max. 383,0 TFLOPS mit halber Genauigkeit (FP16) und 383,0 TFLOPS maximale Bfloat-Genauigkeit (BF16). Berechnungen durchgeführt vom AMD Leistungslabor, Stand: 18.09.2021, für den AMD Instinct™ MI100 (32 GB HBM2 PCIe®-Karte) Beschleuniger bei max. 1.502 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 11,54 TFLOPS mit doppelter Genauigkeit (FP64), max. 46,1 TFLOPS mit einfacher Genauigkeit (FP32), max. 23,1 TFLOPS mit einfacher Genauigkeit (FP32) und max. 184,6 TFLOPS mit halber Genauigkeit (FP16). Veröffentlichte Ergebnisse des Nvidia Ampere A100 (80 GB) GPU-Beschleunigers bei 1.410 MHz Boost-Speichertakt ergaben max. 19,5 TFLOPS mit doppelter Genauigkeit Tensor Cores (FP64 Tensor Core) und max. 9,7 TFLOPS mit doppelter Genauigkeit (FP64). Theoretische Gleitkommaleistung: max. 19,5 TFLOPS mit einfacher Genauigkeit (FP32), max. 78 TFLOPS mit halber Genauigkeit (FP16), max. 312 TFLOPS mit halber Genauigkeit (FP16 Tensor Flow), max. 39 TFLOPS Bfloat 16 (BF16) und max. 312 TFLOPS Bfloat16-Genauigkeit (BF16 Tensor Flow). Das Datenformat TF32 ist nicht IEEE-konform und daher nicht in diesem Vergleich enthalten (siehe: https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-ampere-architecture-whitepaper.pdf, Seite 15, Tabelle 1 (Englisch)). MI200-01

- Berechnungen durchgeführt im AMD Leistungslabor am 21. September 2021 für die AMD Instinct™ MI250X und MI250 (128 GB HBM2e) OAM-Beschleuniger mit AMD CDNA™ 2 6-nm-FinFet-Prozesstechnologie und einem Spitzenspeichertakt von 1.600 MHz ergaben eine theoretische Spitzen-Speicherbandbreiten-Performance von 3,2768 TFLOPS. Die Speicherbus-Schnittstelle des MI250/MI250X ist 4.096 Bit x 2 Die und die Speicherdatenrate beträgt 3,20 GB/s, was eine Gesamtspeicherbandbreite von 3,2768 TB/s ergibt ((3,20 GB/s * (4.096 Bit * 2)) / 8). Die höchsten veröffentlichten Ergebnisse für den Nvidia Ampere A100 (80 GB) SXM GPU Beschleuniger ergaben eine Speicherbandbreiten-Performance von 2,039 Tbit/s. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-07

- Berechnungen durchgeführt vom AMD Leistungslabor am 21. September 2021 für die AMD Instinct™ MI250X und MI250 Beschleuniger (OAM) mit AMD CDNA™ 2 6-nm-FinFet-Prozesstechnologie und einem Spitzenspeichertakt von 1.600 MHz ergaben eine HBMe-Speicherkapazität von 128 GB. Die veröffentlichten Spezifikationen der Nvidia Ampere A100 (80 GB) SXM und A100 Beschleuniger (PCIe®) wiesen eine Speicherkapazität von 80 GB auf. Ergebnisse einsehbar unter: https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-18

- Test durchgeführt vom AMD Leistungslabor am 2.11.2022 mithilfe von HPCG 3.0; verglichen wurden zwei Systeme: 2P-Server mit EPYC™ 7763, SMT deaktiviert, mit 1 x, 2 x und 4 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPUs, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 im Vergleich zu 2P-Server mit AMD EPYC™ 7742, mit 1 x, 2 x und 4 x Nvidia Ampere A100 80 GB SXM 400 W GPUs, SBIOS 0.34, Ubuntu 20.04.4, CUDA 11.6. HPCG 3.0 Container: nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg unter https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-70A.

- Tests durchgeführt vom AMD Leistungslabor am 14.11.2022 mithilfe von HPL; es wurden zwei Systeme verglichen. 2P EPYC™ 7763 Server, SMT deaktiviert, mit 1 x, 2 x und 4 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU, Host ROCm 5.2.0 rocHPL6.0.0. AMD HPL Container ist für Infinity Hub noch nicht verfügbar. Im Vergleich zu 2P AMD EPYC™ 7742 Server, SMT aktiviert, mit 1 x, 2 x und 4 x Nvidia Ampere A100 80 GB SXM 400 W GPU, CUDA 11.6 und Treiberversion 510.47.03. HPL Container (nvcr.io/nvidia/hpc-benchmarks:21.4-hpl) abgerufen unter https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-69A.

- HPL-AI-Vergleich basierend auf internen AMD Tests vom 02.11.2022, bei denen die HPL-AI-Benchmark-Performance (TFLOPS) unter Verwendung eines Servers mit 2 x EPYC 7763 und 4 x MI250 128 MB HBM2e mit Host ROCm 5.2.0, HPL-AI-AMD v1.0.0 gemessen wurde; im Vergleich zu einem Server mit 2 x EPYC 7742 und 4 x A100 SMX 80 GB HBM2e mit CUDA 11.6, HPL-AI-NVIDIA v2.0.0, Container nvcr.io/nvidia/hpc-benchmarks:21.4-hpl. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-81.

- Tests durchgeführt vom AMD Leistungslabor am 25.11.2022 unter Verwendung von PyFR TGV und NACA 0021. Es wurden zwei Systeme verglichen: 2P-Server mit EPYC™ 7763, SMT deaktiviert, mit 1 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 im Vergleich zu 2P-Server mit AMD EPYC™ 7742, SMT aktiviert, mit 1 x Nvidia Ampere A100 80 GB SXM 400 W GPU, SBIOS 0.34, Ubuntu 20.04.4, CUDA 11.6. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-82.

- Tests durchgeführt vom AMD Leistungslabor am 14.04.2023 unter Verwendung von OpenFOAM v2206 auf einem 2P EPYC 7763 CPU Produktionsserver mit 1 x, 2 x und 4 x AMD Instinct™ MI250 GPUs (128 GB, 560 W) mit AMD Infinity Fabric™ Technologie aktiviert, ROCm™ 5.3.3, Ubuntu® 20.04.4 im Vergleich zu einem 2P EPYC 7742 CPU Produktionsserver mit 1 x, 2 x und 4 x Nvidia A100 80 GB SXM GPUs (400 W) mit NVLink Technologie aktiviert, CUDA® 11.8, Ubuntu 20.04.4. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren.

- Tests durchgeführt vom AMD Leistungslabor am 26.08.2022 unter Verwendung von AMBER: Cellulose_production_NPT_4fs, Cellulose_production_NVE_4fs, FactorIX_production_NPT_4fs, FactorIX_production_NVE_4fs, STMV_production_NPT_4fs, STMV_production_NVE_4fs, JAC_production_NPT_4fs und JAC production_NVE_4fs. Es wurden zwei Systeme verglichen: 2P-Server mit EPYC™ 7763 und 1 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU, ROCm 5.2.0, Amber-Container 22.amd_100 im Vergleich zu 2P-Server mit EPYC™ 7742 und 1 x Nvidia A100 SXM (80 GB HBM2e) 400 W GPU, MPS aktiviert (2 Instanzen), CUDA 11.6. MI200-73.

- Tests durchgeführt vom AMD Leistungslabor am 18.10.2022 mithilfe von Gromacs STMV; es wurden zwei Systeme verglichen: 2P-Server mit EPYC™ 7763 und 4 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPUs und Infinity Fabric™ Technologie, ROCm™ 5.2.0, Gromacs-Container 2022.3.amd1_174 im Vergleich zu öffentlichen Nvidia-Angaben unter https://developer.nvidia.com/hpc-application-performance. (Gromacs 2022.2). Dual EPYC 7742 mit 4 x Nvidia Ampere A100 SXM 80 GB GPUs. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund von Faktoren wie dem Einsatz neuester Treiber und Optimierungen variieren. MI200-74.

- Tests durchgeführt vom AMD Leistungslabor am 03.10.2022 unter Verwendung von LAMMPS: EAM, LJ, ReaxFF und Tersoff; verglichen wurden zwei Systeme: 2P-Server mit EPYC™ 7763 und 4 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU, ROCm 5.2.0, LAMMPS-Container 2021.5.14_121amdih/lammps:2022.5.04_130 im Vergleich zu öffentlichen Nvidia-Angaben unter http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. (stable 23Jun2022 update 1). Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-77.

- Tests durchgeführt vom AMD Leistungslabor am 13.09.2022 unter Verwendung von NAMD: STMV_NVE, APOA1_NVE; verglichen wurden zwei Systeme: 2P-Server mit EPYC™ 7763 und 1 x, 2 x und 4 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU mit AMD Infinity Fabric™ Technologie, ROCm 5.2.0, NAMD-Container namd3:3.0a9 im Vergleich zu öffentlichen Nvidia-Angaben zur Performance des 2P-Servers EPYC 7742 mit 1 x, 2 x und 4 x Nvidia Ampere A100 80 GB SXM GPU (https://developer.nvidia.com/hpc-application-performance). (v2.15a AVX-512). Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-76.

- Tests durchgeführt vom AMD Leistungslabor am 14.11.2022 auf 2P-Sockel AMD EPYC™ 7763 CPU Supermicro 4124 mit 8 x AMD Instinct™ MI210 GPUs (PCIe® 64 GB, 300 W); AMD Infinity Fabric™ Technologie aktiviert. Ubuntu 18.04.6 LTS, Host ROCm 5.2.0, rocHPL 6.0.0. Ergebnisse aus den Mittelwerten von fünf Durchläufen berechnet im Vergleich zu Tests durchgeführt vom AMD Leistungslabor auf 2P-Sockel AMD EPYC™ 7763 Supermicro 4124 mit 8 x NVIDIA A100 GPUs (PCIe 80 GB, 300 W), Ubuntu 18.04.6 LTS, CUDA 11.6, HPL Nvidia Container-Image 21.4-HPL Alle Ergebnisse wurden auf Systemen gemessen, die mit 8 GPUs konfiguriert sind. 2 Kombinationen der 4 x MI210 GPUs verbunden über eine Infinity Fabric™ Link 4-Wege-Brücke; 4 Kombinationen der 2 x A100 80 GB PCIe GPUs verbunden über eine 2-Wege-NVLink-Brücke. Informationen über HPL: https://www.netlib.org/benchmark/hpl/. AMD HPL Container-Details: HPL Container ist für Infinity Hub noch nicht verfügbar. Nvidia HPL Container-Details: https://ngc.nvidia.com/catalog/containers/nvidia:hpc-benchmarks. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-49A.

- HPL-AI-Vergleich basierend auf internen AMD Tests vom 02.11.2022, bei denen die HPL-AI-Benchmark-Performance (TFLOPS) unter Verwendung eines Servers mit 2 x EPYC 7763 und 8 x MI210 (64 MB HBM2e) und Infinity Fabric Technologie mit Host ROCm 5.2.0, HPL-AI-AMD v1.0.0 gemessen wurde; AMD HPL-AI-Container ist für Infinity Hub noch nicht verfügbar; im Vergleich zu einem Server mit 2 x EPYC 7763 und 8 x A100 PCIe 80 GB HBM2e mit CUDA 11.6, HPL-AI-NVIDIA v2.0.0, Container nvcr.io/nvidia/hpc-benchmarks:21.4-hpl. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-83.

- Tests durchgeführt vom AMD Leistungslabor am 03.10.2022 auf 2P-Sockel AMD EPYC™ 7763 CPU Supermicro 4124 mit 4 x und 8 x AMD Instinct™ MI210 GPU (PCIe® 64 GB, 300 W); AMD Infinity Fabric™ Technologie war aktiviert. SBIOS2.2, Ubuntu® 18.04.6 LTS, Host ROCm™ 5.2.0. LAMMPS Container amdih-2022.5.04_130 (ROCm 5.1) im Vergleich zu öffentlichen Nvidia-Angaben für 4 x und 8 x A100 PCIe 80 GB GPUs http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-47A.

- Top-500-Liste, Juni 2023

- Die weltweit schnellste GPU für Rechenzentren ist der AMD Instinct™ MI250X. Berechnungen durchgeführt vom AMD Leistungslabor, Stand: 15.09.2021, für den AMD Instinct™ MI250X Beschleuniger (128 GB HBM2e OAM-Modul) bei max. 1.700 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 95,7 TFLOPS mit doppelter Genauigkeit (FP64-Matrix), max. 47,9 TFLOPS mit doppelter Genauigkeit (FP64), max. 95,7 TFLOPS mit einfacher Genauigkeit (FP32-Matrix), max. 47,9 TFLOPS mit einfacher Genauigkeit (FP32), max. 383,0 TFLOPS mit halber Genauigkeit (FP16) und 383,0 TFLOPS maximale Bfloat-Genauigkeit (BF16). Berechnungen durchgeführt vom AMD Leistungslabor, Stand: 18.09.2021, für den AMD Instinct™ MI100 (32 GB HBM2 PCIe®-Karte) Beschleuniger bei max. 1.502 MHz Boost-Speichertakt ergaben folgende theoretische Gleitkommaleistung: max. 11,54 TFLOPS mit doppelter Genauigkeit (FP64), max. 46,1 TFLOPS mit einfacher Genauigkeit (FP32), max. 23,1 TFLOPS mit einfacher Genauigkeit (FP32) und max. 184,6 TFLOPS mit halber Genauigkeit (FP16). Veröffentlichte Ergebnisse des Nvidia Ampere A100 (80 GB) GPU-Beschleunigers bei 1.410 MHz Boost-Speichertakt ergaben max. 19,5 TFLOPS mit doppelter Genauigkeit Tensor Cores (FP64 Tensor Core) und max. 9,7 TFLOPS mit doppelter Genauigkeit (FP64). Theoretische Gleitkommaleistung: max. 19,5 TFLOPS mit einfacher Genauigkeit (FP32), max. 78 TFLOPS mit halber Genauigkeit (FP16), max. 312 TFLOPS mit halber Genauigkeit (FP16 Tensor Flow), max. 39 TFLOPS Bfloat 16 (BF16) und max. 312 TFLOPS Bfloat16-Genauigkeit (BF16 Tensor Flow). Das Datenformat TF32 ist nicht IEEE-konform und daher nicht in diesem Vergleich enthalten (siehe: https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-ampere-architecture-whitepaper.pdf, Seite 15, Tabelle 1 (Englisch)). MI200-01

- Berechnungen durchgeführt im AMD Leistungslabor am 21. September 2021 für die AMD Instinct™ MI250X und MI250 (128 GB HBM2e) OAM-Beschleuniger mit AMD CDNA™ 2 6-nm-FinFet-Prozesstechnologie und einem Spitzenspeichertakt von 1.600 MHz ergaben eine theoretische Spitzen-Speicherbandbreiten-Performance von 3,2768 TFLOPS. Die Speicherbus-Schnittstelle des MI250/MI250X ist 4.096 Bit x 2 Die und die Speicherdatenrate beträgt 3,20 GB/s, was eine Gesamtspeicherbandbreite von 3,2768 TB/s ergibt ((3,20 GB/s * (4.096 Bit * 2)) / 8). Die höchsten veröffentlichten Ergebnisse für den Nvidia Ampere A100 (80 GB) SXM GPU Beschleuniger ergaben eine Speicherbandbreiten-Performance von 2,039 Tbit/s. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-07

- Berechnungen durchgeführt vom AMD Leistungslabor am 21. September 2021 für die AMD Instinct™ MI250X und MI250 Beschleuniger (OAM) mit AMD CDNA™ 2 6-nm-FinFet-Prozesstechnologie und einem Spitzenspeichertakt von 1.600 MHz ergaben eine HBMe-Speicherkapazität von 128 GB. Die veröffentlichten Spezifikationen der Nvidia Ampere A100 (80 GB) SXM und A100 Beschleuniger (PCIe®) wiesen eine Speicherkapazität von 80 GB auf. Ergebnisse einsehbar unter: https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-18

- Test durchgeführt vom AMD Leistungslabor am 2.11.2022 mithilfe von HPCG 3.0; verglichen wurden zwei Systeme: 2P-Server mit EPYC™ 7763, SMT deaktiviert, mit 1 x, 2 x und 4 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPUs, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 im Vergleich zu 2P-Server mit AMD EPYC™ 7742, mit 1 x, 2 x und 4 x Nvidia Ampere A100 80 GB SXM 400 W GPUs, SBIOS 0.34, Ubuntu 20.04.4, CUDA 11.6. HPCG 3.0 Container: nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg unter https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-70A.

- Tests durchgeführt vom AMD Leistungslabor am 14.11.2022 mithilfe von HPL; es wurden zwei Systeme verglichen. 2P EPYC™ 7763 Server, SMT deaktiviert, mit 1 x, 2 x und 4 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU, Host ROCm 5.2.0 rocHPL6.0.0. AMD HPL Container ist für Infinity Hub noch nicht verfügbar. Im Vergleich zu 2P AMD EPYC™ 7742 Server, SMT aktiviert, mit 1 x, 2 x und 4 x Nvidia Ampere A100 80 GB SXM 400 W GPU, CUDA 11.6 und Treiberversion 510.47.03. HPL Container (nvcr.io/nvidia/hpc-benchmarks:21.4-hpl) abgerufen unter https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-69A.

- HPL-AI-Vergleich basierend auf internen AMD Tests vom 02.11.2022, bei denen die HPL-AI-Benchmark-Performance (TFLOPS) unter Verwendung eines Servers mit 2 x EPYC 7763 und 4 x MI250 128 MB HBM2e mit Host ROCm 5.2.0, HPL-AI-AMD v1.0.0 gemessen wurde; im Vergleich zu einem Server mit 2 x EPYC 7742 und 4 x A100 SMX 80 GB HBM2e mit CUDA 11.6, HPL-AI-NVIDIA v2.0.0, Container nvcr.io/nvidia/hpc-benchmarks:21.4-hpl. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-81.

- Tests durchgeführt vom AMD Leistungslabor am 25.11.2022 unter Verwendung von PyFR TGV und NACA 0021. Es wurden zwei Systeme verglichen: 2P-Server mit EPYC™ 7763, SMT deaktiviert, mit 1 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 im Vergleich zu 2P-Server mit AMD EPYC™ 7742, SMT aktiviert, mit 1 x Nvidia Ampere A100 80 GB SXM 400 W GPU, SBIOS 0.34, Ubuntu 20.04.4, CUDA 11.6. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-82.

- Tests durchgeführt vom AMD Leistungslabor am 14.04.2023 unter Verwendung von OpenFOAM v2206 auf einem 2P EPYC 7763 CPU Produktionsserver mit 1 x, 2 x und 4 x AMD Instinct™ MI250 GPUs (128 GB, 560 W) mit AMD Infinity Fabric™ Technologie aktiviert, ROCm™ 5.3.3, Ubuntu® 20.04.4 im Vergleich zu einem 2P EPYC 7742 CPU Produktionsserver mit 1 x, 2 x und 4 x Nvidia A100 80 GB SXM GPUs (400 W) mit NVLink Technologie aktiviert, CUDA® 11.8, Ubuntu 20.04.4. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren.

- Tests durchgeführt vom AMD Leistungslabor am 26.08.2022 unter Verwendung von AMBER: Cellulose_production_NPT_4fs, Cellulose_production_NVE_4fs, FactorIX_production_NPT_4fs, FactorIX_production_NVE_4fs, STMV_production_NPT_4fs, STMV_production_NVE_4fs, JAC_production_NPT_4fs und JAC production_NVE_4fs. Es wurden zwei Systeme verglichen: 2P-Server mit EPYC™ 7763 und 1 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU, ROCm 5.2.0, Amber-Container 22.amd_100 im Vergleich zu 2P-Server mit EPYC™ 7742 und 1 x Nvidia A100 SXM (80 GB HBM2e) 400 W GPU, MPS aktiviert (2 Instanzen), CUDA 11.6. MI200-73.

- Tests durchgeführt vom AMD Leistungslabor am 18.10.2022 mithilfe von Gromacs STMV; es wurden zwei Systeme verglichen: 2P-Server mit EPYC™ 7763 und 4 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPUs und Infinity Fabric™ Technologie, ROCm™ 5.2.0, Gromacs-Container 2022.3.amd1_174 im Vergleich zu öffentlichen Nvidia-Angaben unter https://developer.nvidia.com/hpc-application-performance. (Gromacs 2022.2). Dual EPYC 7742 mit 4 x Nvidia Ampere A100 SXM 80 GB GPUs. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund von Faktoren wie dem Einsatz neuester Treiber und Optimierungen variieren. MI200-74.

- Tests durchgeführt vom AMD Leistungslabor am 03.10.2022 unter Verwendung von LAMMPS: EAM, LJ, ReaxFF und Tersoff; verglichen wurden zwei Systeme: 2P-Server mit EPYC™ 7763 und 4 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU, ROCm 5.2.0, LAMMPS-Container 2021.5.14_121amdih/lammps:2022.5.04_130 im Vergleich zu öffentlichen Nvidia-Angaben unter http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. (stable 23Jun2022 update 1). Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-77.

- Tests durchgeführt vom AMD Leistungslabor am 13.09.2022 unter Verwendung von NAMD: STMV_NVE, APOA1_NVE; verglichen wurden zwei Systeme: 2P-Server mit EPYC™ 7763 und 1 x, 2 x und 4 x AMD Instinct™ MI250 (128 GB HBM2e) 560 W GPU mit AMD Infinity Fabric™ Technologie, ROCm 5.2.0, NAMD-Container namd3:3.0a9 im Vergleich zu öffentlichen Nvidia-Angaben zur Performance des 2P-Servers EPYC 7742 mit 1 x, 2 x und 4 x Nvidia Ampere A100 80 GB SXM GPU (https://developer.nvidia.com/hpc-application-performance). (v2.15a AVX-512). Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-76.

- Tests durchgeführt vom AMD Leistungslabor am 14.11.2022 auf 2P-Sockel AMD EPYC™ 7763 CPU Supermicro 4124 mit 8 x AMD Instinct™ MI210 GPUs (PCIe® 64 GB, 300 W); AMD Infinity Fabric™ Technologie aktiviert. Ubuntu 18.04.6 LTS, Host ROCm 5.2.0, rocHPL 6.0.0. Ergebnisse aus den Mittelwerten von fünf Durchläufen berechnet im Vergleich zu Tests durchgeführt vom AMD Leistungslabor auf 2P-Sockel AMD EPYC™ 7763 Supermicro 4124 mit 8 x NVIDIA A100 GPUs (PCIe 80 GB, 300 W), Ubuntu 18.04.6 LTS, CUDA 11.6, HPL Nvidia Container-Image 21.4-HPL Alle Ergebnisse wurden auf Systemen gemessen, die mit 8 GPUs konfiguriert sind. 2 Kombinationen der 4 x MI210 GPUs verbunden über eine Infinity Fabric™ Link 4-Wege-Brücke; 4 Kombinationen der 2 x A100 80 GB PCIe GPUs verbunden über eine 2-Wege-NVLink-Brücke. Informationen über HPL: https://www.netlib.org/benchmark/hpl/. AMD HPL Container-Details: HPL Container ist für Infinity Hub noch nicht verfügbar. Nvidia HPL Container-Details: https://ngc.nvidia.com/catalog/containers/nvidia:hpc-benchmarks. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-49A.

- HPL-AI-Vergleich basierend auf internen AMD Tests vom 02.11.2022, bei denen die HPL-AI-Benchmark-Performance (TFLOPS) unter Verwendung eines Servers mit 2 x EPYC 7763 und 8 x MI210 (64 MB HBM2e) und Infinity Fabric Technologie mit Host ROCm 5.2.0, HPL-AI-AMD v1.0.0 gemessen wurde; AMD HPL-AI-Container ist für Infinity Hub noch nicht verfügbar; im Vergleich zu einem Server mit 2 x EPYC 7763 und 8 x A100 PCIe 80 GB HBM2e mit CUDA 11.6, HPL-AI-NVIDIA v2.0.0, Container nvcr.io/nvidia/hpc-benchmarks:21.4-hpl. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-83.

- Tests durchgeführt vom AMD Leistungslabor am 03.10.2022 auf 2P-Sockel AMD EPYC™ 7763 CPU Supermicro 4124 mit 4 x und 8 x AMD Instinct™ MI210 GPU (PCIe® 64 GB, 300 W); AMD Infinity Fabric™ Technologie war aktiviert. SBIOS2.2, Ubuntu® 18.04.6 LTS, Host ROCm™ 5.2.0. LAMMPS Container amdih-2022.5.04_130 (ROCm 5.1) im Vergleich zu öffentlichen Nvidia-Angaben für 4 x und 8 x A100 PCIe 80 GB GPUs http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI200-47A.