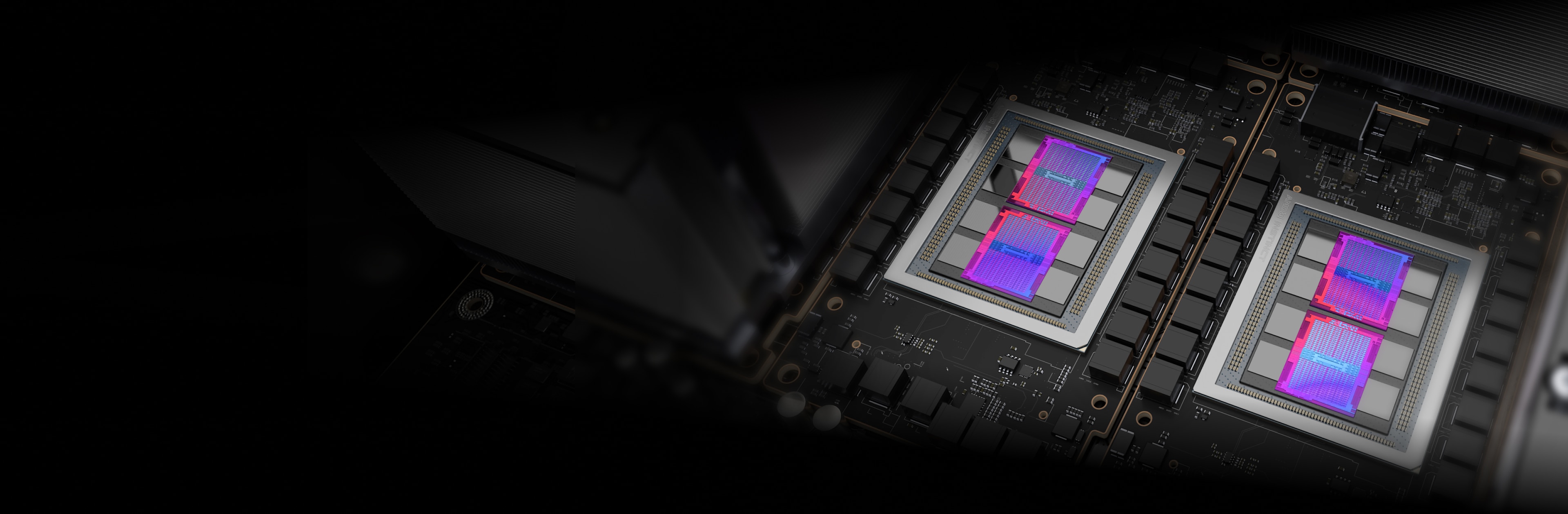

外壳下暗藏的先进技术

AMD Instinct 加速器基于 AMD CDNA 架构打造,内置 Matrix Core 技术,并全面支持各种精度计算,无论是高效的 INT8 和 FP8,还是高性能计算中要求最为严苛的 FP64,均不在话下。

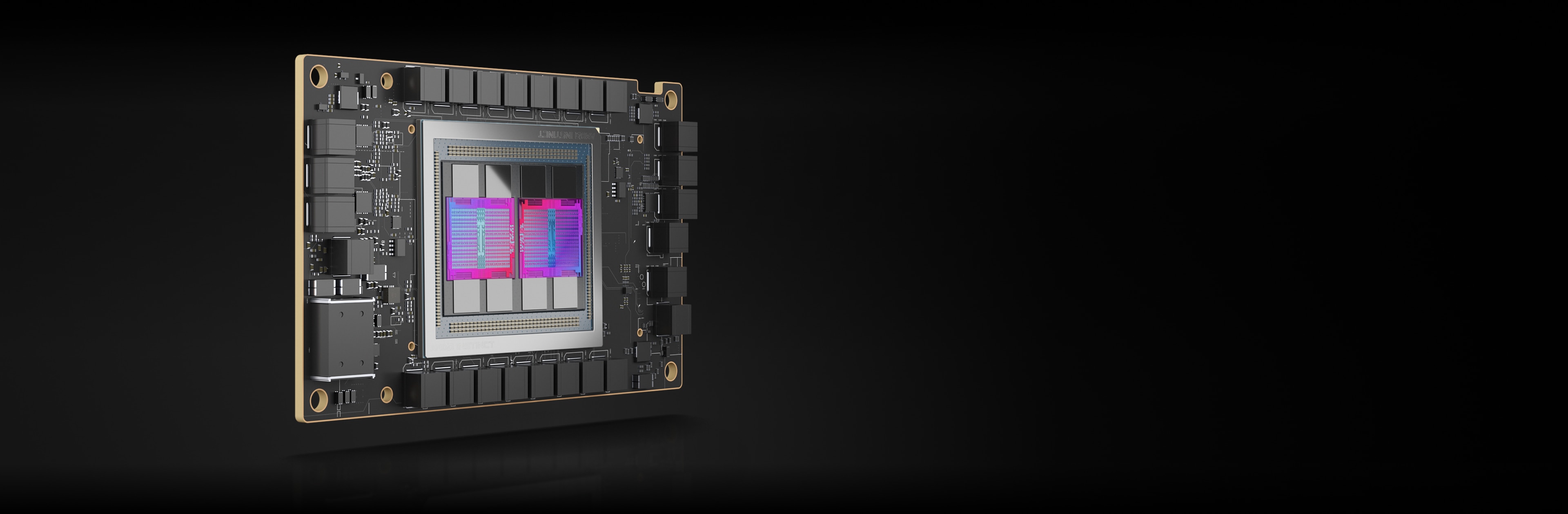

AMD Instinct MI250X 加速器

AMD Instinct MI250X 加速器为全球领先的超级计算机提供助力。

220 个计算单元

220 个 GPU 计算单元

128 GB

128 GB HBM2e 显存

3.2 TB/秒

3.2 TB/秒峰值显存带宽

400 GB/秒

400 GB/秒 Infinity Fabric 峰值聚合带宽

规格比较

高达 383 TFLOPS 的峰值理论半精度 (FP16) 性能,在面对要求严苛的 AI 工作负载时,带来多于同类 GPU 最高 1.6 倍的显存容量和带宽。2,3,4

MI250X

参考基准

带来与同类 GPU 相比最高 4 倍的性能优势,提供高达 47.9 的 TFLOPs FP64 和高达 95.7 的 TFLOPs FP64 矩阵峰值理论性能。2

MI250X

参考基准

*TF32 数据格式不符合 IEEE 标准,因此不包括在本比较中。

AMD Instinct MI250 加速器

AMD Instinct MI250 加速器为企业、研究和学术相关使用场景带来出色的高性能计算和人工智能性能。

208 个计算单元

208 个 GPU 计算单元

128 GB

128 GB HBM2e 显存

3.2 TB/秒

3.2 TB/秒峰值显存带宽

100 GB/秒

100 GB/秒 Infinity Fabric 链路峰值带宽

性能基准测试

HPCG 3.0:高性能共轭梯度 (HPCG) 基准测试是用于对高性能计算系统进行排名的指标。HPCG 旨在对高性能 LINPACK (HPL) 基准测试(即目前用于对全球超级计算机 500 强计算系统进行排名的指标)形成补充。5

指标 |

1xMI250 |

2xMI250 |

4xMI250 |

GFLOPS |

488.8 |

972.6 |

1927.7 |

HPL:HPL 用于实现高性能 Linpack 基准测试。此代码使用标准操作计数公式,解出均匀的线性方程随机系统,并报告时间和浮点执行率。6

指标 |

1xMI250 |

2xMI250 |

4xMI250 |

TFLOPS |

40.45 |

80.666 |

161.97 |

HPL_AI (High Performance LINPACK for Accelerator Introspection) 是一种基准测试,使用新颖的混合精度算法来解出线性方程系统,从而实现高性能计算与人工智能工作负载的融合。7

指标 |

测试模块 |

4xMI250 |

TFLOPS |

混合 FP16/32/64 |

930.44 |

PyFR 是基于 Python 的开源框架,它运用 Huynh 的通量重建方法,解决串流架构中的对流扩散型问题。此框架旨在解决包含多种元素类型的混合非结构网格上出现的各种管理系统问题。8

指标 |

测试模块 |

1xMI250 |

模拟/天 |

TGV |

41.73 |

OpenFOAM (Open-source Field Operation And Manipulation) 是一款 C++ 工具包,用于开发定制数值求解器,以及解决连续介质力学问题(主要包括计算流体动力学 (CFD))的前/后处理实用工具。9

指标 |

测试模块 |

1xMI250 |

2xMI250 |

4xMI250 |

时间(秒) |

HPC Motorbike(数值越小越好) |

662.3 |

364.26 |

209.84 |

Amber 是一组生物分子模拟程序。“Amber”一词指代两种事物。首先,它是一套用于生物分子模拟的分子力学力场。其次,它是一套包含源代码和演示的分子模拟程序。10

应用 |

指标 |

测试模块 |

数值越大越好 |

1xMI250 |

AMBER |

ns/天 |

Cellulose Production NPT 4fs |

是 |

227.2 |

AMBER |

ns/天 |

Cellulose Production NVE 4fs |

是 |

242.4 |

AMBER |

ns/天 |

FactorIX Production NPT 4fs |

是 |

803.1 |

AMBER |

ns/天 |

FactorIX Production NVE 4fs |

是 |

855.2 |

AMBER |

ns/天 |

JAC Production NPT 4fs |

是 |

1794 |

AMBER |

ns/天 |

JAC Production NVE 4fs |

是 |

1871 |

AMBER |

ns/天 |

STMV Production NPT 4fs |

是 |

80.65 |

AMBER |

ns/天 |

STMV Production NVE 4fs |

是 |

86.7 |

GROMACS 是一套分子动力学程序包,主要用于蛋白质、脂类和核酸模拟。 GROMACS 最初由格罗宁根大学生物物理化学系开发,现在由世界各地的大学和研究中心的贡献者共同维护。11

应用 |

指标 |

测试模块 |

数值越大越好 |

1xMI250 |

2xMI250 |

4xMI250 |

GROMACS |

ns/天 |

STMV |

是 |

34.2 |

61.812 |

89.26 |

LAMMPS 是一种经典的分子动力学代码,主要用于材料建模。 LAMMPS 是 Large-scale Atomic/Molecular Massively Parallel Simulator(大规模原子/分子大规模并行模拟器)的首字母缩写。LAMMPS 在固态材料(金属、半导体)和软物质(生物分子、聚合物)以及粗粒度或介观系统方面具有潜力。12

应用 |

指标 |

测试模块 |

数值越大越好 |

1xMI250 |

2xMI250 |

4xMI250 |

LAMMPS |

Atom-Time 步/秒 |

LJ |

是 |

6E+08 |

1E+09 |

2E+09 |

LAMMPS |

Atom-Time 步/秒 |

ReaxFF |

是 |

7E+06 |

1E+07 |

3E+07 |

LAMMPS |

Atom-Time 步/秒 |

Tersoff |

是 |

5E+08 |

1E+09 |

2E+09 |

NAMD 是一套分子动力学程序包,主要用于模拟生物分子随时间的运动。NAMD 适用于大型生物分子系统,并已被用于模拟含有超过 10 亿个原子的系统,在成千上万的 CPU 核心和 GPU 上展现出极强的可扩展性。13

应用 |

指标 |

测试模块 |

数值越大越好 |

1xMI250 |

2xMI250 |

4xMI250 |

NAMD 3.0 |

ns/天 |

APOA1_NVE |

是 |

221.4 |

443.61 |

879.43 |

NAMD 3.0 |

ns/天 |

STMV_NVE |

是 |

19.87 |

39.545 |

77.132 |

AMD Instinct MI210 加速器

AMD Instinct MI210 加速器适用于单服务器解决方案等用途,可为企业、研究和学术领域的高性能计算和人工智能工作负载提供支持。

104 个计算单元

104 个 GPU 计算单元

64 GB

64 GB HBM2e 显存

1.6 TB/秒

1.6 TB/秒峰值显存带宽

100 GB/秒

100 GB/秒 Infinity Fabric 链路峰值带宽

性能基准测试

HPL:HPL 用于实现高性能 Linpack 基准测试。此代码使用标准操作计数公式,解出均匀的线性方程随机系统,并报告时间和浮点执行率。14

指标 |

数值越大越好 |

1xMI210 |

2xMI210 |

4xMI210 | 8xMI210 |

TFLOPS |

是 |

21.07 |

40.878 |

81.097 | 159.73 |

HPL-AI:HPL_AI (High Performance LINPACK for Accelerator Introspection) 是一种基准测试,使用新颖的混合精度算法来解出线性方程系统,从而实现高性能计算与人工智能工作负载的融合。15

指标 |

测试模块 |

数值越大越好 |

4xMI210 |

8xMI210 |

TFLOPS |

混合 FP16/32/64 |

是 |

444.77 |

976.18 |

LAMMPS:LAMMPS 是一种经典的分子动力学代码,主要用于材料建模。LAMMPS 是 Large-scale Atomic/Molecular Massively Parallel Simulator(大规模原子/分子大规模并行模拟器)的首字母缩写。LAMMPS 在固态材料(金属、半导体)和软物质(生物分子、聚合物)以及粗粒度或介观系统方面具有潜力。16

指标 |

测试模块 |

数值越大越好 |

4xMI210 | 8xMI210 |

Atom-Time 步/秒 |

ReaxFF |

是 |

1E+07 | 3E+07 |

随时掌握最新动态

订阅接收最新数据中心动态以及服务器相关内容。

附注

- 全球超级计算机 500 强榜单(2023 年 6 月)

- AMD Instinct MI250X 是先进的数据中心 GPU。AMD 性能实验室于 2021 年 9 月 15 日经过测算,AMD Instinct MI250X(128GB HBM2e OAM 模块)加速器在 1,700 MHz 峰值加速引擎时钟频率下为 95.7 TFLOPS 理论峰值双精度 (FP64 Matrix)、47.9 TFLOPS 理论峰值双精度 (FP64)、95.7 TFLOPS 理论峰值单精度矩阵 (FP32 Matrix)、47.9 TFLOPS 理论峰值单精度 (FP32)、383.0 TFLOPS 理论峰值半精度 (FP16) 和 383.0 TFLOPS 理论峰值 Bfloat16 精度 (BF16) 浮点性能。AMD 性能实验室于 2020 年 9 月 18 日经过测算,AMD Instinct MI100(32GB HBM2 PCIe® 卡)加速器在 1,502 MHz 峰值加速引擎时钟频率下为 11.54 TFLOPS 理论峰值双精度 (FP64)、46.1 TFLOPS 理论峰值单精度矩阵 (FP32)、23.1 TFLOPS 理论峰值单精度 (FP32) 和 184.6 TFLOPS 理论峰值半精度 (FP16) 浮点性能。MI200-01

- AMD 性能实验室于 2021 年 9 月 21 日对 AMD Instinct MI250X 和 MI250 (128GB HBM2e) OAM 加速器进行测算,加速器采用 AMD CDNA 2 6nm FinFet 制程工艺,在 1,600 MHz 峰值显存时钟频率下可实现 3.2768 TFLOPS 峰值理论显存带宽性能。MI250/MI250X 显存总线接口为 4,096 位 x 2 个芯片,显存数据速率为 3.20 Gbps,总显存带宽为 3.2768 TB/s((3.20 Gbps*(4,096 位*2))/8)。

- AMD 性能实验室于 2021 年 9 月 21 日对 AMD Instinct MI250X 和 MI250 加速器 (OAM) 进行测算,加速器采用 AMD CDNA 2 6nm FinFet 制程工艺,在 1,600 MHz 峰值显存时钟频率下可实现 128GB HBMe 显存容量。

- AMD 性能实验室于 2022 年 11 月 2 日使用 HPCG 3.0 测试以下系统:基于 EPYC(霄龙)7763 的双路服务器,禁用 SMT,分别搭载 1 个、2 个和 4 个 AMD Instinct MI250 (128 GB HBM2e) 560W GPU,SBIOS M12,Ubuntu 20.04.4,Host ROCm 5.2.0。 HPCG 3.0 容器:nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg,位于 https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-70A。

- AMD 性能实验室于 2022 年 11 月 14 日使用 HPL 测试以下系统。基于 EPYC(霄龙)7763 的双路服务器,禁用 SMT,分别搭载配备 1 个、2 个和 4 个 AMD Instinct MI250 (128 GB HBM2e) 560W GPU、host ROCm 5.2.0 rocHPL6.0.0。Infinity Hub 尚不可使用 AMD HPL 容器。HPL 容器 (nvcr.io/nvidia/hpc-benchmarks:21.4-hpl),获取自 https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-69A。

- HPL-AI 测试基于 AMD 于 2022 年 11 月 2 日进行的内部测试,测量 HPL-AI 基准性能 (TFLOPS),使用基于 2 个 EPYC(霄龙)7763 的服务器,搭载 4 个 MI250 128MB HBM2e,运行 host ROCm 5.2.0,HPL-AI-AMD v1.0.0。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-81。

- AMD 性能实验室于 2022 年 11 月 25 日使用 PyFR TGV 和 NACA 0021 进行测试:基于 EPYC(霄龙)7763 的双路服务器,禁用 SMT,搭载 1 个 AMD Instinct MI250 (128 GB HBM2e) 560W GPU,SBIOS M12,Ubuntu 20.04.4,Host ROCm 5.2.0。 服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-82。

- AMD 性能实验室于 2023 年 4 月 14 日使用 OpenFOAM v2206 进行了测试,测试采用基于 EPYC(霄龙)7763 CPU 的双路生产服务器,分别搭载 1 个、2 个和 4 个 AMD Instinct MI250 GPU (128GB、560W),同时启用 AMD Infinity Fabric 技术,使用 ROCm 5.3.3,Ubuntu® 20.04.4。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。

- AMD 性能实验室于 2022 年 8 月 26 日使用 AMBER 进行了测试:Cellulose_production_NPT_4fs、Cellulose_production_NVE_4fs、FactorIX_production_NPT_4fs、FactorIX_production_NVE_4fs、STMV_production_NPT_4fs、STMV_production_NVE_4fs、JAC_production_NPT_4fs 和 JAC production_NVE_4fs。系统配置:基于 EPYC(霄龙)7763 的双路服务器,搭载 1 个 AMD Instinct MI250 (128GB HBM2e) 560W GPU,ROCm 5.2.0,Amber 容器 22.amd_100。 MI200-73。

- AMD 性能实验室于 2022 年 10 月 18 日使用 Gromacs STMV 测试以下系统:基于 EPYC(霄龙)7763 的双路服务器,搭载采用 AMD Infinity Fabric 技术的 4 个 AMD Instinct MI250 (128GB HBM2e) 560W GPU,ROCm 5.2.0,Gromacs 容器 2022.3.amd1_174。 服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化等各种因素而有所不同。MI200-74。

- AMD 性能实验室 109.0322.22 使用 LAMMPS 进行了测试:EAM、LJ、ReaxFF 和 Tersoff 测试以下系统:基于 EPYC(霄龙)7763 的双路服务器,搭载 4 个 AMD Instinct MI250 (128GB HBM2e) 560W GPU,ROCm 5.2.0,LAMMPS 容器 2021.5.14_121amdih/lammps:2022.5.04_130。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-77。

- AMD 性能实验室于 2022 年 9 月 13 日使用 NAMD 进行了测试:STMV_NVE、APOA1_NVE 测试以下系统:基于 EPYC(霄龙)7763 的双路服务器,分别搭载采用 AMD Infinity Fabric 技术的 1 个、2 个和 4 个 AMD Instinct MI250 (128GB HBM2e) 560W GPU,ROCm 5.2.0,NAMD 容器 namd3:3.0a9。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-76。

- AMD 性能实验室于 2022 年 11 月 14 日在基于 AMD EPYC(霄龙)7763 CPU 的 Supermicro 4124 双路服务器上搭载 8 个 AMD Instinct MI210 GPU (PCIe® 64GB 300W) 进行了测试,同时启用了 AMD Infinity Fabric 技术。Ubuntu 18.04.6 LTS、Host ROCm 5.2.0、rocHPL 6.0.0。结果采用 5 次运行的得分中位数。所有结果均在配置有 8 个 GPU 的系统上测量;2 对 4xMI210 GPU,通过 4 路 Infinity Fabric 链路桥接连接;4 对 2xA100 80GB PCIe GPU,通过 2 路 NVLink 桥接连接。有关 HPL 的信息:https://www.netlib.org/benchmark/hpl/。 AMD HPL 容器详情:Infinity Hub 尚不可使用 HPL 容器。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-49A。

- HPL-AI 测试基于 AMD 于 2022 年 11 月 2 日进行的内部测试,测量 HPL-AI 基准性能 (TFLOPS),使用基于 2 个 EPYC(霄龙)7763 的服务器,搭载采用 Infinity Fabric 技术的 8 个 MI210 64MB HBM2e,运行host ROCm 5.2.0,HPL-AI-AMD v1.0.0;Infinity Hub 尚不可使用 AMD HPL-AI 容器。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-83。

- AMD 性能实验室于 2022 年 10 月 3 日在基于 AMD EPYC(霄龙)7763 CPU 的 Supermicro 4124 双路服务器上分别搭载 4 个和 8 个 AMD Instinct MI210 GPU (PCIe® 64GB 300W) 进行了测试,同时启用了 AMD Infinity Fabric 技术。SBIOS2.2、Ubuntu® 18.04.6 LTS、host ROCm 5.2.0。LAMMPS 容器 amdih-2022.5.04_130 (ROCm 5.1)。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-47A。

- 全球超级计算机 500 强榜单(2023 年 6 月)

- AMD Instinct MI250X 是先进的数据中心 GPU。AMD 性能实验室于 2021 年 9 月 15 日经过测算,AMD Instinct MI250X(128GB HBM2e OAM 模块)加速器在 1,700 MHz 峰值加速引擎时钟频率下为 95.7 TFLOPS 理论峰值双精度 (FP64 Matrix)、47.9 TFLOPS 理论峰值双精度 (FP64)、95.7 TFLOPS 理论峰值单精度矩阵 (FP32 Matrix)、47.9 TFLOPS 理论峰值单精度 (FP32)、383.0 TFLOPS 理论峰值半精度 (FP16) 和 383.0 TFLOPS 理论峰值 Bfloat16 精度 (BF16) 浮点性能。AMD 性能实验室于 2020 年 9 月 18 日经过测算,AMD Instinct MI100(32GB HBM2 PCIe® 卡)加速器在 1,502 MHz 峰值加速引擎时钟频率下为 11.54 TFLOPS 理论峰值双精度 (FP64)、46.1 TFLOPS 理论峰值单精度矩阵 (FP32)、23.1 TFLOPS 理论峰值单精度 (FP32) 和 184.6 TFLOPS 理论峰值半精度 (FP16) 浮点性能。MI200-01

- AMD 性能实验室于 2021 年 9 月 21 日对 AMD Instinct MI250X 和 MI250 (128GB HBM2e) OAM 加速器进行测算,加速器采用 AMD CDNA 2 6nm FinFet 制程工艺,在 1,600 MHz 峰值显存时钟频率下可实现 3.2768 TFLOPS 峰值理论显存带宽性能。MI250/MI250X 显存总线接口为 4,096 位 x 2 个芯片,显存数据速率为 3.20 Gbps,总显存带宽为 3.2768 TB/s((3.20 Gbps*(4,096 位*2))/8)。

- AMD 性能实验室于 2021 年 9 月 21 日对 AMD Instinct MI250X 和 MI250 加速器 (OAM) 进行测算,加速器采用 AMD CDNA 2 6nm FinFet 制程工艺,在 1,600 MHz 峰值显存时钟频率下可实现 128GB HBMe 显存容量。

- AMD 性能实验室于 2022 年 11 月 2 日使用 HPCG 3.0 测试以下系统:基于 EPYC(霄龙)7763 的双路服务器,禁用 SMT,分别搭载 1 个、2 个和 4 个 AMD Instinct MI250 (128 GB HBM2e) 560W GPU,SBIOS M12,Ubuntu 20.04.4,Host ROCm 5.2.0。 HPCG 3.0 容器:nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg,位于 https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-70A。

- AMD 性能实验室于 2022 年 11 月 14 日使用 HPL 测试以下系统。基于 EPYC(霄龙)7763 的双路服务器,禁用 SMT,分别搭载配备 1 个、2 个和 4 个 AMD Instinct MI250 (128 GB HBM2e) 560W GPU、host ROCm 5.2.0 rocHPL6.0.0。Infinity Hub 尚不可使用 AMD HPL 容器。HPL 容器 (nvcr.io/nvidia/hpc-benchmarks:21.4-hpl),获取自 https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-69A。

- HPL-AI 测试基于 AMD 于 2022 年 11 月 2 日进行的内部测试,测量 HPL-AI 基准性能 (TFLOPS),使用基于 2 个 EPYC(霄龙)7763 的服务器,搭载 4 个 MI250 128MB HBM2e,运行 host ROCm 5.2.0,HPL-AI-AMD v1.0.0。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-81。

- AMD 性能实验室于 2022 年 11 月 25 日使用 PyFR TGV 和 NACA 0021 进行测试:基于 EPYC(霄龙)7763 的双路服务器,禁用 SMT,搭载 1 个 AMD Instinct MI250 (128 GB HBM2e) 560W GPU,SBIOS M12,Ubuntu 20.04.4,Host ROCm 5.2.0。 服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-82。

- AMD 性能实验室于 2023 年 4 月 14 日使用 OpenFOAM v2206 进行了测试,测试采用基于 EPYC(霄龙)7763 CPU 的双路生产服务器,分别搭载 1 个、2 个和 4 个 AMD Instinct MI250 GPU (128GB、560W),同时启用 AMD Infinity Fabric 技术,使用 ROCm 5.3.3,Ubuntu® 20.04.4。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。

- AMD 性能实验室于 2022 年 8 月 26 日使用 AMBER 进行了测试:Cellulose_production_NPT_4fs、Cellulose_production_NVE_4fs、FactorIX_production_NPT_4fs、FactorIX_production_NVE_4fs、STMV_production_NPT_4fs、STMV_production_NVE_4fs、JAC_production_NPT_4fs 和 JAC production_NVE_4fs。系统配置:基于 EPYC(霄龙)7763 的双路服务器,搭载 1 个 AMD Instinct MI250 (128GB HBM2e) 560W GPU,ROCm 5.2.0,Amber 容器 22.amd_100。 MI200-73。

- AMD 性能实验室于 2022 年 10 月 18 日使用 Gromacs STMV 测试以下系统:基于 EPYC(霄龙)7763 的双路服务器,搭载采用 AMD Infinity Fabric 技术的 4 个 AMD Instinct MI250 (128GB HBM2e) 560W GPU,ROCm 5.2.0,Gromacs 容器 2022.3.amd1_174。 服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化等各种因素而有所不同。MI200-74。

- AMD 性能实验室 109.0322.22 使用 LAMMPS 进行了测试:EAM、LJ、ReaxFF 和 Tersoff 测试以下系统:基于 EPYC(霄龙)7763 的双路服务器,搭载 4 个 AMD Instinct MI250 (128GB HBM2e) 560W GPU,ROCm 5.2.0,LAMMPS 容器 2021.5.14_121amdih/lammps:2022.5.04_130。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-77。

- AMD 性能实验室于 2022 年 9 月 13 日使用 NAMD 进行了测试:STMV_NVE、APOA1_NVE 测试以下系统:基于 EPYC(霄龙)7763 的双路服务器,分别搭载采用 AMD Infinity Fabric 技术的 1 个、2 个和 4 个 AMD Instinct MI250 (128GB HBM2e) 560W GPU,ROCm 5.2.0,NAMD 容器 namd3:3.0a9。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-76。

- AMD 性能实验室于 2022 年 11 月 14 日在基于 AMD EPYC(霄龙)7763 CPU 的 Supermicro 4124 双路服务器上搭载 8 个 AMD Instinct MI210 GPU (PCIe® 64GB 300W) 进行了测试,同时启用了 AMD Infinity Fabric 技术。Ubuntu 18.04.6 LTS、Host ROCm 5.2.0、rocHPL 6.0.0。结果采用 5 次运行的得分中位数。所有结果均在配置有 8 个 GPU 的系统上测量;2 对 4xMI210 GPU,通过 4 路 Infinity Fabric 链路桥接连接;4 对 2xA100 80GB PCIe GPU,通过 2 路 NVLink 桥接连接。有关 HPL 的信息:https://www.netlib.org/benchmark/hpl/。 AMD HPL 容器详情:Infinity Hub 尚不可使用 HPL 容器。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-49A。

- HPL-AI 测试基于 AMD 于 2022 年 11 月 2 日进行的内部测试,测量 HPL-AI 基准性能 (TFLOPS),使用基于 2 个 EPYC(霄龙)7763 的服务器,搭载采用 Infinity Fabric 技术的 8 个 MI210 64MB HBM2e,运行host ROCm 5.2.0,HPL-AI-AMD v1.0.0;Infinity Hub 尚不可使用 AMD HPL-AI 容器。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-83。

- AMD 性能实验室于 2022 年 10 月 3 日在基于 AMD EPYC(霄龙)7763 CPU 的 Supermicro 4124 双路服务器上分别搭载 4 个和 8 个 AMD Instinct MI210 GPU (PCIe® 64GB 300W) 进行了测试,同时启用了 AMD Infinity Fabric 技术。SBIOS2.2、Ubuntu® 18.04.6 LTS、host ROCm 5.2.0。LAMMPS 容器 amdih-2022.5.04_130 (ROCm 5.1)。服务器制造商可能会采用不同的配置而得到不同的结果。性能可能会随使用的驱动程序版本和优化而有所不同。MI200-47A。