AMD Instinct プラットフォーム

単一の UBB ボード フォーム ファクターに 8 基の Instinct MI355X または MI350X GPU を搭載し、最大の演算能力を実現

最先端の AI および HPC 性能

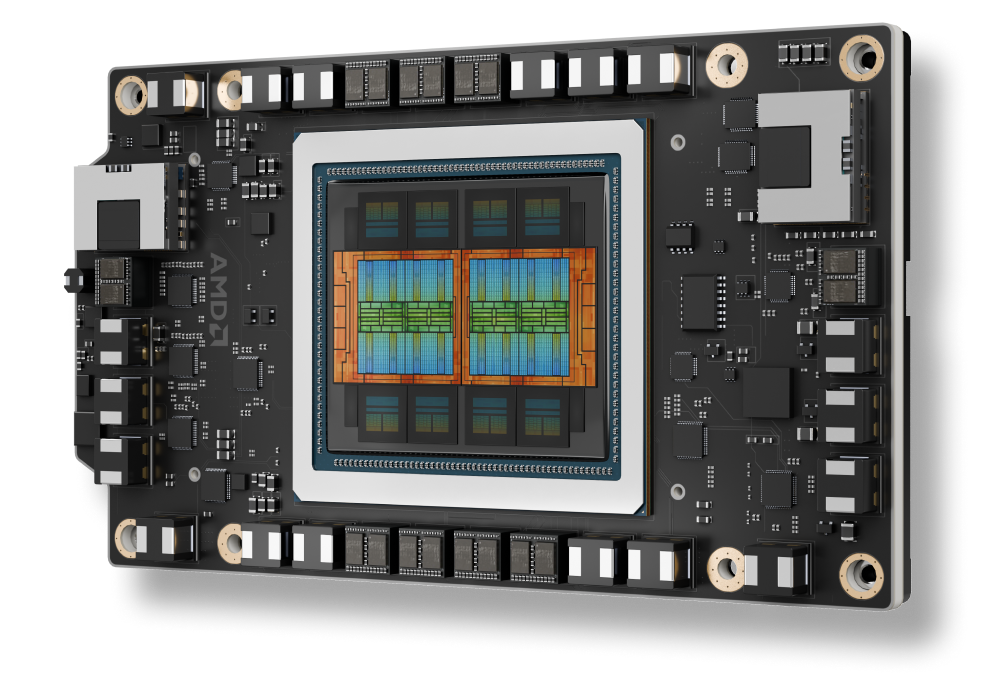

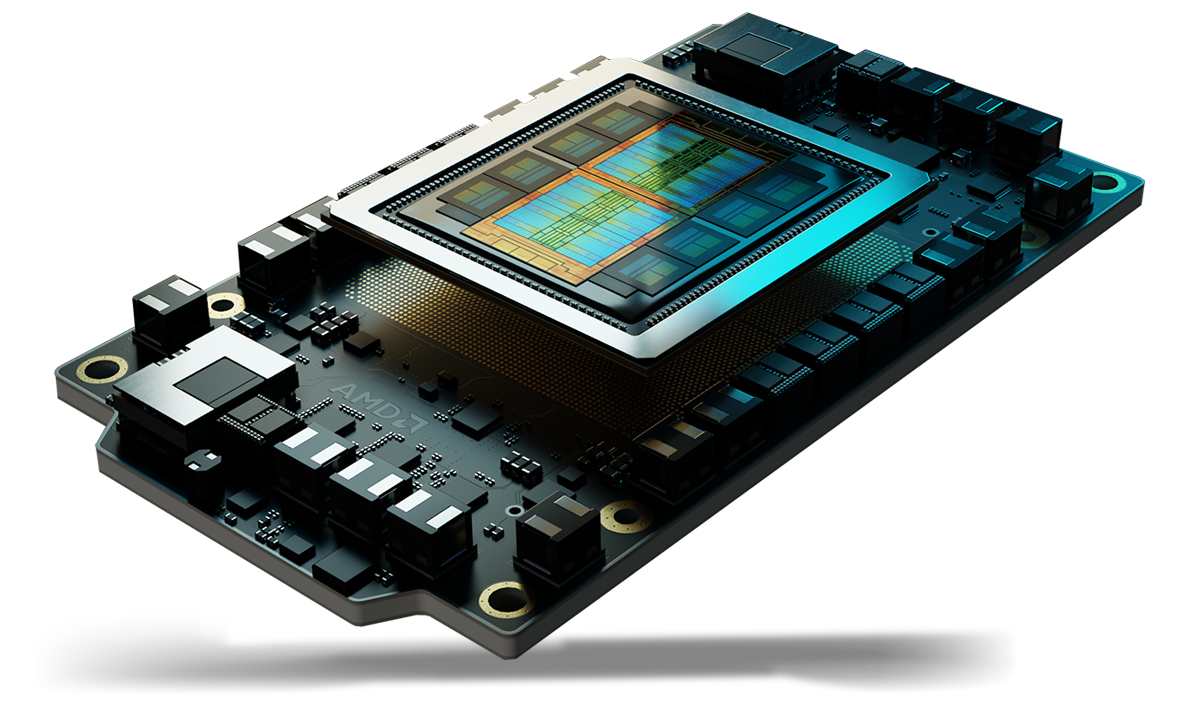

AMD Instinct™ MI350 シリーズ GPU は、データセンターにおける生成 AI および高性能コンピューティング (HPC) の分野で、新たな基準を打ち立てます。最新の第 4 世代 AMD CDNA™ アーキテクチャに基づいて構築されているこれらの GPU は、大規模な AI モデルのトレーニングや高速推論のほか、科学シミュレーション、データ処理、計算モデリングといった複雑な HPC ワークロードに対して、優れた効率性と卓越したパフォーマンスを提供します。

AMD Instinct™ アクセラレータは、シングルサーバー ソリューションから世界最大級のエクサスケール級スーパーコンピューターまで、あらゆる規模のデータセンターでリーダーシップを発揮するパフォーマンスを実現します。

最も要求の厳しい AI や HPC のワークロード処理にも適しており、卓越した演算能力、高メモリ集積度、広帯域幅メモリ、特殊なデータ形式のサポートを提供します。

AMD Instinct GPU は、マトリックス コア テクノロジと幅広いデータ型機能をサポートする AMD CDNA™ アーキテクチャ上に構築されています。AI 向けに INT8、OCP-FP8、FP16/BF16 のスパース性対応を含む、高効率の MXFP4 および MXFP6 から、HPC 向けの最も要求の厳しい FP64 までをサポートします。

クラウドで AMD Instinct GPU を活用

主要なクラウド サービス プロバイダーがサポートするプログラムで、AI、HPC、ソフトウェア開発のニーズをサポートします。

AMD は、大手 OEM やプラットフォーム設計者と協力して、AMD Instinct GPU 搭載ソリューションの堅牢なエコシステムを提供しています。

サインアップして、最新のデータセンター ニュースとサーバー コンテンツを受信します。