AMD Instinct Plattformen

Umfasst acht (8) Instinct MI355X oder MI350X GPUs in einer einzigen UBB-Platinenbauform für maximale Rechenleistung

Führende KI- und HPC-Performance

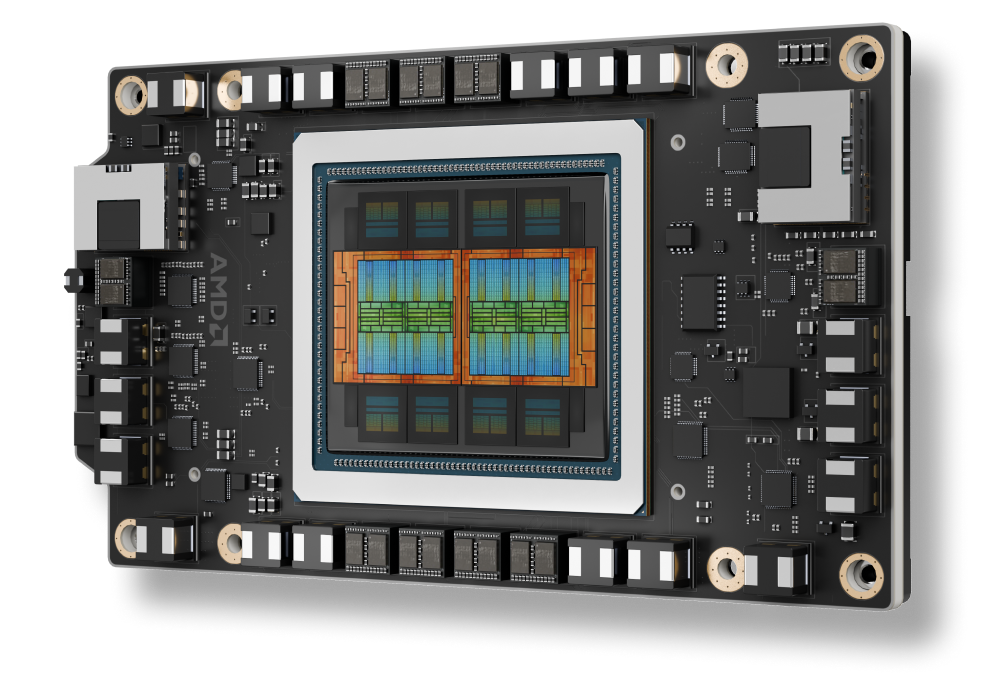

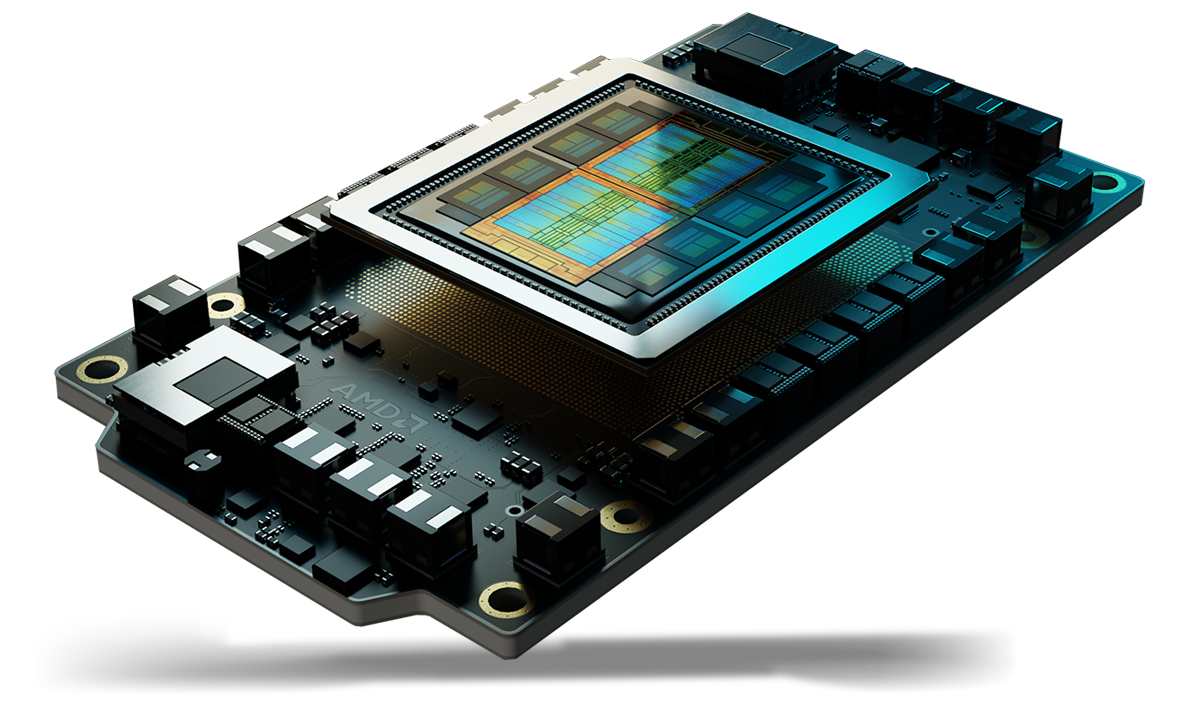

Die AMD Instinct™ MI350-Serie GPUs setzen neue Maßstäbe für generative KI und High-Performance-Computing (HPC) in Rechenzentren. Diese GPUs basieren auf der neuen, hochmodernen AMD CDNA™ Architektur der 4. Generation und bieten außergewöhnliche Effizienz und Performance für das Training sehr großer KI-Modelle, Hochgeschwindigkeitsinferenz und komplexe HPC-Auslastungen wie wissenschaftliche Simulationen, Datenverarbeitung und Computermodellierung.

AMD Instinct™ Beschleuniger ermöglichen beispiellose Performance für das Rechenzentrum, in jeder Größenordnung – von Einzelserver-Lösungen bis hin zu den weltweit größten Supercomputern der Exascale-Klasse.

Sie sind hervorragend geeignet, um selbst die anspruchsvollsten KI- und HPC-Auslastungen zu bewältigen, und bieten eine außergewöhnliche Rechenleistung, große Speicherdichte, High Bandwidth Memory und Unterstützung für spezielle Datenformate.

AMD Instinct GPUs basieren auf der AMD CDNA™ Architektur mit Matrix-Core-Technologien und Unterstützung für eine Vielzahl von Genauigkeiten – von hocheffizienten MXFP4 und MXFP6 (mit KI-Unterstützung für INT8-, OCP-FP8- und FP16/BF16-Sparsity) bis hin zu anspruchsvollsten FP64 für HPC.

AMD Instinct GPUs in der Cloud erleben

Unterstützen Sie Ihre KI-, HPC- und Softwareentwicklungsanforderungen mit Programmen, die von führenden Cloud-Service-Anbietern unterstützt werden.

AMD arbeitet mit führenden Erstausrüstern (OEMs) und Plattformentwicklern zusammen, um ein robustes Ökosystem von auf AMD Instinct GPUs basierenden Lösungen anzubieten.

Wir bei AMD glauben, dass die Weiterentwicklung von KI und HPC eine intensive Zusammenarbeit erfordert. Unsere Mitarbeiter decken das gesamte Spektrum des KI- und HPC-Ökosystems ab – von der Modellentwicklung und umfassenden Schulungen bis hin zu Simulation, wissenschaftlicher Forschung und Inferenz in Echtzeit. Gemeinsam bringen wir bahnbrechende Entwicklungen in Bereichen hervor, die von künstlicher Intelligenz über numerische Strömungsdynamik bis hin zu Wettermodellierung und darüber hinaus reichen.

Melden Sie sich an und erhalten Sie alle Neuigkeiten über Rechenzentren und Server.